朋友们,刷到这条的你,大概率被这些消息“轰炸”过吧?

“AI大模型通过律师考试,分数超90%人类!”

“10分钟!大模型帮我写完年终总结,老板直夸有深度!”

“和AI聊天机器人聊哲学,它竟能接住我的灵魂拷问?!”

这些新闻里频频露脸的“大模型”,到底是什么“神奇物种”?它为啥好像一夜之间就拥有了“超人智慧”?今天,我就化身你的“科技导游”,用大白话+硬知识,彻底拆解这个改变游戏规则的技术!保证你看完不仅“哦,原来如此”,更能和朋友侃侃而谈!

一句话定义:大模型,就是一个被“海量知识”喂大、用“天量算力”练就的“超级思维引擎”!

想象一下,你要打造一个“最强大脑”。怎么做?

1、喂它“读万卷书,行万里路”(海量数据训练): 不是读几本名著,而是让它吞下整个互联网的精华!TB甚至PB级别的文字、代码、图片描述、科学论文……相当于让它瞬间吸收人类几千年积累的公开智慧结晶。它不分昼夜地“阅读”,核心目标就一个:摸透文字(或图像)背后的“潜规则”。比如:

“春天来了”后面,大概率接“万物复苏”还是“冰箱坏了”?

看到“编程”、“bug”、“调试”这些词扎堆出现,意味着在讨论什么?

描述“成功”,人们常用哪些词?和“失败”的描述有啥微妙差别?

(对于看图说话的大模型)一张有沙滩、椰树、比基尼的照片,配文大概率是啥?

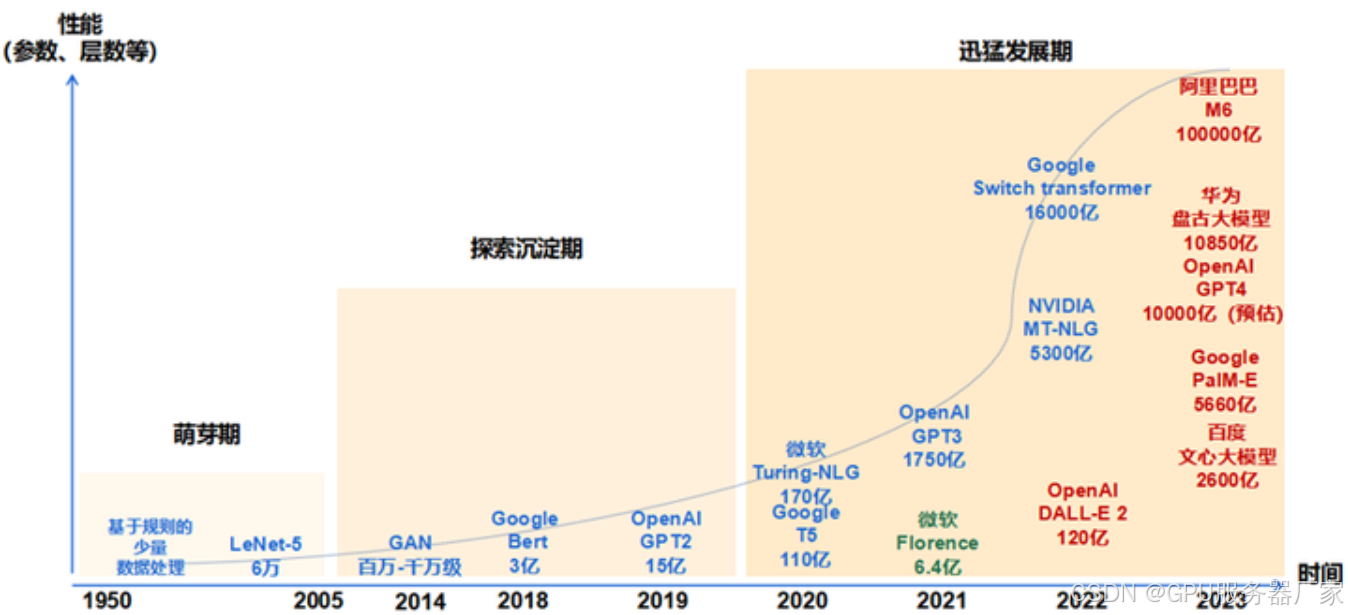

2、给它装一个“超级大脑”(巨量参数模型): 光“知道”不够,还得能“思考”。这个大脑的“脑细胞”(专业术语叫参数)数量,不是百万、千万级,而是几十亿、百亿、千亿,甚至万亿级别!做个对比:人脑神经元大概有860亿个。像GPT-3就有1750亿个“脑细胞”,GPT-4、Claude 3 Opus等顶尖模型,更是突破万亿大关!“脑细胞”越多,它能建立的联系就越复杂、越精妙,能“理解”和“生成”的东西就越接近人类思维的深度和广度。

3、送它去“顶级训练营”(天量算力锤炼): 打造这样的“超级大脑”,可不是在家用电脑就能完成的“小目标”。它需要成千上万台顶级服务器(装满GPU/TPU芯片)组成超级计算机集群,日夜不停地疯狂运算,持续数周甚至数月!消耗的电力和资金成本,堪比一个小型城市的运作。这就是为什么目前只有少数科技巨头能玩转“大模型”训练。

核心奥秘:它为何能“无师自通”,突破想象?

经过这番“地狱式”训练,大模型展现出令人震惊的“超能力”,这背后有深刻的原理:

1、“智力大爆炸” - 涌现:最神奇的黑箱!

现象: 当模型的“脑细胞”(参数)数量、吞下的“知识”(数据量)、经历的“训练强度”(算力)超过某个神秘临界点时,它会突然解锁一系列在“小模型”阶段完全不存在或极其笨拙的能力!比如:复杂的逻辑推理(解数学题)、富有创意的写作(写诗编故事)、编写和调试程序代码、进行多轮深度对话、理解隐喻和讽刺等。

本质: 这不是程序员一行行代码“教”出来的,而是模型在海量数据中自行摸索、发现并内化了极其复杂的模式和规律。就像亿万次练习后,突然“顿悟”了某个高级技巧。“规模”是触发质变的关键钥匙! 这也是当前AI研究最激动人心也最神秘的前沿。

2、“举一反三”小天才 - 上下文学习:

现象: 想让大模型做新任务?不用重新“教”(微调参数)!只需在对话里给它看几个例子(上下文)。比如:

你请把英文翻译成中文:

Apple -> 苹果

Banana -> 香蕉

Computer -> ?

(模型)电脑

本质: 模型能从你给的少量样本中,瞬间推断出你隐含的任务要求(这里是翻译),并应用它从海量数据中学到的通用语言规律来完成任务。零样本(只给任务描述)/小样本(给几个例子)学习能力,是大模型实用性的革命性突破!

3、“善解人意”好帮手 - 指令遵循:

现象: 你可以直接用自然语言“命令”它:“写一封情真意切的辞职信,表达感谢也说明追求”,“用小学生能听懂的话解释量子纠缠”,“给我列一份健康的一周早餐食谱,要快手易做的”。

本质: 通过专门的“指令微调”和“人类反馈强化学习”(如RLHF),模型被训练得能精准理解人类用日常语言表达的复杂意图,并据此生成符合要求的回复。这让人机交互变得无比自然流畅,大大降低了AI的使用门槛。

4、“行走的百科全书” - 世界知识:

现象: 它能回答“珠穆朗玛峰多高?”、“光合作用的公式是什么?”、“《红楼梦》的作者是谁?”、“牛顿定律是哪三条?”等海量事实性问题。

本质: 在“吞食”互联网的过程中,模型在其庞大的参数网络中编码、压缩了难以计量的现实世界知识和常识。这为它的推理、对话和创作提供了丰富的背景信息。但请注意!它只是“记住了”互联网上的信息,并不具备验证真伪的能力,可能产生“幻觉”(一本正经地胡说八道),也可能包含过时或偏见信息。 把它当“超级搜索引擎+脑补大师”更准确。

技术基石:Transformer - “超级大脑”的独特构造

大模型能有如此强大的“思维能力”,离不开一个名为 Transformer 的革命性架构(你可以理解为它大脑的“硬件设计图”和“工作方式”)。它的核心绝招是 “自注意力机制”。

“瞬间关联全场” - 自注意力:

痛点: 以前的技术(如RNN)理解长文时,像拿着放大镜一个字一个字看,容易“忘了开头”。

突破: Transformer让模型在处理句子中的任何一个词时,都能瞬间“注意到”句子(甚至整篇文章)里所有其他与之相关的词,无论距离多远!比如理解:“尽管投资巨大,这个项目最终还是失败了,主要因为市场调研做得不够充分。” 模型能高效地将“失败”与“项目”、“市场调研”精准关联起来。

优势: 这种机制让模型真正理解上下文、把握长距离依赖关系的能力产生质的飞跃,是理解复杂语义的关键。

“多核并行”高效能: Transformer的结构设计非常适合并行计算。想象一下,不是一个人埋头苦读,而是成千上万个“小工”同时处理文章的不同部分,再汇总结果。这大大加速了训练和推理过程,让训练万亿参数的“超级大脑”成为可能。没有Transformer,就没有今天的大模型时代!

深刻洞见与理性看待:

1、本质是“概率预测大师”: 大模型的所有输出,都是基于它从海量数据中学习到的统计规律,计算出的“下一个最可能出现的词/图”。它没有意识、没有情感、不理解“意义”,只是在做极其复杂和精准的模式匹配与预测。它的“智慧”是统计的智慧。

2、“双刃剑”特性:

强大生产力工具: 能极大提升写作、编程、研究、客服等效率,激发创意灵感。

风险与挑战: “幻觉”(输出错误但看似合理的内容)、偏见放大(训练数据中的偏见被模型学习并放大)、安全性(被恶意利用)、可解释性差(难以理解其内部决策过程)、巨大资源消耗。

3、人机协作是未来: 大模型不是取代人类,而是强大的“思维加速器”和“知识协作者”。人类的创造力、批判性思维、价值观判断和现实世界经验,是AI无法替代的核心优势。 善用AI者将如虎添翼。

总结升华:

大模型,这个由 “海量数据”喂养、“巨量参数”构建、“天量算力”锤炼 的“超级思维引擎”,凭借 Transformer架构 赋予的“瞬间关联”超能力,突破了规模临界点,触发了 “智力涌现” 的奇迹,展现出 “一点就通”(上下文学习)、“善解人意”(指令遵循)、“博闻强记”(世界知识) 的非凡特性。

它掀起的不是一阵风,而是一场深刻的“思维效率革命”! 理解其原理(模式预测)、惊叹其能力(涌现)、正视其局限(幻觉/偏见),我们才能在这场变革中保持清醒,将AI转化为拓展人类智慧边界的强大工具,而非被其光芒迷惑。

记住:最强大的智能,永远是善用工具的人类本身!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?