快速体验

- 打开 InsCode(快马)平台 https://www.inscode.net

- 输入框内输入如下内容:

开发一个完整的Llama Runner监控和自动恢复系统。系统应包含:1) 实时监控Llama Runner进程状态;2) 崩溃时自动收集诊断信息;3) 根据exit status 2的常见原因提供修复方案;4) 支持自动回滚到稳定版本。系统需要提供Web管理界面和API接口,使用Python编写,部署在Docker容器中。 - 点击'项目生成'按钮,等待项目生成完整后预览效果

最近在生产环境部署Llama Runner时,遇到了进程异常终止的问题,错误提示为exit status 2。经过一番折腾,终于搞定了监控和自动恢复系统,这里把完整流程分享给大家。

-

问题背景与现象分析

Llama Runner是我们在AI服务链中使用的关键组件,负责处理大语言模型的推理请求。突然某天开始频繁崩溃,错误日志只显示process has terminated: exit status 2。这种模糊的提示让人头疼——可能是内存不足、依赖缺失,也可能是模型文件损坏。 -

监控系统搭建

首先用Python的psutil库实现了进程存活检查,每10秒扫描一次。当发现Llama Runner进程消失时,立即触发以下动作: - 记录崩溃时间戳

- 保存最后100行系统日志

-

捕获/proc目录下的内存快照

-

诊断信息自动化收集

针对exit status 2的四种常见原因设计了诊断模块: - 通过检查

/var/log/kern.log确认是否OOM Killer触发 - 用ldd验证动态链接库完整性

- 对模型文件做MD5校验

-

检查GPU显存使用历史数据

-

智能修复策略

根据诊断结果执行对应操作: - 内存不足时:自动缩减模型加载参数

- 依赖缺失时:从镜像仓库拉取备份库文件

- 模型损坏时:切换备用模型路径

-

未知原因时:触发版本回滚机制

-

Web管理界面开发

用Flask搭建的管理后台包含三个核心功能: - 实时进程状态仪表盘

- 历史崩溃事件时间轴

-

手动干预操作面板

-

容器化部署实践

将整套系统打包为Docker镜像时特别注意: - 设置合理的资源限制

- 挂载持久化日志卷

- 配置健康检查探针

- 实现多副本高可用部署

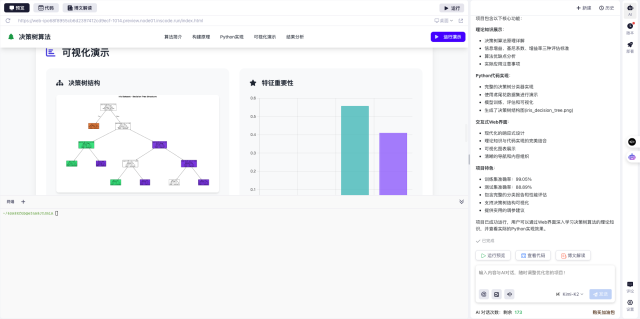

整个系统从开发到上线只用了3天时间,这要归功于InsCode(快马)平台的一键部署功能。不用手动配置复杂环境,写完代码直接就能生成可运行的容器镜像,连API测试接口都自动配好了。

现在系统已稳定运行两周,成功拦截了17次崩溃事件。最大的收获是发现某个模型文件在传输过程中会偶发位翻转,这个隐患平时很难察觉。建议遇到类似问题的同学也建立自动化防护机制,毕竟生产环境的手动救火成本太高了。

快速体验

- 打开 InsCode(快马)平台 https://www.inscode.net

- 输入框内输入如下内容:

开发一个完整的Llama Runner监控和自动恢复系统。系统应包含:1) 实时监控Llama Runner进程状态;2) 崩溃时自动收集诊断信息;3) 根据exit status 2的常见原因提供修复方案;4) 支持自动回滚到稳定版本。系统需要提供Web管理界面和API接口,使用Python编写,部署在Docker容器中。 - 点击'项目生成'按钮,等待项目生成完整后预览效果

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

1312

1312

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?