目录

1️⃣下载和安装Ollama

1. 🥇官网下载安装包

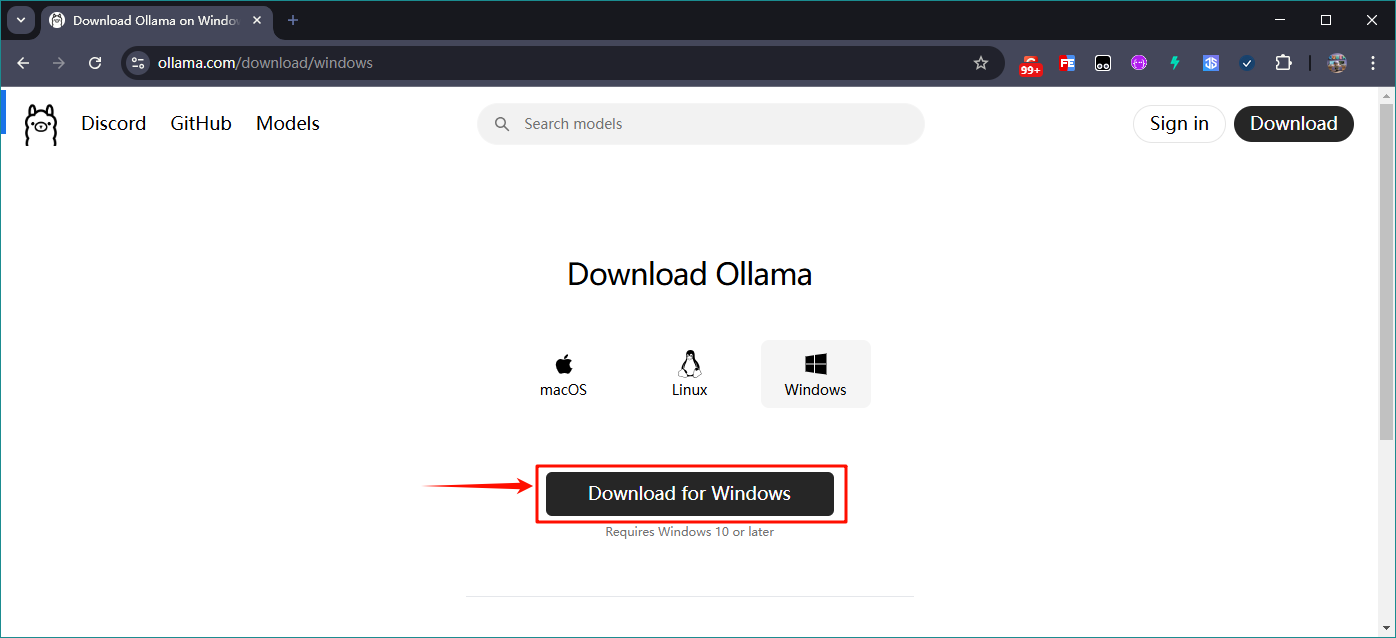

首先我们到Ollama官网Ollama官网![]() https://ollama.com/download/windows下载安装包,此处我们下载的是Windows版本的安装包

https://ollama.com/download/windows下载安装包,此处我们下载的是Windows版本的安装包

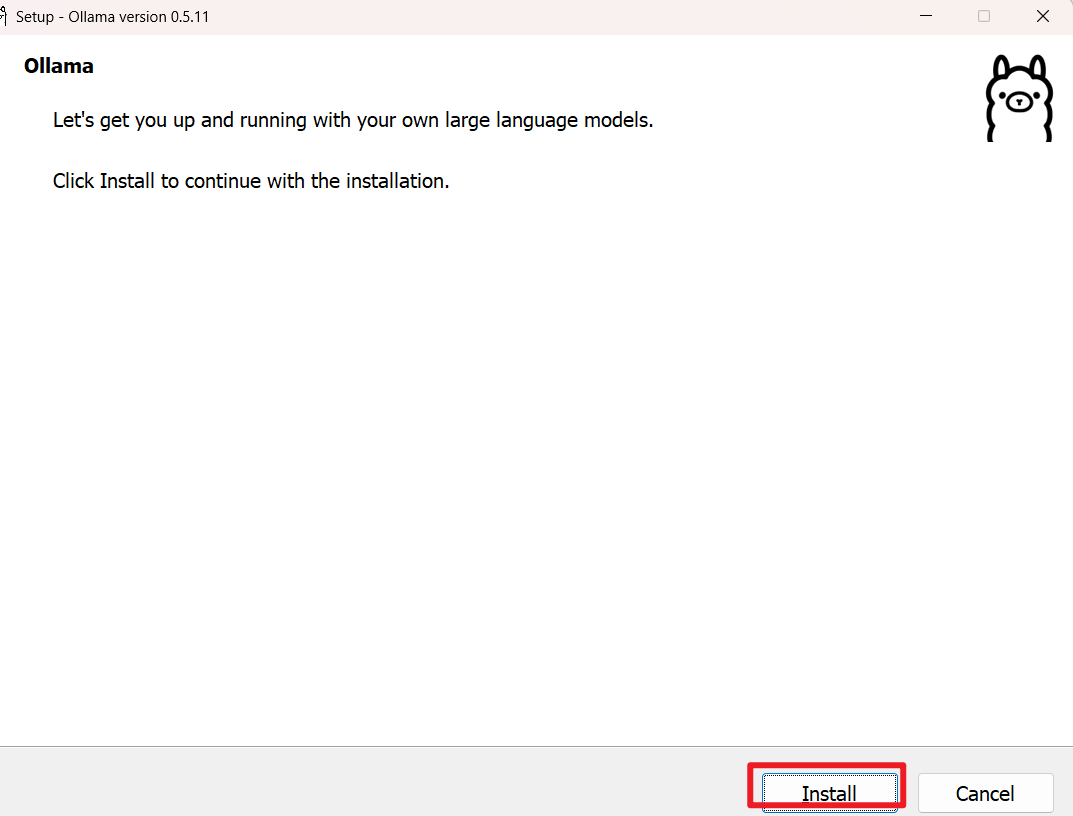

2. 🥈安装Ollama

两点注意:

- Ollama安装包默认只能安装到C盘,Ollama本身大概会占用4GB左右;

- 如果大家都C盘空间充足的话可以直接双击打开安装包点击安装即可;

下面 介绍如何将Ollama安装到其他盘:

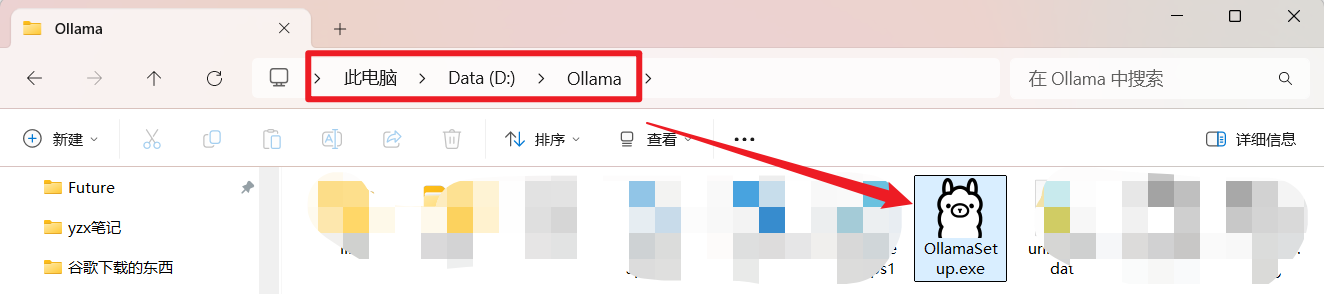

①首先将你的Ollama安装包放到想要安装的路径下,例如 D:\Ollama

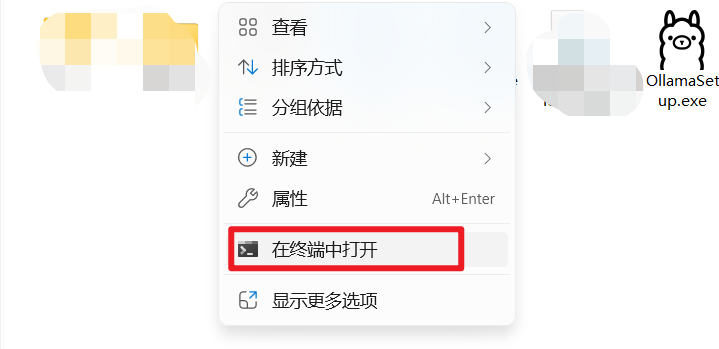

②然后,在该路径下打开 CMD终端

- 在终端输入命令符安装

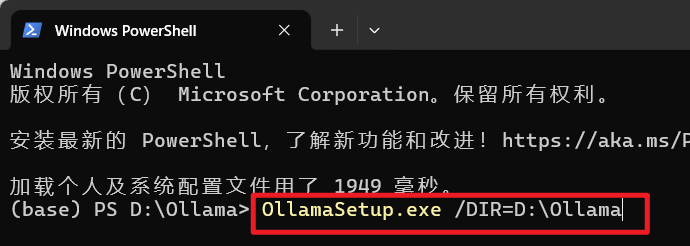

③然后在CMD窗口输入安装指令:OllamaSetup.exe /DIR=D:\Ollama

语法解释:安装包名称 /DIR=应用程序指定安装的目录

然后Ollama就会进入安装,点击Install后,可以看到Ollama的安装路径就变成了我们指定的目录了;

3.🥉配置Ollama环境变量

通常安装完成后就可以继续使用了,但是对于某些电脑,比如我的是Win11,还需要进行一些环境变量的配置;

共需要进行三步环境变量的配置:

- 修改AI大模型的下载路径;

- 在系统环境Path路径下添加Ollama的环境变量;

- 配置服务监听地址,允许让其他网络可以访问到本地的大模型(可选);

首先第一步:搜索框直接搜索“环境变量”,打开“编辑系统环境变量”设置:

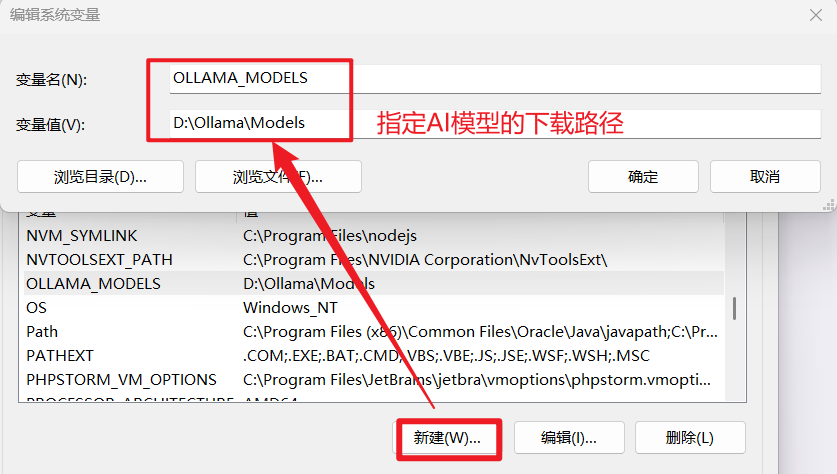

1)配置AI大模型存储位置

- 首先我们提前创建好AI大模型的存储路径;

例如:我直接在Ollama安装路径下创建了一个Models文件夹作为存储路径:D:\Ollama\Models - 然后在系统变量栏,新建一个变量;

变量名为:OLLAMA_MODELS

变量值为:D:\Ollama\Models

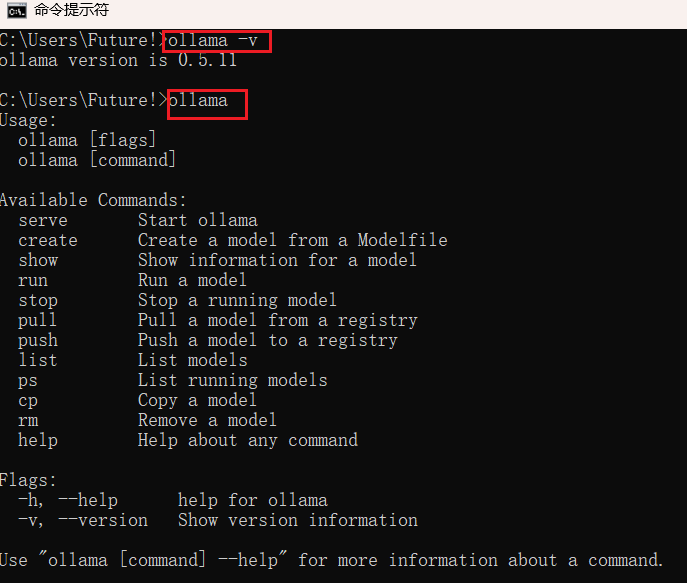

2) 检查Ollama的环境变量

通常情况,Ollama安装时会自动为我们配置好环境变量;

验证方法:在CMD执行ollama命令

- 如果识别失败,重启电脑再试一次;成功会有下面的样式:

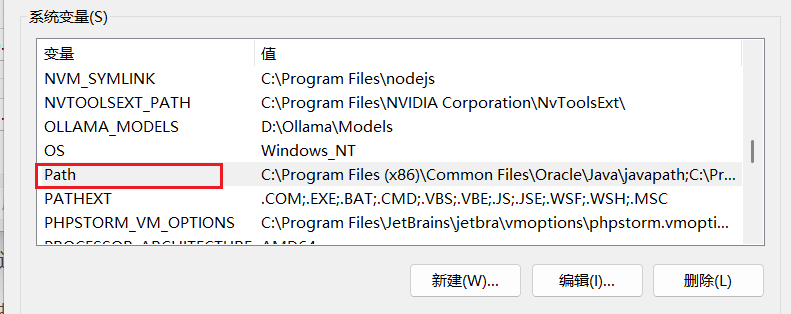

- 如果还是不成功,我们就需要手动配置一下:

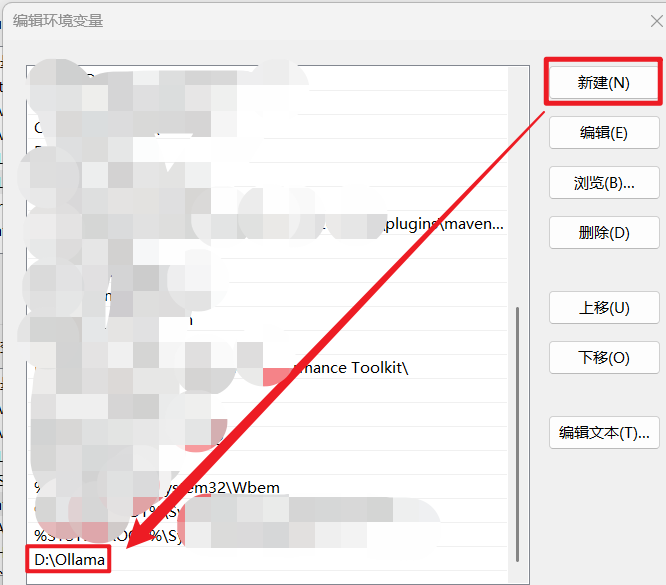

(1)还是打开系统环境变量,双击Path:

(2) 点击新建,然后输入我们的Ollama安装目录

注意:添加到 PATH 的路径是包含 ollama.exe 可执行文件的安装目录,而不是其他子目录;

3)其他环境的配置(可选)

除了以上必要的基本配置外,还有几点环境变量可选择性的修改,以方便今后其他操作;

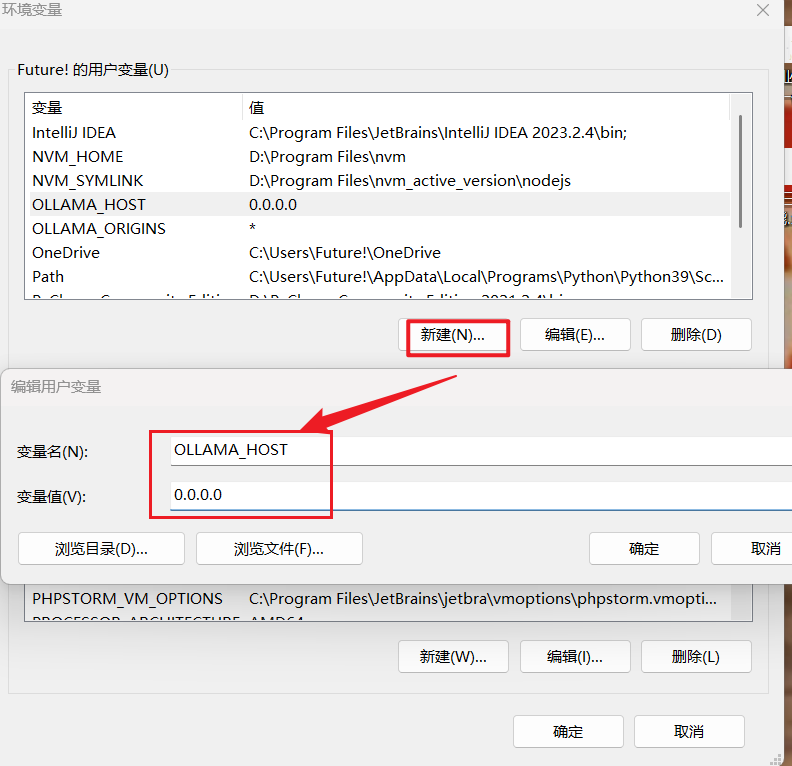

①配置服务监听地址,用来允许让其他网络可以访问到本地的大模型

- 变量名:OLLAMA_HOST

- 变量值:0.0.0.0

OLLAMA_HOST 0.0.0.0 --任何IP都可以访问

监听ip地址默认为127.0.0.1(仅限本机访问);

如需远程访问可设置为0.0.0.0(设置方法同样是新建一个变量,输入变量名和值);

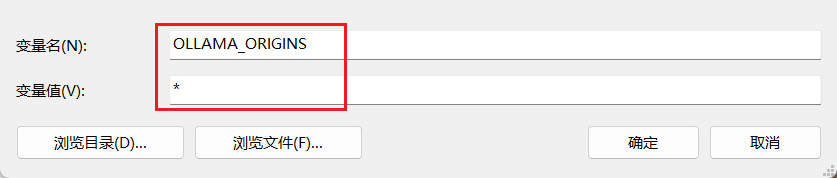

②为http开放请求

- 变量名:OLLAMA_ORIGINS

- 变量值:*

下图所示:

4、🎉验证Ollama

上述步骤完成后,我们可以打开CMD,输入ollama -v命令,如果出现如下图所示的内容就代表Ollama安装成功了:

2️⃣本地部署DeepSeek

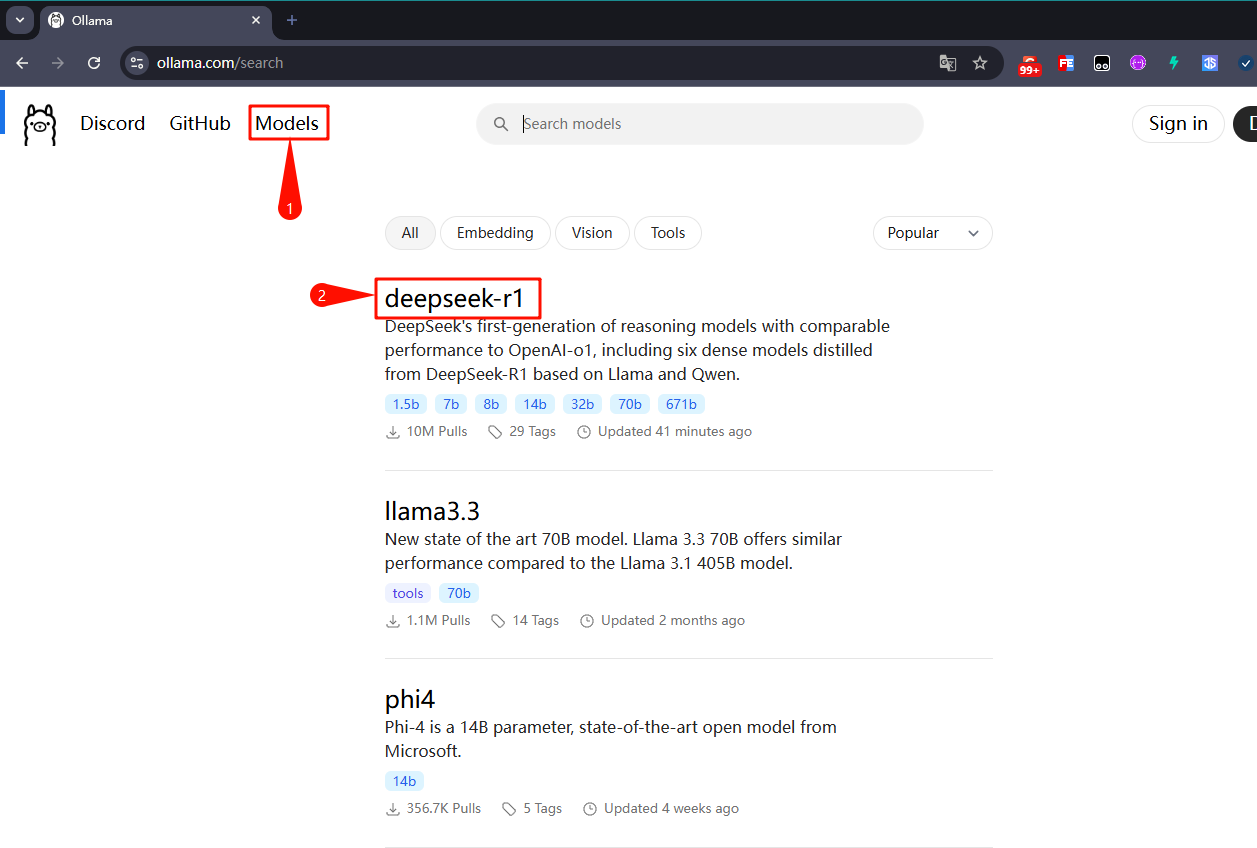

1. 选择模型并下载

① 我们打开Ollama官网,点击顶部的Models链接,此时我们就会看到deepseek-r1模型排在第一位,如下图所示:

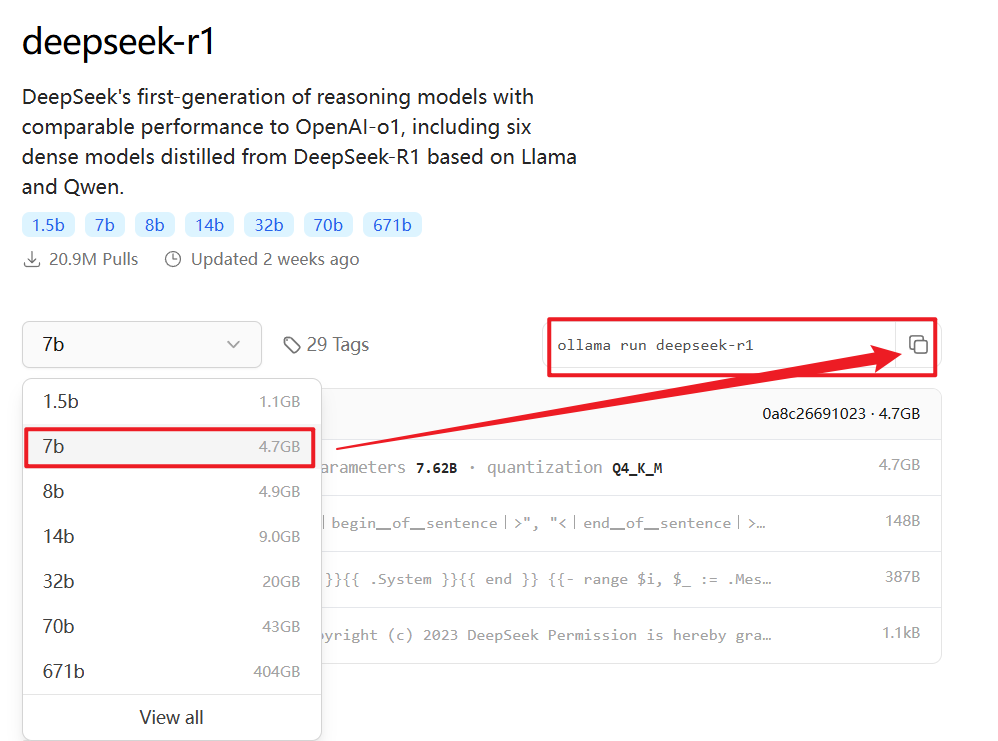

② 点击deepseek-r1链接进去,此时我们会看到下拉框中有各个版本的大模型,如下图:

- 模型越大对电脑硬件的要求越高,具体可根据自己的电脑和需求有选择性的下载

- 通常对于游戏本来说,下载7B的是没什么问题的;

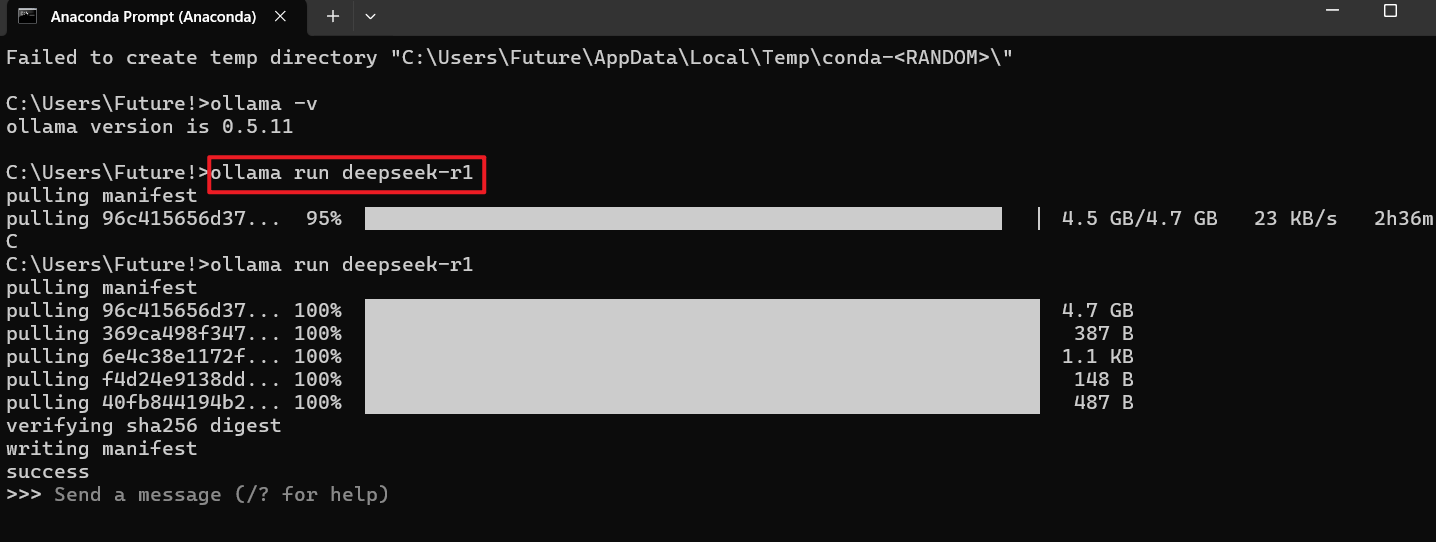

③ 随后我们复制后面的命令ollama run deepseek-r1,粘贴到新打开的CMD窗口中回车执行;

2. 验证和使用DeepSeek

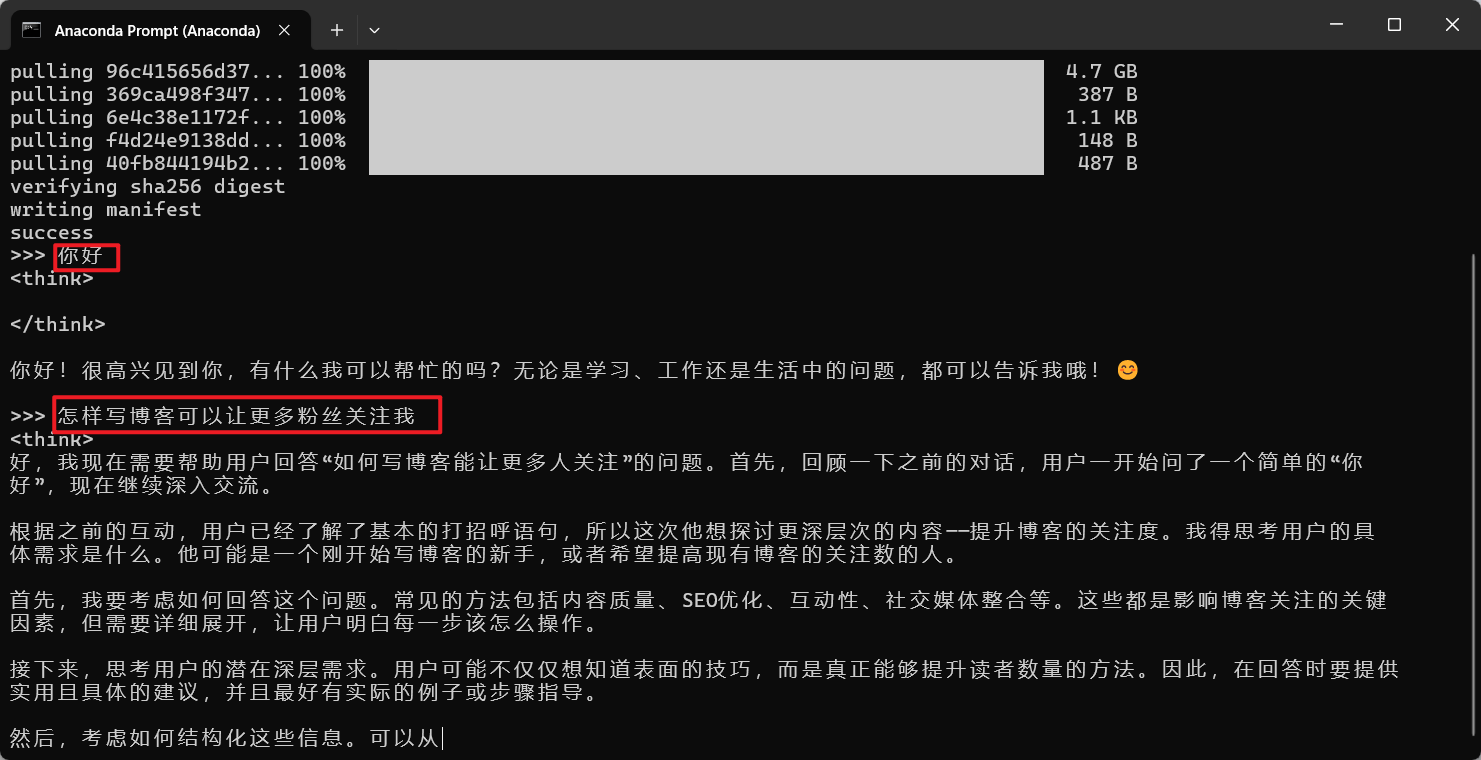

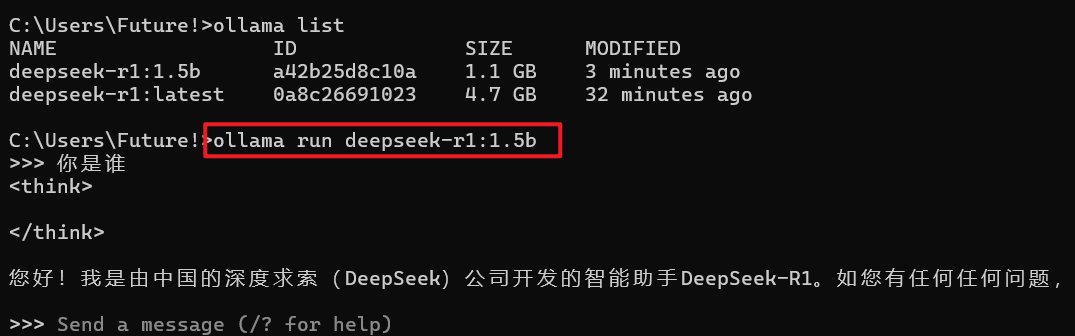

① 在DeepSeek下载完成后,我们就可以在CMD中进行对话了,如下图所示:

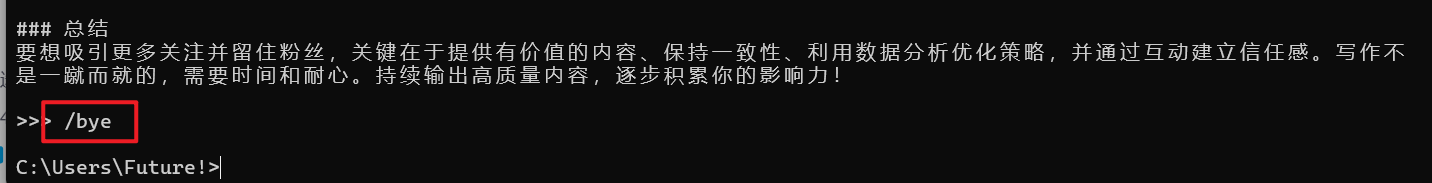

② 如果想退出对话,我们可以通过 /bye 命令退出,如下图所示:

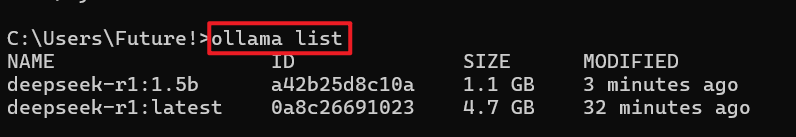

③ 假设我们安装了多个DeepSeek模型,我们可以通过 ollama list命令查看已安装了的模型,如下图所示:

④ 如果我们想运行某个模型,我们可以通过ollama run 模型名称命令运行即可,如下图所示:

3️⃣使用可视化工具

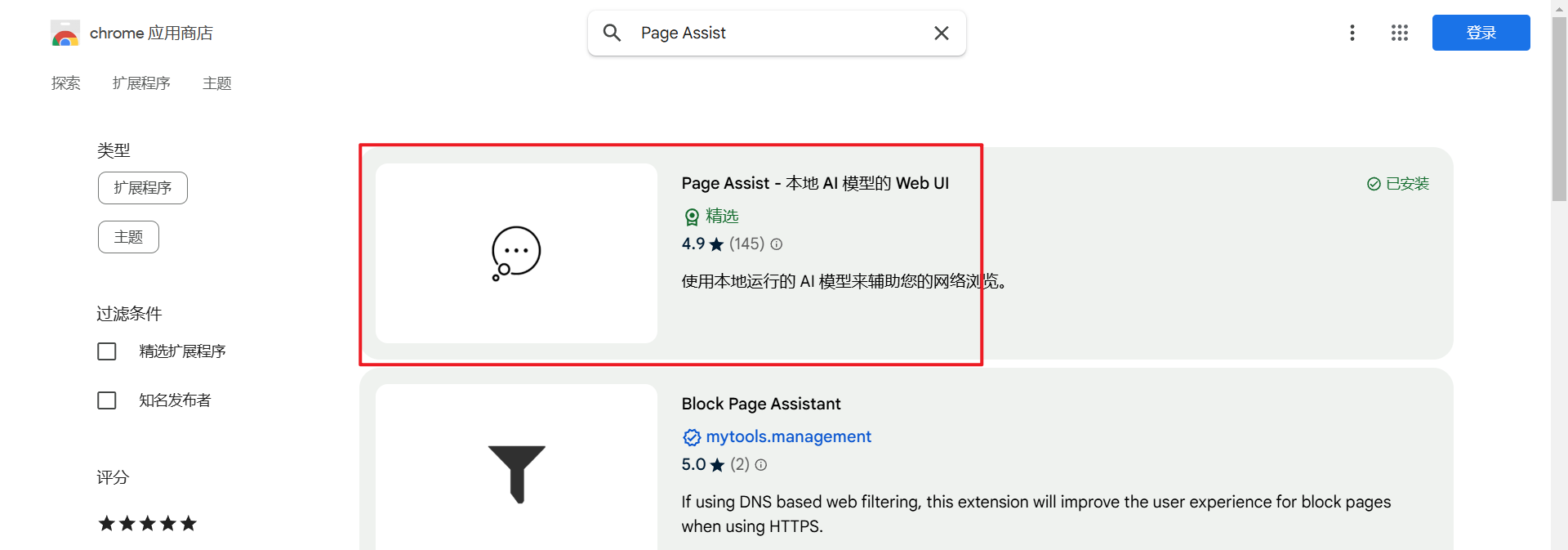

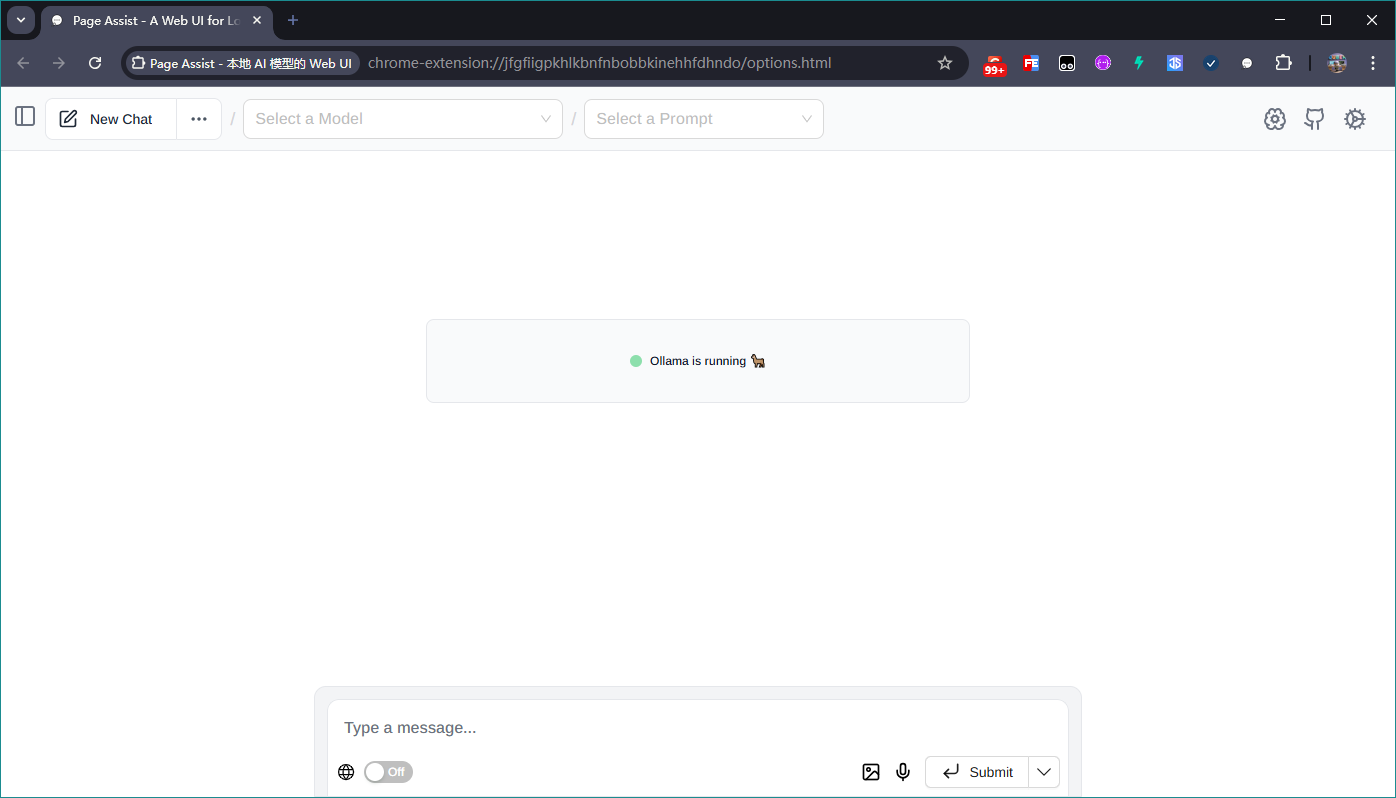

1. 使用Chrome插件-Page Assist

① 首先我们通过谷歌浏览器官方插件地址搜索Page Assist,下载第一个插件,如下图所示:

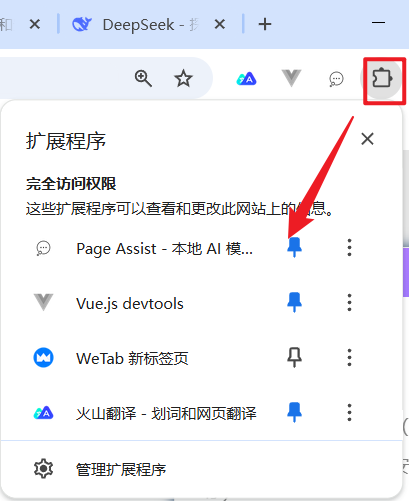

② 安装完成后,可以将该插件固定到 浏览器顶部,方便使用,如下图所示

③ 随后我们点击该插件,就会出现如下图所示的界面:

注意:如果界面出现:Unable to connect to Ollama的提示,说明Ollama没有启动;

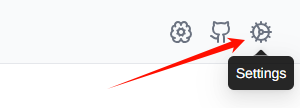

④ 设置中文:点击界面右上角的Settings按钮,将语言设置为简体中文,如下图所示:

设置完成后返回主界面,此时就是中文界面了。

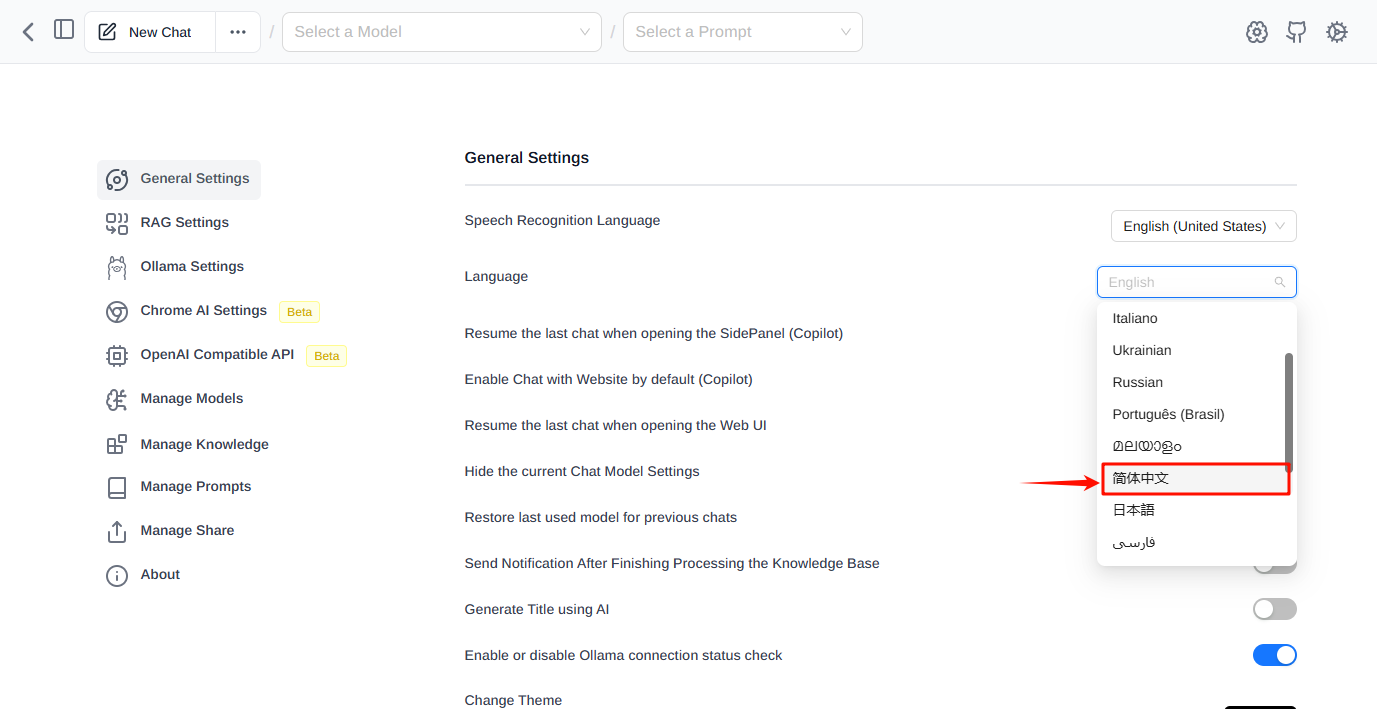

⑤ 选择模型:点击主界面中的第一个下拉框,选择一个我们下载的模型deepseek-r1:1.5,如下图

到此配置完成,我们就可以愉快的对话了,如下图:

4️⃣搭建个人知识库

1.安装“词嵌入模型”

- 当我们给deepseek搭建自己的知识库体系时,需要用到一个嵌入模型:shaw/dmeta-embedding-zh

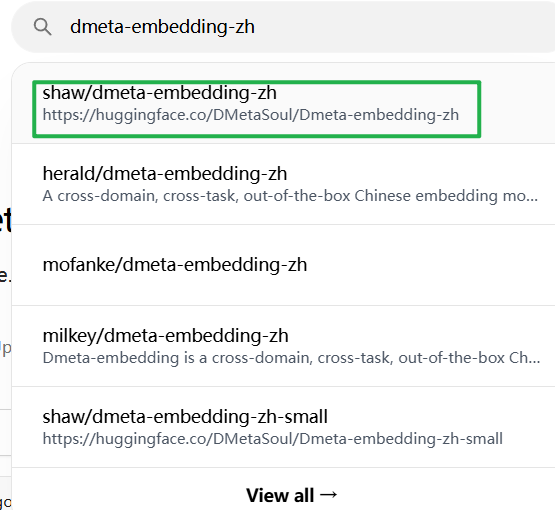

① 再次打开Ollama官网,搜索 dmeta-embedding-zh 选择第一个词条

② 同样的,复制右侧下载指令,粘贴到CMD执行 如下图:

2. 安装Cherry Studio

- Cherry Studio是一款AI知识库集成软件

- 官网:

Cherry Studio - 全能的AI助手

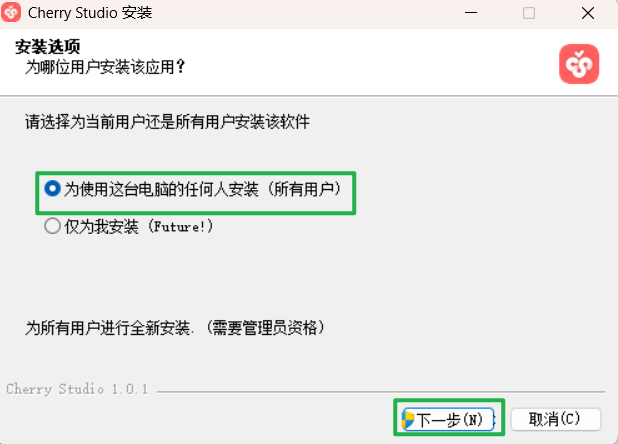

① 打开Cherry Studio官网,下载windows版 ,并根据引导安装即可;

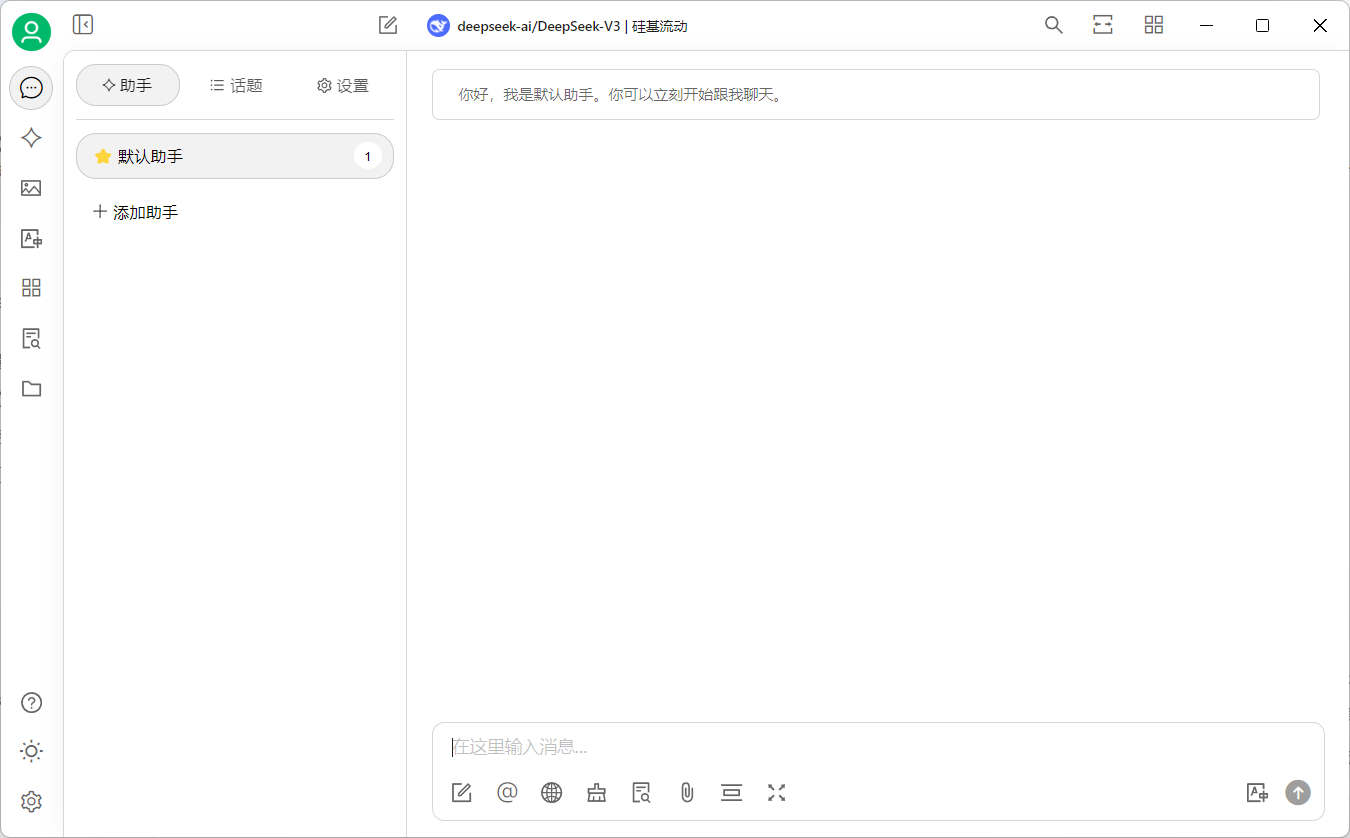

安装成功后,界面如下图所示:

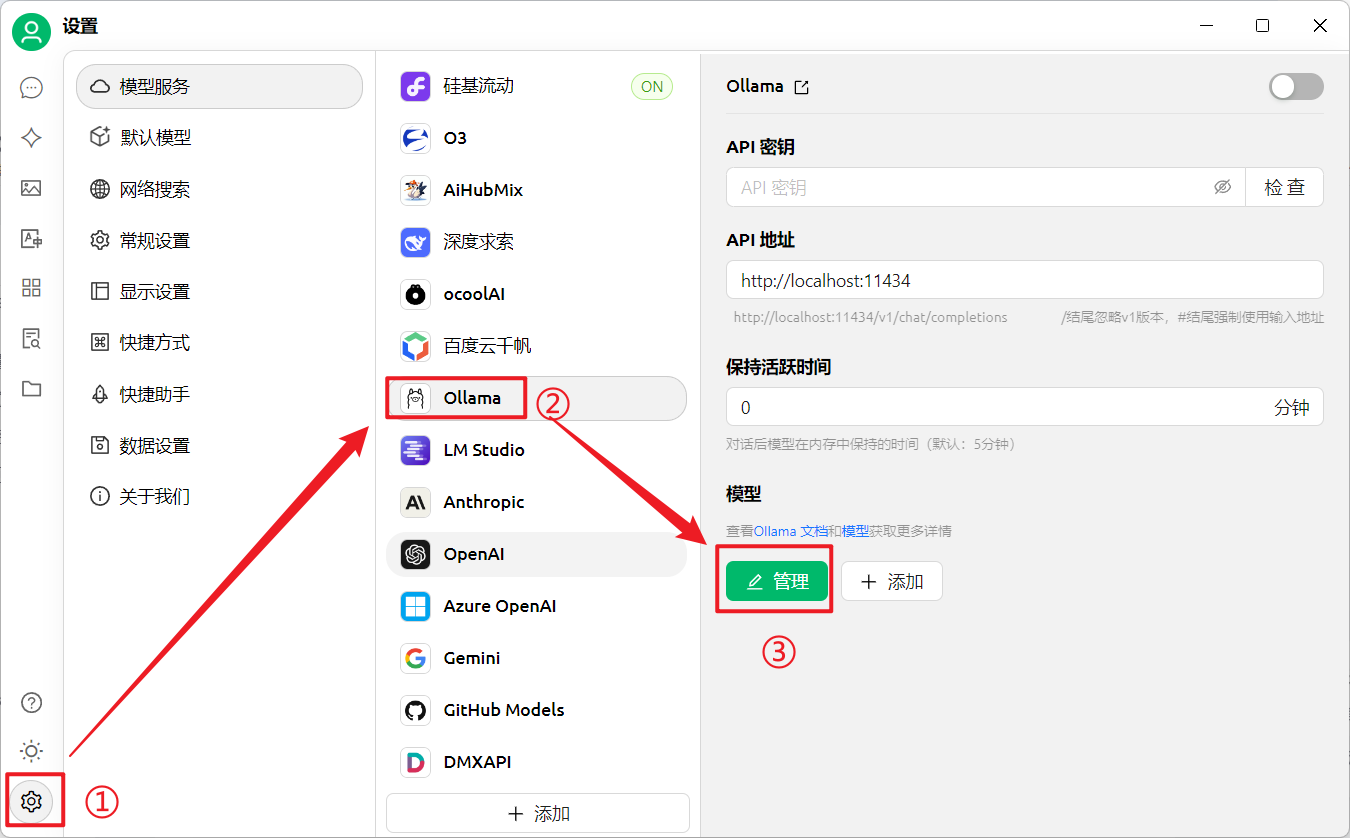

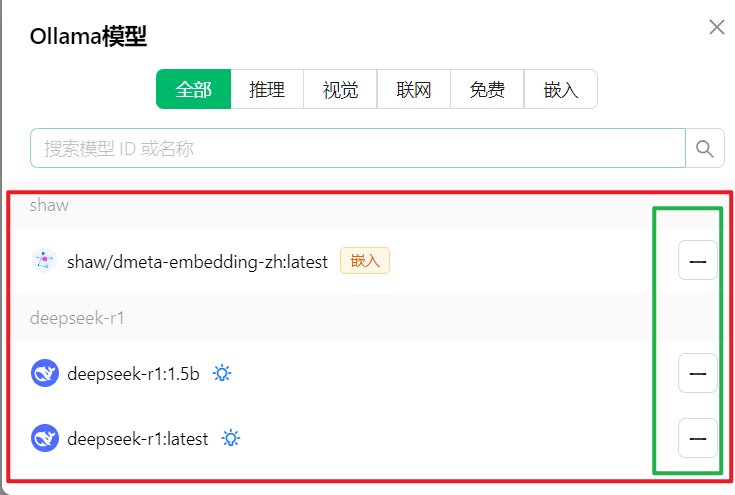

② 在 Cherry Studio中导入本地下载好的DeepSeek

(设置 —> Ollama —> 管理)

(在管理界面,我们可以看到所有从Ollama下载到本地的大模型,然后点击右侧➕号即可导入)

如下图:

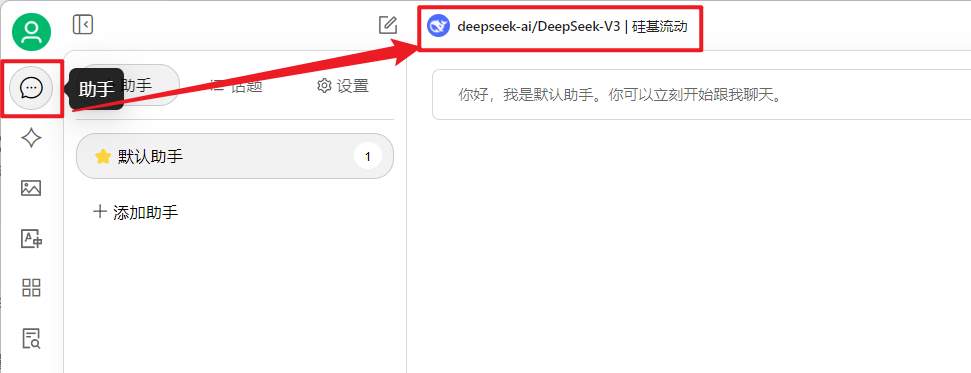

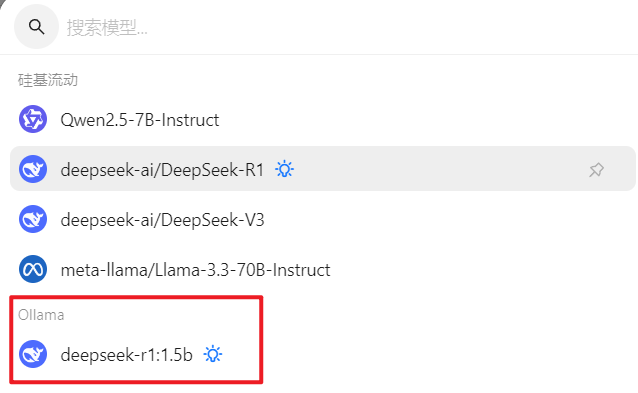

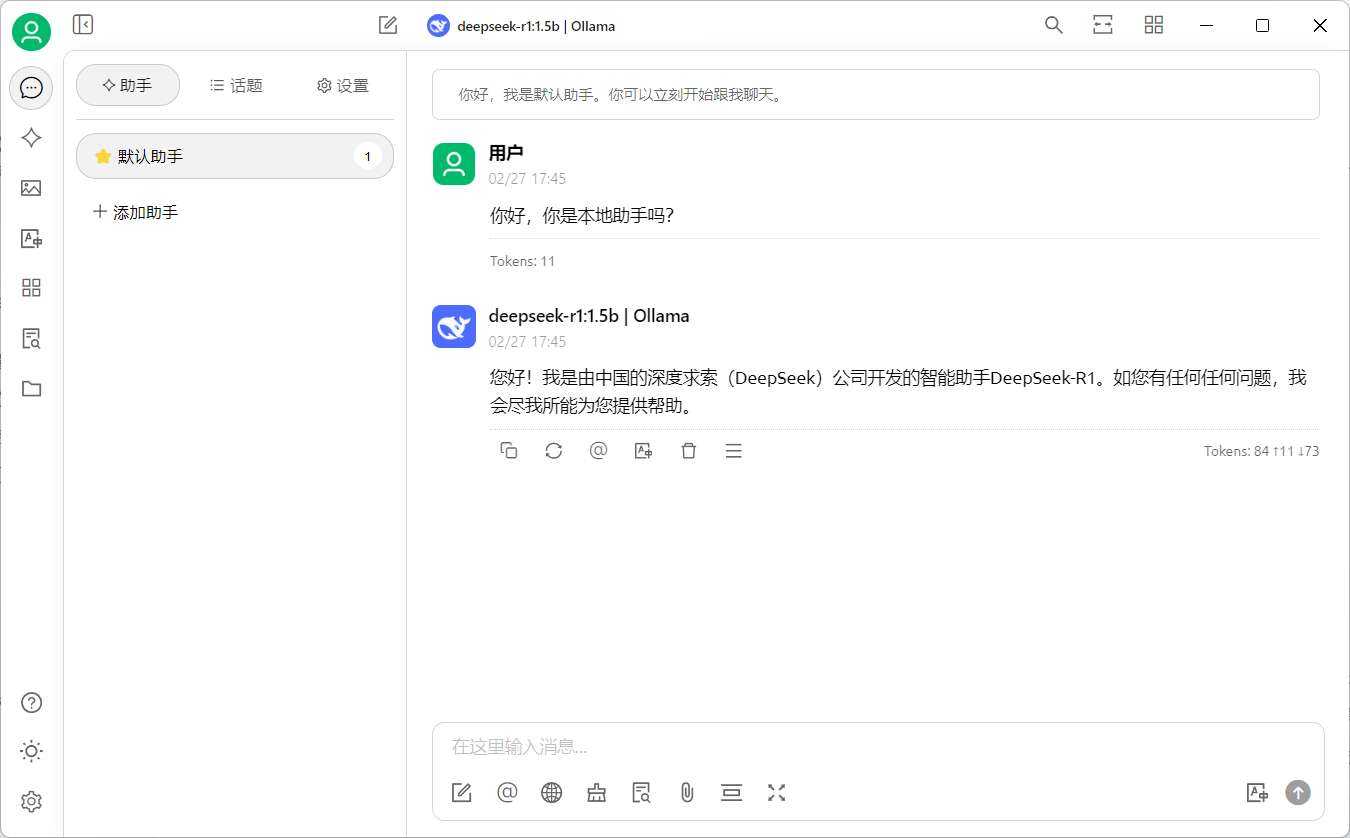

③ 导入成功后,再次回到助手界面,点击顶部模型切换版本;

(之后我们也可以在该界面使用我们本地的deepSeek了,也是美化了使用界面)

3. 导入个人知识库

① 点击左侧知识库一栏,添加知识库

给自己的知识库起个名字,然后选择之前下载好的"词嵌入模型",如下图:

注意:如果这里没有显示的话,可能是你没有导入进来;(记得在上几步管理界面点击加号导入)

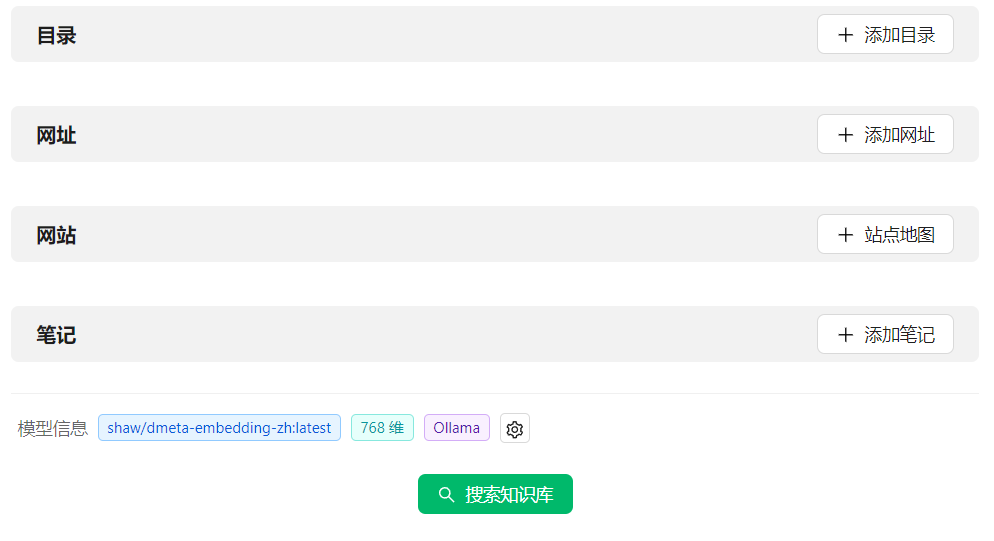

然后,在以下界面,你可以导入自己的知识库 喂给AI大模型;

直接拖过来即可

当然,你也可以导入一些网址、网站、笔记等等

看看效果:

可能是 本人的电脑太垃了🥲,跑7b的Deepseek模型,回答一个问题要215秒哈😂

至此,我们就完成了 Ollama的下载和安装+本地部署DeepSeek+UI可视化+搭建个人知识库的操作;如果有任何问题,欢迎大家评论区交流探讨!🎉🎉🎉

5万+

5万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?