小全读论文《End-to-End Incremental Learning》ECCV 2018

Motivation

本文关注的是增量学习问题,本文指出一个基于深度学习的增量方法需要符合下列特征:

1)可训性,模型应该具备对数据流数据的训练能力,也就是说即使不同类别的数据以不同顺序的形式在不同时间段出现,模型依然能对数据进行训练;

2)有效性,在新类别和旧类别都有比较好的性能

3)资源有限性,模型的参数以及不能随着数据的流入而不断增大;

4)模型可以同时对分类器和特征提取器进行更新,实现端到端的训练;

本文指出,即使学者们在增量学习领域做出了不少努力,但是没有一个现存的工作能同时满足上面所有性质,如

1)有些方法把分类器和特征学习任务是解耦,或者受限于一些特定的场景,如学习新的数据集,其类别并不是和旧类别相关

(读者认为文章中该点的描述有点偏差,文章提出说针对分类器和特征学习任务是解耦的例子是iCaRL,但是iCaRL的分类器是依赖于特征学习的,他们的关系并非是独立的)

2)有些方法尝试采取一些额外的分类器,如SVM,本文认为这些分类器是不适合深度学习结构的

3)有些方法会导致网络的参数的快速增加,如一些方法为新类别训练一个新的网络

相对于其他方法,本文的方法的一个核心点在于:实现了分类器和特征提取器的端到端的训练

Approach

与iCaRL类似,本文也提出了一个样本集,用来存储旧类别的数据。我们首先介绍模型的整体框架,然后再进一步介绍算法的整体训练流程。

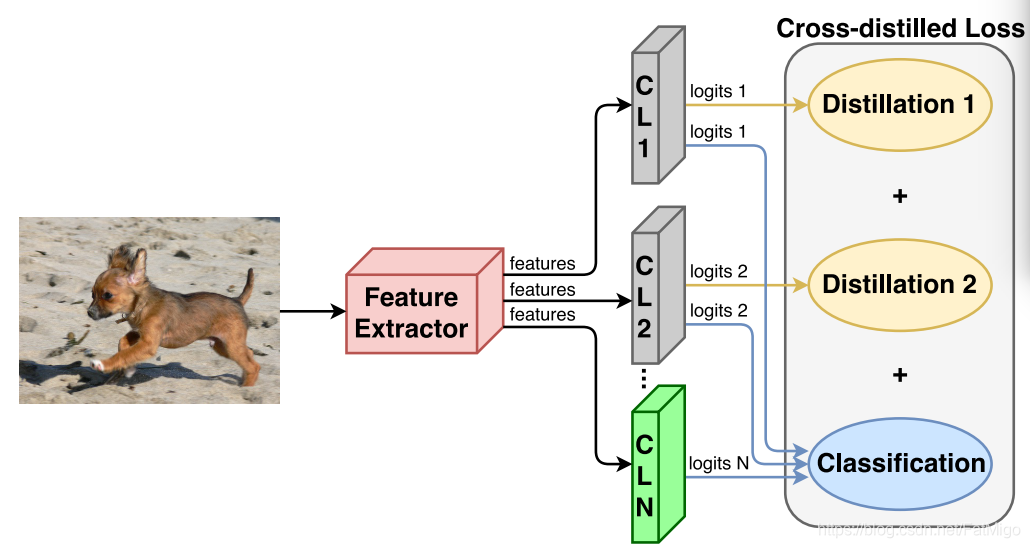

模型框架

本文提出的框架也很直接,和之前很多方法也是一致的,当遇到新类别的时候,在网络的顶部增加了分类器层,采取知识蒸馏的loss和分类loss结合的主流方式,利用新类别的数据和样本集的数据对整体模型进行更新。

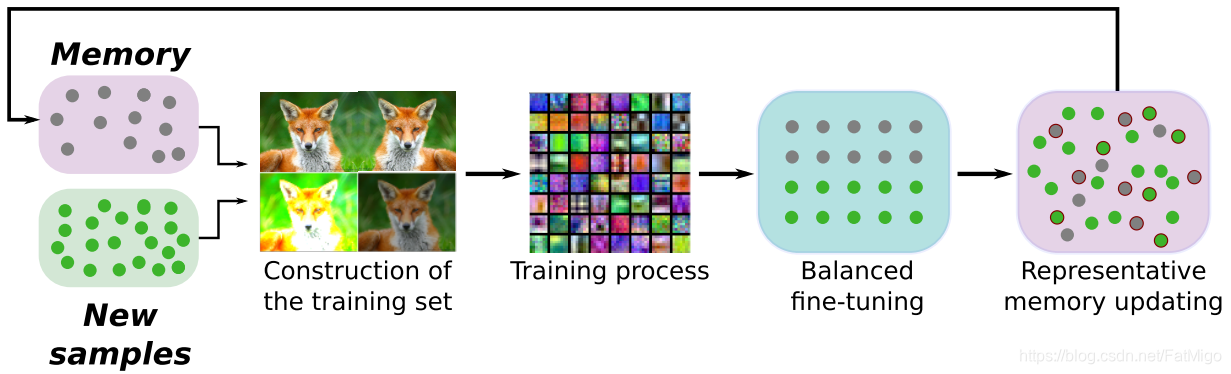

算法流程

和iCaRL类别,本文也提出了一个样本集存储旧类别的数据。本文方法包含了四个过程:

1)训练集的构建(construction of the training set)

2)训练过程(training process)

3)基于均衡采样的微调(balanced fine-tuning)

4)代表性存储空间的更新(representative memory updating)

训练集的构建(construction of the training set)

训练集包含了新类别的数据以及样本集的数据,并提取训练集每张图片在旧模型上的响应

训练过程(training process)

文章采取了流行的双loss的形式:知识蒸馏的loss和分类的loss,具体地:

L ( ω ) = L C ( ω ) + ∑ f = 1 F L D f ( ω ) L(\omega) = L_C(\omega) +\sum_{f=1}^F{L_{D_f}(\omega)} L(ω)=LC(ω)+∑f=1F

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2073

2073

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?