源码

MNIST_Training_By_FileName_Dataset

MNIST_Training_By_TXTLabel

简介

本文主要探讨两种不同的数据集获取labels的方法

-

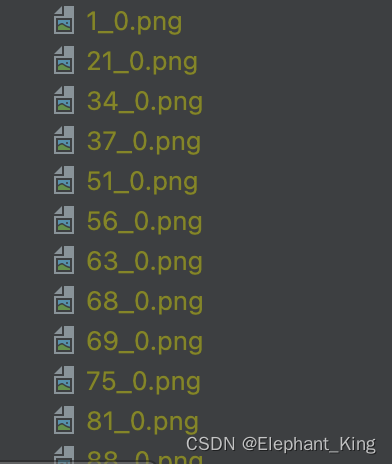

根据图片的文件名中获取文件标签

-

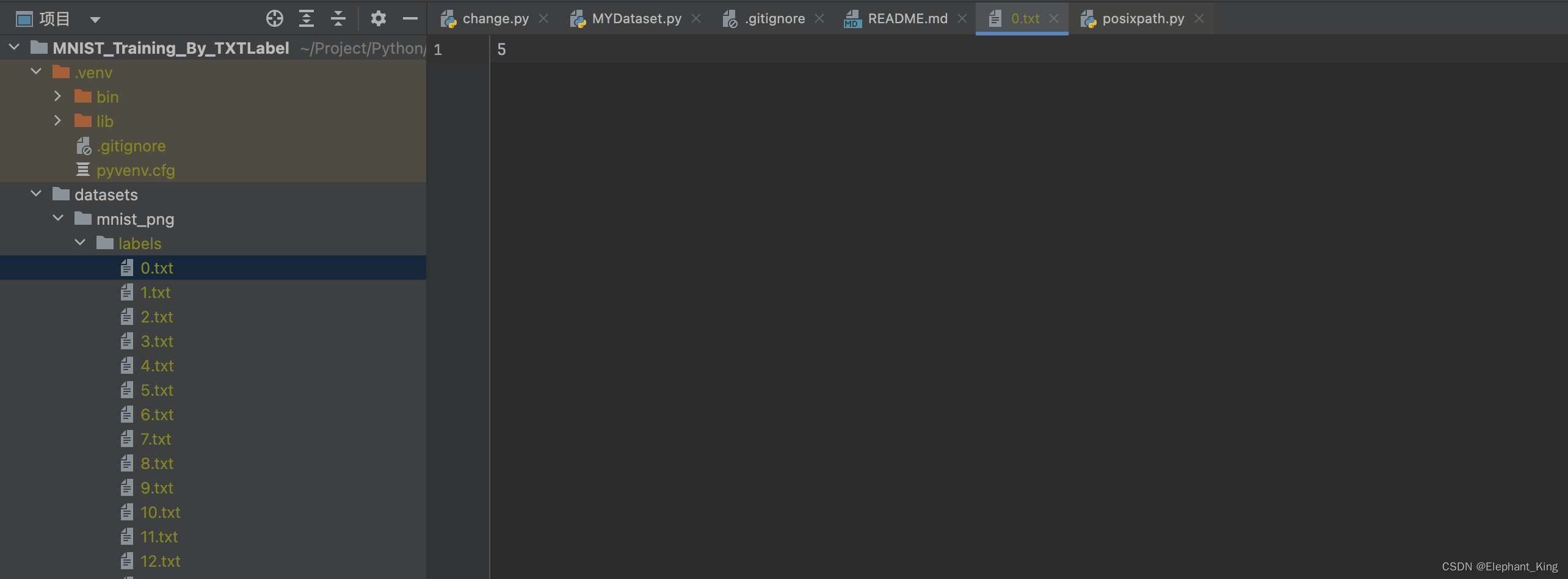

根据与图片名称相同的

.txt文件获取文件名

根据图片名称获取labels

主要的区别在__init__方法中

def __init__(self, root_path, train, transform=None):

self.root_path = root_path

self.transform = transform

if train:

self.root_path = os.path.join

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2094

2094

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?