探索与利用

一、序列决策任务中的基本问题

探索和利用

基于目前策略获取已知最优收益还是尝试不同的决策

- Exploitation执行能够获得已知最优收益的决策

利用现在已知的认知,选择当前最好策略 - Exploration尝试更多可能的决策,不一定会是最优收益

当前的最好策略不一定最优,通过探索找到可能的更优策略

π(当前策略)≠π∗(最优策略)\pi(当前策略)\neq\pi^{*}(最优策略)π(当前策略)=π∗(最优策略)

探索过程中策略和价值函数的变化情况(可能发现更好的策略):

εt={πti∣i=1,…,n}→探索εt+1={πti∣i=1,…,n}∪{πej∣j=1,…,m}\varepsilon_{t} = \{\pi^{i}_{t} | i=1,\dots,n\} \xrightarrow[]{探索} \varepsilon_{t+1} = \{\pi^{i}_{t} | i=1,\dots,n\}\cup \{\pi^{j}_{e}|j=1,\dots,m\}εt={πti∣i=1,…,n}探索εt+1={πti∣i=1,…,n}∪{πej∣j=1,…,m}

∃V∗(⋅∣πti∼εt)≤V∗(⋅∣πt+1i∼εt+1)πt+1i∼{πei∣i=1,…,m}\exist{V^{*}}(\cdot|\pi^{i}_{t}\sim\varepsilon_{t})\leq V^{*}(\cdot|\pi^{i}_{t+1}\sim\varepsilon_{t+1}) \qquad \pi^{i}_{t+1}\sim\{\pi^{i}_{e}|i=1,\dots,m\}∃V∗(⋅∣πti∼εt)≤V∗(⋅∣πt+1i∼εt+1)πt+1i∼{πei∣i=1,…,m}

例子:餐厅吃饭(探索和利用的关系)

- 总是选择自己熟悉的餐厅,即利用当前的最优策略(Exploitation)

- 偶尔选择自己没有去过的餐厅,对其他策略的探索(Exploration)

二、策略探索的一些原则

- 朴素方法(Naive Exploration)

添加策略噪声ϵ−greedy\epsilon-greedyϵ−greedy - 积极初始化(Optimistic Initialization)

给价值函数较高的初始化 - 基于不确定性的度量(Uncertainty Measurement)

尝试具有不确定收益的策略,可能带来更高的收益 - 概率匹配(Probability Matching)

基于概率选择最佳策略 - 状态搜索(State Searching)

探索后续状态可能带来更高收益的策略

三、多臂老虎机

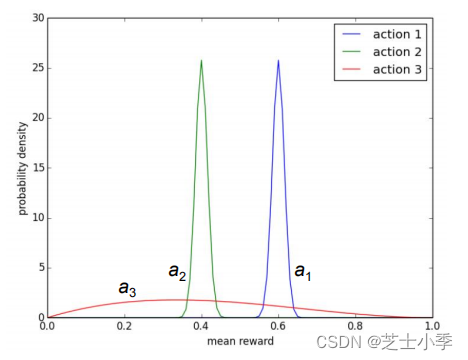

多臂老虎机的定义

多臂老虎机(Multi-arm Bandit)问题的形式化描述

⟨A,R⟩\left\langle \mathcal{A},\mathcal{R} \right\rangle⟨A,R⟩

动作集合:

ai∈A,i=1,…,Ka^{i}\in\mathcal{A},i=1,\dots,Kai∈A,i=1,…,K

收益(反馈)函数分布:

R(r∣ai)=P(r∣ai)\mathcal{R}(r|a^{i})=\mathbb{P}(r|a^{i})R(r∣ai)=P(r∣ai)

最大化累积时间的收益:

max∑t=1Trt,rt∼R(⋅∣a)\max\sum^{T}_{t=1}{r_{t},r_{t}\sim\mathcal{R(\cdot|a)}}maxt=1∑Trt,rt∼R(⋅∣a)

收益估计

期望收益和采样次数的关系:

Qn(ai)=r1+r2+⋯+rn−1n−1Q_{n}(a^{i})=\frac{r_{1}+r_{2}+\cdots+r_{n-1}}{n-1}Qn(ai)=n−1r1+r2+⋯+rn−1

缺点:每次更新的空间复杂度是O(n)O(n)O(n)

增量实现:

Qn+1(ai):=1n∑i=1nri=1n(rn+n−1n−1∑i=1n−1ri)=1nrn+n−1nQn=Qn+1n(rn−Qn)Q_{n+1}(a^{i}):=\frac{1}{n}\sum^{n}_{i=1}r_{i}=\frac{1}{n}\left(r_{n}+\frac{n-1}{n-1}\sum^{n-1}_{i=1}{r_{i}}\right)=\frac{1}{n}r_{n}+\frac{n-1}{n}Q_{n}=Q_{n}+\frac{1}{n}(r_{n}-Q_{n})Qn+1(ai):=n1i=1∑nri=n1(rn+n−1n−1i=1∑n−1ri)=n1rn+nn−1Qn=Qn+n1(rn−Qn)

误差项: Δni\Delta^{i}_{n}Δni

空间复杂度: O(1)O(1)O(1)

算法:多臂老虎机

- 初始化:Q(ai):=ci,N(ai)=0,i=1,…,nQ(a^{i}):=c^{i},N(a^{i})=0,i=1,\dots,nQ(ai):=ci,N(ai)=0,i=1,…,n

- 主循环 t=1:Tt=1:Tt=1:T

- 利用策略 π\piπ 选取某个动作 aaa

- 获取收益:rt=Bandit(a)r_{t}=Bandit(a)rt=Bandit(a)

- 更新计数器:N(a):=N(a)+1N(a):=N(a)+1N(a):=N(a)+1

- 更新估值:Q(a):=Q(a)+1N(a)[rt−Q(a)]Q(a):=Q(a)+\frac{1}{N(a)}[r_{t}-Q(a)]Q(a):=Q(a)+N(a)1[rt−Q(a)]

Regret函数

决策的期望收益:

Q(ai)=Er∼P(r∣ai)[r∣ai]Q(a^{i})=\mathbb{E}_{r\sim\mathbb{P}(r|a^{i})}[r|a^{i}]Q(ai)=Er∼P(r∣ai)[r∣ai]

最优收益:

Q∗=maxai∈AQ(ai)Q^{*}=\mathop{max}\limits_{a^{i}\in\mathcal{A}}Q(a^{i})Q∗=ai∈AmaxQ(ai)

决策与最优决策的收益差:

R(ai)=Q∗−Q(ai)R(a^{i})=Q^{*}-Q(a^{i})R(ai)=Q∗−Q(ai)

Total Regret 函数:

σR=Ea∼π[∑t=1TR(ati)]\sigma_{R}=\mathbb{E}_{a\sim\pi}[\sum^{T}_{t=1}{R(a^{i}_{t})}]σR=Ea∼π[t=1∑TR(ati)]

等价性:

minσR=maxEa∼π[∑t=1TQ(ati)]\min\sigma_{R}=\max\mathbb{E}_{a\sim\pi}[\sum^{T}_{t=1}Q(a^{i}_{t})]minσR=maxEa∼π[t=1∑TQ(ati)]

随着时间推移,单步regret越来越小

如果一直探索新策略:σR∝T⋅R\sigma_{R}\propto T \cdot RσR∝T⋅R ,total regret将线性递增,无法收敛

如果一直不探索新策略:σR∝T⋅R\sigma_{R} \propto T \cdot RσR∝T⋅R ,total regret将线性递增

是否存在一个方法具有次线性(sublinear)收敛保证的regret?

下届(Lai & Robbins)

使用 Δa=Q∗−Q(a)\Delta_{a}=Q^{*}-Q(a)Δa=Q∗−Q(a) 和反馈函数分布相似性:DKL(R(r∣a)∣∣R∗(r∣a))D_{KL}(\mathcal{R}(r|a)||\mathcal{R}^{*}(r|a))DKL(R(r∣a)∣∣R∗(r∣a)) 描述

limT→∞σR≥logT∑a∣Δa>0ΔaDKL(R(r∣a)∥R∗(r∣a))\lim\limits_{T\rightarrow\infty}{\sigma_{R}\geq\log{T}\sum\limits_{a|\Delta_{a}>0}{\frac{\Delta_{a}}{D_{KL}(\mathcal{R}(r|a)\Vert\mathcal{R}^{*}(r|a))}}}T→∞limσR≥logTa∣Δa>0∑DKL(R(r∣a)∥R∗(r∣a))Δa

以O(logT)O(\log{T})O(logT)的速度收敛

四、策略探索的方法

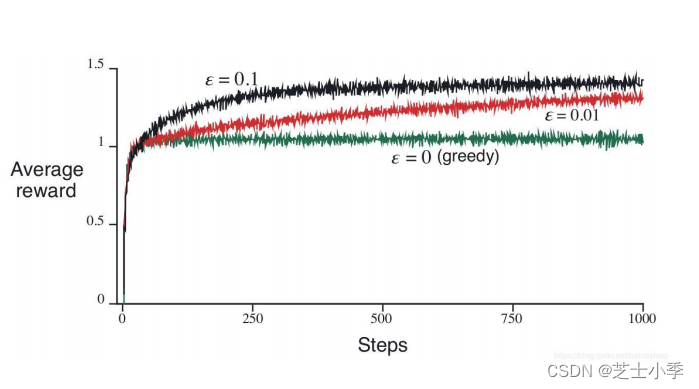

贪心策略和 ϵ−greedy\epsilon-greedyϵ−greedy 策略

-

贪心策略

Q(ai)=1N(ai)∑t=1Trt⋅1(at=ai)Q(a^{i})=\frac{1}{N(a^{i})}\sum^{T}_{t=1}{r_{t}\cdot 1(a_{t}=a^{i})}Q(ai)=N(ai)1t=1∑Trt⋅1(at=ai)

a∗=argmaxaiQ(ai)a^{*}=\arg\max\limits_{a^{i}}Q(a^{i})a∗=argaimaxQ(ai)

σR∝T⋅[Q(ai)−Q∗]\sigma_{R}\propto T\cdot [Q(a^{i})-Q^{*}]σR∝T⋅[Q(ai)−Q∗]

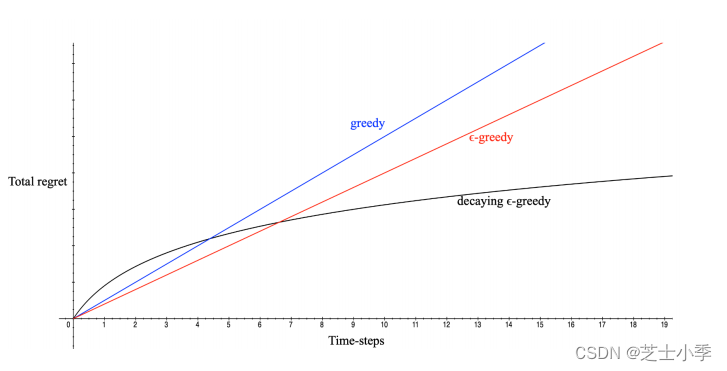

线性增长的Total Regret

-

ϵ−greedy\epsilon-greedyϵ−greedy策略

at={argmaxaQ(a)1−ϵU(0,∣A∣)ϵ a_{t} = \begin{cases} {\arg\max\limits_{a}Q(a)} & {1-\epsilon}\\ {\quad U(0,|\mathcal{A}|)} & {\quad\epsilon} \end{cases} at={argamaxQ(a)U(0,∣A∣)1−ϵϵ常量ϵ\epsilonϵ保证total regret满足

σR≥ϵ∣A∣∑a∈AΔa\sigma_{R}\geq\frac{\epsilon}{\left|\mathcal{A}\right|}\sum\limits_{a\in\mathcal{A}}\Delta_{a}σR≥∣A∣ϵa∈A∑Δa

Total Regret仍然是线性递增的,只是增长率比贪心策略小 -

衰减贪心策略

ϵ−greedy\epsilon-greedyϵ−greedy 的变种,ϵ\epsilonϵ 随着时间衰减

理论上对数渐进收敛

一种可能的衰减方式:c≥0,d=mina∣Δa>0Δa,ϵt=min{1,c∣A∣d2t}c\geq0,\qquad d=\min\limits_{a|\Delta_{a}>0}{\Delta_{a}},\qquad \epsilon_{t}=\min\left\{1,\frac{c|\mathcal{A}|}{d^{2}t}\right\}c≥0,d=a∣Δa>0minΔa,ϵt=min{1,d2tc∣A∣}

缺点:很难找到合适的衰减规划

不同 ϵ−greedy策略对比\epsilon-greedy策略对比ϵ−greedy策略对比

- Total Regret

- 平均收益

积极初始化

给 Q(ai)Q(a^{i})Q(ai) 一个较高的初始化值

增量式蒙特卡洛估计更新 Q(ai)Q(a^{i})Q(ai)

Q(ai):=Q(ai)+1N(ai)(rt−Q(ai))Q(a^{i}):=Q(a^{i})+\frac{1}{N(a^{i})}(r_{t}-Q(a^{i}))Q(ai):=Q(ai)+N(ai)1(rt−Q(ai))

有偏估计,但是随着采样增加,这个偏差带来的影响会越来越小

但是仍然可能陷入局部最优,可能会出现最优策略估计的过低而一直无法被选择的情况

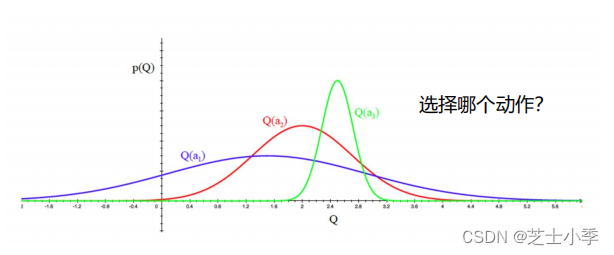

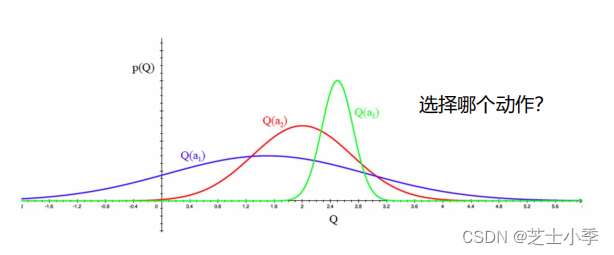

显式地考虑动作的价值分布

考虑以上三个动作的价值分布,平衡探索和利用,选择哪个动作?

- 显式地鼓励不确定性

- 直接根据分布采样来选择

基于不确定性测度

不确定性越大的Q(ai)Q(a^{i})Q(ai),越具有探索的价值,有可能会是最好的策略

一个经验性指导:

- N(a)N(a)N(a)大,U(a)U(a)U(a)小

- N(a)N(a)N(a)小,U(a)U(a)U(a)大

策略

π:a=argmaxa∈AQ^(a)+U^(a)\pi:a=\arg\max\limits_{a\in\mathcal{A}}{\hat{Q}(a)+\hat{U}(a)}π:a=arga∈AmaxQ^(a)+U^(a)

也称为UCB:上置信界法(Upper Confidence Bounds)

UCB:上置信界

Hoeffding不等式:

P[E[x]>xˉt+u]≤e−2tu2forx∈[0,1]\mathbb{P}[\mathbb{E}[x]>\bar{x}_{t}+u]\leq e^{-2tu^{2}}\quad for \quad x\in[0,1]P[E[x]>xˉt+u]≤e−2tu2forx∈[0,1]

为每一个动作收益估值估计一个上置信界:U^(a)\hat{U}(a)U^(a)

显然有:Qt(a)≤Q^t(a)+U^t(a)Q_{t}(a)\leq\hat{Q}_{t}(a)+\hat{U}_{t}(a)Qt(a)≤Q^t(a)+U^t(a)以一个概率ppp不成立(Hoeffding不等式)

依据以下原则挑选进行决策:

a=argmaxa∈AQ^t(a)+U^t(a)a=\arg\max\limits_{a\in\mathcal{A}}{\hat{Q}_{t}(a)+\hat{U}_{t}(a)}a=arga∈AmaxQ^t(a)+U^t(a)

e−2Nt(a)Ut(a)2=p⟶U^t(a)=−logp2Nt(a)e^{-2N_{t}(a)U_{t}(a)^{2}}=p\longrightarrow\hat{U}_{t}(a)=\sqrt{-\frac{\log{p}}{2N_{t}(a)}}e−2Nt(a)Ut(a)2=p⟶U^t(a)=−2Nt(a)logp

收敛性:

limt→∞σR≤8logt∑a∣Δa>0Δa\lim\limits_{t\rightarrow\infty}{\sigma_{R}}\leq 8\log{t}\sum\limits_{a|\Delta_{a}>0}\Delta_{a}t→∞limσR≤8logta∣Δa>0∑Δa

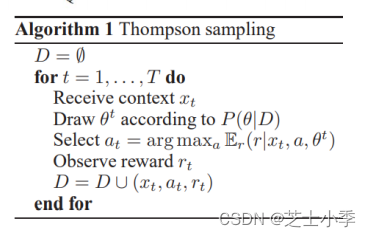

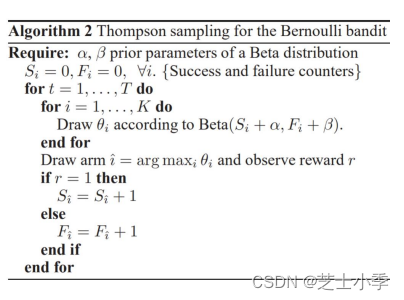

Thompson Sampling方法

想法:根据每个动作成为最优的概率来选择动作

p(a)=∫∏[Ep(Q(a))[Q(a;θ)]=maxa′∈AEp(Q(a′))(Q(a′;θ))]dθp(a)=\int{\prod[\mathbb{E}_{p(Q(a))}[Q(a;\theta)]=\max\limits_{a'\in\mathcal{A}}{\mathbb{E}_{p(Q(a'))}(Q(a';\theta))}]d\theta}p(a)=∫∏[Ep(Q(a))[Q(a;θ)]=a′∈AmaxEp(Q(a′))(Q(a′;θ))]dθ

实现:根据当前每个动作aia_{i}ai的价值概率分布p(Q(ai))p(Q(a_{i}))p(Q(ai))来采样到其价值Q(ai)Q(a_{i})Q(ai),选择价值最大的动作

实验:K-arm多臂老虎机,用Beta分布建模每个arm的成功率,初始化成功率分布为Beat(1,1)

Beta(x;α,β)∝xα−1(1−x)β−1Beta(x;\alpha,\beta)\propto x^{\alpha-1}(1-x)^{\beta-1}Beta(x;α,β)∝xα−1(1−x)β−1

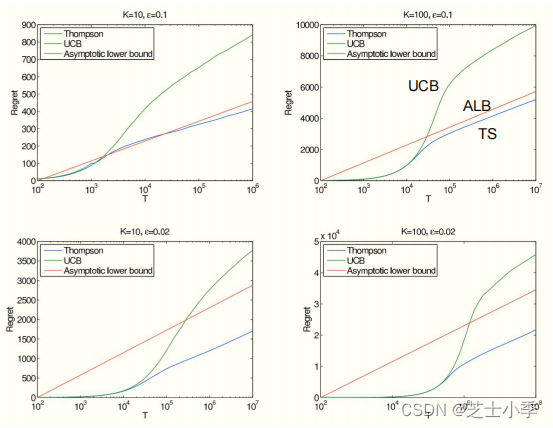

Thompson Sampling和UCB的实验对比

- K-arms

- The best arm has reward probability of 0.5

- K-1 other arms have the reward probability of 0.5−ϵ0.5-\epsilon0.5−ϵ

- Asymptotic lower bound(Lai & Robbins)

五、探索与利用总结

- 探索和利用是强化学习的trial-and-error中的必备技术

- 多播老虎机可以被看成是无状态(state-less)强化学习

只需要关注对每个动作的认知,没有环境给的状态 - 多臂老虎机是研究探索与利用技术理论的最佳环境

- 理论的渐进最优regret为O(logT)O(\log{T})O(logT)

- ϵ−greedy\epsilon-greedyϵ−greedy、UCB和Thompson Sampling方法在多臂老虎机任务中十分常用,在强化学习的探索中也十分常用,最常见的是ϵ−greedy\epsilon-greedyϵ−greedy

六、常见问题

Epsilon greedy在强化学习中得到了很广泛的应用,但是作为更加有效的方法,Thompson Sampling和UCB更多地只出现在Multi-Arm Bandit中,在强化学习中很少看到,是什么导致的这一现象呢?

- Epsilon greedy在RL里面是做探索的方法。其实RL领域也有不少其他的做探索的方法,只是专门在做探索,所以就不仅仅是UCB或者TS这种MAB的经典方法了。

- 例如,在树结构博弈里面UCB叫UCT(Upper Confidence bounds applied to Trees)

- Epsilon greedy用的多而UCB、Thompson Sampling等方法用的少,我觉得主要是因为RL的大部分value function都是点估计,也就是说V(s)V(s)V(s)和Q(s,a)Q(s,a)Q(s,a)都是给出一个数值。

如何理解积极初始化的Q是一个有偏估计,但是这个偏差带来的影响会随着采样增加而降低。

- Q是有偏估计是因为本页讨论的积极初始化方法为了加强探索给了所有的Q(a)Q(a)Q(a)一个较高的初始值(这样没有探索过action的就有较高Q值,会优先被选择),这样的Q相对于真实的Q分布显然是有偏的。

- 而随着采样的增加和增量式蒙特卡洛更新,每个Q(ai)Q(a^{i})Q(ai)的过高初始值会逐渐收敛到采样到的奖励rtr_{t}rt的平均值,这个过高初始值带来的偏差也就慢慢降低了。

本文围绕强化学习中的探索与利用展开。先介绍序列决策任务中探索和利用的概念及关系,以餐厅吃饭为例说明。接着阐述多臂老虎机的定义、收益估计等,分析Regret函数。还介绍多种策略探索方法,如贪心、ϵ−greedy等,并对常见问题进行解答。

本文围绕强化学习中的探索与利用展开。先介绍序列决策任务中探索和利用的概念及关系,以餐厅吃饭为例说明。接着阐述多臂老虎机的定义、收益估计等,分析Regret函数。还介绍多种策略探索方法,如贪心、ϵ−greedy等,并对常见问题进行解答。