1,准备

jdk1.7或者1.8 hadoop2.6 对应tar包

hadoop 运行需要java编写 运行需要jdk

rz 命令可以选择 对应的文件上传到linux

tar -zxvf ****.tar.gz 解压缩对应的tar 文件

2,配置java环境

java -version 查看java版本

将jdk的tar包 解压到自己定义的目录 ~/app/jdk1.7

pwd 查看 当前目录

配置java的环境变量

这里有两个文件可以配置 ~/.bash_profile 和 /etc/profile 这两个文件配置哪里都可以

● vi ~/.bash_profile //超级用户所有 hadoop环境要配置在这里面

● vi /etc/profile //独立用户所有

在上述两个文件其中任意一个加入以下配置

export JAVA_HOME=/root/app/jdk1.7.0_80

export PATH=$PATH:$JAVA_HOME/bin

生效环境变量

source /etc/profile

再次查看 java -version

3,配置hadoop环境

cd ~/app

在app文件下生成hadoop目录

mkdir hadoop

rz 将hadoop的tar包上传到 hadoop目录下

解压tar

tar -zxvf ***hadoop.26.tar.gz

增加hadoop的ssh免密登录

生成无密码公钥

ssh-keygen -t dsa -p '' -f ~/.ssh/id_dsa

追加公钥到authorized_keys

cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys

验证ssh登录

ssh locahhost

ssh Master

修改主机名

vi /etc/hostname

Master

:x 或 :wq! 保存退出

指定ip

vi /etc/hosts

192.168.149.183 Master

创建三个hadoop 需要用到的三个相关文件夹

●mkdir /usr/local/hadoop/tmp

●mkdir -p /usr/local/hadoop/hdfs/name //-p 强制地柜创建文件夹

●mkdir /usr/local/hadoop/hdfs/data

配置hadoop环境变量

vi ~/.bash_profile //超级用户所有

HADOOP_HOME=/root/app/hadoop-2.6.4

PATH=$PATH:$HADOOP_HOME/bin

export HADOOP_HOME PATH

:wq! 退出报错

生效环境变量

source ~/.bash_profile

4,修改hadoop的配置文件

进入到

cd /root/app/hadoop-2.6.4/etc/hadoop

修改hadoop-env.sh 文件

vi hadoop-env.sh

修改jdk 配置

export JAVA_HOME=/root/app/jdk1.7.0_80

修改yarn-env.sh

vi yarn-env.sh

修改jdk 配置

export JAVA_HOME=/root/app/jdk1.7.0_80

修改核心配置文件 core-site.xml

vi core-site.xml

在configuration中增加如下参数

<property>

<name>fs.defaultFS</name>

<value>hdfs://MASTER:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/hadoop/tmp</value>//如果不存在会自动创建

</property>

修改hadoop底层存储 hdfs-site.xml

vi hdfs-site.xml

在configuration中增加如下参数

<property>

<name>dfs.namenode.name.dir</name>

<value>file://usr/local/hadoop/hdfs/name</value>//源数据

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file://usr/local/hadoop/hdfs/data</value>//datanode物理存储位置

</property>

<property>

<name>dfs.replication</name>//副本数

<value>1</value>//hadoop 默认副本数是3 javaApi 调用此设置不起作用

</property>

修改mapred-site.xml

cp mapred-site.xml.template mapred-site.xml

vi mapred-site.xml

在configuration中增加如下参数--指定mr要使用的框架 这里用yarn

<property>

<name>mapreduce.framwork.name</name>

<value>yarn</value>

</property>

修改yarn-site.xml

vi yarn-site.xml

在configuration中增加如下参数

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

5,格式化namenode --只需格式化一次 修改配置需要再次格式化

./hdfs namenode -format

// hadoop fs namenode -format

启动

./start-all.sh

chomd +x ./*.sh 增加脚本执行权限

6,查看

jps //一下节点

dataNode

ResourceManager

NameNode

NadeManager

SecondaryNameNode

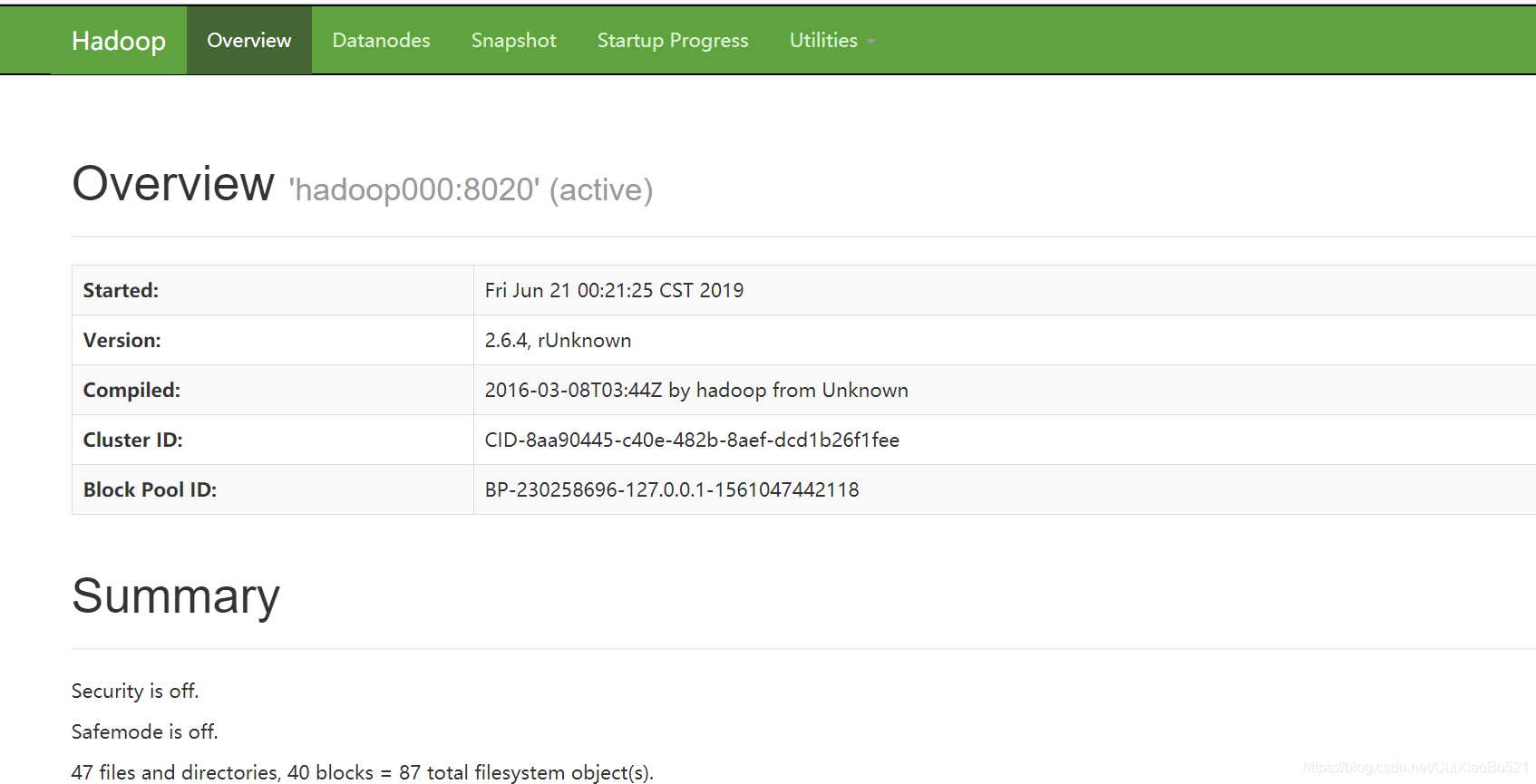

http://192.168.149.183:50070 //hadoop

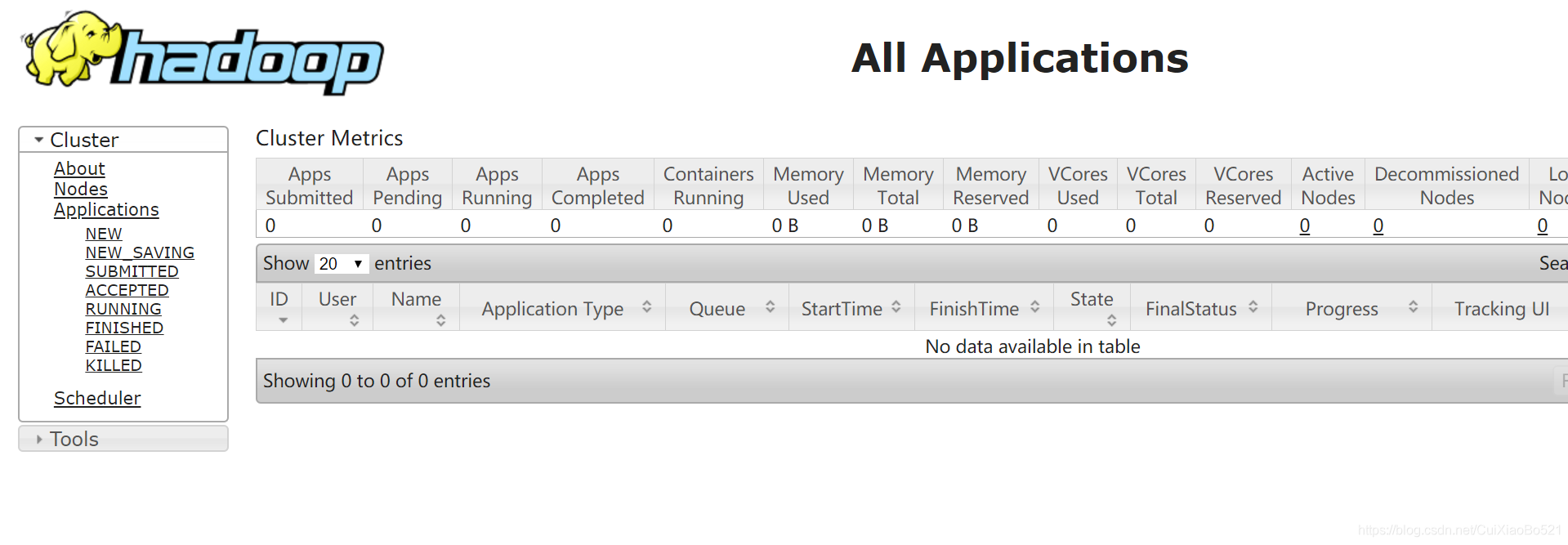

http://192.168.149.183:8088 //yarn

注意防火墙

查看状态

firewall-cmd --state --running

关闭防火墙

systemctl stop firewalld.service

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?