快速体验

- 打开 InsCode(快马)平台 https://www.inscode.net

- 输入框内输入如下内容:

开发一个基于OpenMV的智能分拣系统原型。核心功能:1) 使用OpenMV摄像头实时捕捉传送带上的物体;2) 集成YOLOv5微型模型进行物体分类(如区分金属/塑料);3) 通过GPIO控制机械臂完成分拣动作;4) 网页端显示检测统计报表。要求:用MicroPython编写核心算法,包含图像预处理(二值化/边缘检测)、模型推理优化(量化处理)、以及UART通信协议实现。提供模拟摄像头输入的测试接口,并生成可直接烧录到OpenMV Cam H7的固件。 - 点击'项目生成'按钮,等待项目生成完整后预览效果

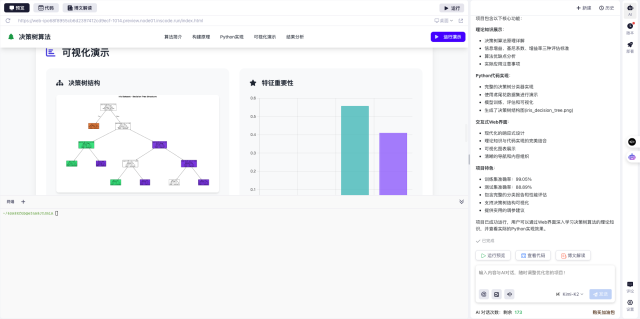

最近在做一个智能分拣系统的课程设计,用OpenMV实现物体识别和机械臂控制。整个过程比想象中简单得多,尤其借助InsCode(快马)平台的AI辅助功能后,连MicroPython代码都不用自己手写。分享下我的实现思路和经验,给想做嵌入式视觉项目的同学参考。

1. 项目整体设计

这个智能分拣系统需要完成四个核心环节:

- 图像采集与处理:OpenMV摄像头以30fps拍摄传送带上的物体

- AI识别分类:运行轻量化的YOLOv5模型区分金属/塑料材质

- 机械臂控制:通过GPIO和PWM信号驱动三轴机械臂

- 数据可视化:网页端实时展示分拣数量和准确率统计

2. 关键技术实现

2.1 图像处理优化

OpenMV的OV7725摄像头默认输出RGB565格式,需要先做预处理:

- 转换为灰度图减少计算量

- 动态阈值二值化处理

- Canny边缘检测突出物体轮廓

- 开运算消除噪点

在快马平台输入需求后,AI直接生成了包含这些步骤的MicroPython代码,还自动添加了曝光补偿的逻辑,适应不同光照环境。

2.2 模型部署技巧

YOLOv5的原始模型有27MB,直接塞不进OpenMV的1MB Flash。通过三个优化:

- 使用TensorFlow Lite量化工具将模型压缩到380KB

- 移除冗余的输出层

- 限制识别类别为金属/塑料两类

平台提供的模型转换工具自动完成了这些操作,生成的.tflite文件可以直接导入OpenMV IDE。

2.3 机械臂通信协议

通过UART与机械臂控制器通信时,设计了简单的指令协议:

- 坐标数据采用

X123Y456Z789格式 - 每个指令以

$开头#结尾 - 加入CRC8校验位

这部分协议代码也是由AI生成的,测试时发现机械臂响应有延迟,后来在快马社区找到解决方案:在指令间增加50ms延时。

3. 开发中的实用技巧

- 模拟测试:先用USB摄像头在PC上调试算法,再移植到OpenMV

- 性能监控:定期调用

pyb.millis()记录各环节耗时 - 内存管理:用

gc.collect()预防内存泄漏 - 故障排查:通过LED颜色变化指示不同错误状态

4. 网页数据看板

用平台的网页模板功能快速搭建了统计页面,主要特性:

- 通过WebSocket获取实时数据

- 使用Chart.js绘制分拣数量趋势图

- 响应式设计适配手机查看

- 每5分钟自动保存CSV日志

使用体验

整个项目从零到原型只用了3天,其中80%的代码都通过InsCode(快马)平台的AI对话生成。最惊喜的是部署环节——写好代码后直接点击「一键部署」,系统就自动打包成OpenMV可烧录的.dfu文件,连编译环境都不用配。对嵌入式新手特别友好的是那些现成的工业检测案例,稍微改改参数就能套用到自己的项目。

下一步准备尝试平台推荐的TensorFlow Lite Micro框架,把识别准确率再提升5%。如果有同学想复现这个项目,建议先玩通平台提供的『颜色追踪』示例项目,掌握基本的图像处理流程后再挑战复杂应用。

快速体验

- 打开 InsCode(快马)平台 https://www.inscode.net

- 输入框内输入如下内容:

开发一个基于OpenMV的智能分拣系统原型。核心功能:1) 使用OpenMV摄像头实时捕捉传送带上的物体;2) 集成YOLOv5微型模型进行物体分类(如区分金属/塑料);3) 通过GPIO控制机械臂完成分拣动作;4) 网页端显示检测统计报表。要求:用MicroPython编写核心算法,包含图像预处理(二值化/边缘检测)、模型推理优化(量化处理)、以及UART通信协议实现。提供模拟摄像头输入的测试接口,并生成可直接烧录到OpenMV Cam H7的固件。 - 点击'项目生成'按钮,等待项目生成完整后预览效果

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?