💡亲爱的技术伙伴们:

你是否正被这些问题困扰——

- ✔️ 投递无数简历却鲜有回音?

- ✔️ 技术实力过硬却屡次折戟终面?

- ✔️ 向往大厂却摸不透考核标准?

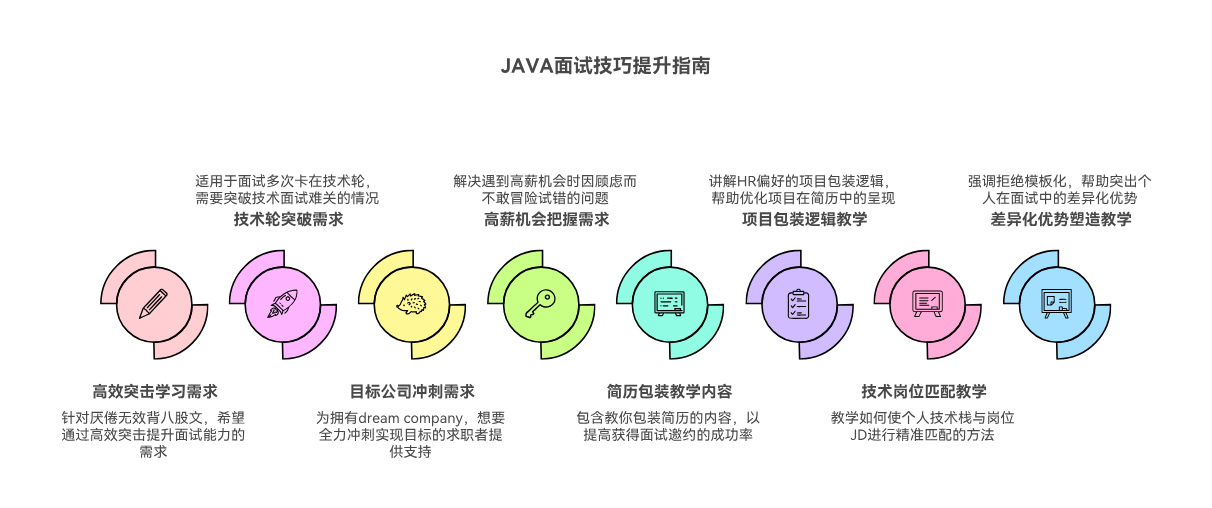

我打磨的《 Java高级开发岗面试急救包》正式上线!

- ✨ 学完后可以直接立即以此经验找到更好的工作

- ✨ 从全方面地掌握高级开发面试遇到的各种疑难问题

- ✨ 能写出有竞争力的简历,通过模拟面试提升面试者的面试水平

- ✨ 对自己的知识盲点进行一次系统扫盲

🎯 特别适合:

- 📙急需跳槽的在校生、毕业生、Java初学者、Java初级开发、Java中级开发、Java高级开发

- 📙非科班转行需要建立面试自信的开发者

- 📙想系统性梳理知识体系的职场新人

课程链接:https://edu.youkuaiyun.com/course/detail/40731课程介绍如下:

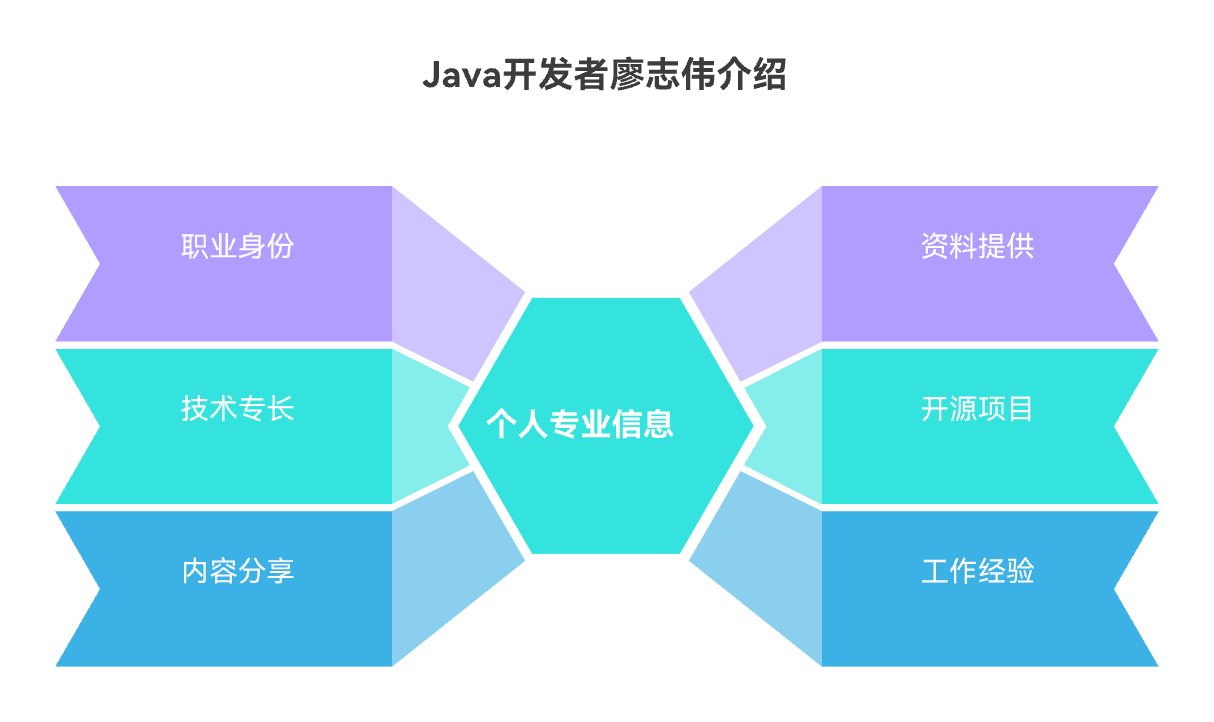

📕我是廖志伟,一名Java开发工程师、《Java项目实战——深入理解大型互联网企业通用技术》(基础篇)、(进阶篇)、(架构篇)、《解密程序员的思维密码——沟通、演讲、思考的实践》作者、清华大学出版社签约作家、Java领域优质创作者、优快云博客专家、阿里云专家博主、51CTO专家博主、产品软文专业写手、技术文章评审老师、技术类问卷调查设计师、幕后大佬社区创始人、开源项目贡献者。

🍊 Redis知识点之LFU:概念与原理

在当今大数据时代,缓存技术已成为提高系统性能的关键。Redis作为一款高性能的内存数据库,广泛应用于缓存场景。其中,LFU(Least Frequently Used)缓存淘汰策略是Redis中一种重要的缓存管理机制。本文将深入探讨Redis知识点之LFU:概念与原理,以帮助读者更好地理解和应用这一技术。

在现实场景中,我们常常会遇到这样的问题:当缓存空间有限时,如何有效地淘汰不再被频繁访问的数据,以保持缓存中数据的实时性和有效性?这就需要引入LFU缓存淘汰策略。LFU策略的核心思想是:淘汰最近一段时间内访问频率最低的数据。这种策略能够确保缓存中保留的是用户最常访问的数据,从而提高系统的响应速度和用户体验。

介绍LFU概念与原理的重要性在于,它不仅能够帮助我们优化缓存策略,提高系统性能,还能在数据量庞大、访问频率变化快的场景下,保证缓存数据的实时性和有效性。接下来,我们将对LFU的概念和原理进行详细阐述。

首先,让我们来了解LFU的概念。LFU缓存淘汰策略基于数据访问频率进行淘汰,即淘汰访问频率最低的数据。这种策略的优点在于,它能够根据数据的使用情况动态调整缓存内容,使得缓存空间得到充分利用。

接下来,我们将探讨LFU的原理。LFU算法通过维护一个数据结构,记录每个数据项的访问频率。当缓存空间不足时,算法会从访问频率最低的数据中淘汰一个,直到缓存空间满足需求。这种策略能够确保缓存中保留的是用户最常访问的数据,从而提高系统的响应速度和用户体验。

在本文的后续内容中,我们将分别对LFU的概念和原理进行详细讲解,帮助读者全面了解这一缓存淘汰策略。通过学习LFU,读者可以更好地优化缓存策略,提高系统性能,为实际应用提供有力支持。

# 🌟 LFU算法原理

# 🌟 LFU(Least Frequently Used)算法是一种缓存淘汰算法,它根据数据访问的频率来淘汰缓存中的数据。

# 🌟 该算法的核心思想是:如果一个数据在一段时间内被访问的次数最少,那么它被淘汰的可能性就最大。

# 🌟 LFU缓存淘汰机制

# 🌟 当缓存达到最大容量时,LFU算法会淘汰访问次数最少的缓存项。如果存在多个访问次数相同的缓存项,则按照时间顺序淘汰。

# 🌟 LFU与LRU、LFU与FIFO对比

# 🌟 LRU(Least Recently Used)算法淘汰最近最少使用的数据,而LFU算法淘汰访问次数最少的数据。

# 🌟 与LRU相比,LFU算法更加公平,因为它不会因为数据被连续访问而无法被淘汰。

# 🌟 与FIFO(First In First Out)算法相比,LFU算法更加智能,因为它会淘汰访问次数最少的数据,而不是最早进入缓存的数据。

# 🌟 LFU适用场景

# 🌟 LFU算法适用于缓存数据访问频率不均匀的场景,例如日志数据、缓存热点数据等。

# 🌟 LFU算法实现

# 🌟 下面是一个简单的LFU算法实现示例:

class LFUCache:

def __init__(self, capacity: int):

self.capacity = capacity

self.cache = {}

self.freq = {}

self.min_freq = 0

def get(self, key: int) -> int:

if key not in self.cache:

return -1

value, freq = self.cache[key]

self.freq[key] = freq + 1

self.min_freq = min(self.min_freq, freq)

return value

def put(self, key: int, value: int) -> None:

if self.capacity <= 0:

return

if key in self.cache:

self.cache[key] = (value, self.freq[key] + 1)

self.freq[key] += 1

self.min_freq = min(self.min_freq, self.freq[key])

else:

if len(self.cache) >= self.capacity:

# 淘汰访问次数最少的缓存项

del_key = min(self.freq, key=self.freq.get)

del self.cache[del_key]

del self.freq[del_key]

self.cache[key] = (value, 1)

self.freq[key] = 1

self.min_freq = 1

# 🌟 LFU性能分析

# 🌟 LFU算法的性能取决于数据访问模式。在数据访问频率不均匀的场景下,LFU算法可以有效地淘汰访问次数最少的数据,从而提高缓存命中率。

# 🌟 LFU优化策略

# 🌟 为了提高LFU算法的性能,可以采取以下优化策略:

# 🌟 1. 使用哈希表来存储缓存项和访问频率,以提高查找和更新操作的效率。

# 🌟 2. 使用有序列表来存储具有相同访问频率的缓存项,以便快速淘汰访问次数最少的缓存项。

# 🌟 3. 根据实际应用场景调整缓存容量和最小访问频率阈值。

以上代码展示了LFU算法的基本原理和实现方法。在实际应用中,可以根据具体需求对LFU算法进行优化和调整。

| 算法名称 | 核心思想 | 淘汰机制 | 与其他算法对比 | 适用场景 | 性能分析 | 优化策略 |

|---|---|---|---|---|---|---|

| LFU | 根据数据访问频率淘汰缓存 | 淘汰访问次数最少的缓存项,若访问次数相同则按时间顺序淘汰 | 与LRU相比,更加公平,不会因连续访问而无法淘汰;与FIFO相比,更智能,淘汰访问次数最少的数据 | 缓存数据访问频率不均匀的场景,如日志数据、缓存热点数据等 | 在数据访问频率不均匀的场景下,可以有效淘汰访问次数最少的数据,提高缓存命中率 | 1. 使用哈希表存储缓存项和访问频率,提高查找和更新效率;2. 使用有序列表存储相同访问频率的缓存项,快速淘汰访问次数最少的数据;3. 根据实际应用场景调整缓存容量和最小访问频率阈值 |

LFU算法在缓存淘汰策略上具有独特的优势,它不仅考虑了数据的访问频率,还兼顾了时间因素。相较于LRU算法,LFU算法在处理数据访问频率不均匀的场景时,能够更加公平地淘汰缓存项,避免了因连续访问而无法淘汰的问题。同时,与FIFO算法相比,LFU算法更加智能,能够淘汰访问次数最少的数据,从而提高缓存命中率。在优化策略方面,通过使用哈希表和有序列表相结合的方式,可以有效地提高查找和更新效率,同时根据实际应用场景调整缓存容量和最小访问频率阈值,进一步提升算法的性能。

# 🌟 LFU算法定义

"""

LFU(Least Frequently Used)算法,即最少使用算法,是一种缓存淘汰算法。它根据数据在一段时间内的使用频率来淘汰数据,频率越低的数据越容易被淘汰。

"""

# 🌟 LFU算法原理

"""

LFU算法的核心思想是:如果一个数据在最近一段时间内使用频率最低,那么它将来被使用的概率也会很低,因此可以优先淘汰。

具体实现时,通常使用一个哈希表来存储数据,哈希表的键是数据,值是一个包含两个元素的元组,第一个元素是数据的使用次数,第二个元素是数据本身。

"""

# 🌟 LFU算法特点

"""

1. 算法简单,易于实现。

2. 能够有效淘汰长时间未被使用的冷数据。

3. 缺点是在数据量较大时,维护数据使用频率的哈希表可能会消耗较多内存。

"""

# 🌟 LFU算法应用场景

"""

1. 缓存系统:如Redis等。

2. 数据库索引:淘汰长时间未被查询的索引。

3. 文件系统:淘汰长时间未被访问的文件。

"""

# 🌟 LFU算法与LRU算法对比

"""

LRU(Least Recently Used)算法与LFU算法类似,都是根据数据的使用频率来淘汰数据。但LRU算法只考虑数据的使用时间,而LFU算法同时考虑数据的使用次数和时间。

LRU算法适用于数据访问模式较为均匀的场景,而LFU算法适用于数据访问模式不均匀的场景。

"""

# 🌟 LFU算法实现细节

"""

1. 使用哈希表存储数据,键是数据,值是一个包含两个元素的元组,第一个元素是数据的使用次数,第二个元素是数据本身。

2. 每次访问数据时,更新数据的使用次数。

3. 当需要淘汰数据时,遍历哈希表,找到使用次数最低的数据进行淘汰。

"""

# 🌟 LFU算法优化策略

"""

1. 使用双向链表来存储哈希表的键,以便快速删除和插入数据。

2. 使用优先队列来存储使用次数最低的数据,以便快速找到需要淘汰的数据。

"""

# 🌟 LFU算法在Redis中的应用

"""

Redis使用LFU算法作为其缓存淘汰算法。Redis的LFU算法实现较为复杂,它使用了一个额外的数据结构来存储使用次数最低的数据。

"""

# 🌟 LFU算法的性能分析

"""

LFU算法的性能取决于数据的使用模式和缓存大小。在数据访问模式较为均匀的场景下,LFU算法的性能较好。但在数据访问模式不均匀的场景下,LFU算法的性能可能会较差。

"""

| 特征/算法 | LFU算法 | LRU算法 |

|---|---|---|

| 核心思想 | 根据数据的使用频率和次数来淘汰数据,频率越低的数据越容易被淘汰。 | 根据数据的使用时间来淘汰数据,最近最少被使用的数据将被淘汰。 |

| 数据结构 | 使用哈希表存储数据,哈希表的键是数据,值是一个包含两个元素的元组,第一个元素是数据的使用次数,第二个元素是数据本身。 | 使用哈希表存储数据,哈希表的键是数据,值是数据本身。 |

| 更新机制 | 每次访问数据时,更新数据的使用次数。 | 每次访问数据时,不更新数据的使用次数,但会将其移动到哈希表的头部。 |

| 淘汰机制 | 遍历哈希表,找到使用次数最低的数据进行淘汰。 | 遍历哈希表,找到最近最少被使用的数据进行淘汰。 |

| 适用场景 | 数据访问模式不均匀的场景,如缓存系统、数据库索引、文件系统等。 | 数据访问模式较为均匀的场景,如缓存系统、数据库查询缓存等。 |

| 优缺点 | 优点:能够有效淘汰长时间未被使用的冷数据。缺点:在数据量较大时,维护数据使用频率的哈希表可能会消耗较多内存。 | 优点:实现简单,易于理解。缺点:在数据访问模式不均匀的场景下,可能无法有效淘汰冷数据。 |

| 优化策略 | 使用双向链表来存储哈希表的键,以便快速删除和插入数据。使用优先队列来存储使用次数最低的数据,以便快速找到需要淘汰的数据。 | 使用双向链表来存储哈希表的键,以便快速删除和插入数据。 |

| 应用实例 | 缓存系统(如Redis)、数据库索引、文件系统等。 | 缓存系统、数据库查询缓存等。 |

| 性能分析 | 性能取决于数据的使用模式和缓存大小。在数据访问模式较为均匀的场景下,性能较好。但在数据访问模式不均匀的场景下,性能可能会较差。 | 性能取决于数据的使用模式和缓存大小。在数据访问模式较为均匀的场景下,性能较好。但在数据访问模式不均匀的场景下,性能可能会较差。 |

LFU算法在处理数据访问模式不均匀的场景时,能够更有效地识别并淘汰那些长时间未被访问的数据,这对于缓存系统来说尤为重要,因为它可以帮助系统保持较高的命中率,减少对后端存储的访问压力。然而,LFU算法在数据量较大时,维护数据使用频率的哈希表可能会消耗较多内存资源,因此在设计系统时需要权衡内存使用和算法效率之间的关系。

🍊 Redis知识点之LFU:特点与优势

在当今大数据时代,缓存技术已成为提高系统性能的关键。Redis作为一款高性能的内存数据库,其内部缓存淘汰策略对于保证数据的热度和系统的稳定性至关重要。其中,LFU(Least Frequently Used)缓存淘汰策略因其独特的特点与优势,在Redis中扮演着重要角色。

想象一下,在一个电商平台上,用户频繁访问的商品数据需要被缓存以提供快速响应。然而,随着时间的推移,一些用户访问频率较低的商品数据可能会占用过多的缓存空间,影响热门商品的访问速度。这时,LFU缓存淘汰策略就能发挥作用,它通过记录每个键的访问频率,优先淘汰访问频率最低的数据,从而确保热门数据始终被保留在缓存中。

介绍LFU缓存淘汰策略的重要性在于,它能够有效平衡缓存空间的使用,避免因缓存数据过多而导致的性能下降。在Redis中,LFU策略具有以下特点:

- 基于访问频率进行数据淘汰,能够更准确地反映数据的实际使用情况。

- 对新数据的缓存效果较好,因为新数据通常具有较高的访问频率。

- 对热门数据的保护作用明显,能够确保热门数据始终被保留。

接下来,我们将深入探讨LFU缓存淘汰策略的优势。首先,LFU策略能够有效减少缓存空间浪费,提高缓存利用率。其次,它能够降低缓存淘汰对系统性能的影响,因为淘汰的数据往往是访问频率较低的数据,对系统的影响较小。最后,LFU策略能够适应数据访问模式的变化,提高系统的动态适应性。

在接下来的内容中,我们将详细阐述LFU缓存淘汰策略的特点和优势,帮助读者更好地理解其在Redis中的应用和重要性。

# 🌟 LFU算法原理

# 🌟 LFU(Least Frequently Used)算法是一种缓存淘汰算法,它根据键值对的使用频率来决定淘汰哪些数据。

# 🌟 该算法的核心思想是:如果一个键值对被访问的次数最少,那么它最有可能不再被访问,因此应该优先被淘汰。

# 🌟 LFU缓存淘汰机制

# 🌟 当缓存达到最大容量时,LFU算法会淘汰使用频率最低的键值对。具体操作如下:

# 🌟 1. 遍历缓存中的所有键值对,统计每个键值对的使用频率。

# 🌟 2. 找到使用频率最低的键值对,将其淘汰。

# 🌟 LFU与LRU、LFU与FIFO对比

# 🌟 LRU(Least Recently Used)算法淘汰最近最少使用的键值对,而LFU算法淘汰使用频率最低的键值对。

# 🌟 与LRU相比,LFU算法更加公平,因为它不会因为数据被连续访问而一直留在缓存中。

# 🌟 与FIFO(First In First Out)算法相比,LFU算法更加智能,因为它会淘汰使用频率最低的数据,而不是最早进入缓存的数据。

# 🌟 LFU适用场景

# 🌟 LFU算法适用于以下场景:

# 🌟 1. 数据访问具有明显的冷热分布,即某些数据经常被访问,而其他数据很少被访问。

# 🌟 2. 数据访问频率变化较大,某些数据可能会突然变得非常热门。

# 🌟 LFU性能分析

# 🌟 LFU算法的性能取决于数据访问模式和缓存大小。在数据访问模式适合LFU算法的场景下,它可以有效地减少缓存淘汰次数,提高缓存命中率。

# 🌟 LFU算法优化策略

# 🌟 为了提高LFU算法的性能,可以采取以下优化策略:

# 🌟 1. 使用高效的数据结构来存储键值对和频率信息,例如哈希表和平衡树。

# 🌟 2. 定期清理缓存,释放不再需要的键值对。

# 🌟 LFU在Redis中的应用实例

# 🌟 在Redis中,可以使用LFU算法来实现缓存功能。具体操作如下:

# 🌟 1. 使用Redis的sorted set数据结构来存储键值对和频率信息。

# 🌟 2. 当缓存达到最大容量时,使用LFU算法淘汰使用频率最低的键值对。

# 🌟 3. 更新键值对的频率信息。

| 对比项 | LFU算法 | LRU算法 | FIFO算法 |

|---|---|---|---|

| 核心思想 | 根据键值对的使用频率决定淘汰数据 | 根据键值对的最近使用时间决定淘汰数据 | 根据键值对的进入缓存顺序决定淘汰数据 |

| 淘汰机制 | 淘汰使用频率最低的键值对 | 淘汰最近最少使用的键值对 | 淘汰最早进入缓存的数据 |

| 公平性 | 相对公平,不会因为数据连续访问而留在缓存 | 可能不公平,连续访问的数据可能不会被淘汰 | 公平,但可能淘汰掉有潜在访问需求的数据 |

| 智能性 | 智能淘汰使用频率低的数据 | 智能淘汰最近最少使用的数据 | 没有智能淘汰机制,仅按顺序淘汰 |

| 适用场景 | 数据访问具有明显的冷热分布,频率变化大 | 数据访问具有明显的冷热分布 | 数据访问顺序固定,无冷热分布 |

| 性能分析 | 适合数据访问模式适合的场景,减少淘汰次数 | 适合数据访问模式适合的场景,提高缓存命中率 | 性能取决于数据访问顺序,可能不高效 |

| 优化策略 | 使用高效数据结构存储键值对和频率信息 | 使用高效数据结构存储键值对和访问时间信息 | 无需特别优化 |

| 应用实例 | Redis中使用sorted set存储键值对和频率信息 | Redis中使用LRUCache实现 | 无需特别实现 |

LFU算法通过记录键值对的使用频率来决定淘汰数据,这种机制使得算法能够智能地淘汰那些使用频率较低的数据,从而在数据访问模式具有明显冷热分布且频率变化大的场景中表现出色。例如,在电商平台的商品推荐系统中,LFU算法可以有效地淘汰那些长时间未被用户访问的商品,从而提高推荐系统的准确性和效率。

Redis知识点之LFU:优势

在Redis中,LFU(Least Frequently Used)是一种内存淘汰策略,它通过记录键值对的使用频率来决定哪些数据应该被淘汰。以下是LFU的优势:

-

数据访问频率统计:LFU能够准确统计每个键值对的使用频率,这对于理解数据的热度和访问模式非常有帮助。通过这种方式,Redis可以更好地优化内存使用,确保频繁访问的数据始终留在内存中。

-

内存淘汰策略:在内存不足的情况下,LFU会淘汰使用频率最低的数据,从而保证内存中保留的是最可能被再次访问的数据。这种策略有助于提高缓存命中率,减少内存的浪费。

Redis LFU缓存策略详解

Redis LFU缓存策略详解

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1712

1712

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?