本文深度剖析了AI大模型产业链的技术垄断现象。NVIDIA凭借Tensor Core硬件优势和15年CUDA生态护城河占据92%市场份额;OpenAI年亏50亿美元仍需疯狂投入训练;Oracle以低毛利率提供算力租赁服务,实则长期绑定客户。

2023年,ChatGPT的爆火让全世界陷入AI狂欢。硅谷的创业者们振臂高呼:技术民主化来了,人人都能训练大模型,AI将像水电一样普及。

但现实用两年时间给出了答案:OpenAI年亏50亿美元仍在疯狂烧钱,NVIDIA市值破3万亿成为躺赢赢家,AMD高喊"挑战者"口号却只拿下不到5%的市场,Oracle的AI云服务毛利率低至14%还要硬着头皮做下去。

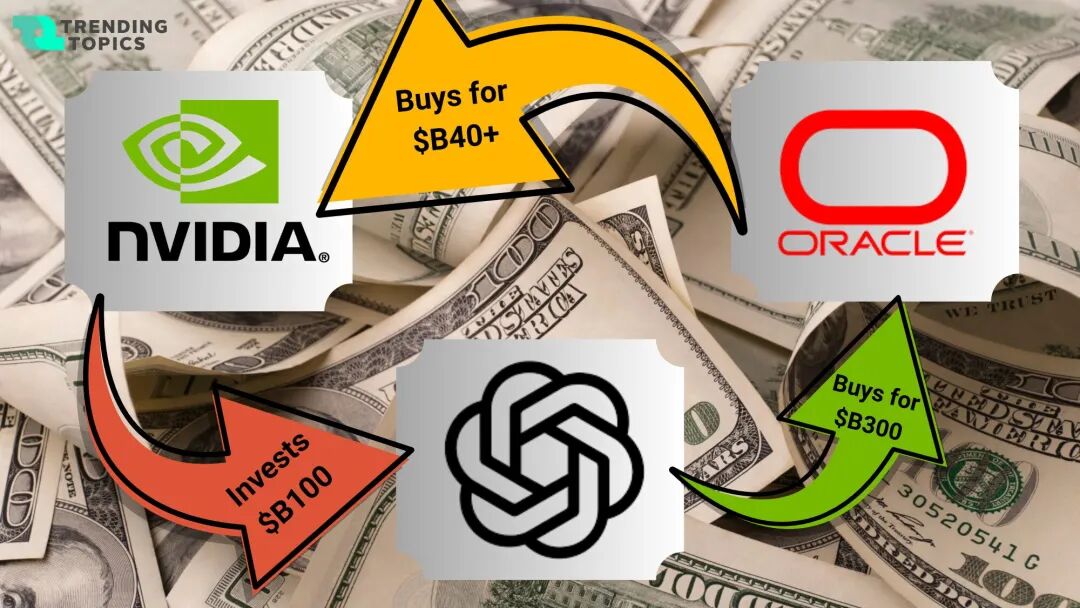

这场AI革命的真相,不是技术突破让竞争更公平,而是技术垄断通过四层架构完成了自我强化。从芯片到云服务,一个看似松散、实则精密的资本闭环正在形成。让我们从技术原理的角度,彻底拆解OpenAI-NVIDIA-AMD-Oracle这个利益共同体。

一、NVIDIA vs AMD

我们来看看2024年AI芯片市场数据:NVIDIA市占率:92%,AMD市占率:4%,其他(Google TPU等):4%。

AMD的MI300X在硬件规格上已经接近H100,为什么市场份额依然可怜?

******第一层壁垒:硬件架构的代际差距

什么是Tensor Core?为什么它让NVIDIA领先两代?

AI训练的核心是矩阵乘法运算(GEMM - General Matrix Multiply)。一个简单的Transformer模型,90%的计算时间都花在矩阵乘法上。

传统GPU核心(CUDA Core)执行矩阵乘法的方式:

# 传统方式:逐元素计算

def matrix_multiply_slow(A, B):

# A: [M, K] B: [K, N] 结果: [M, N]

C = zeros(M, N)

for i in range(M):

for j in range(N):

for k in range(K):

C[i,j] += A[i,k] * B[k,j] # 每次只算一个乘加

return C

# 复杂度:O(M*N*K) 次操作

# 对于1024x1024矩阵:需要10亿次操作

Tensor Core的突破:硬件级矩阵加速

Tensor Core不是逐元素计算,而是一次性计算一个小矩阵块(通常4x4或8x8)。这就像:传统方式用筷子一粒粒夹米饭,Tensor Core用勺子一口吃一大勺。

# Tensor Core工作原理(伪代码)

class TensorCore:

def matrix_block_multiply(self, A_block, B_block):

# 一个时钟周期内完成4x4矩阵乘法

# 输入:A[4,4] B[4,4]

# 输出:C[4,4] = A @ B

return hardware_accelerated_gemm(A_block, B_block)

# 性能提升:

# CUDA Core: 1024x1024矩阵乘法 ≈ 0.5ms

# Tensor Core: 1024x1024矩阵乘法 ≈ 0.01ms

# 加速比:50x

H100的恐怖性能:理论算力3958 TFLOPS (FP8精度),实际含义每秒3958万亿次浮点运算。而AMD MI300X理论算力5300 TFLOPS,但实际应用中性能只有H100的60-70%。

第二层壁垒:CUDA软件生态的15年护城河

CUDA不是编程语言,而是一个完整的开发生态

大多数人认为GPU芯片才是核心,CUDA只是编程工具。但现实恰恰相反:CUDA才是NVIDIA真正的护城河。NVIDIA从2007年开始布局CUDA,至今已经17年。这17年里,它构建了一个从底层驱动到上层框架的完整技术栈。

应用层:PyTorch / TensorFlow / JAX

↓

框架层:cuDNN (深度学习算子库)

↓

库层:cuBLAS (线性代数) / cuSPARSE (稀疏计算) / NCCL (多卡通信)

↓

编程层:CUDA C/C++ / Python API

↓

驱动层:NVIDIA GPU Driver

↓

硬件层:Tensor Core / NVLink / HBM

让我们看一个真实的代码对比。

使用CUDA的PyTorch代码(标准写法):

import torch

# 在H100上训练一个Transformer层

x = torch.randn(32, 1024, 4096).cuda() # batch=32, seq=1024, dim=4096

attention = torch.nn.MultiheadAttention(4096, 32).cuda()

# 前向传播

with torch.cuda.amp.autocast(): # 自动混合精度(FP16/FP8)

output, weights = attention(x, x, x)

# 训练时间:~2ms

如果要迁移到AMD ROCm:

import torch

# 理论上只需要改.cuda()为.hip()

x = torch.randn(32, 1024, 4096).hip() # ❌ 语法正确,但...

attention = torch.nn.MultiheadAttention(4096, 32).hip()

# 实际问题:

# 1. autocast不支持MI300X的FP8模式

# 2. Flash Attention算法没有ROCm优化版本

# 3. NCCL的AMD版本(RCCL)在8卡通信时慢30%

# 4. 训练时间:~5ms(慢2.5倍)

工程师需要重写的代码量:约40%的底层算子。******

二、OpenAI & Oracle

如果说NVIDIA-AMD的竞争是"芯片战争",那么OpenAI-Oracle的关系则揭示了一个更残酷的技术真相:在AI产业链中,技术越先进、规模越大,反而受制于底层架构越深。

OpenAI的算力黑洞:为什么年亏50亿还停不下来?

1. 大模型训练成本:一个GPT-4要烧多少钱?

让我们从技术原理算一笔账。训练GPT-4级别模型的基本参数:

- 模型参数量:约1.76万亿(1.76T)

- 训练数据量:约13万亿token

- 所需GPU:约25,000张A100(或10,000张H100)

- 训练时长:约100天

那什么是Token呢?Token是大模型处理文本的基本单位。不是"一个字=一个token",而是根据统计规律切分。

# Token化示例

文本:你好世界Hello World

Token化后:['你好', '世界', 'Hello', ' World']

Token数量:4个

# 中文平均:1.5-2个汉字 = 1个token

# 英文平均:0.75个单词 = 1个token

# "一文搞懂大模型" ≈ 5个token

训练成本计算如下:

单卡算力消耗:

H100功率:700W

训练100天 = 2400小时

单卡耗电:700W × 2400h = 1,680 kWh

10,000张H100总耗电:

1,680 × 10,000 = 16,800,000 kWh = 1,680万度电

美国数据中心电价:$0.07/kWh

电费成本:1,680万 × $0.07 = $117.6万

GPU租赁成本(主要成本):

H100云端租赁:$2-3/小时/卡

10,000卡 × 2400小时 × $2.5 = $6,000万

总训练成本:约6,100万美元

总训练成本约6,100万美元,但这只是一次训练!

OpenAI实际成本远超这个数字,因为:

- 实验失败率:成功训练一个GPT-4,需要尝试30-50个版本

- 持续迭代:GPT-4.5、GPT-5同时在训练

- 安全对齐:RLHF(人类反馈强化学习)需要额外10-20%算力

- 推理成本:OpenAI每年推理要花多少钱?

让我们从技术原理算一笔账,ChatGPT的基本运营数据。

- 日活用户:约2亿(2024年数据)

- 平均每人每天对话:5次

- 每次对话平均生成:600 token

- 所需GPU:约30,000张H100(推理集群)

什么是推理?和训练有什么区别?

训练:教AI学会说话(一次性投入)

喂给模型13万亿token数据

需要100天 × 10,000张GPU

成本:$6,100万(一次性)

推理:AI每次回答你的问题(持续消耗)

每次对话都要计算

需要24小时 × 30,000张GPU在线

成本:每天都在烧钱

真实年度成本估算如下:一年总计约50亿美元。

基础训练:$6,100万 × 40次迭代 = $24.4亿

推理服务(用户使用):$15亿/年

研发测试:$8亿/年

数据采购与标注:$2.6亿/年

————————————————————————

总计:约$50亿/年

为什么OpenAI需要Oracle?数据中心困境:AI巨头的算力难题

1. 自建数据中心:40亿美元的豪赌

(1)时间成本:2年才能开机

10万卡H100集群建设周期:

0-6个月: GPU排队(NVIDIA产能有限)

6-15个月: 土地审批 + 土建施工 + 电力扩容

15-20个月:机电安装 + 设备部署

20-24个月:调试 + 测试

总计:24个月

现实:Meta的数据中心从立项到投产耗时28个月。竞争对手不会等你2年。

(2)资金成本:前期投入$40亿

【硬件】$30亿

- GPU:10万卡 × $25,000 = $25亿

- 服务器 + 网络:$5亿

【基建】$10亿

- 土地 + 厂房:$2亿

- 电力系统:$4亿(需要300MW,相当于小型发电厂)

- 冷却系统:$3亿(10万卡功耗30MW)

- 消防 + 安防:$1亿

【运维】每年$3,000万

- 300人专业团队

(3)隐形杀手:年度电费$6,867万

功耗计算:

- GPU:10万卡 × 700W = 70MW

- 冷却:28MW(散热功耗占40%)

- 总计:98MW

年耗电:858,480 MWh

电费($0.08/kWh):$6,867万/年

如果在加州($0.15/kWh):$1.29亿/年

这就是为什么:微软建在水电站旁,谷歌去芬兰蹭冬季冷却,Meta考虑核电。

- Oracle的"即插即用"方案

核心价值:固定成本变可变成本

自建模式:

前期$40亿 → 摊销3年 → 每年固定$13.3亿

(用不用满都得付)

OCI租用:

- 训练期:10,000卡 × $2.5/时 × 720时/月 = $1,800万/月

- 推理期:3,000卡 × $2.5/时 × 720时/月 = $540万/月

GPT-5项目(4个月训练 + 8个月推理):

总成本 = 4×$1,800万 + 8×$540万 = $1.152亿

vs 自建第一年:亏损$40亿

关键差异:如果模型失败,损失从$40亿降到$1亿。

- Oracle为什么"赔本赚吆喝"?

(1)表面:毛利率只有14%

OCI定价:$2.5/小时/卡

Oracle实际成本:

- GPU摊销:$1.20/时(长期采购折扣)

- 电费冷却:$0.40/时

- 网络存储:$0.30/时

- 运维人力:$0.20/时

- 机房折旧:$0.05/时

————————————

总计:$2.15/时

毛利:$0.35/时(14%)

对比AWS EC2:28%毛利率

(2)真相:玩的是长期锁定

客户迁移成本:

OpenAI在OCI上的沉没成本:

- 数据迁移:100PB × $50/TB = $500万

- 环境重建:$200万 + 2个月工程时间

- 业务中断:3个月

总成本:$700万 + 5个月

→ 换云厂商比续约更贵

客户终身价值:

OpenAI年度支出估算:

- GPT训练:$7,200万

- 推理服务:$5,184万

- 实验项目:$3,000万

- 存储CDN:$6,000万

————————————

年度:$2.14亿

5年合同:$10.7亿

Oracle净利润(8%净利率):$8,560万

(3)战略卡位:AI算力专卖店

云计算格局(2024):

AWS 32% → 通用计算,GPU优先给Amazon自家

Azure 23% → 企业市场,GPU优先给Microsoft Copilot

Google 11% → 大数据,GPU优先给Gemini

Oracle 2% → 没有AI产品,100% GPU对外出租

Oracle突围逻辑:

放弃通用计算 → 全押AI算力 → 专攻OpenAI/Anthropic等训练大模型的公司

当我们拆解完这个产业链的每一层,会发现一个残酷的事实:所谓的AI革命,本质上是一场资本密集型的技术军备竞赛。

垄断者的完美闭环:

- NVIDIA:控制算力入口,92%市占率让它成为"AI税收者",每一次算力升级都能收割全行业

- AMD:看似挑战者,实则是NVIDIA的"价格调节器",永远慢半拍的生态让它只能吃残羹冷炙

- Oracle:14%的毛利率不是慈善,而是用短期亏损换长期绑定,把OpenAI等客户变成"终身用户"

- OpenAI:年亏50亿还要继续融资,因为停下来就意味着2年内被追上,前期投入全部打水漂

所谓的AI民主化,或许从一开始就是一个美丽的谎言。当入场费涨到50亿美元时,这场革命已经不属于普通玩家。

我们如何系统学习掌握AI大模型?

AI大模型作为人工智能领域的重要技术突破,正成为推动各行各业创新和转型的关键力量。抓住AI大模型的风口,掌握AI大模型的知识和技能将变得越来越重要。

学习AI大模型是一个系统的过程,需要从基础开始,逐步深入到更高级的技术。

这里给大家精心整理了一份

全面的AI大模型学习资源,包括:AI大模型全套学习路线图(从入门到实战)、精品AI大模型学习书籍手册、视频教程、实战学习、面试题等,资料免费分享!

1. 成长路线图&学习规划

要学习一门新的技术,作为新手一定要先学习成长路线图,方向不对,努力白费。

这里,我们为新手和想要进一步提升的专业人士准备了一份详细的学习成长路线图和规划。可以说是最科学最系统的学习成长路线。

2. 大模型经典PDF书籍

书籍和学习文档资料是学习大模型过程中必不可少的,我们精选了一系列深入探讨大模型技术的书籍和学习文档,它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。(书籍含电子版PDF)

3. 大模型视频教程

对于很多自学或者没有基础的同学来说,书籍这些纯文字类的学习教材会觉得比较晦涩难以理解,因此,我们提供了丰富的大模型视频教程,以动态、形象的方式展示技术概念,帮助你更快、更轻松地掌握核心知识。

4. 大模型行业报告

行业分析主要包括对不同行业的现状、趋势、问题、机会等进行系统地调研和评估,以了解哪些行业更适合引入大模型的技术和应用,以及在哪些方面可以发挥大模型的优势。

5. 大模型项目实战

学以致用 ,当你的理论知识积累到一定程度,就需要通过项目实战,在实际操作中检验和巩固你所学到的知识,同时为你找工作和职业发展打下坚实的基础。

6. 大模型面试题

面试不仅是技术的较量,更需要充分的准备。

在你已经掌握了大模型技术之后,就需要开始准备面试,我们将提供精心整理的大模型面试题库,涵盖当前面试中可能遇到的各种技术问题,让你在面试中游刃有余。

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以

微信扫描下方优快云官方认证二维码,免费领取【保证100%免费】

743

743

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?