点击下方卡片,关注“自动驾驶之心”公众号

>>自动驾驶前沿信息获取→自动驾驶之心知识星球

这两年AI吸引着全世界的眼光,而英伟达无疑是所有目光中的焦点。这家为AI时代提供基础设施的科技巨头,在10月底成为人类历史上第一家5万亿美元市值的公司,比三年前翻了11倍。

成立于93年的英伟达,已经完成了从图形芯片到AI巨头的演进之路。三十多年的发展过程中有几个关键的节点:1999年推出GeForce 256,2006年CUDA问世,2012年支持AlexNet,2020年开始发布高端计算GPU,21年开始发布端侧芯片(ORIN/Thor)。

毫无疑问,英伟达是AI基础设施的第一巨头。但在这背后,英伟达的野心不只局限于做一下硬件公司。一个非常明显的信号是,今年英伟达在自动驾驶、具身智能、大模型和世界模型几个最热的AI赛道上产出了多篇重量级工作,引起了业内的广泛讨论。今天自动驾驶之心就带大家盘点一下2025年英伟达的技术图鉴,主要有以下几个系列:

Cosmos系列:从今年一月份开始布局的世界基础模型平台,衍生出Cosmos-Transfer1、Cosmos-Reason1、Cosmos-Predict2.5等工作,为下游自动驾驶和具身智能奠定基座;

Nemotron系列:Nemotron 系列是英伟达为代理式 AI 时代打造的 "数字大脑",通过提供开放、高效、精准的模型和工具,让企业能够快速构建专业 AI 智能体;

具身系列:GR00T N1和Isaac Lab,一手具身VLA,一手仿真平台,英伟达在正在深入布局具身智能;

自动驾驶:十一月的Alpamayo-R1直接炸翻了自驾行业,难得的英伟达在自驾VLA上的尝试。

今天盘点的主要是英伟达主导的工作,并未涉及英伟达参与的其他工作。更多关于英伟达的技术解析、发展趋势和行业讨论,欢迎加入『自动驾驶之心星球』!我们准备了大额优惠券,仅限前5名......

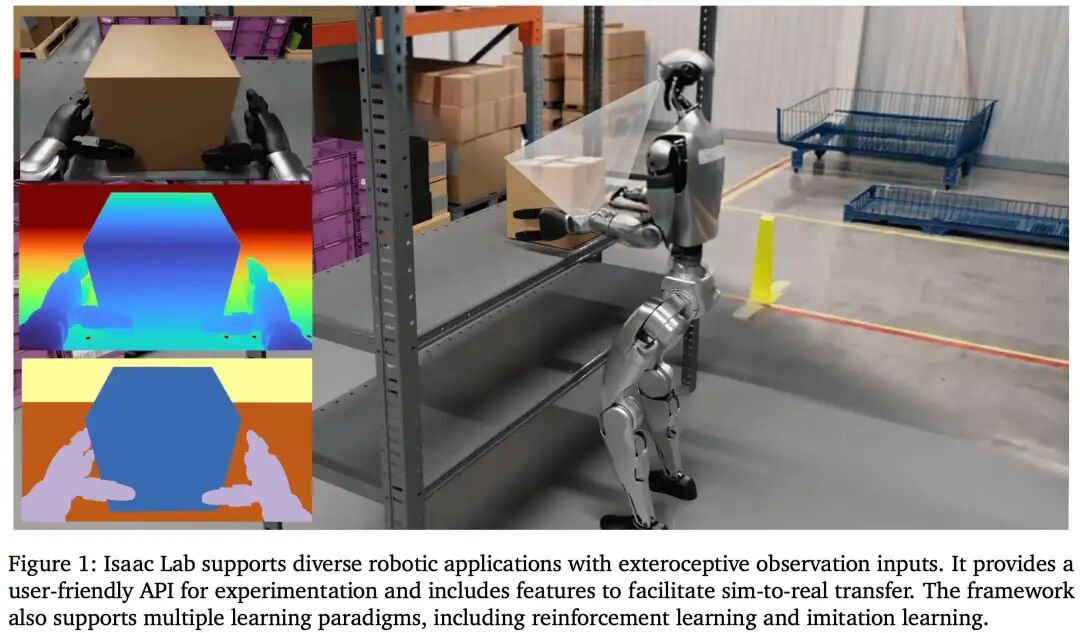

Isaac Lab

论文标题:Isaac Lab: A GPU-Accelerated Simulation Framework for Multi-Modal Robot Learning

论文链接:https://arxiv.org/abs/2511.04831

项目主页:https://github.com/isaac-sim/IsaacLab

提出机构:NVIDIA

一句话总结:Isaac Lab 构建了一个集高保真物理、照片级渲染与模块化环境设计于一体的GPU原生仿真平台,通过统一传感器仿真、数据收集与策略训练工作流,旨在系统性解决机器人学习中的数据稀缺、仿真到现实鸿沟及大规模多模态策略训练等核心挑战。

核心贡献:

提出了一个统一且可扩展的仿真范式,将GPU并行物理(PhysX)、实时射线追踪渲染(RTX)与通用场景描述(USD)深度集成,实现了从简单控制到复杂多模态任务的大规模、高效率仿真训练。

设计了全面的多模态传感器仿真套件,涵盖基于物理的传感器(IMU、接触)、基于渲染的相机(RGB、深度、语义)以及基于Warp的几何传感器(射线雷达),并支持异步更新与域随机化,为感知策略提供了逼真且多样化的训练数据。

实现了从数据生成到策略部署的端到端学习工作流支持,内置了强化学习、模仿学习、教师-学生蒸馏以及合成数据生成(Mimic)等多种学习范式,并提供了海量的标准机器人环境,极大降低了复杂机器人算法研究的工程门槛。

通过模块化的“管理器”架构与底层Tensor API,在保持高性能GPU原生计算的同时,为研究者提供了从底层物理状态直接操作到高层任务抽象管理的灵活控制,平衡了效率与易用性,成为推动机器人学习研究的基础设施。

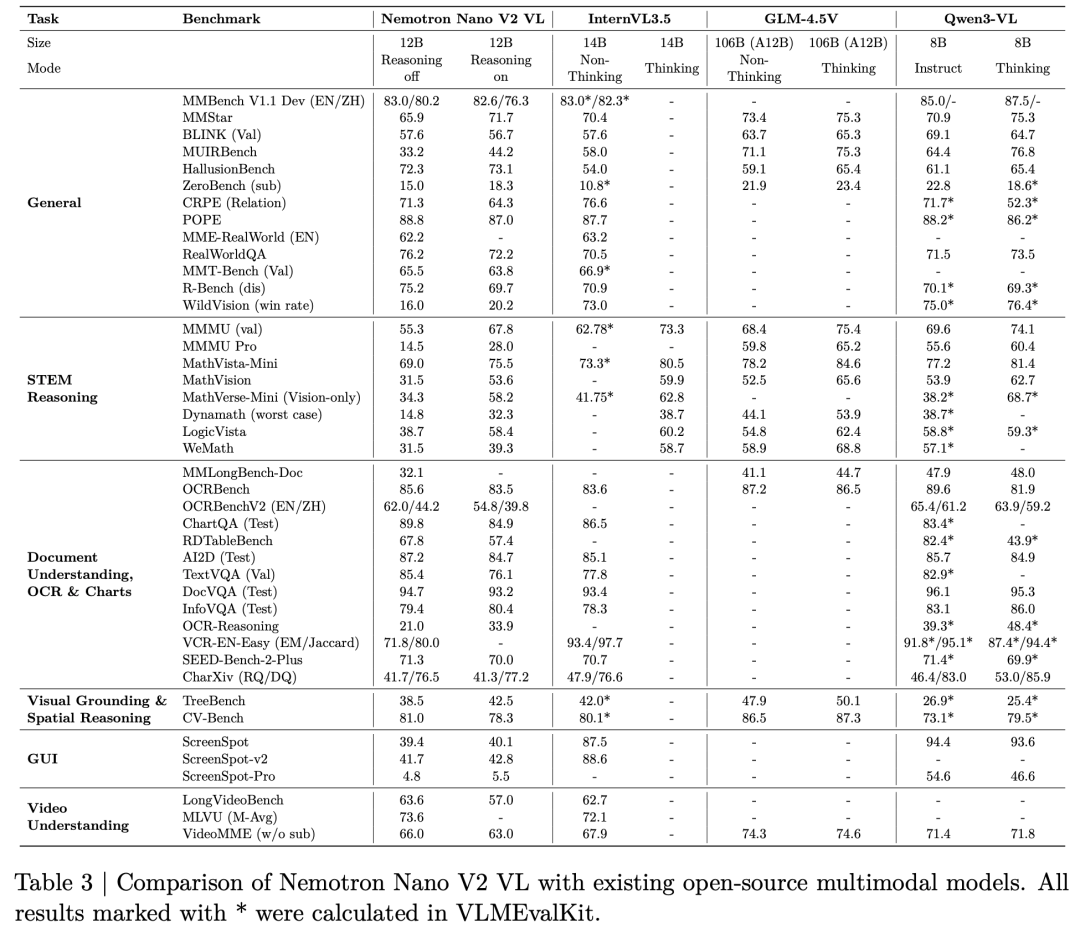

NVIDIA Nemotron Nano V2 VL

论文标题:NVIDIA Nemotron Nano V2 VL

论文链接:https://arxiv.org/abs/2511.03929

提出机构:NVIDIA

一句话总结:NVIDIA发布了Nemotron Nano V2 VL,这是一个高效的12B视觉语言模型,通过混合Mamba-Transformer架构、多阶段训练策略和高效推理优化,在文档理解、长视频推理等多模态任务中实现了SOTA性能,同时保持了文本推理能力。

核心贡献:

高效混合架构与长上下文支持:基于Nemotron Nano V2混合Mamba-Transformer大语言模型,将上下文长度从16K扩展至128K,支持长视频、多页文档等复杂场景理解。

多阶段渐进式训练策略:采用五阶段训练流程,逐步融合视觉对齐、多模态理解、长上下文扩展与文本能力恢复,在提升视觉理解的同时最小化对文本推理能力的损失。

高效推理与量化部署:集成Efficient Video Sampling技术,显著提升视频处理吞吐量;支持FP8与FP4量化,提供高推理效率的部署版本,适用于资源受限环境。

全面且领先的评估表现:在OCRBench v2、MMMU、ChartQA、Video-MME等45个多模态基准测试中表现优异,尤其在文档理解、长视频问答、STEM推理等任务上达到或超越同类开源模型。

开源数据集与工具链:公开发布包含超过800万样本的Nemotron VLM Dataset V2,以及NVPDFTex等标注工具,推动视觉语言模型研究与生态发展。

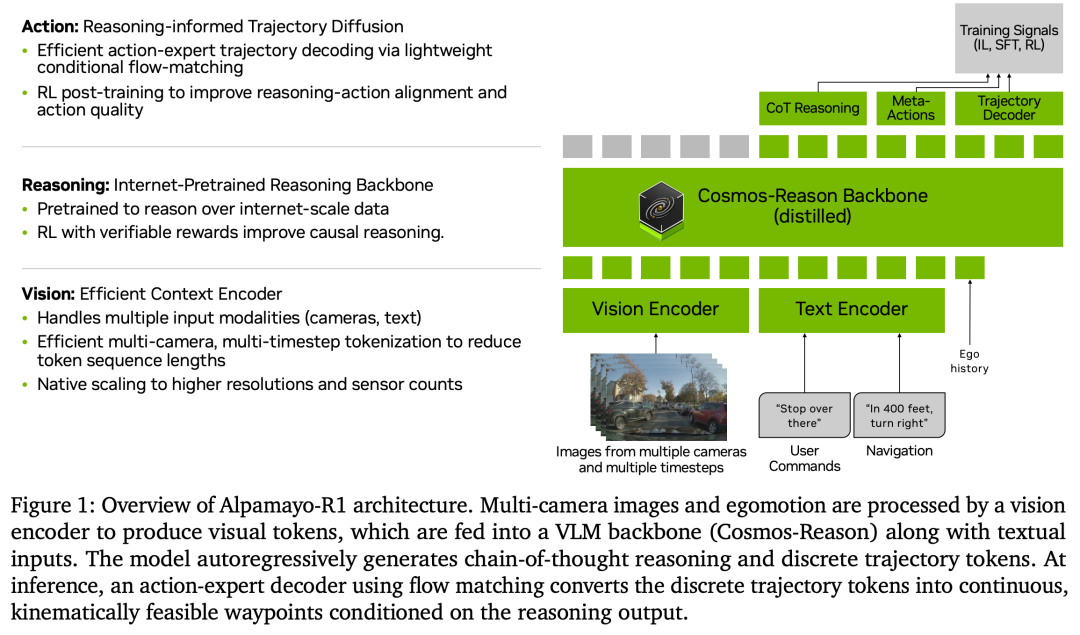

Alpamayo-R1

论文标题:Alpamayo-R1: Bridging Reasoning and Action Prediction for Generalizable Autonomous Driving in the Long Tail

论文链接:https://arxiv.org/abs/2511.00088

提出机构:NVIDIA

一句话总结:为了解决端到端自动驾驶在长尾安全关键场景中因监督稀疏和因果理解不足导致的性能瓶颈,Alpamayo-R1 提出了一种融合因果推理与轨迹规划的视觉-语言-动作模型,通过结构化因果链数据集、模块化VLA架构与强化学习后训练,显著提升了在复杂驾驶场景中的规划安全性与决策可解释性。

核心贡献:

提出了 Chain of Causation(CoC)数据集,通过人机协同标注流程构建具有因果关联的结构化推理轨迹,确保推理与驾驶行为在时间与逻辑上对齐,避免了传统自由形式推理中的模糊性与因果混淆问题。

设计了 模块化推理VLA架构,以物理AI预训练的Cosmos-Reason为骨干,结合基于流匹配的轨迹解码器,实现高效的多相机时序感知与实时轨迹生成,在保证推理深度的同时满足车载部署的实时性要求(99ms延迟)。

提出了 多阶段训练策略,包括动作模态注入、基于CoC的监督微调以及基于大推理模型反馈的强化学习后训练,共同优化推理质量、推理-动作一致性以及轨迹安全性,在仿真与实车测试中均表现出显著的性能提升。

在闭环仿真与实车测试中验证了其有效性:相比仅预测轨迹的基线模型,Alpamayo-R1在挑战性场景中规划准确率提升最高达12%,脱轨率降低35%,近距离接触率降低25%,推理质量与推理-动作一致性分别提升45%与37%。

Cosmos-Predict2.5

论文标题:World Simulation with Video Foundation Models for Physical AI

论文链接:https://arxiv.org/abs/2511.00062

项目主页:https://github.com/nvidia-cosmos/cosmos-predict2.5

https://github.com/nvidia-cosmos/cosmos-transfer2.5提出机构:NVIDIA

一句话总结:提出了新一代物理AI视频世界基础模型Cosmos-Predict2.5与其控制网络变体Cosmos-Transfer2.5,基于流匹配架构统一了文本、图像、视频到世界的生成能力,并引入物理AI专用VLM——Cosmos-Reason1进行文本嵌入与细粒度控制,在视频质量、指令对齐与长视频生成一致性上实现显著提升,为机器人、自动驾驶等具身智能任务提供高保真、可控的世界仿真与合成数据生成平台。

核心贡献:

统一的多模态世界生成架构:首次在单一模型中集成Text2World、Image2World和Video2World生成能力,基于流匹配实现高质量、时序一致的视频预测与生成。

物理AI专用数据与训练流程:构建了包含2亿精选视频片段的大规模训练数据集,并针对机器人、自动驾驶、智能空间、人体动力学、物理现象等五大领域进行专项数据整理与标注,提升模型在物理场景中的生成真实性与合理性。

控制网络增强与长视频生成:提出Cosmos-Transfer2.5,支持边缘、模糊、深度、分割等多模态控制信号输入,在保持模型规模减小3.5倍的同时,实现更高的生成质量与更少的错误累积,支持长达120秒的长视频连贯生成。

多视角与相机可控生成:扩展模型支持多摄像头同步视频生成(如自动驾驶7视角、机器人3视角),并实现基于相机轨迹的视角重渲染,为机器人操纵与自动驾驶仿真提供多视角一致的场景合成能力。

强化学习后训练与模型蒸馏:采用基于VLM奖励模型的强化学习对生成质量进行对齐优化,并使用时步蒸馏技术将推理步数大幅减少至4步,在保持质量的同时显著提升生成效率。

开源模型与基准评估:全面开源2B与14B规模的预训练与后训练模型,涵盖基础生成、领域专用及控制网络变体,并在PAI-Bench等物理AI基准测试中取得领先性能,为社区提供可复现、可扩展的世界仿真基础平台。

NVFP4

论文标题:Pretraining Large Language Models with NVFP4

论文链接:https://arxiv.org/abs/2509.25149

开源链接:https://github.com/NVIDIA/TransformerEngine/pull/2177

提出机构:NVIDIA

一句话总结:针对大型语言模型(LLM)预训练中计算与内存消耗巨大的挑战,NVIDIA 提出并验证了一种基于新型 4 位浮点格式 NVFP4 的高效训练方法,通过引入混合精度、随机哈达玛变换、二维权重缩放与随机舍入等关键技术,成功在 120 亿参数模型上进行了长达 10 万亿 token 的稳定训练,其损失曲线与下游任务精度与 FP8 基线模型相当,首次证实了 4 位精度在万亿 token 规模预训练中的可行性。

核心贡献:

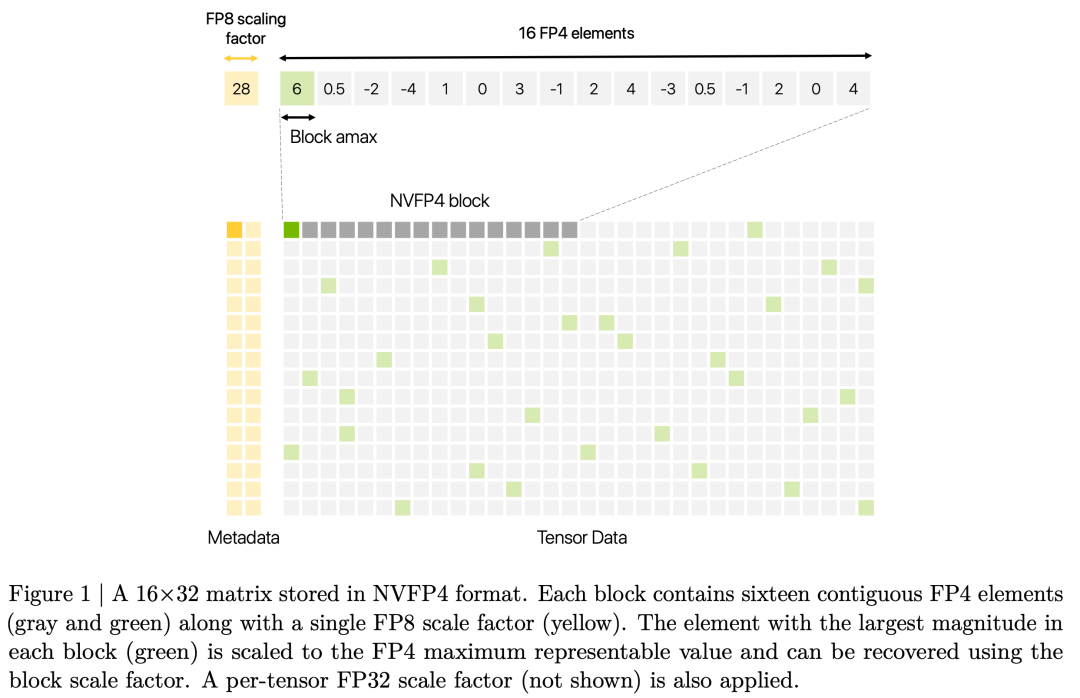

提出 NVFP4 格式:一种增强型 4 位微缩放格式,通过将块大小从 32 减小到 16、使用 E4M3 格式存储块尺度因子、并引入张量级 FP32 尺度进行两级缩放,显著提升了数值表示的准确性,尤其是对异常值的捕获能力,减少了小值量化为零的损失。

系统性的 4 位训练方法学:提出一套完整且必要的技术组合以确保大规模 4 位训练的稳定与收敛,包括:1) 将网络末端对数值敏感的部分线性层(约15%)保留在高精度(BF16/MXFP8);2) 在权重梯度计算(Wgrad)的输入上应用 16x16 随机哈达玛变换以分散块级异常值;3) 对权重采用 16x16 二维块缩放,确保前向与反向传播中量化表示的一致性;4) 对梯度张量应用随机舍入以减少量化偏差。

大规模训练验证:在 120 亿参数的混合 Mamba-Transformer 模型上,使用 NVFP4 格式成功完成了 10 万亿 token 的预训练。实验表明,其验证损失与 FP8 基线全程紧密吻合(相对误差<1.5%),并在 MMLU、数学、多语言理解、常识推理等多个下游任务上取得了可比拟的准确率。

NVFP4 与 MXFP4 的对比优势:通过 80 亿参数模型的对比实验证明,NVFP4 在达到相同训练损失时,所需的训练 token 数比 MXFP4 少约 36%,在收敛效率上展现出明显优势,凸显了其更优的数值属性。

为窄精度训练铺平道路:本研究首次公开证明了在万亿 token 规模上使用 4 位精度进行持续预训练的可行性,为下一代更大规模、更高能效的 LLM 训练提供了关键算法基础和实践路径。相关工作已在 NVIDIA Blackwell GPU 上通过 Transformer Engine 获得全面支持。

Audio2Face-3D

论文名称:Audio2Face-3D: Audio-driven Realistic Facial Animation For Digital Avatars

论文链接:https://arxiv.org/abs/2508.16401

提出机构:NVIDIA

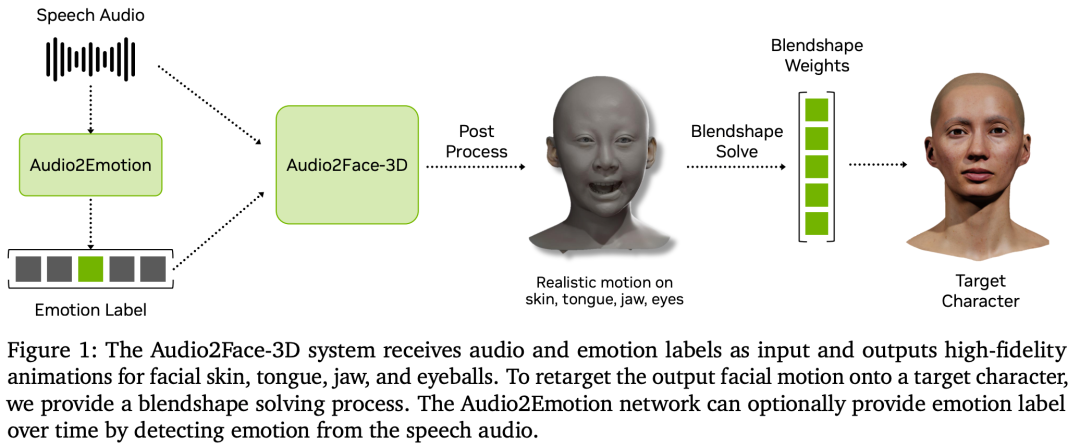

一句话总结:Audio2Face-3D 是一个基于深度学习的端到端音频驱动三维面部动画系统,能够从单一语音输入实时生成高保真、口型同步且带情感表达的全脸动画(包括皮肤、舌头、下巴和眼球运动),支持多身份适配与流式推理,并开源了模型、SDK与训练框架,推动数字人技术的普及与应用。

核心贡献:

双网络架构设计:提出了两种互补的神经网络架构——基于回归的轻量级网络(Audio2Face-3D-v2.3)与基于扩散模型的高质量网络(Audio2Face-3D-v3.0)。回归网络支持低延迟单帧推理,适合实时多路并行;扩散网络以流式方式生成连续30帧动画,在表现力与自然度上更优,且支持多身份条件生成。

高质量数据管道与增强策略:构建了基于专业演员多情感语音捕获的4D面部数据集,并创新性地采用语音转换、文本转语音对齐与静默数据插入三种增强方法,在不破坏音画同步的前提下显著提升数据的多样性与模型的泛化能力。

可重定向的混合形状求解器:开发了一套基于优化的混合形状权重求解流程,可将网络生成的面部顶点运动转化为标准的ARKit混合形状权重,支持将动画无缝重定向至不同角色模型(如MetaHuman),提升了输出结果的通用性与生产流程兼容性。

实时流式推理与后处理控制:系统支持在线流式音频输入并实时生成动画,推理延迟低,并提供丰富的后处理参数面板(如区域运动强度、平滑度、眼球与眨眼控制等),允许用户在无需重新训练的情况下对生成动画进行细节调整与风格化编辑。

拓展性实验功能:探索了多项前沿扩展,包括文本驱动的情绪与面部动作控制(通过CLIP文本编码器)、头部运动生成、音频直接驱动角色装备参数以及下巴引导的混合形状求解,展示了系统在未来数字人动画生成中的更多可能性。

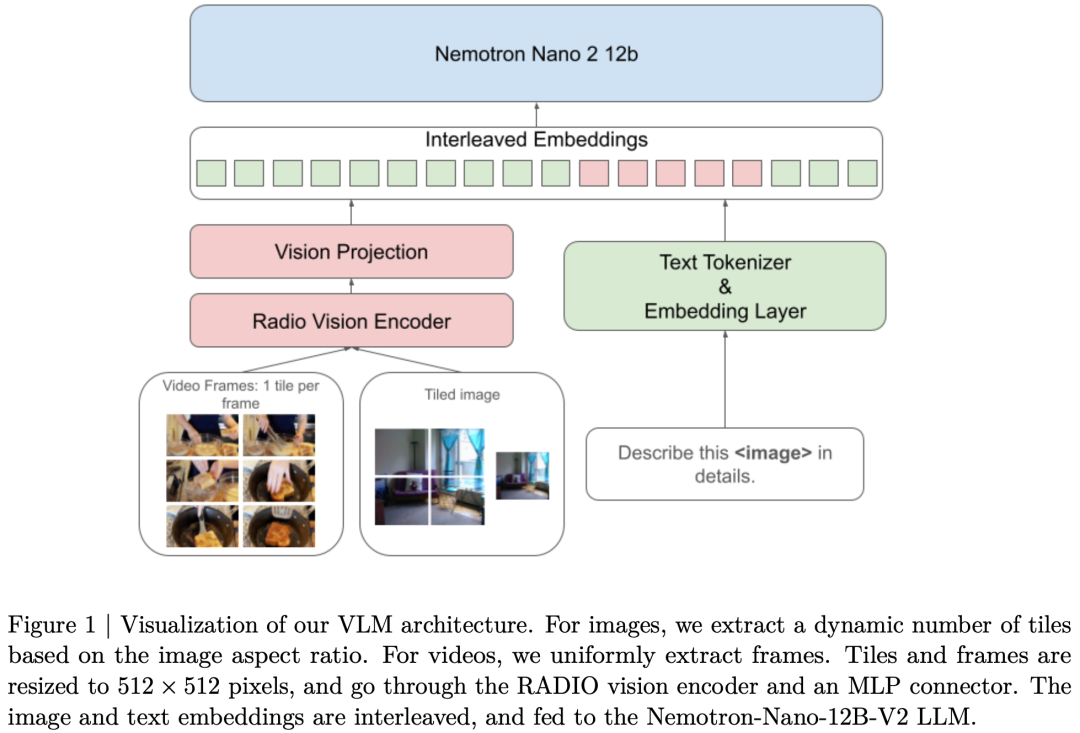

NVIDIA Nemotron Nano 2

论文名称:NVIDIA Nemotron Nano 2: An Accurate and Efficient Hybrid Mamba-Transformer Reasoning Model

论文链接:https://arxiv.org/abs/2508.14444

提出机构:NVIDIA

一句话总结:Nemotron Nano 2是一款面向推理任务的高效混合架构语言模型,通过结合Mamba-2层与自注意力层,在保持与同类模型相当或更高精度的同时,实现了最高达6倍的推理吞吐量提升,并支持128k长上下文推理。

核心贡献:

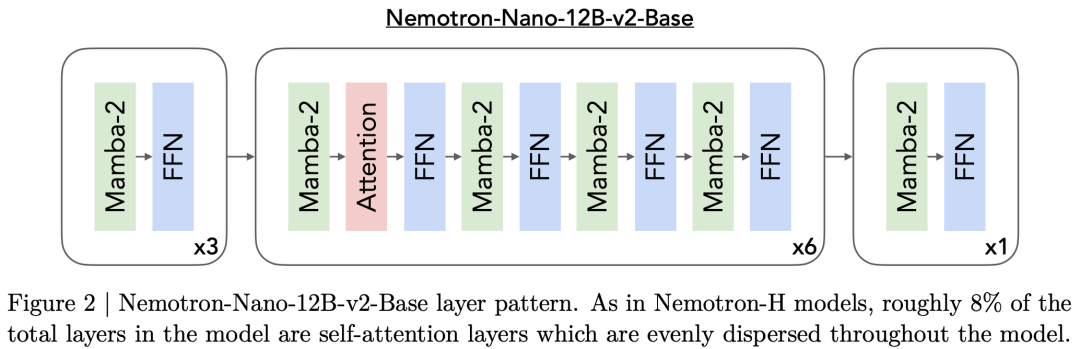

提出了一种混合Mamba-Transformer架构(Nemotron-Nano-12B-v2-Base),将大部分自注意力层替换为Mamba-2层,显著提升长序列生成效率,适用于需要长思维链的推理场景。

构建了高质量、多领域的预训练数据集,包括经过精心筛选的通用爬取数据、数学专用数据(Nemotron-CC-Math)、代码数据,以及多种合成数据(如STEM、多语言问答、学术SFT风格数据),显著提升了模型在数学、代码、多语言理解等方面的能力。

采用了FP8混合精度训练配方与分阶段课程学习策略,在20T token上完成预训练,并进行了长上下文扩展训练,使模型支持128k上下文而不损失其他任务性能。

设计了一套完整的对齐流程,包括多阶段监督微调(SFT)、指令遵循强化学习(GRPO)、直接偏好优化(DPO)以及人类反馈强化学习(RLHF),显著提升了模型的指令遵循、工具调用和对话能力。

提出并实施了基于Minitron的轻量级剪枝与蒸馏策略,将12B模型压缩至9B,使其能够在单张NVIDIA A10G GPU(22GB显存)上以128k上下文进行推理,在保持高精度的同时大幅提升部署效率与推理速度。

Nemotron-H:

论文名称:Nemotron-H: A Family of Accurate and Efficient Hybrid Mamba-Transformer Models

论文链接:https://arxiv.org/abs/2504.03624

提出机构:NVIDIA

一句话总结:为了突破传统Transformer模型因自注意力机制导致的推理时计算和内存开销线性增长的瓶颈,并适应现代LLM“推理时缩放”以提升答案质量的新范式,NVIDIA推出了Nemotron-H系列模型。该系列采用创新的混合Mamba-Transformer架构,用计算和内存需求恒定的Mamba层替代了绝大部分自注意力层,从而在保证与同类顶尖开源Transformer模型(如Qwen2.5、Llama3.1)相当甚至更优精度的前提下,实现了高达3倍的推理速度提升。同时,其配套的FP8训练方案和名为MiniPuzzle的压缩-蒸馏技术,大幅降低了此类高性能混合模型的训练与部署成本。

核心贡献:

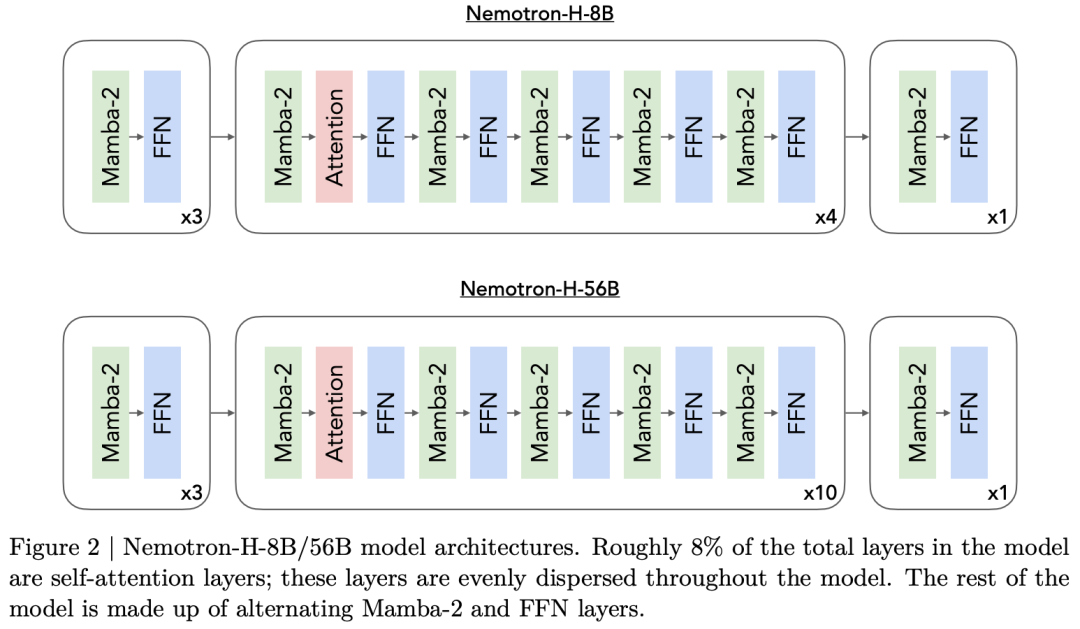

开创性的高效混合架构:提出了以Mamba-2层为核心、仅保留约8%自注意力层的混合模型架构(8B和56B参数规模)。该设计从根本上改变了自回归推理的计算模式,使得每生成一个token的计算量和激活内存趋于恒定,从而在生成长序列时获得巨大的推理吞吐量优势(在65k输入、1k输出场景下,吞吐量达同类Transformer的2-3倍)。

创新的模型压缩范式MiniPuzzle:提出了一种结合轻量级剪枝与神经架构搜索(NAS)的压缩框架,能够根据目标硬件(如单张RTX 5090 GPU)的显存和延迟约束,自动搜索并蒸馏出最优的子架构。成功将56B模型压缩为47B模型,仅用极少量(63B)token进行蒸馏便恢复精度,并在长上下文推理中实现额外20%的加速,极大提升了部署灵活性。

实用的FP8混合精度训练方案:为56B大模型成功实施了以FP8(E4M3/E5M2)精度为主的层wise混合精度预训练方案(仅首尾少量层保持BF16)。实验证明,该方案在长达20万亿token的训练中稳定,且下游任务精度与BF16训练相当甚至更优,为降低大模型训练成本提供了可靠路径。

验证了混合架构的广泛适用性:基于Nemotron-H骨干网络,成功构建了在多项视觉语言基准(MMMU, MathVista等)上达到SOTA水平的VLM模型(8B/56B-VLM),以及具有强指令跟随和长上下文(128K)处理能力的推理模型(8B/47B-Reasoning),充分证明了该混合架构在不同模态和任务上的强大泛化能力和后训练潜力。

Cosmos-Reason1

论文名称:Cosmos-Reason1: From Physical Common Sense To Embodied Reasoning

论文链接:https://arxiv.org/abs/2503.15558

项目主页:https://github.com/nvidia-cosmos/cosmos-reason1

提出机构:NVIDIA

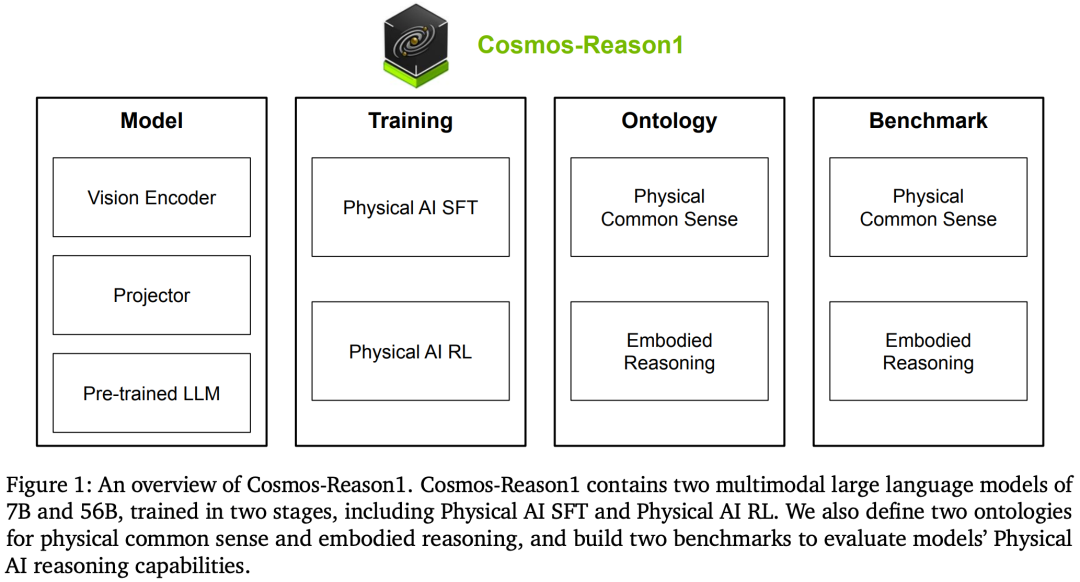

一句话总结:为了赋予多模态大语言模型真正的“物理常识”与“具身推理”能力,NVIDIA提出了Cosmos-Reason1模型家族,它通过定义一套层次化的物理常识本体与二维具身推理本体,并采用“监督微调+强化学习”的两阶段训练范式,使得模型能够基于视频输入进行长链条思维推理,输出符合物理规律的解释与行动决策,显著缩小了AI模型在抽象符号推理与真实物理世界交互之间的能力鸿沟。

核心贡献:

系统定义了物理AI推理的两大核心能力及其本体:首次明确提出了物理常识推理(分为空间、时间、基础物理三大类16个子类)和具身推理(涵盖处理复杂感知输入、预测动作效果、尊重物理约束、从交互中学习四大能力,并泛化至人类、机械臂、人形机器人、自动驾驶车辆等多种智能体)的层次化本体框架,为构建和评估物理AI模型建立了清晰的路线图与标准。

提出了专为物理AI设计的、可扩展的两阶段训练方法:首先通过精心策划的约4M视频-文本对(包括理解性与推理性标注)进行监督微调,随后创新性地利用基于规则、可验证的多选题奖励进行强化学习后训练。这种组合显著提升了模型的基础物理常识与在具体场景中做出合理行动规划的能力。

构建了全面、可量化的物理AI评估基准:根据定义的本体,分别构建了包含604个问题的物理常识推理基准和涵盖6个数据集、610个问题的具身推理基准,为社区提供了衡量模型物理世界理解与决策能力的重要标尺。

验证了方法在7B和56B模型上的显著有效性:实验表明,经过物理AI SFT后,模型在物理常识和具身推理基准上的性能较基线VLM提升超过10%。进一步的物理AI RL训练能在多数任务上再带来超过5%的性能提升。尤为突出的是,模型在直觉物理任务(如时间箭头、空间谜题、物体恒存性)上取得了远优于现有主流模型的性能,展现了其深入理解物理世界根本规律的能力。

GR00T N1

论文名称:GR00T N1: An Open Foundation Model for Generalist Humanoid Robots

论文链接:https://arxiv.org/abs/2503.14734

提出机构:NVIDIA

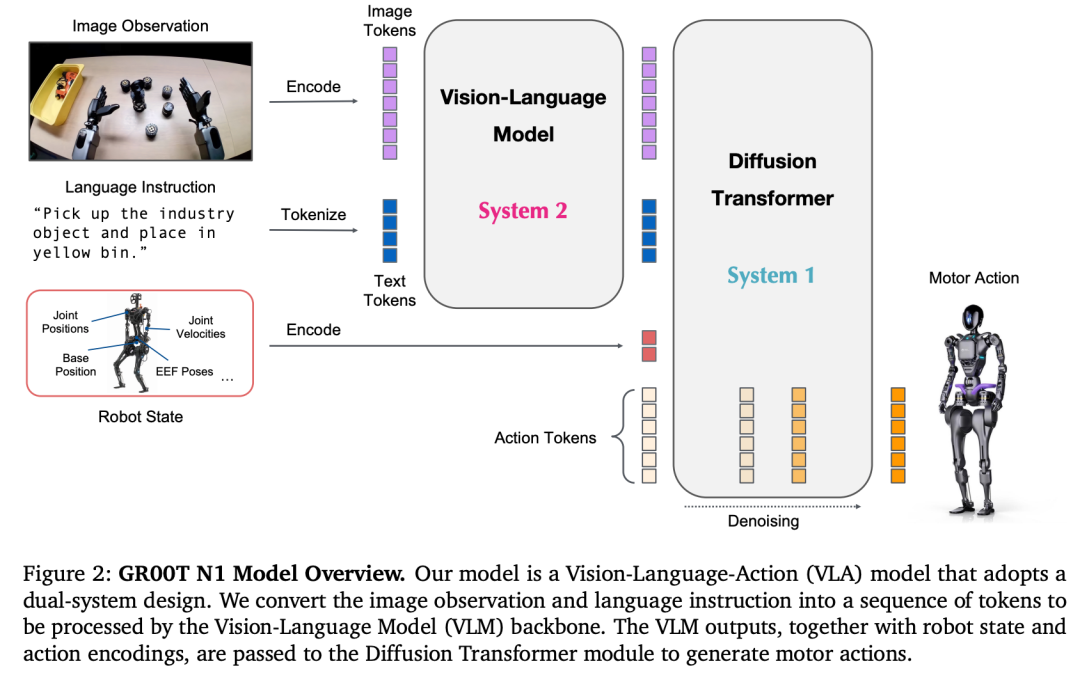

一句话总结:GROOT N1 是一个面向通用人形机器人的开放式视觉-语言-动作(VLA)基础模型,采用双系统架构(System 2 用于视觉语言理解,System 1 用于实时动作生成),并通过构建包含真实机器人数据、仿真轨迹、人类视频与神经生成视频的“数据金字塔”进行大规模预训练,实现了跨多种机器人平台的强泛化能力与高数据效率。

核心贡献:

提出双系统VLA架构:将视觉语言模型(Eagle-2 VLM)作为慢速推理模块(System 2)处理环境理解,与基于扩散Transformer(DiT)的快速动作生成模块(System 1)紧密耦合、端到端联合训练,实现了语义理解与实时动作输出的高效协同。

设计数据金字塔训练策略:创新性地构建了从海量人类视频(底层)、仿真与神经生成数据(中层)到真实机器人轨迹(顶层)的异构数据体系,通过潜在动作学习与逆动力学模型标注,统一了不同来源数据的动作表示,有效缓解了机器人数据稀缺与“数据孤岛”问题。

实现跨平台通用策略:使用单一模型权重支持从单臂机械臂到双手机巧人形机器人等多种机器人形态,在仿真与真实世界基准测试中均显著超越现有模仿学习方法,尤其在低数据场景下表现出卓越的样本效率。

推动开源与社区共享:公开发布了GROOT-N1-2B模型检查点、训练数据集及仿真基准,为机器人基础模型的研究与应用提供了重要的开放资源与可复现基础,加速通用人形机器人技术的发展。

Cosmos-Transfer1

论文名称:Cosmos-Transfer1: Conditional World Generation with Adaptive Multimodal Control

论文链接:https://arxiv.org/abs/2503.14492

项目主页:https://github.com/nvidia-cosmos/cosmos-transfer1

提出机构:NVIDIA

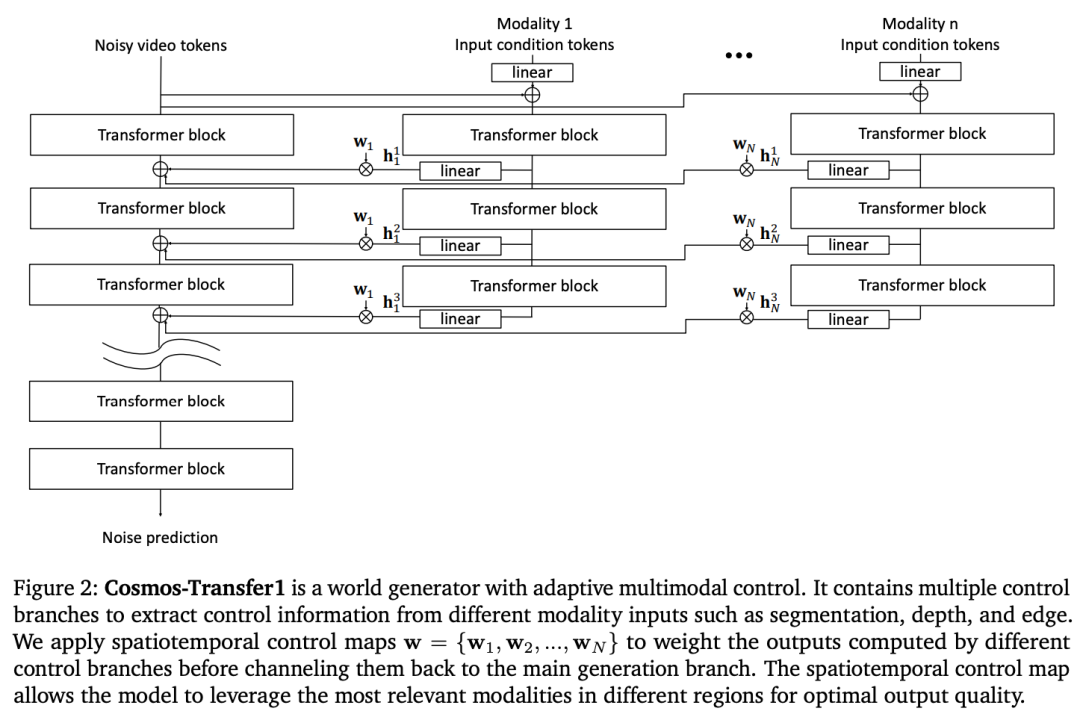

一句话总结:Cosmos-Transfer1 是一个基于扩散模型的多模态可控世界生成框架,通过自适应空间-时间控制权重机制,能够根据不同模态输入(如语义分割、深度图、边缘图等)生成高质量的世界仿真视频,特别适用于机器人 Sim2Real 与自动驾驶数据增强等物理 AI 任务,并可扩展至实时生成。

核心贡献:

提出自适应多模态控制机制:首次在扩散世界模型中引入多分支控制网络,并设计可动态调整的时空控制权重图,使用户能够根据不同区域、不同时间点自由调节各模态控制强度,实现细粒度可控世界生成。

实现多模态控制分支独立训练与推理时融合:各模态控制分支可独立训练,缓解内存压力并支持异构数据训练,推理时支持灵活添加或移除模态,增强系统灵活性与扩展性。

构建面向自动驾驶的高质量数据集 RDS-HQ:包含 360 小时的高清地图、3D 检测框与 LiDAR 同步标注,为自动驾驶视频生成提供丰富控制信号,提升生成视频的几何与语义一致性。

验证Sim2Real 与数据增强的有效性:在机器人操作与自动驾驶场景中,Cosmos-Transfer1 能显著提升合成视频的真实性与多样性,同时保持关键场景结构的完整性,有效缓解仿真与现实间的领域差异。

实现实时世界生成:通过设计基于 NVIDIA GB200 NVL72 系统的并行推理策略,在 64 块 GPU 上实现 5 秒 720p 视频的实时生成,为大规模物理 AI 应用提供可行的部署方案。

Cosmos

论文名称:Cosmos World Foundation Model Platform for Physical AI

论文链接:https://arxiv.org/abs/2501.03575

开源链接:https://github.com/nvidia-cosmos/cosmos-predict1

提出机构:NVIDIA

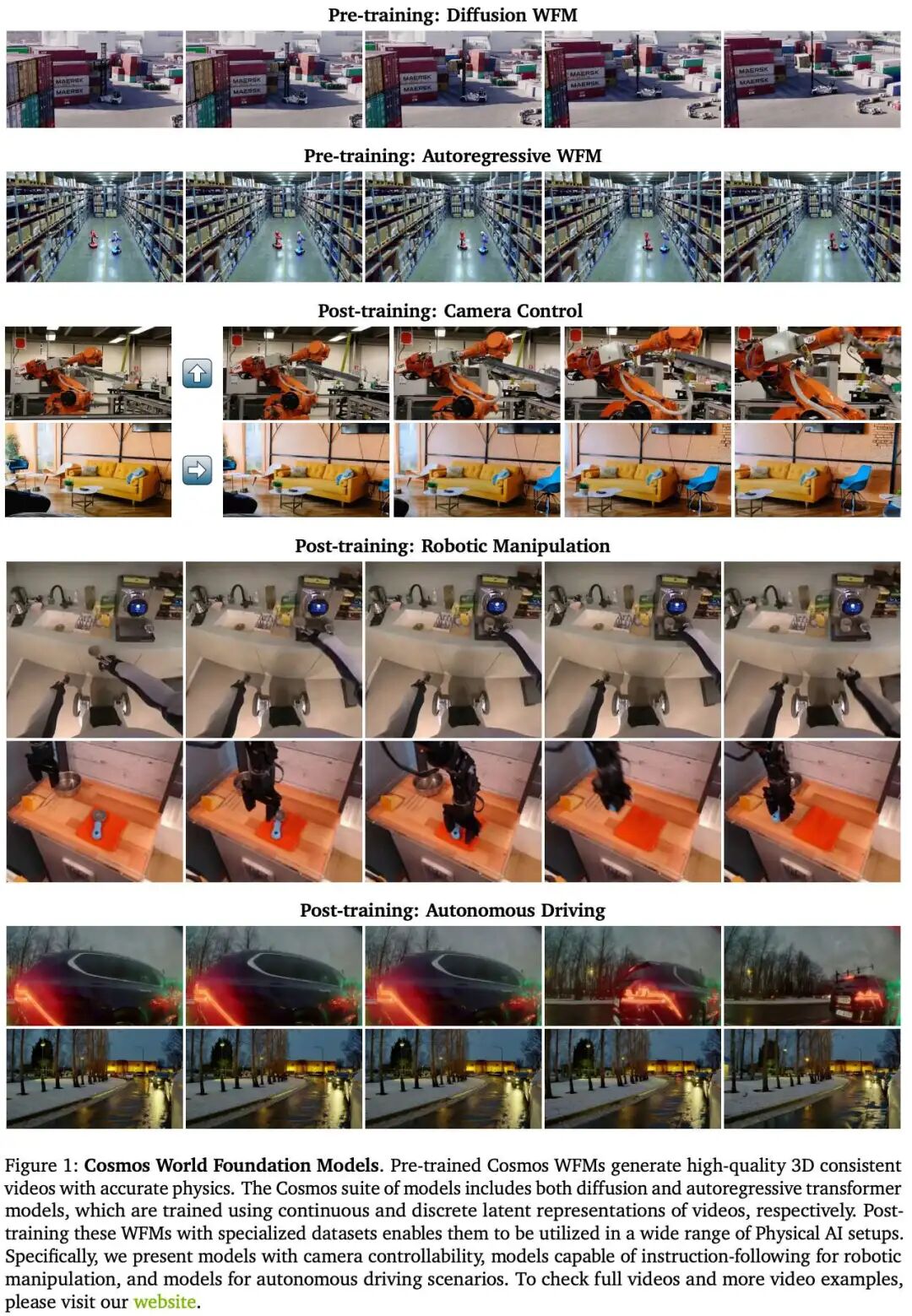

一句话总结:本文提出了 Cosmos 世界基础模型平台,通过构建可扩展的视频数据流程、连续与离散视频标记器、基于扩散与自回归的世界基础模型,以及面向多种物理 AI 任务的后训练机制,为物理 AI 系统提供了一个可高效微调的世界仿真基础。

核心贡献 :

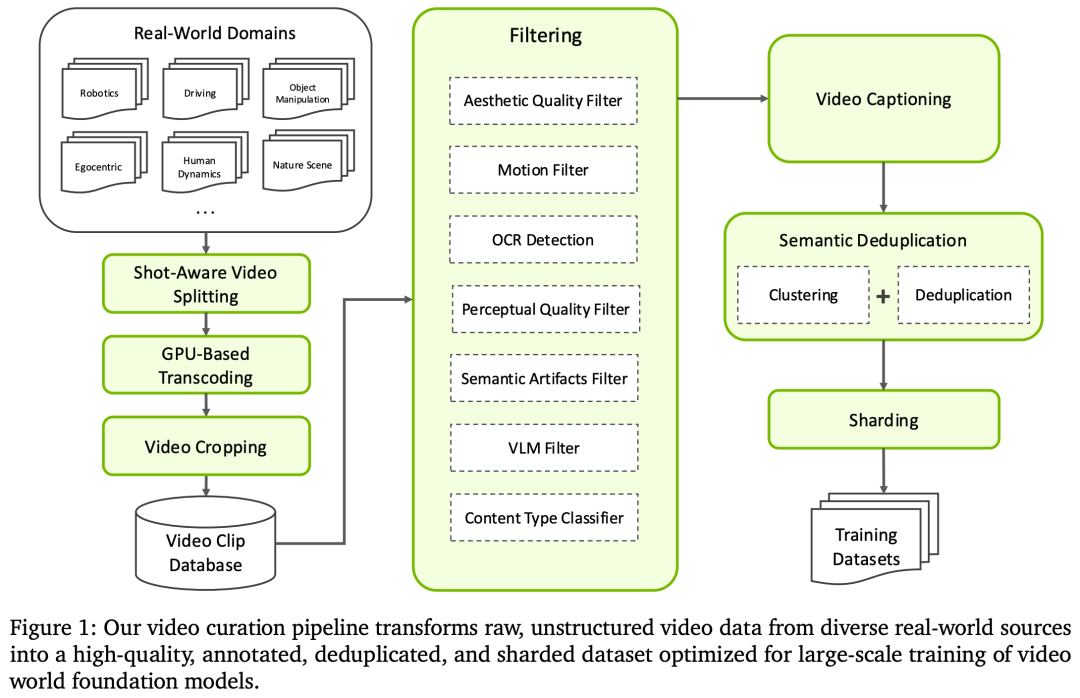

构建了大规模视频数据管理流程,涵盖视频分割、过滤、标注、去重与分片,从 2000 万小时原始视频中提取出高质量、多样化的训练数据集。

提出了一套高效视频标记器,支持连续与离散两种标记形式,具备时序因果性、多尺度压缩能力,在重建质量与推理速度上显著优于现有方法。

开发了两种可扩展的世界基础模型架构:基于扩散的模型(Cosmos-Predict1-7B/14B)与基于自回归的模型(Cosmos-Predict1-4B/12B),均支持文本、视频与动作等多模态条件输入。

展示了模型在多种物理 AI 任务中的后训练适应性,包括相机控制、机器人操作(指令跟随与动作预测)与自动驾驶多视角视频生成,验证了其作为世界仿真器的实用价值。

设计了安全防护机制,包括前向提示过滤与后向内容检测,保障模型生成内容的安全性。

开源模型与工具链,通过 NVIDIA Cosmos 平台提供预训练模型与标记器,推动物理 AI 社区的发展。

自动驾驶之心

端到端与VLA自动驾驶小班课!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?