点击下方卡片,关注“3D视觉之心”公众号

第一时间获取3D视觉干货

一、为啥需要“全能多模态”3D模型?

现在主流3D基础模型(比如VGGT)能统一处理多种3D任务,但有个大问题:只认RGB图像,不用深度、相机参数这些“送分题”信息。

实际应用中,辅助信息随处可见:VR/AR有RGB-D数据、自动驾驶有激光雷达点云、机器人有相机参数,但现有方法要么只能用一种辅助信息,要么最多处理两种(比如RGB+深度),没法灵活适配不同场景。

我们提出OmniVGGT,一个能在训练和推理时灵活利用任意数量辅助几何模态的框架。

文章标题:OmniVGGT: Omni-Modality Driven Visual Geometry Grounded Transformer

项目链接:https://livioni.github.io/OmniVGGT-offcial/

核心创新有两个:

GeoAdapter(几何适配器):用零初始化卷积将深度、相机参数等几何信息逐步注入基础模型,不破坏原有特征空间,计算开销极小,推理速度和原模型VGGT差不多;

随机多模态融合策略:训练时随机采样模态子集,让模型在测试时能接受任意数量的模态输入,学到更鲁棒的空间表示,不会过度依赖辅助信息。

实验表明,OmniVGGT在单目/多视图深度估计、多视图立体匹配、相机位姿估计等任务上都达到顶尖水平,甚至只用RGB输入也比现有方法好。更实用的是,把它集成到视觉-语言-动作(VLA)模型中,还能显著提升机器人操作任务的性能。

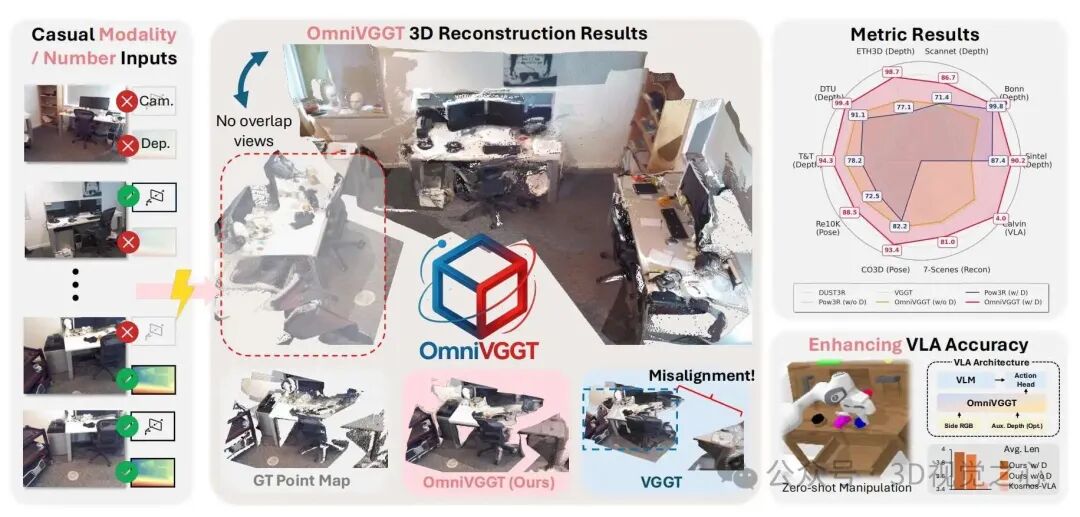

图1:OmniVGGT核心效果

图1:OmniVGGT核心效果

这张图展示了框架的灵活性:输入任意数量的辅助几何模态(深度、相机内参/外参),都能输出高质量3D几何结果;集成到VLA模型后,机器人操作任务的表现也大幅提升。

OmniVGGT就是要解决“信息浪费”和“适配性差”的问题——不管有多少种、多少比例的辅助信息,都能充分利用,还不影响纯RGB输入时的性能。

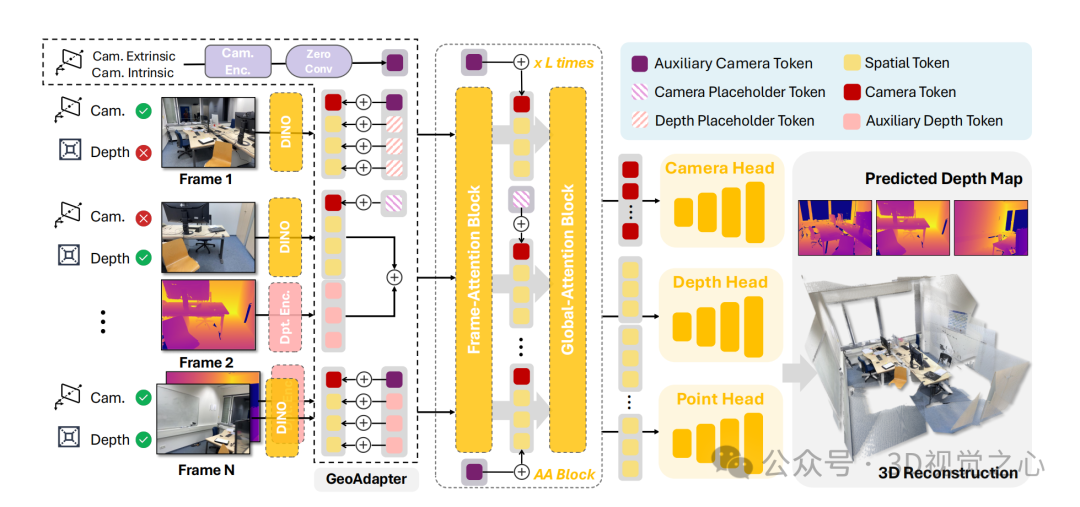

图2:OmniVGGT整体流程

图2:OmniVGGT整体流程

这张图清晰展示了工作逻辑:输入图像集+任意数量的相机参数(位姿/内参)或深度图,缺失的辅助信息用占位符令牌替代;经过L层交替注意力网络处理后,通过三个预测头输出深度图、相机位姿和3D点云图,全程端到端完成。

二、核心技术:GeoAdapter+随机融合,灵活又高效

1. 基础:VGGT的核心逻辑

OmniVGGT基于VGGT改进,先简单了解VGGT的流程:

图像先通过DINO骨干网络转换成空间令牌;

空间令牌和可学习的相机令牌、注册令牌拼接,输入Transformer编码器;

编码器用交替注意力(AA)机制:帧内自注意力捕捉单图结构,全局自注意力聚合多视图信息;

最后用DPT头预测深度图、3D点云图和置信度图,相机头预测相机内参和外参。

2. GeoAdapter:优雅注入多模态信息

GeoAdapter分相机适配器和深度适配器,专门解决“不同模态怎么融合”的问题,轻量又稳定。

(1)相机适配器:处理全局相机参数

相机参数(内参、外参)是全局信息,直接注入容易打乱模型特征,所以用零卷积逐步融入:

坐标归一化:把第一个相机设为原点,计算其他相机到原点的平均距离,统一缩放平移量:

参数编码:把内参、归一化后的位姿转换成特征向量(是旋转四元数,是平移向量,是视场角);

零卷积注入:每个AA块前,用相机编码器生成辅助令牌,再通过零卷积加到原相机令牌上:

是二进制指示器(1表示有相机信息,0则用占位符令牌)。

(2)深度适配器:处理稠密深度图

深度图是逐像素的局部信息,直接注入更高效:

深度归一化:按批次计算有效深度的均值,归一化后和掩码拼接:;

令牌对齐:用卷积编码器将转换成和空间令牌维度一致的辅助令牌;

直接相加:有深度信息就加辅助令牌,没有就加深度占位符令牌:

是二进制指示器(1表示有深度信息),实验证明深度分支不用零卷积,融合效果更好。

3. 随机多模态融合:支持任意输入组合

训练时故意“随机缺信息”,让模型适应各种场景:

对相机信息:随机采样(是序列长度),只给前张图标注相机参数;

对深度信息:独立随机采样,随机选张图标注深度;

纯RGB场景:部分批次(概率)只输入RGB图像,保证无辅助信息时也能工作。

4. 损失函数:多任务联合优化

总损失包含三个部分,和VGGT一致:

:相机参数预测的L1损失;

和:置信度感知回归损失+梯度项,保证局部几何一致性。

三、实验效果:全能选手,样样顶尖!

我们用19个公开数据集训练(覆盖室内/室外、真实/合成、静态/动态场景),在多个3D任务上做了全面测试,结果超惊艳。

核心图表解读

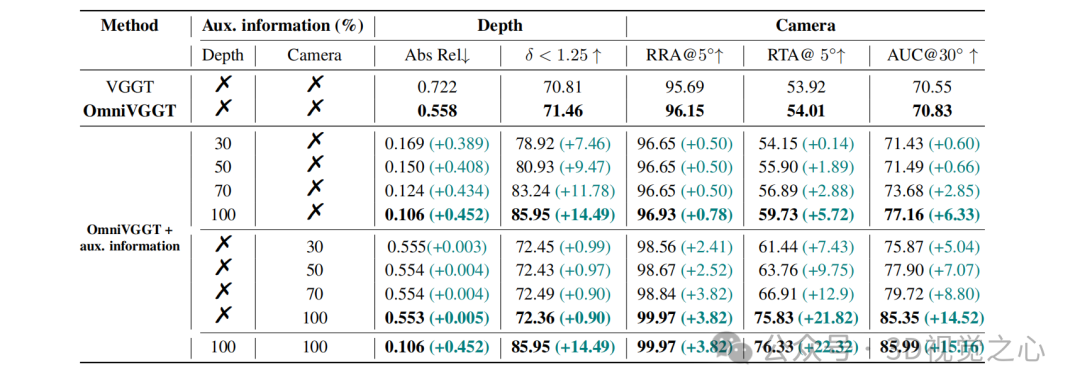

表1:辅助信息比例的影响(Sintel数据集)

表1:辅助信息比例的影响(Sintel数据集)

这张表验证了灵活性:辅助信息越多,性能越好,而且不同类型辅助信息能互补:

只加30%深度信息:深度估计的绝对相对误差(Abs Rel)就降低0.408,效果显著;

加100%相机+100%深度信息:相机位姿的AUC@30°达85.99%,比无辅助信息提升15.16%;

纯RGB输入时,OmniVGGT也比VGGT基线好,证明GeoAdapter没有副作用。

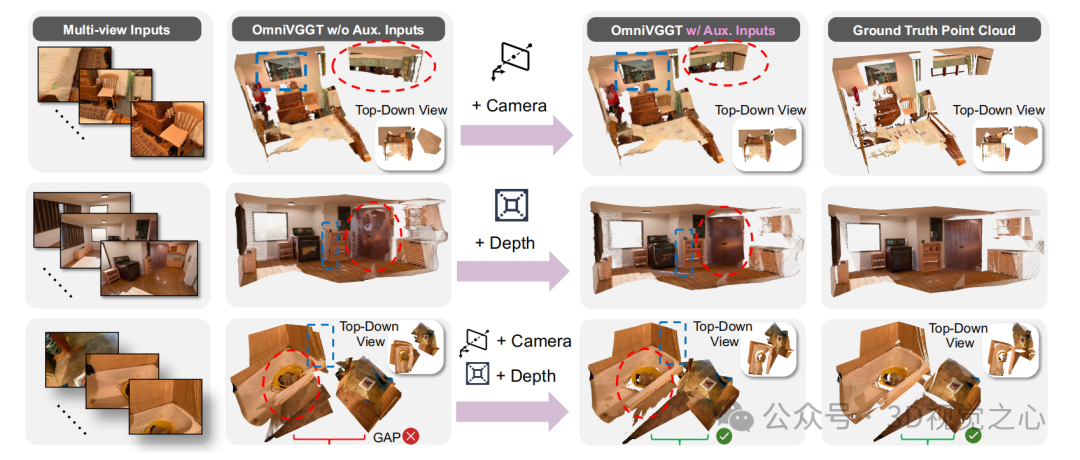

图3:不同辅助信息的视觉效果

图3:不同辅助信息的视觉效果

这张图很直观:

加相机信息:能修正几乎无重叠的复杂场景的位姿;

加深度信息:门等局部几何更精准;

两者都加:相对距离和视角都能正确校正,重建效果最棒。

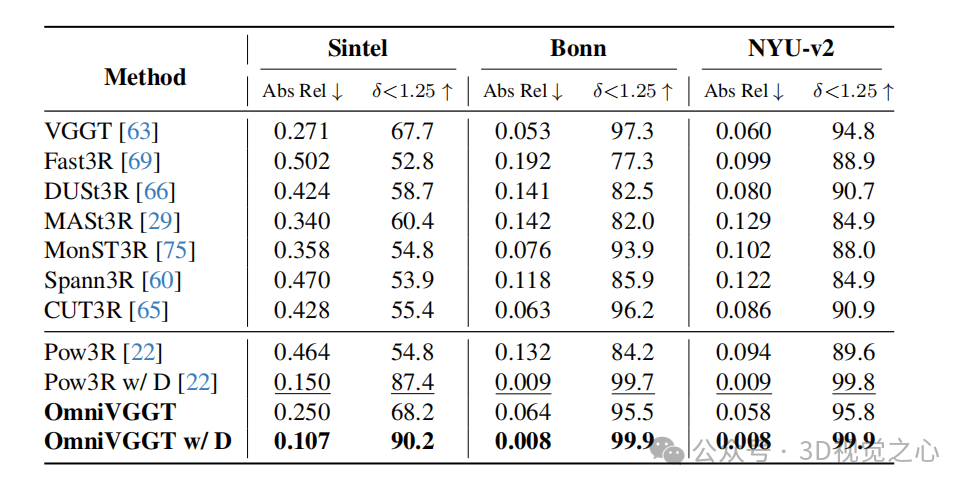

表2:单视图深度估计(Sintel、Bonn、NYU-v2数据集)

表2:单视图深度估计(Sintel、Bonn、NYU-v2数据集)

OmniVGGT不管有没有辅助信息都领先:

纯RGB输入:Sintel数据集的(符合要求的像素比例)达68.2%,比VGGT高0.5个百分点;

加100%深度信息:Bonn和NYU-v2数据集的达99.9%,几乎完美,远超其他方法。

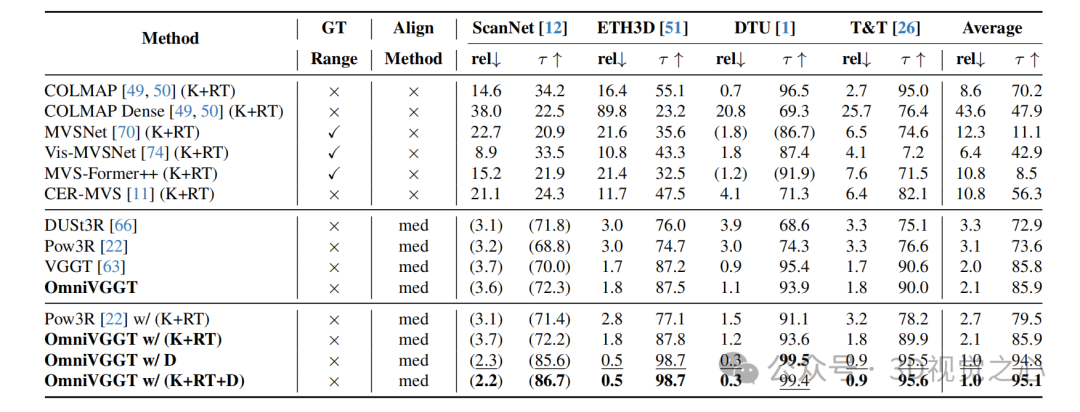

表3:多视图深度估计(ScanNet、ETH3D等数据集)

表3:多视图深度估计(ScanNet、ETH3D等数据集)

多视图场景下优势更明显:

纯RGB输入:ScanNet的相对误差(rel)3.6,和VGGT相当,ETH3D的达87.5%,略高于VGGT;

加100%深度信息:ETH3D的rel仅0.5,达98.7%,DTU数据集的达99.5%,全面碾压其他方法。

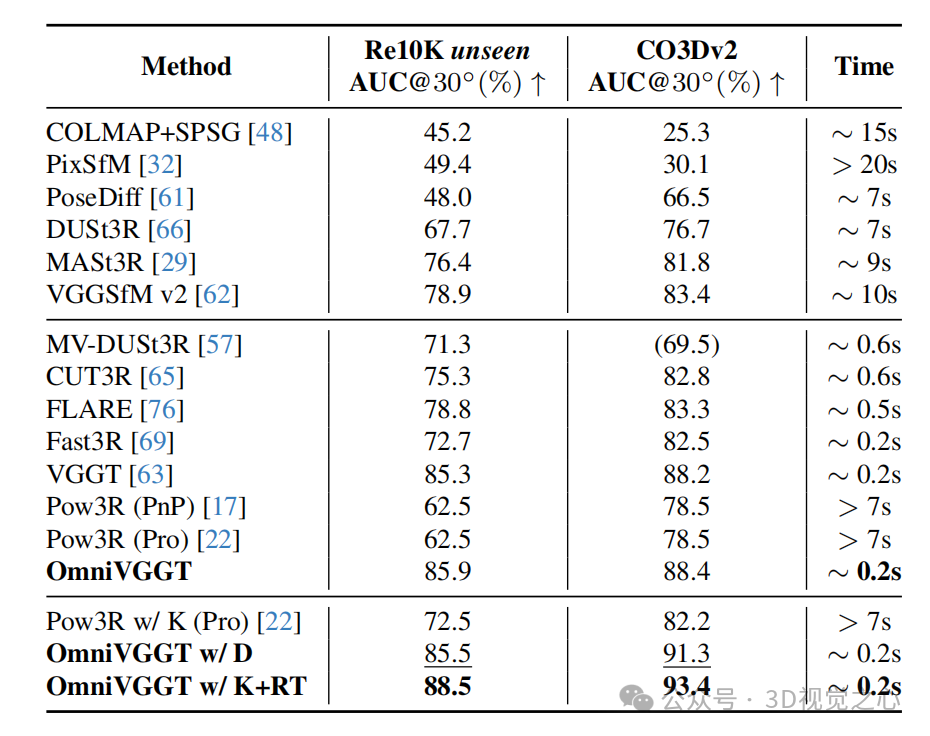

表4:相机位姿估计(RealEstate10K、CO3Dv2数据集)

表4:相机位姿估计(RealEstate10K、CO3Dv2数据集)

速度和精度双领先:

纯RGB输入:RealEstate10K的AUC@30°达85.9%,比VGGT高0.6个百分点;

加相机参数:CO3Dv2的AUC@30°达93.4%,远超Pow3R的82.2%;

速度:OmniVGGT仅需0.2秒,比Pow3R快30倍以上。

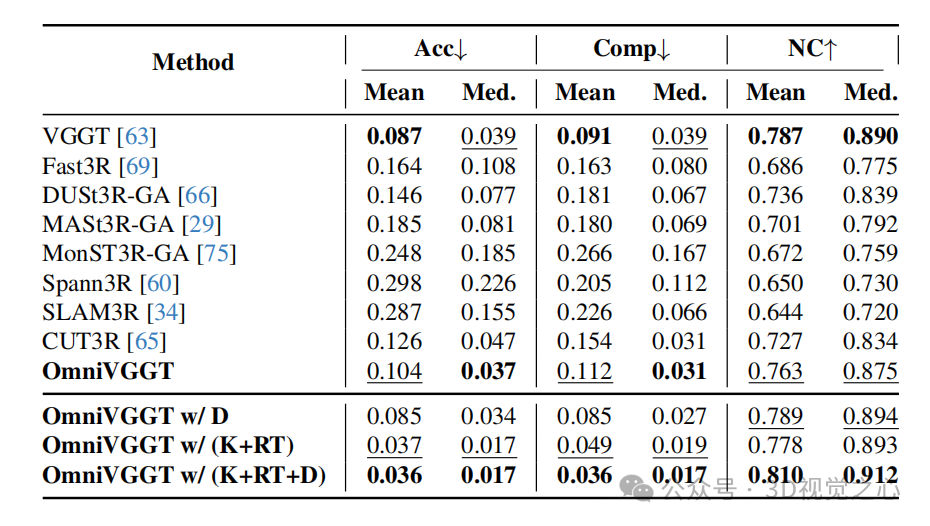

表5:3D重建(7-Scenes数据集)

表5:3D重建(7-Scenes数据集)

稀疏视图场景表现惊人:

纯RGB输入:精度(Acc)0.104,和VGGT相当;

加100%相机参数:Acc降至0.037,比纯RGB提升64.4%;

加相机+深度信息:Acc仅0.036,完整性(Comp)0.036,正常一致性(NC)0.912,全面领先所有基线。

图4:7-Scenes等数据集的视觉对比

图4:7-Scenes等数据集的视觉对比

这张图展示了极端场景的表现:即使图像几乎无重叠,OmniVGGT加辅助信息后也能保持准确的空间关系和几何一致性,重建效果比其他方法更逼真。

表6:机器人操作任务(CALVIN数据集)

表6:机器人操作任务(CALVIN数据集)

集成到VLA模型后效果显著:

加深度信息:ABCD→D任务的平均连续完成数(Avg.Len.)达4.08,比基于点云的基线高0.04;

纯RGB输入:零样本场景的Avg.Len.达3.92,比Kosmos-VLA基线高0.43,证明学到的空间表示更鲁棒。

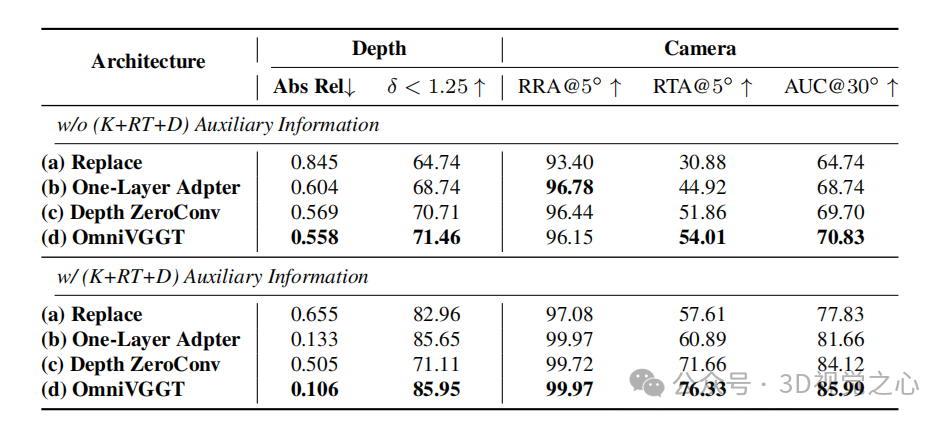

表7:GeoAdapter架构消融实验

表7:GeoAdapter架构消融实验

验证了核心设计的有效性:

直接替换相机令牌(Replace):性能最差,破坏了原有特征;

单层适配器(One-Layer Adapter):无法充分利用辅助信息,效果不如OmniVGGT;

深度加零卷积(Depth ZeroConv):把深度信息当噪声,性能下降;

完整OmniVGGT:各项指标最优,证明零卷积注入相机信息、直接注入深度信息的设计最合理。

四、总结:3D基础模型的“全能辅助”

OmniVGGT的核心价值在于“灵活”和“兼容”:

输入灵活:任意数量、任意组合的辅助几何模态都能利用;

性能强大:纯RGB输入比现有方法好,加辅助信息后更是全面顶尖;

实用高效:计算开销小,推理速度快,还能无缝集成到VLA模型,提升机器人任务性能。

未来可以扩展到更复杂的动态场景,进一步挖掘多模态融合的潜力,让3D基础模型更适应真实世界的多样输入。

【3D视觉&具身智能】技术交流群

我们创办了3D与具身智能、机器人相关的社群!聚焦三维重建、Nerf、点云处理、SLAM、多传感器标定、多传感器融合、摄影几何、VLA、视觉语言导航、强化学习、具身大小脑、机器人本体、sim2real、求职交流等方向。扫码添加小助理微信邀请入群,备注:学校/公司+方向+昵称(快速入群方式)

扫码添加小助理进群

【具身智能之心】知识星球

具身智能之心知识星球是国内首个具身智能开发者社区,也是最专业最大的交流平台,近2000人。主要关注具身智能相关的数据集、开源项目、具身仿真平台、VLA、VLN、Diffusion Policy、强化学习、具身智能感知定位、机器臂抓取、姿态估计、策略学习、轮式+机械臂、双足机器人、四足机器人、大模型部署、端到端、规划控制等方向。星球内部为大家汇总了近40+开源项目、近60+具身智能相关数据集、行业主流具身仿真平台、各类学习路线等,涉及当前具身所有主流方向。

扫码加入星球,享受以下专有服务:

1. 第一时间掌握具身智能相关的学术进展、工业落地应用;

2. 和行业大佬一起交流工作与求职相关的问题;

3. 优良的学习交流环境,能结识更多同行业的伙伴;

4. 具身智能相关工作岗位推荐,第一时间对接企业;

5. 行业机会挖掘,投资与项目对接;

5万+

5万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?