让我们先来看两段视频:

世界模型自提出以来,一直被视为理解世界更本质的一种方式,因此获得了非常广泛的研究。世界模型是一种生成式的方法,但在自动驾驶的场景理解中,纯生成的方法一直没有得到广泛的应用。

现有生成的方法主要聚焦于生成多样化、真实的的驾驶视频;然而由于3D一致性有限且视角覆盖稀疏,这些方法难以支持便捷、高质量的新视角合成。与之相反,近年来的3D/4D重建方法虽大幅提升了真实驾驶场景的重建效果,却天生缺乏生成新视角能力。

所以一种可能的方式是利用生成+重建结合的形式,来建模自动驾驶场景。3DGS用于重建原始场景,生成方法用于优化新视角,两者强强联合以构建自动驾驶中的世界模型。

为解决场景生成与重建之间的这一困境,南开大学&小米汽车的团队提出了WorldSplat——一种用于4D驾驶场景生成的全新前馈式框架。该方法通过两个关键步骤高效生成具有一致性的多轨迹视频:(1)引入融合多模态信息的4D感知潜在扩散模型,以前馈方式生成像素对齐的4D高斯分布;(2)利用增强型视频扩散模型,对基于这些高斯分布渲染的新视角视频进行优化。在基准数据集上开展的大量实验表明,WorldSplat能够有效生成高保真、具备时空一致性的多轨迹新视角驾驶视频。

项目主页:https://wm-research.github.io/worldsplat/

论文链接:https://arxiv.org/abs/2509.23402

一、背景回顾

生成视角可控的真实驾驶场景视频是自动驾驶与计算机视觉领域的核心挑战,对实现可扩展训练与闭环评估至关重要。近年来的生成模型在高保真、用户自定义视频生成方面取得了进展,降低了对昂贵真实数据的依赖。与此同时,城市场景重建方法也优化了3D表示与一致性新视角合成效果。

尽管技术不断进步,生成方法与重建方法仍面临“未知环境创建”与“新视角合成”之间的困境。现有视频生成模型在2D图像域工作,往往缺乏3D一致性和新视角可控性:从某个角度看可能合理,但从新视角生成时却无法保持连贯性。而场景重建方法虽能从已记录的驾驶日志中实现高精度3D一致性与照片级真实感的新视角合成,却缺乏生成灵活性,无法对超出已捕获数据范围的场景进行想象式生成。尽管“先视频生成、后重建”的思路具有可行性,但最终新视角的质量仍会受到两个过程的双重制约。因此,如何将“生成式想象”与“忠实的4D重建”相结合,仍是一个待解决的挑战。

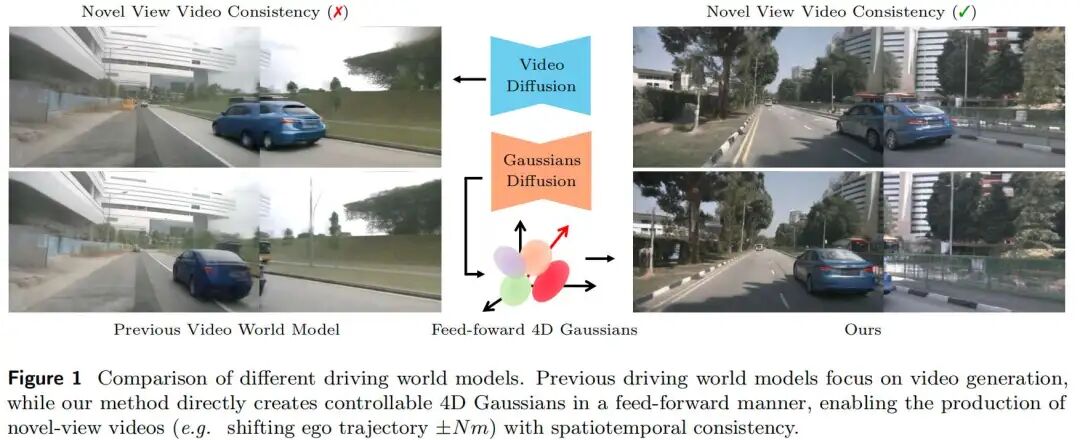

为应对上述挑战,本文提出WorldSplat——一种将生成式扩散与显式3D重建相融合的前馈式框架,用于4D驾驶场景合成。该框架构建动态4D高斯表示,并能沿任意用户定义的相机轨迹渲染新视角,无需进行逐场景优化。通过在扩散模型中嵌入3D感知能力,并采用以高斯分布为核心的显式世界表示,本文方法确保了跨新轨迹视角的时空一致性。如图1所示,以往的驾驶世界模型虽能生成真实视频,但由于其随机性,在合成新视角序列时往往会失去连贯性;与之相反,WorldSplat通过单次前向传播直接输出4D高斯场,能够实现稳定、一致的新视角渲染。为实现灵活的生成控制,该框架支持丰富的条件输入——包括道路草图、文本描述、动态目标放置与自车轨迹,使其成为适用于多样化驾驶场景的高可控性模拟器。

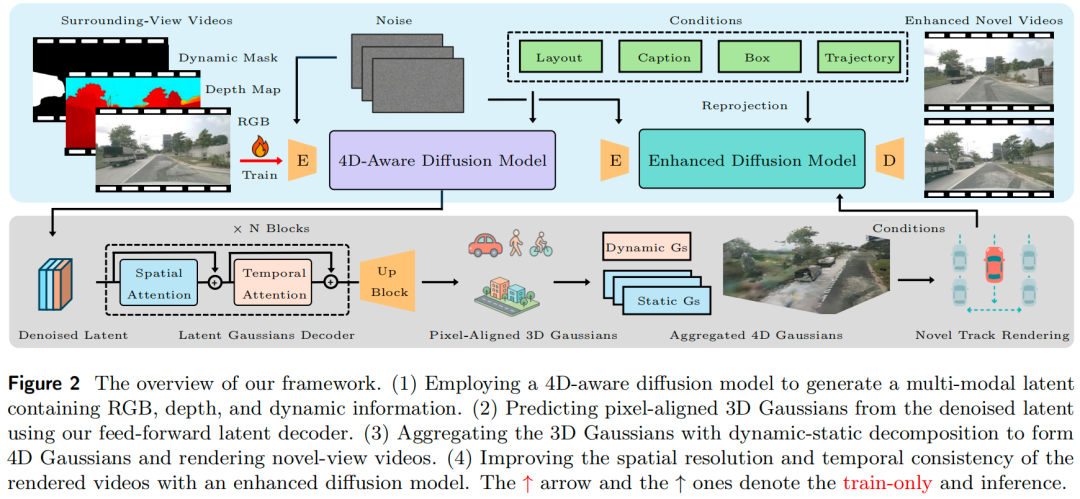

具体而言,WorldSplat的工作流程分为三个阶段:首先,不依赖真实图像或激光雷达(LiDAR)数据,仅基于灵活的用户定义控制条件,4D感知潜在扩散模型生成多视角、时间连贯的潜变量,该潜变量天生包含RGB、度量深度与语义通道,可提供兼具视觉外观与场景几何信息的视角感知3D数据。其次,潜在高斯解码器将这些潜变量转换为显式的4D高斯场景表示;具体而言,该解码器预测一组像素对齐的3D高斯分布,并将其划分为静态背景与动态目标,再聚合为统一的4D表示,从而对动态驾驶世界进行显式建模。为清晰说明,我们在图7中可视化了该表示,并认为相较于点云图,该表示为一致性新视角视频生成提供了更合适的基础。随后,我们采用快速高斯泼溅(Gaussian splatting)技术,将高斯分布投影到新的相机视角,实现具备真实几何一致性的新轨迹视频合成。最后,对渲染帧应用增强型扩散优化模型,通过修正伪影与增强细节(如纹理、光照)进一步提升真实感,最终得到高保真新视角视频。

综上,本文的主要贡献包括:

4D场景生成框架:提出WorldSplat——一种前馈式4D生成框架,将驾驶场景视频生成与显式动态场景重建相统一;

前馈式高斯解码器:设计动态感知高斯解码器,能从多模态潜变量中直接推断出精确的像素对齐3D高斯分布,并通过静-动态分解将其聚合为4D高斯表示;

全面评估:大量实验表明,本文框架能生成具备时空一致性的自由视角视频,在驾驶视频生成任务中实现当前最优性能,并为下游驾驶任务提供显著增益。

二、算法详解

概述

如图2所示,我们的框架包含三个关键模块:用于多模态潜变量生成的4D感知潜在扩散模型、用于前馈式4D高斯预测及实时轨迹渲染的潜在高斯解码器,以及用于视频质量优化的增强型扩散模型。这三个模块独立训练,其架构与训练流程将后续章节中详细说明。最后阐述如何整合这些模块,以生成高保真、具备时空一致性的视频。

4D感知潜在扩散模型

给定噪声潜变量与细粒度条件(即边界框、道路草图、文本描述及自车轨迹),4D感知潜在扩散模型通过去噪生成包含RGB、深度与动态目标信息的多模态潜变量,这些潜变量随后用于4D高斯预测。下文将详细阐述潜变量、控制条件、模型架构及训练策略。

多模态潜变量融合

对于一段包含T帧的K视角驾驶视频片段 ,我们首先利用预训练变分自编码器(VAE)编码器提取多视角图像潜变量 。接着,通过基础深度估计器(Hu et al., 2024)生成度量深度图D,将其归一化至 范围并复制到三个通道,再编码为深度潜变量 。已有研究表明,融入深度潜变量可同时提升3D重建与生成质量。为进一步分离静态与动态目标以实现4D场景重建,我们从动态类别目标的二值分割掩码中,利用SegFormer提取语义掩码潜变量 。最终,将这三个潜变量在通道维度上拼接,形成解码器输入

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

94

94

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?