点击下方卡片,关注“3D视觉之心”公众号

第一时间获取3D视觉干货

>>点击进入→3D视觉之心技术交流群

避免传感器配置差异

近年来,多模态传感器融合的新进展推动了自动驾驶应用中感知方法的发展。这些进展涵盖了 3D 目标检测、在线地图生成与推理、占用预测,以及端到端框架的形式。在这些任务和真实场景中已经取得了最先进的成果,然而,要实现传感器和平台的泛化仍然面临显著挑战。

例如,在 NuScenes (NUSC) 数据集上训练的感知模型很难直接泛化到其他传感器和平台配置(如 Waymo Open 或 Argoverse 2 数据集)。传感器配置可能在相机和激光雷达的数量、在车辆上的位置、方向,以及相机焦距和视场等内参属性上存在差异。研究表明,传感器配置的不同会导致 3D 感知任务(如检测、分割和建图)的性能下降。尽管还有其他领域间差距需要探索,实现跨传感器配置的泛化仍然是一个重要挑战,这也限制了可用于开发的数据量。在最坏的情况下,当传感器设置变化时,必须重新收集和标注数据集来重新训练或微调深度学习架构,这导致了跨车辆类型(如轿车、SUV 和卡车)模型部署的开发过程变得冗长。

近期的研究开始通过两种主要途径来解决传感器泛化问题:基于模型的方法和基于数据的方法。从模型的角度来看,一些方法尝试在问题建模或架构中直接引入与传感器无关的特性。而基于数据的方法则专注于对齐相机参数或应用数据再生成技术。尽管取得了一些有希望的成果,利用真实数据为全景在线高清地图生成开发通用策略仍然是一个开放性问题。

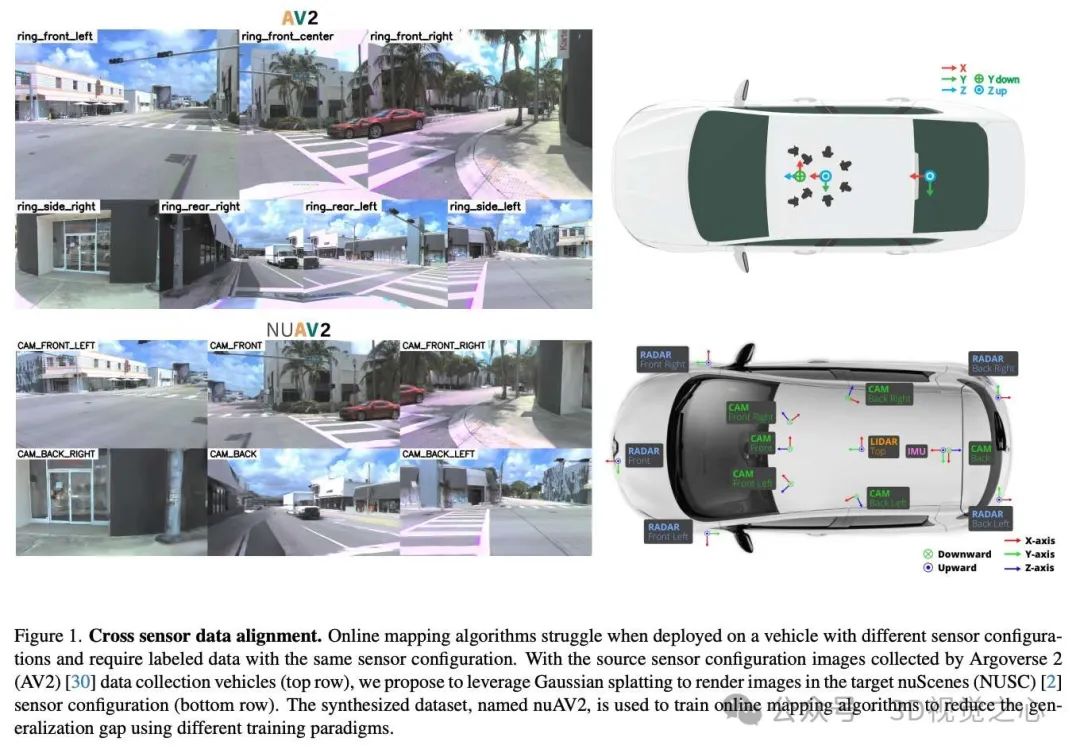

本文介绍的MapGS[1]是一种基于高斯点云渲染 (Gaussian Splatting) 的数据驱动方法,用于场景重建和新视图合成,旨在减少 3D 在线建图算法中的传感器配置差异。该方法包括一套适用于新定制配置的数据再生成方案,其中高斯点云渲染用于重建静态和动态场景。我们将这一方法扩展到 Argoverse 2 数据集,生成新的目标传感器配置相机数据 (nuScenes 配置)。实验结果表明,该方法增强了泛化能力,提高了数据和训练效率,并为全景在线建图实现了数据的可重用性。

仓库链接:https://henryzhangzhy.github.io/mapgs/

主要贡献:

提出了一种基于高斯点云渲染的方案,用于场景重建和新视图渲染,以减少 3D 在线建图算法中的传感器配置差异。

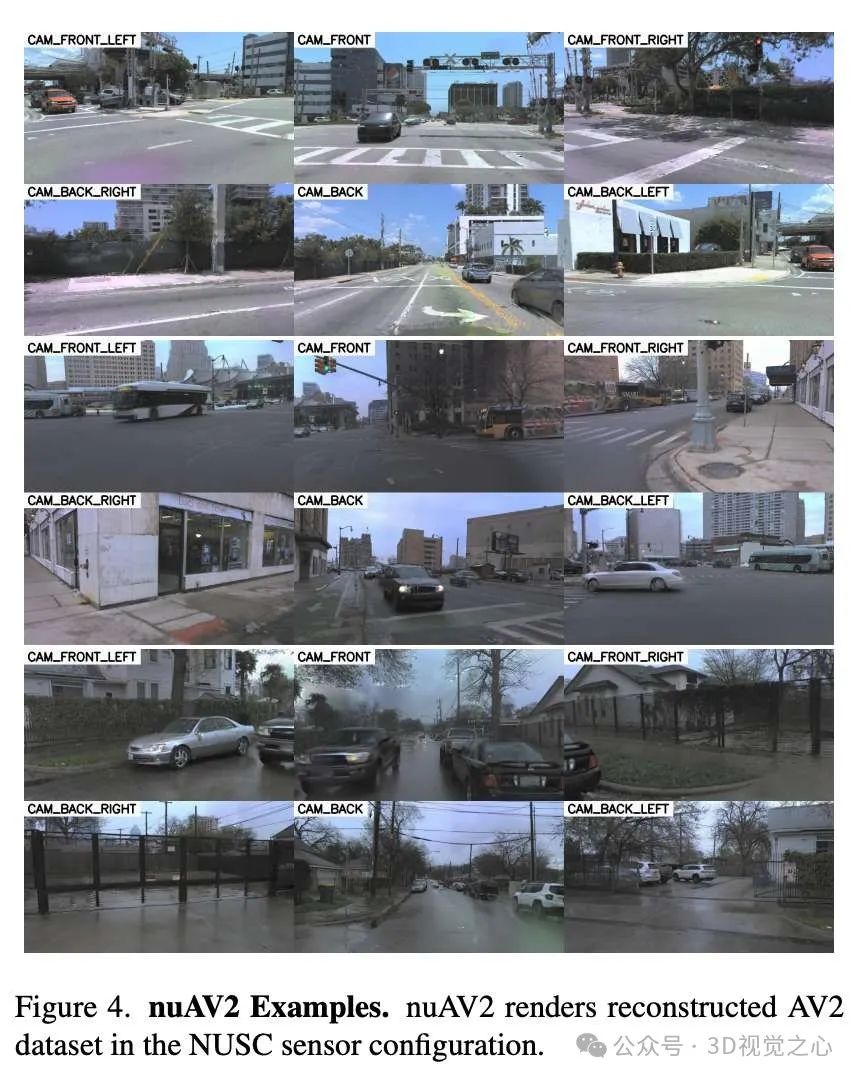

提出了新视图合成和数据再生成的方案,构建了名为 nuAV2 的新数据集,该数据集通过重建 Argoverse 2 数据集的场景并生成 nuScenes 传感器配置的相机数据生成而成。我们计划公开代码和数据。

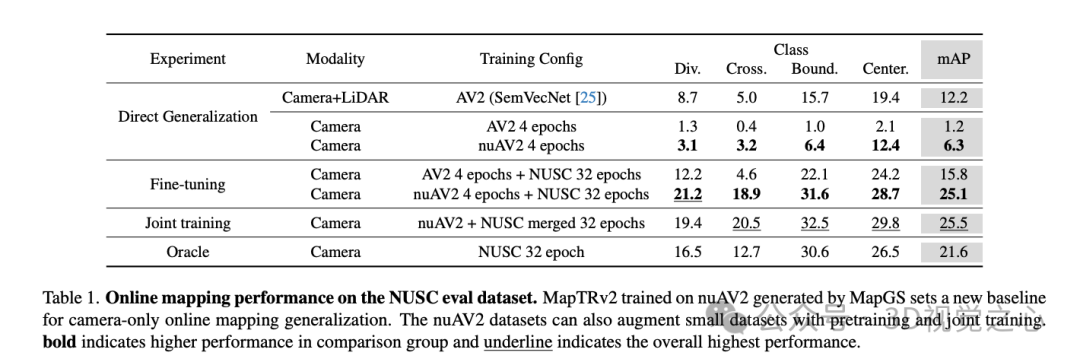

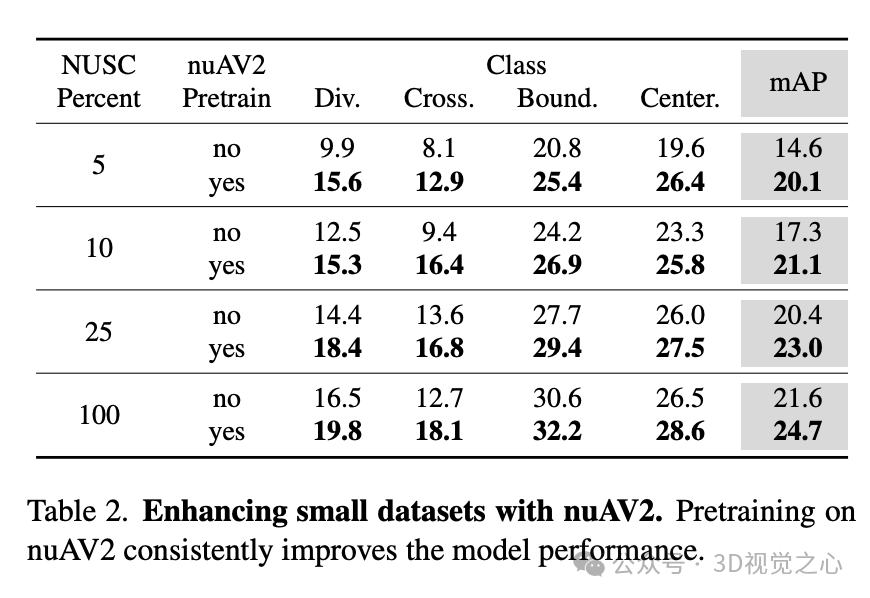

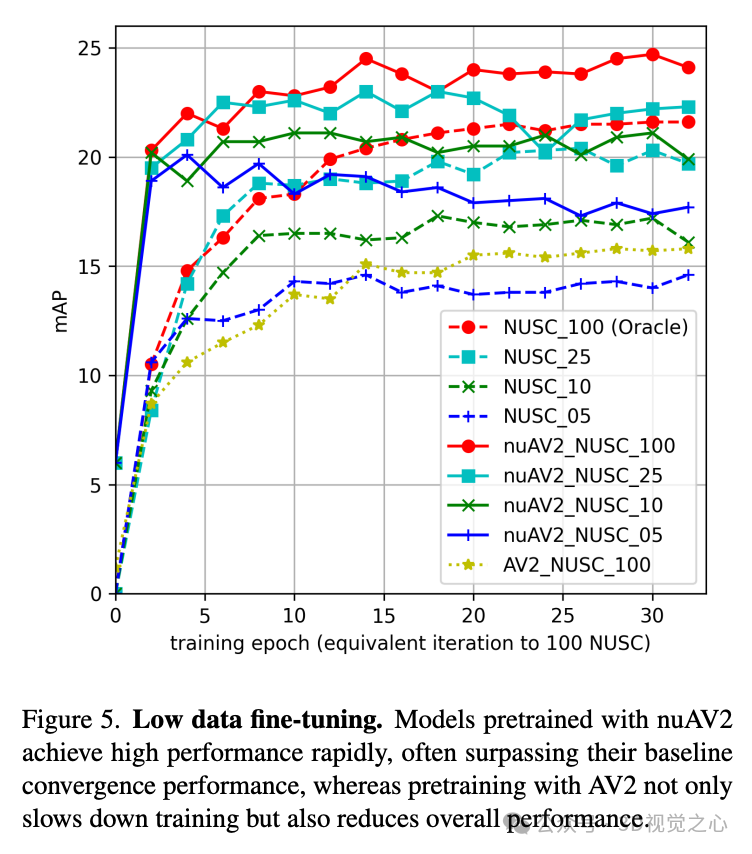

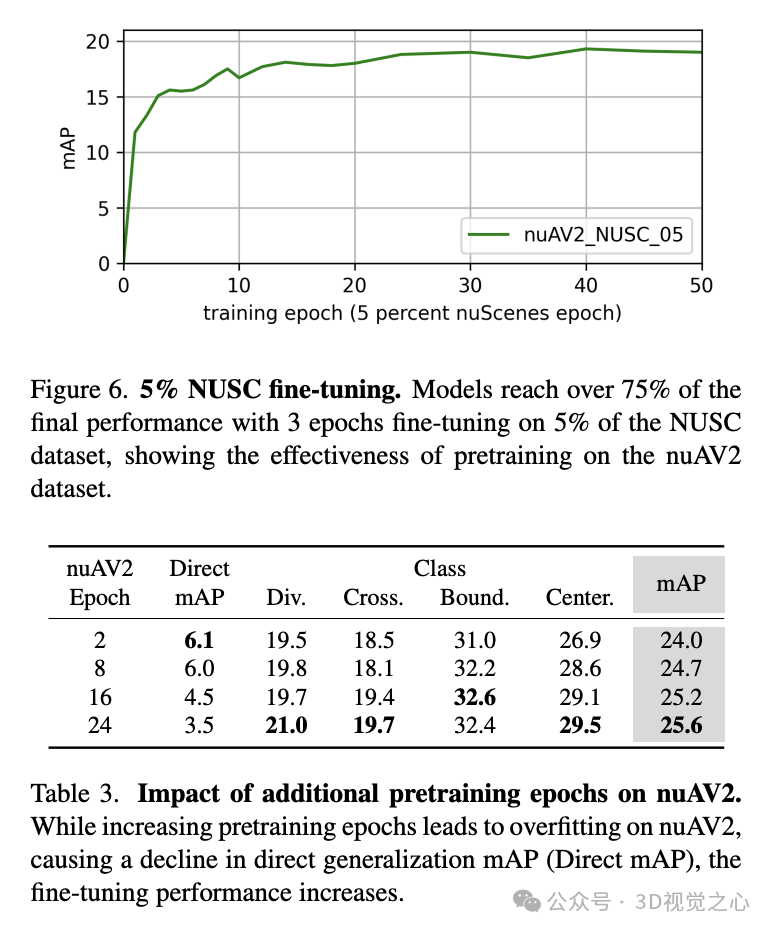

提供了三大关键性能与效率收益:i)通过有效的数据增强提高了泛化能力,性能提升 18%;ii)训练更加高效且收敛更快;iii)在仅使用原始目标传感器配置训练数据 25% 的情况下,性能超越当前最先进水平。

具体方法

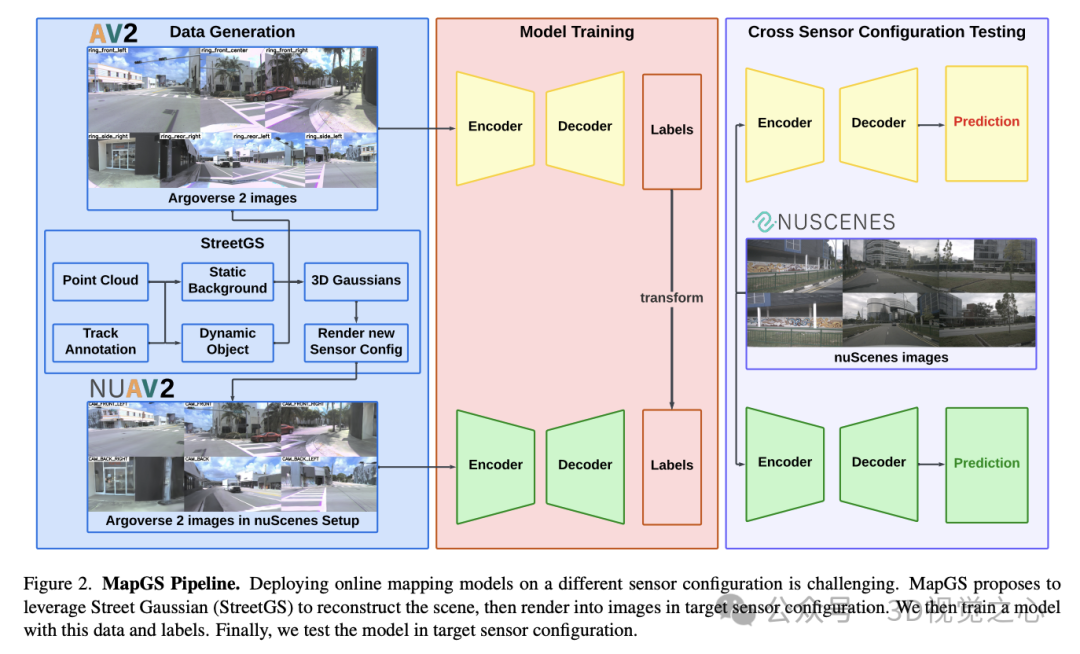

将在线建图算法泛化到不同的传感器配置是一个具有挑战性的问题。我们提出了一种新的范式,通过使用高斯点云渲染 (Gaussian Splatting) 技术,在不同的传感器配置下生成数据,以减少泛化差距。如图 2 所示,对于一个自动驾驶数据集,我们首先使用现有的传感器数据通过高斯点云渲染重建场景,然后渲染目标传感器配置下的图像并映射标签,最后将生成的数据作为训练协议的一部分。

场景重建

我们首先处理传感器数据中的原始图像 (I_S),并重建场景 (G)。传统的 3D 高斯点云渲染方法需要大量图像来完成场景重建。面对动态对象、开放环境和视角同质性等挑战时,重建自动驾驶场景变得非常困难。我们基于 Street Gaussian (StreetGS) 方法,通过利用标注轨迹和点云的先验知识来重建室外场景。先验约束优化过程,并生成高质量的新视图。

StreetGS 将场景分为静态背景 (B) 和动态车辆 (D),依据标注的轨迹对点云进行处理。首先过滤出激光雷达点云中的目标框内点,仅保留其他点以初始化静态背景 (B)。动态车辆被视为沿轨迹移动的静态物体,因此会将每个轨迹内的点云裁剪并聚合到一个单独的框中,以初始化动态物体的 3D 高斯模型。此外,还定义了天空嵌入 (S),用于捕捉天空和远处的物体。

在优化过程中,动态物体的 3D 高斯模型会根据轨迹变换到对应的目标框位置。通过训练相机视角,静态背景、高斯模型和天空会被光栅化以渲染图像。随后,将渲染图像与真实图像进行比较,优化 3D 高斯模型和天空的表示。为了防止生成虚假的效果,会向真实图像添加自车遮罩,以屏蔽自车区域。

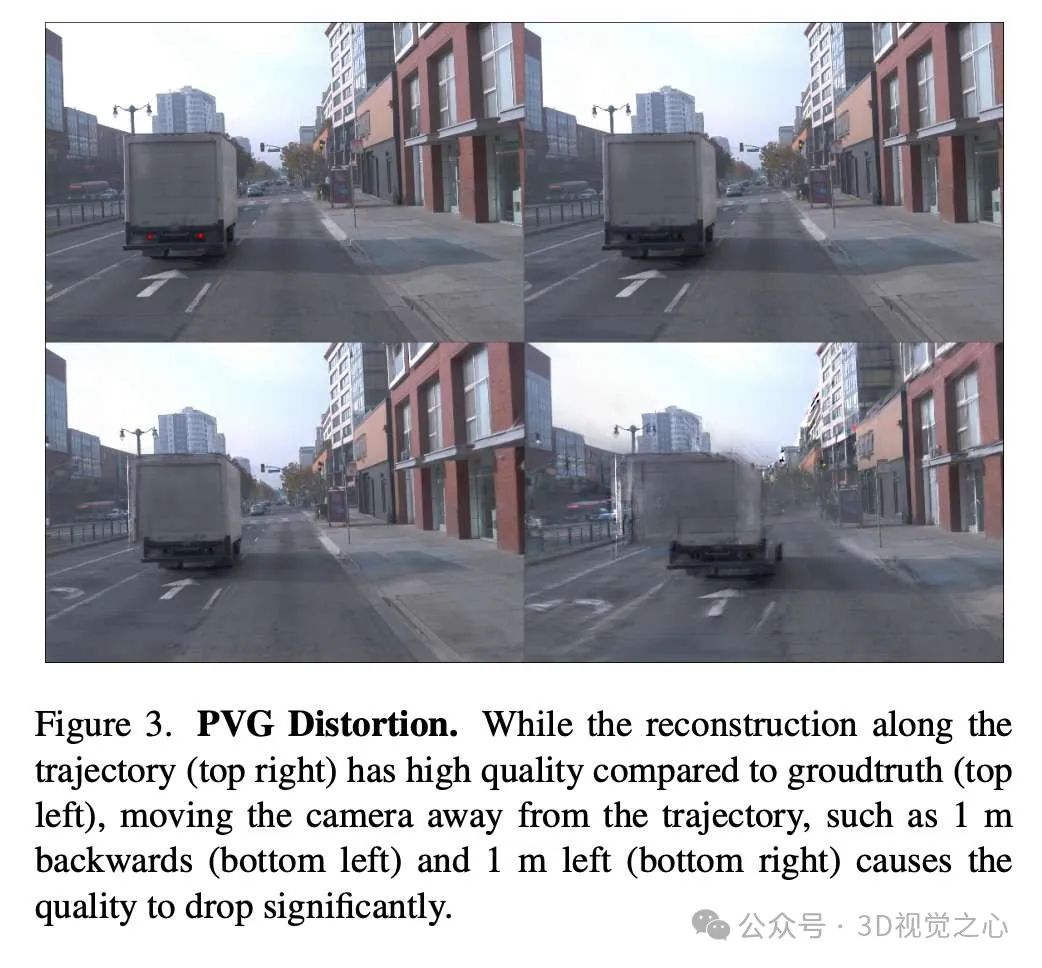

这种方法利用先验知识来优化动态场景,使其表现类似静态场景,同时避免引入额外的时间参数。该方法在视角发生显著变化时减少了因过拟合导致的失真。

目标配置数据生成

在重建的场景 (G) 中,我们渲染目标配置下的图像,记为 (I_T)。该过程尝试在场景中模拟目标车辆行驶时的图像视角。

给定源车辆的位姿 (G_T^{VS}) (时间 (t))、目标相机到车辆的变换 (V_T^{TC})、以及目标车辆到源车辆的变换 (V_S^{VT}),目标车辆的位姿可表示为:[ G_T^{VT} = G_T^{VS} V_S^{VT} ]

目标相机的位姿则定义为:[ G_T^{CT} = G_T^{VT} V_T^{TC} ]

结合目标相机的内参矩阵 (K_T),我们可以渲染目标传感器配置下的图像。此外,还将地图标签转换到新的传感器配置中,用于以自车为中心的建图训练与评估。

在线建图

我们仅关注地图元素的几何信息,而不考虑近期流行的拓扑推理。我们采用 MapTRv2 的相机版实现,其包含三个主要组件:特征提取器、视图变换模块和矢量地图解码器。

特征提取器:将环视图图像 (I) 输入,提取透视视角特征 (F_{PV})。

视图变换模块:将透视视角特征投影为鸟瞰视角特征 (F_{BEV})。

矢量地图解码器:通过 Deformable DETR 解码器,从鸟瞰视角特征中解码矢量地图元素。

这种方法专注于几何表示,并有效地利用了高斯点云渲染生成的数据进行训练,支持不同传感器配置下的在线建图任务。

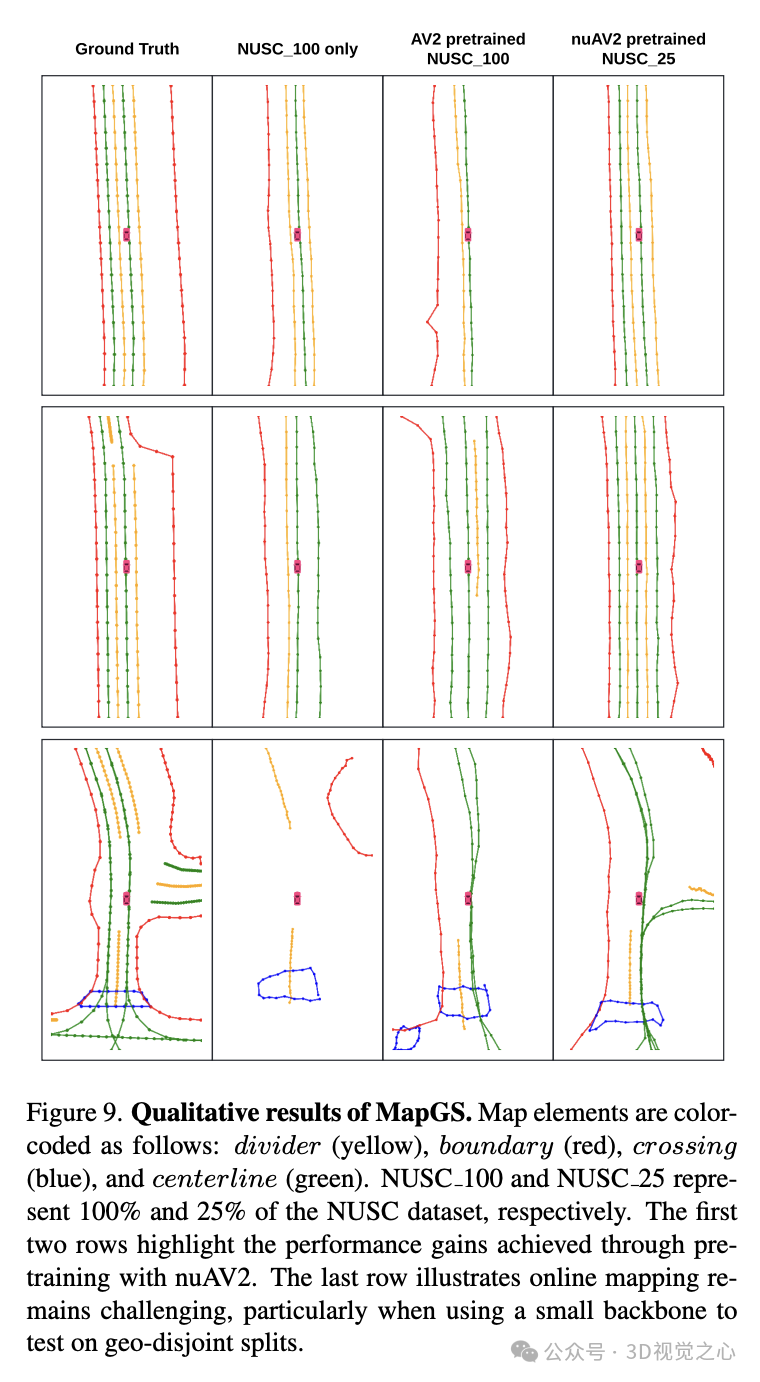

实验效果

总结一下

MapGS 框架专为应对特定传感器配置下在线建图模型训练中数据不足的问题。MapGS 利用高斯点云渲染重建场景,并渲染目标传感器配置视图的图像。通过这项工作,提出了一种数据再生成的方案,并引入了 nuAV2 数据集,将 Argoverse 2 数据集的图像转换为 nuScenes 数据集视图,用于训练。我们证明了该方法可以缩小传感器配置之间的差距。此外,它是一种有效的数据增强技术,能够在在线建图任务中实现预训练或联合训练。

参考

[1] MapGS: Generalizable Pretraining and Data Augmentation for Online Mapping via Novel View Synthesis

本文仅做学术分享,论文汇总于『3D视觉之心知识星球』,欢迎加入交流!

【3D视觉之心】技术交流群

3D视觉之心是面向3D视觉感知方向相关的交流社区,由业内顶尖的3D视觉团队创办!聚焦三维重建、Nerf、点云处理、视觉SLAM、激光SLAM、多传感器标定、多传感器融合、深度估计、摄影几何、求职交流等方向。扫码添加小助理微信邀请入群,备注:学校/公司+方向+昵称(快速入群方式)

扫码添加小助理进群

【3D视觉之心】知识星球

3D视觉之心知识星球主打3D感知全技术栈学习,星球内部形成了视觉/激光/多传感器融合SLAM、传感器标定、点云处理与重建、视觉三维重建、NeRF与Gaussian Splatting、结构光、工业视觉、高精地图等近15个全栈学习路线,每天分享干货、代码与论文,星球内嘉宾日常答疑解惑,交流工作与职场问题。

262

262

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?