作者 | Mr.Jian 编辑 | 汽车人

原文链接:https://zhuanlan.zhihu.com/p/592381828

点击下方卡片,关注“自动驾驶之心”公众号

ADAS巨卷干货,即可获取

点击进入→自动驾驶之心【目标检测】技术交流群

DETR利用object query在feature map上全局预测bbox的坐标,并借助匈牙利算法(Hungarian algorithm)完成预测bbox与gt的匹配过程,整体结构还是和Transformer类似。

接下来我们来看看从初期-中期-后期的整个训练过程中,object query预测的bbox是如何一步步在全局坐标上靠近gt。

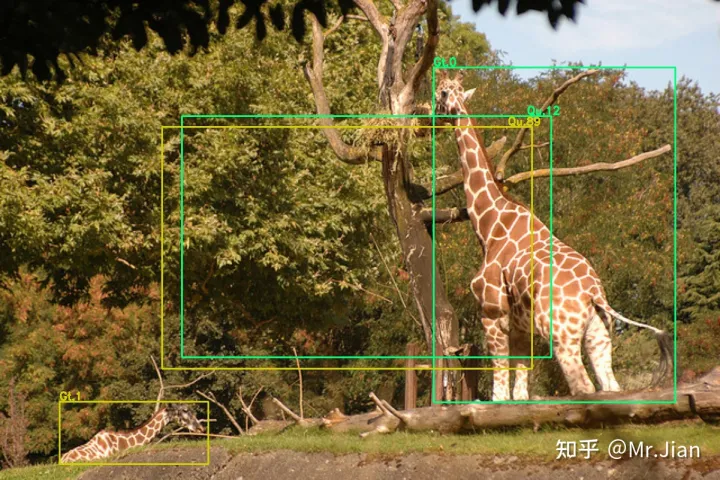

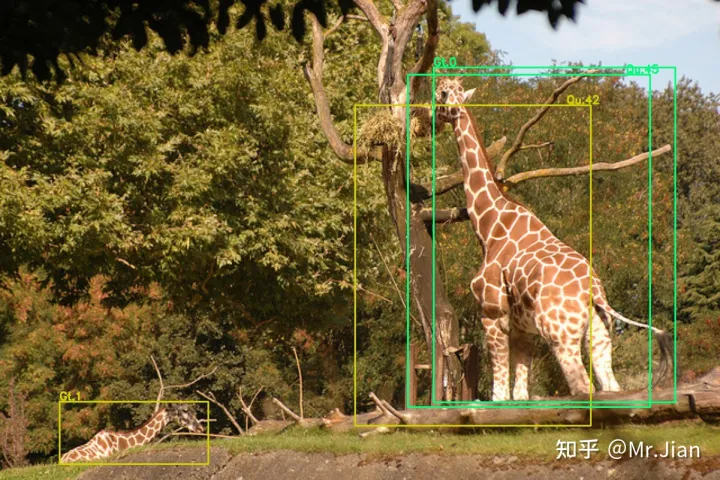

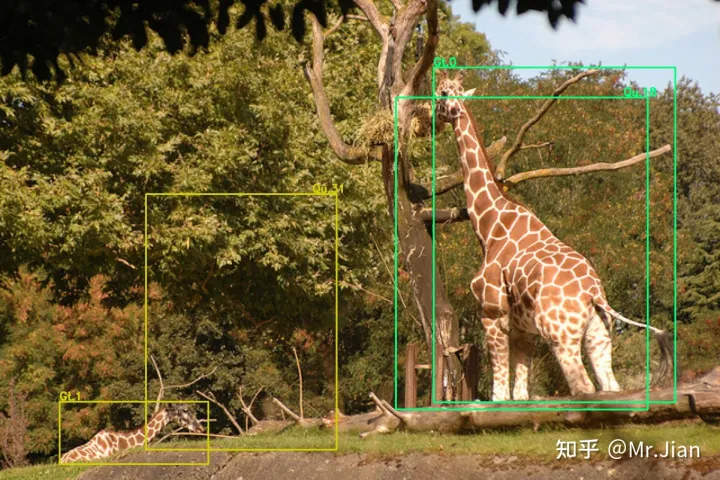

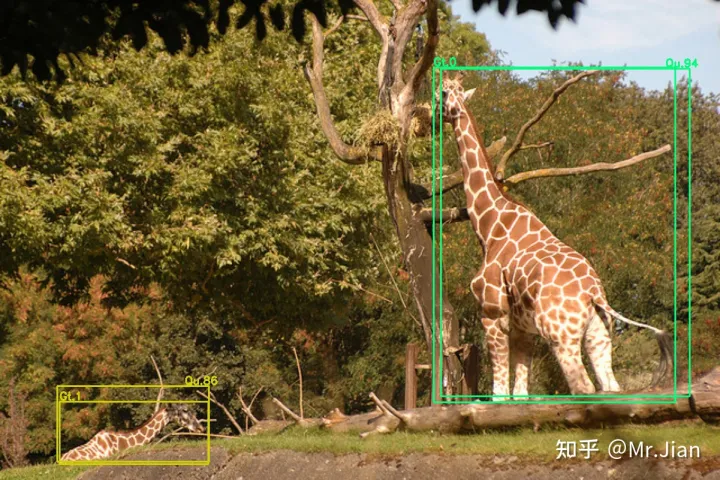

示意图含义,图像上的bbox分为两个部分,1. gt bbox,2. object query预测的pred bbox。

gt bbox:用不同颜色来表示不同的gt bbox,在gt bbox的左上角用 Gt.i 表示当前的gt bbox是第 i 个gt,i从0开始。比如 Gt.1 表示第1个gt bbox。

object query预测的pred bbox:pred bbox的颜色与gt bbox一一对应,相同颜色表示该pred bbox经过匈牙利算法匹配后负责预测这个gt bbox。在pred bbox的右上角用 Qu.i(取query的前2个字母)表示当前的pred bbox是第 i 个object query输出的。比如 Qu.34 表示当前的pred bbox是第 34 个object query输出的bbox。

先看个目标数量比较少的giraffe场景:有2只giraffe,用 Gt.0 和 Gt.1 表示。

刚初始化模型后object query输出的pred bbox,经过匈牙利算法匹配后:分别为 Qu.12 和 Qu.89 负责预测。

经过45个step后,黄色绿色的pred bbox都朝右边的长颈鹿靠近,并且由 Qu.45 和 Qu.42 负责预测。

经过80step后,黄色框的 Qu.31 开始向 Gt.1 靠近。

经过135个step后,黄色框的 Qu.86 越来越靠近 Gt.1,并且绿色框的 Qu.94 也更加接近 Gt.0 。

上面的过程用GIF图看:可以发现每个step,分别负责预测 Gt.0 和 Gt.1 的object query是不断变化的。

模型训练后期到收敛状态:分别负责预测 Gt.0 和 Gt.1 的object query变化频率很小,Gt.0 基本由 Qu.98 负责,Gt.1由 Qu.2、Qu.61、Qu.67 负责,并且pred bbox更加稳定。

训练后期,模型接近收敛

再看一个目标数量比较多的场景:多个person,和一个小目标frisbee,用 Gt.0 ~ Gt.7 表示。

模型初始化后,训练前期object query分别去找各自负责的gt bbox,对于中大目标person,object query在250个step后基本能找到,但是对于小目标frisbee,就比较难找了,会出现pred bbox在frisbee附近震荡。

训练前期

训练中后期,pred bbox在各自的gt附近晃动,负责预测小目标frisbee的object query输出的bbox开始偏向稳定,Qu.i 频繁跳动。

训练中后期

训练到收敛阶段,负责预测各个gt bbox的object query变得稳定。

训练到收敛阶段

视频课程来了!

自动驾驶之心为大家汇集了毫米波雷达视觉融合、高精地图、BEV感知、传感器标定、自动驾驶协同感知、语义分割、自动驾驶仿真、L4感知等多个方向学习视频,欢迎大家自取(扫码进入学习)

(扫码学习最新视频)

国内首个自动驾驶学习社区

近1000人的交流社区,和20+自动驾驶技术栈学习路线,想要了解更多自动驾驶感知(分类、检测、分割、关键点、车道线、3D目标检测、Occpuancy、多传感器融合、目标跟踪、光流估计、轨迹预测)、自动驾驶定位建图(SLAM、高精地图)、自动驾驶规划控制、领域技术方案、AI模型部署落地实战、行业动态、岗位发布,欢迎扫描下方二维码,加入自动驾驶之心知识星球,这是一个真正有干货的地方,与领域大佬交流入门、学习、工作、跳槽上的各类难题,日常分享论文+代码+视频,期待交流!

【自动驾驶之心】全栈技术交流群

自动驾驶之心是首个自动驾驶开发者社区,聚焦目标检测、语义分割、全景分割、实例分割、关键点检测、车道线、目标跟踪、3D目标检测、BEV感知、多传感器融合、SLAM、光流估计、深度估计、轨迹预测、高精地图、NeRF、规划控制、模型部署落地、自动驾驶仿真测试、产品经理、硬件配置、AI求职交流等方向;

添加汽车人助理微信邀请入群

备注:学校/公司+方向+昵称

2102

2102

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?