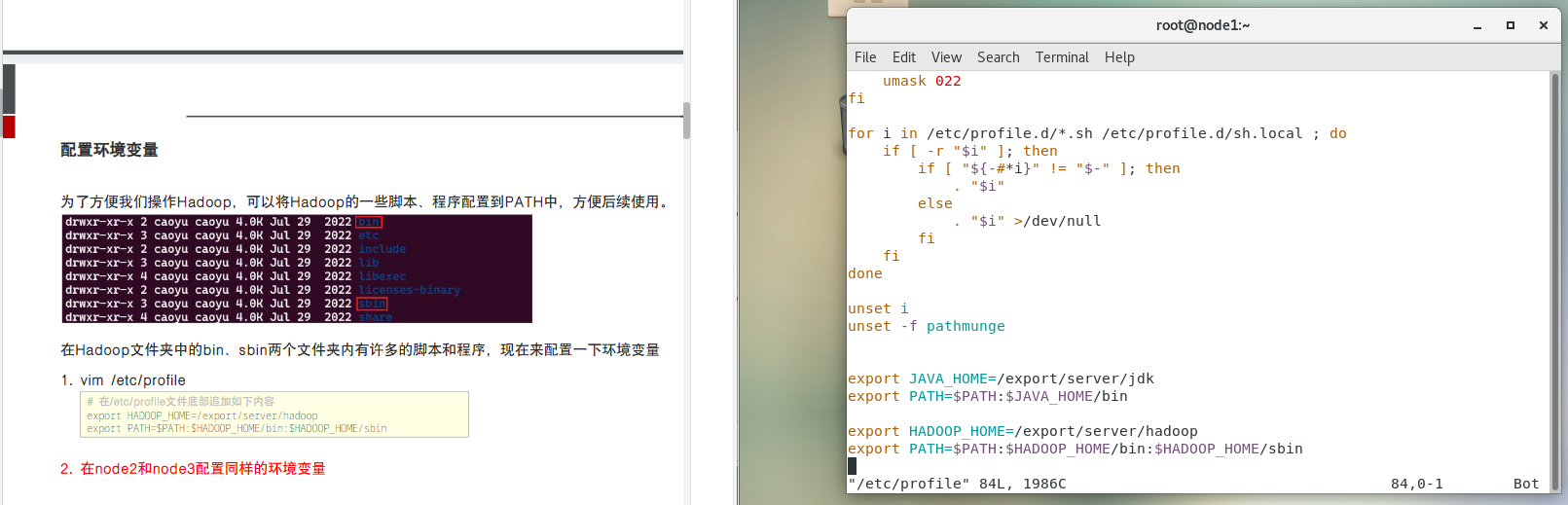

1.配置环境变量

vim /etc/profile 中配置环境变量,在/ete/profile文件底部追加如下内容:

export HADOOP_HOME=/export/server/hadoop

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

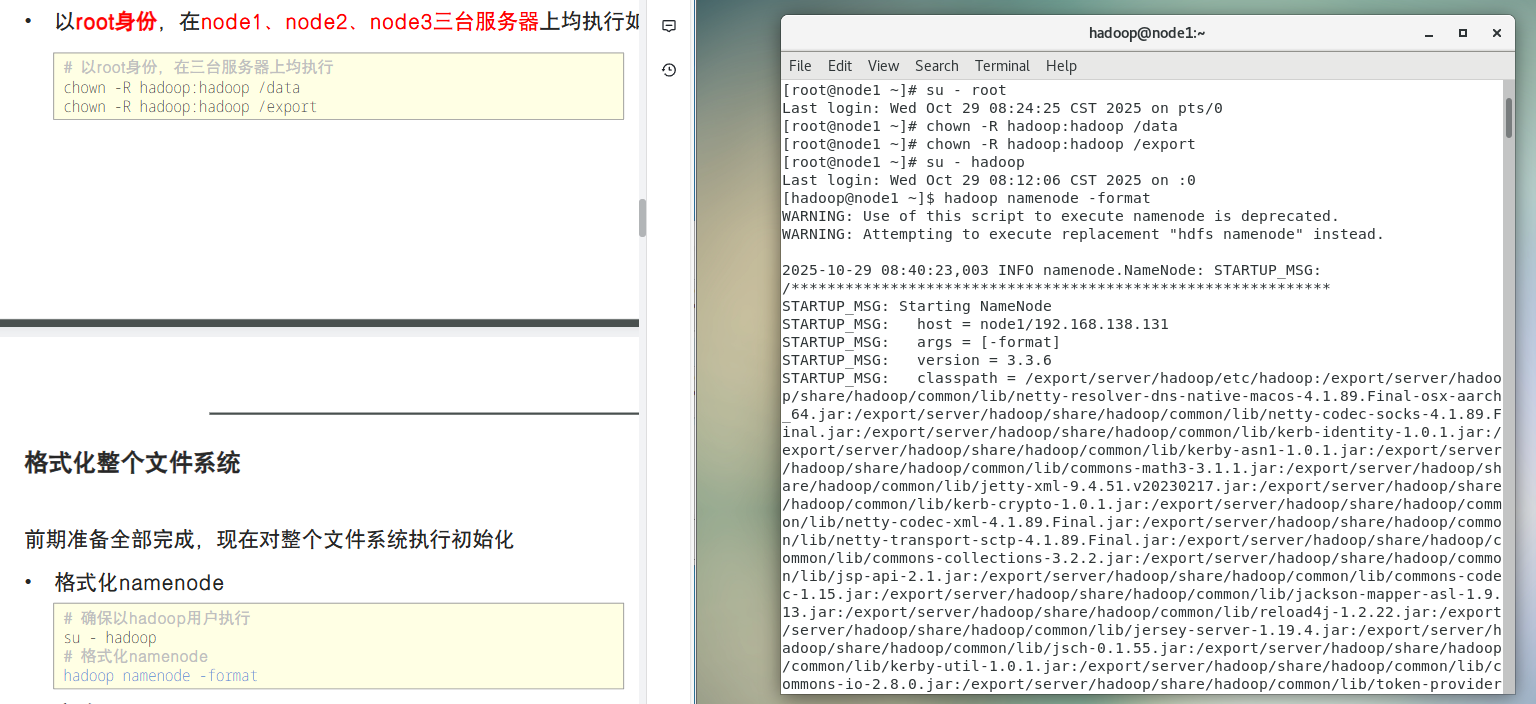

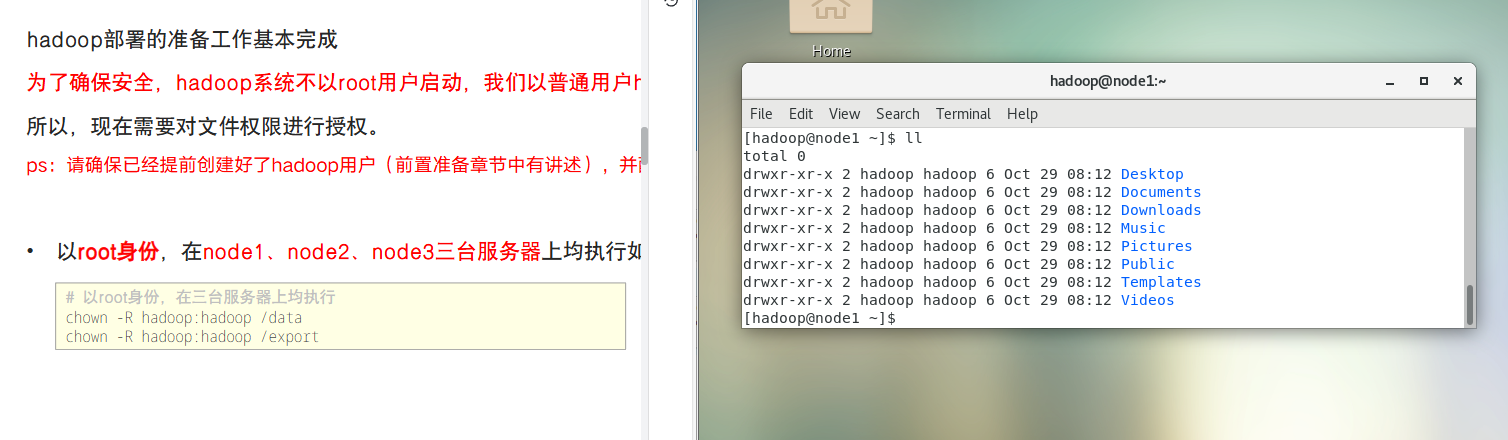

2.修改文件或目录的所有者和所属组

以root身份执行:

chown -R hadoop:hadoop /data

chown -R hadoop:hadoop /export

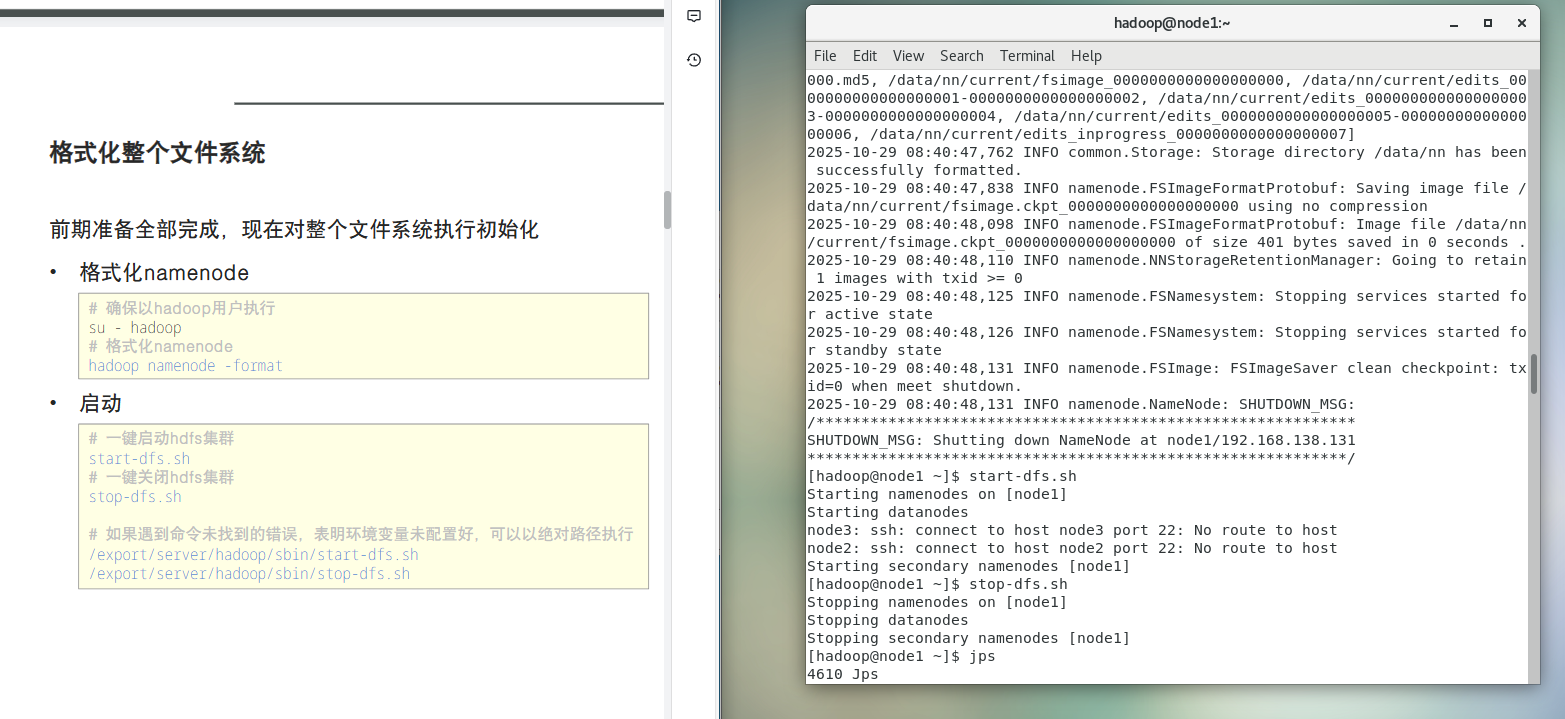

3.格式化整个文件系统,对整个文件系统执行初始化

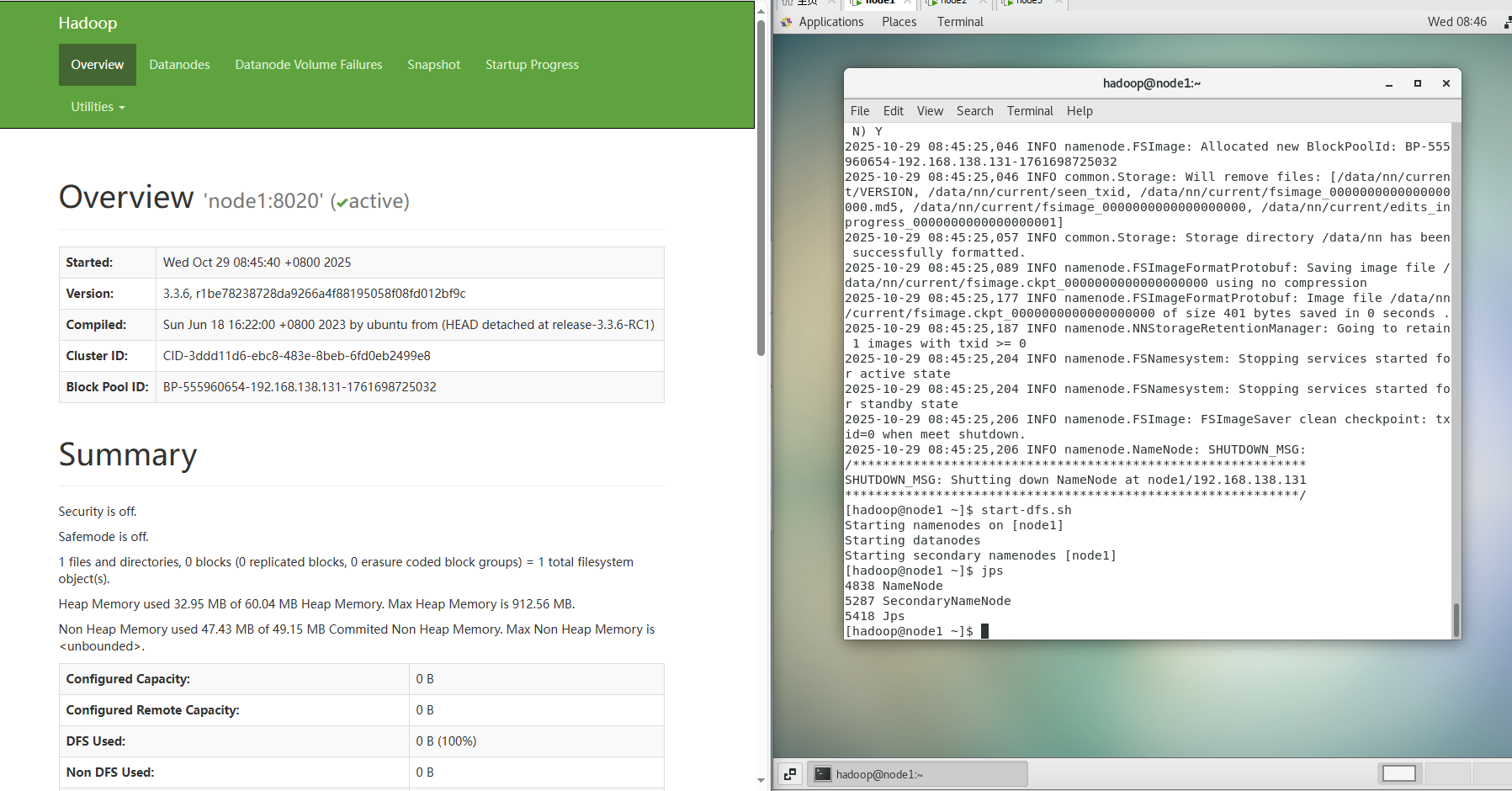

格式化namenode;启动

4.网页

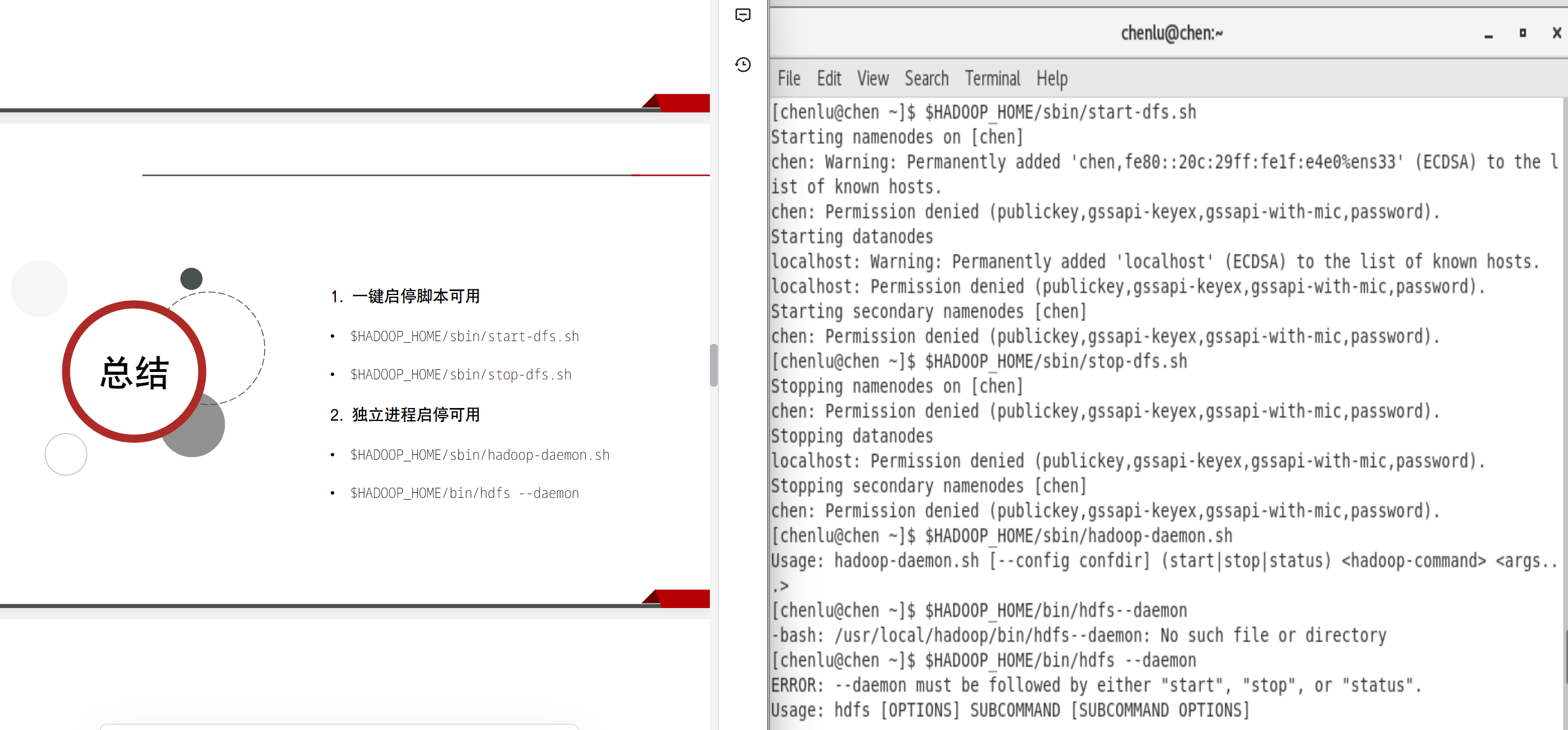

5.一键启停脚本

Hadoop HDFS组件内置了HDFS集群的一键启停脚本。

$HADOOP_HOME/sbin/start-dfs.sh,一键启动HDFS集群

$HADOOP_HOME/sbin/stop-dfs.sh,一键关闭HDFS集群

单进程启停

除了一键启停外,也可以单独控制进程的启停。

1.$HADOOP_HOME/sbin/hadoop-daemon.sh,此脚本可以单独控制所在机器的进程的启停

2.$HADOOP_HOME/bin/hdfs,此程序也可以用以单独控制所在机器的进程的启停

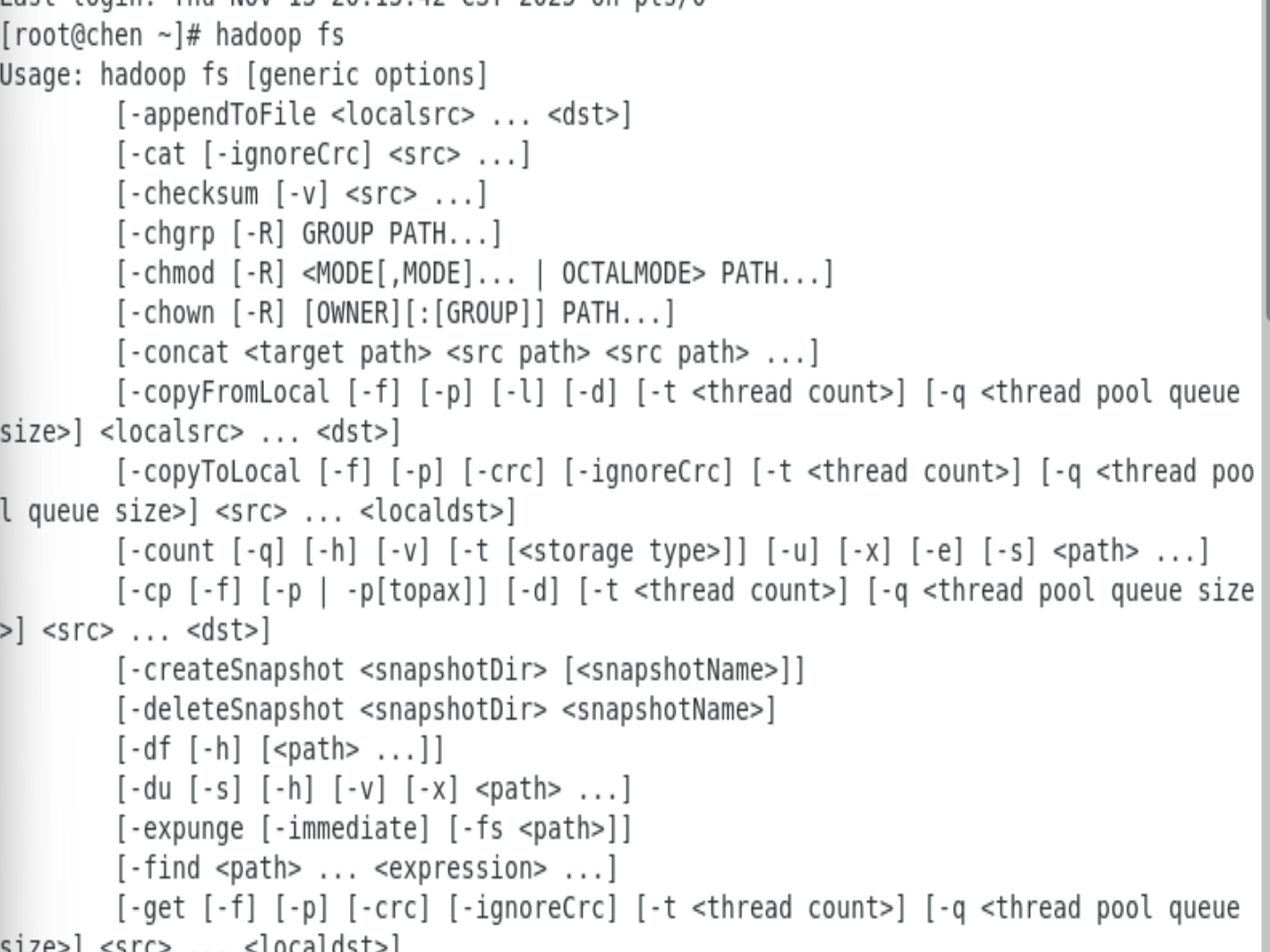

6.HDFS文件系统基本信息

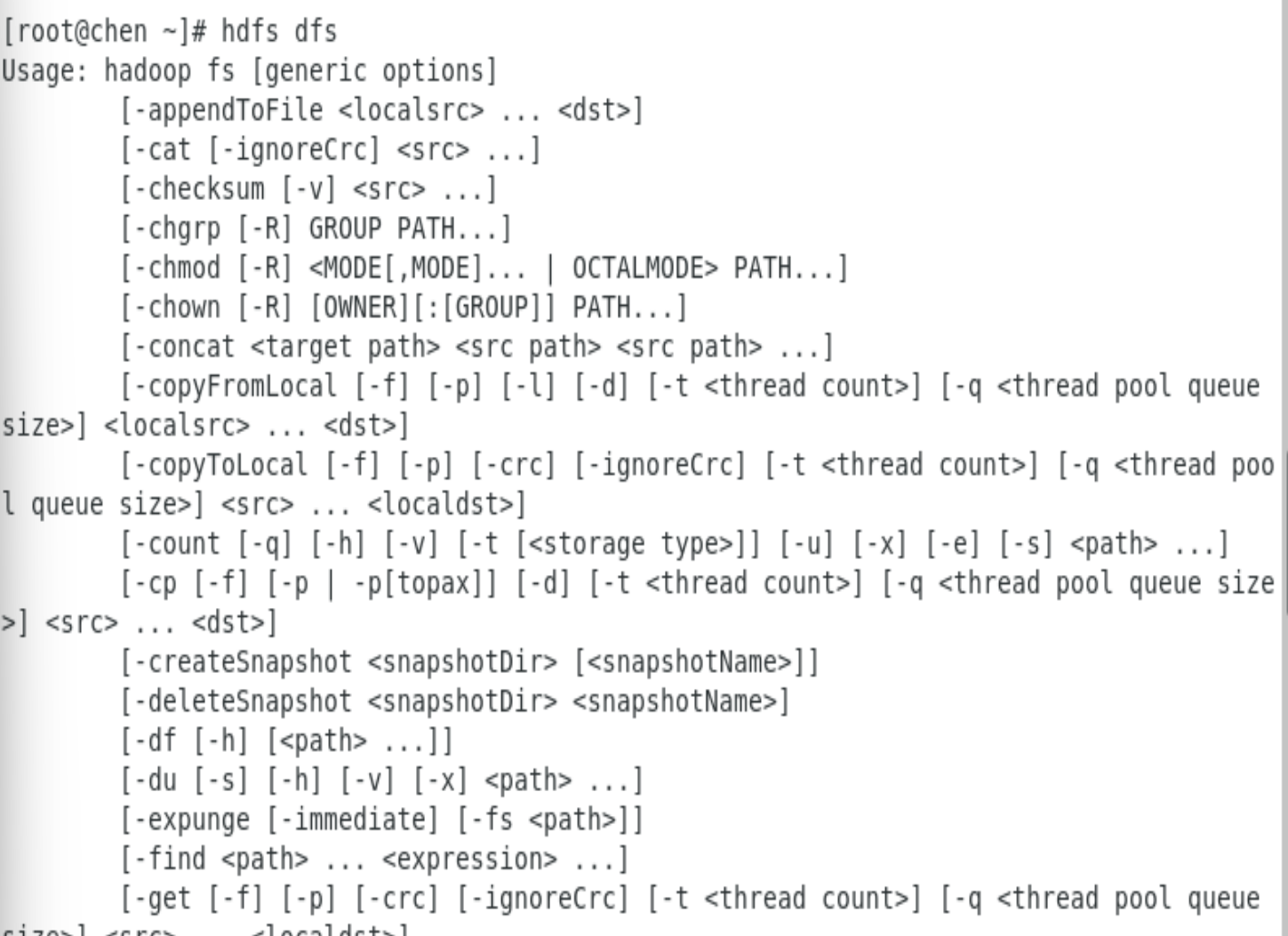

hadoop命令(老版本用法),用法:hadoop fs

hdfs命令(新版本用法),用法:hdfsd fs

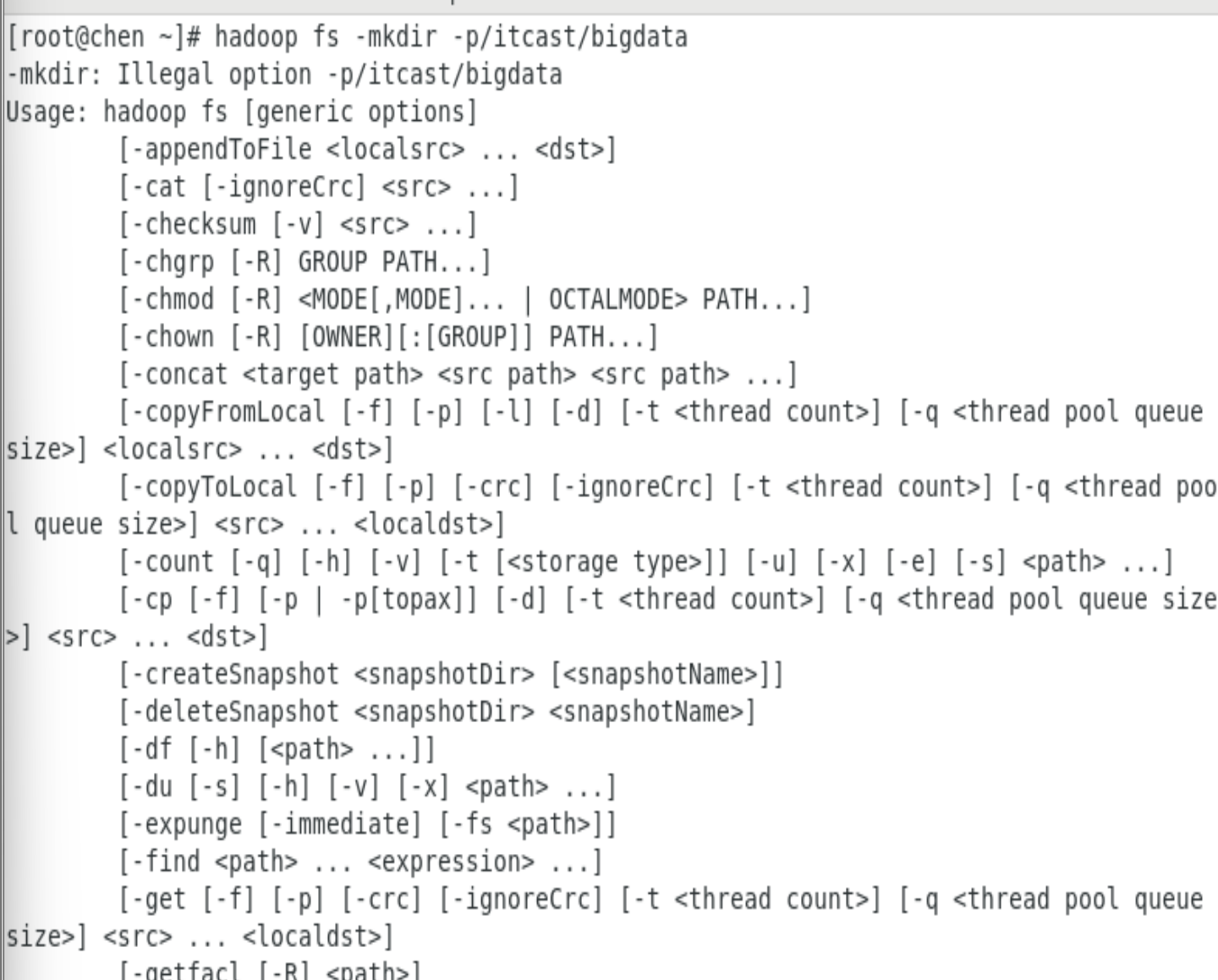

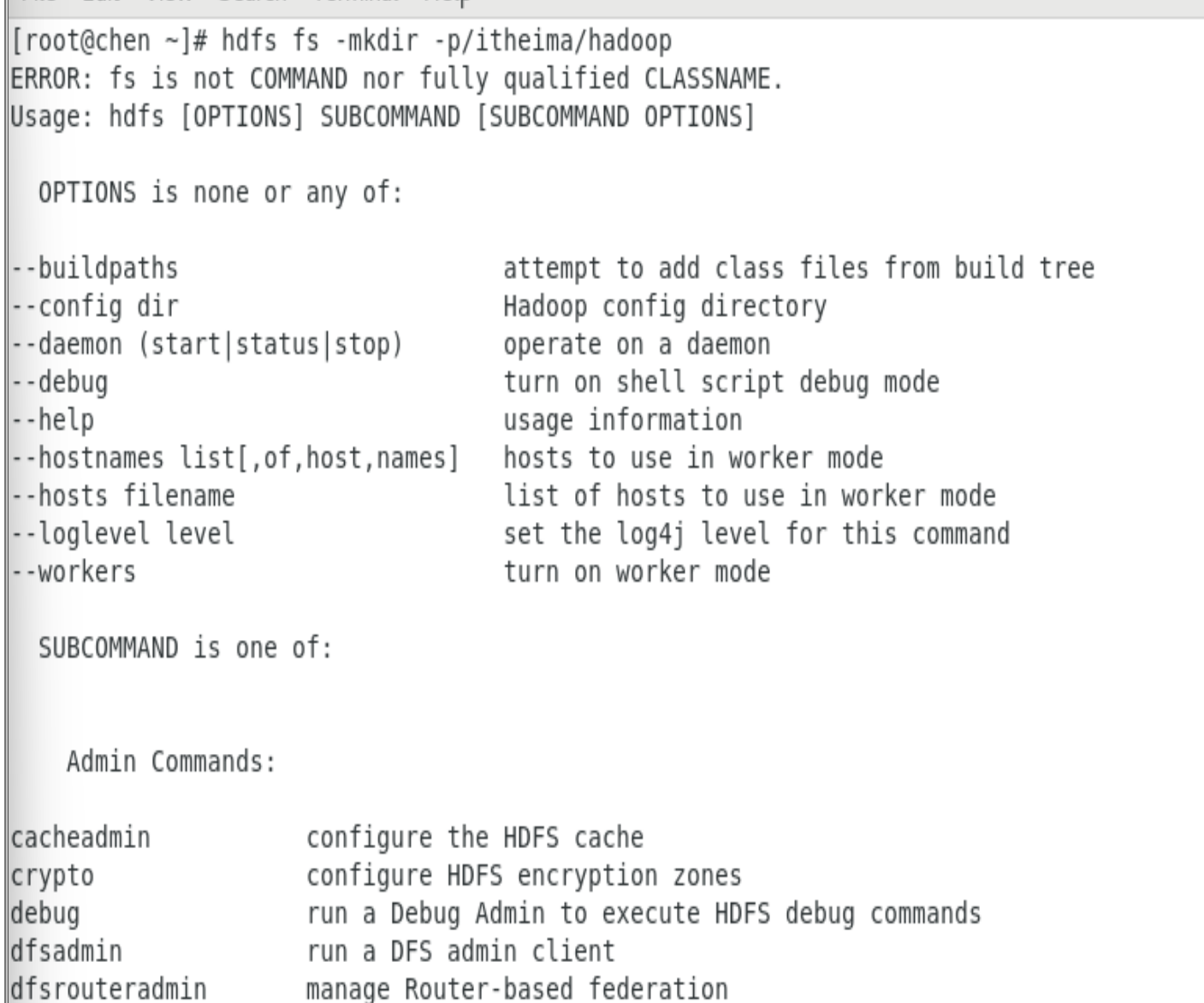

创建文件夹

hadoopfs-mkdir[-p]<path>...

hdfsdfs-mkdir[-p]<path>...

path为待创建的目录

-p选项的行为与Linuxmkdir-p一致,它会沿着路径创建父目录。

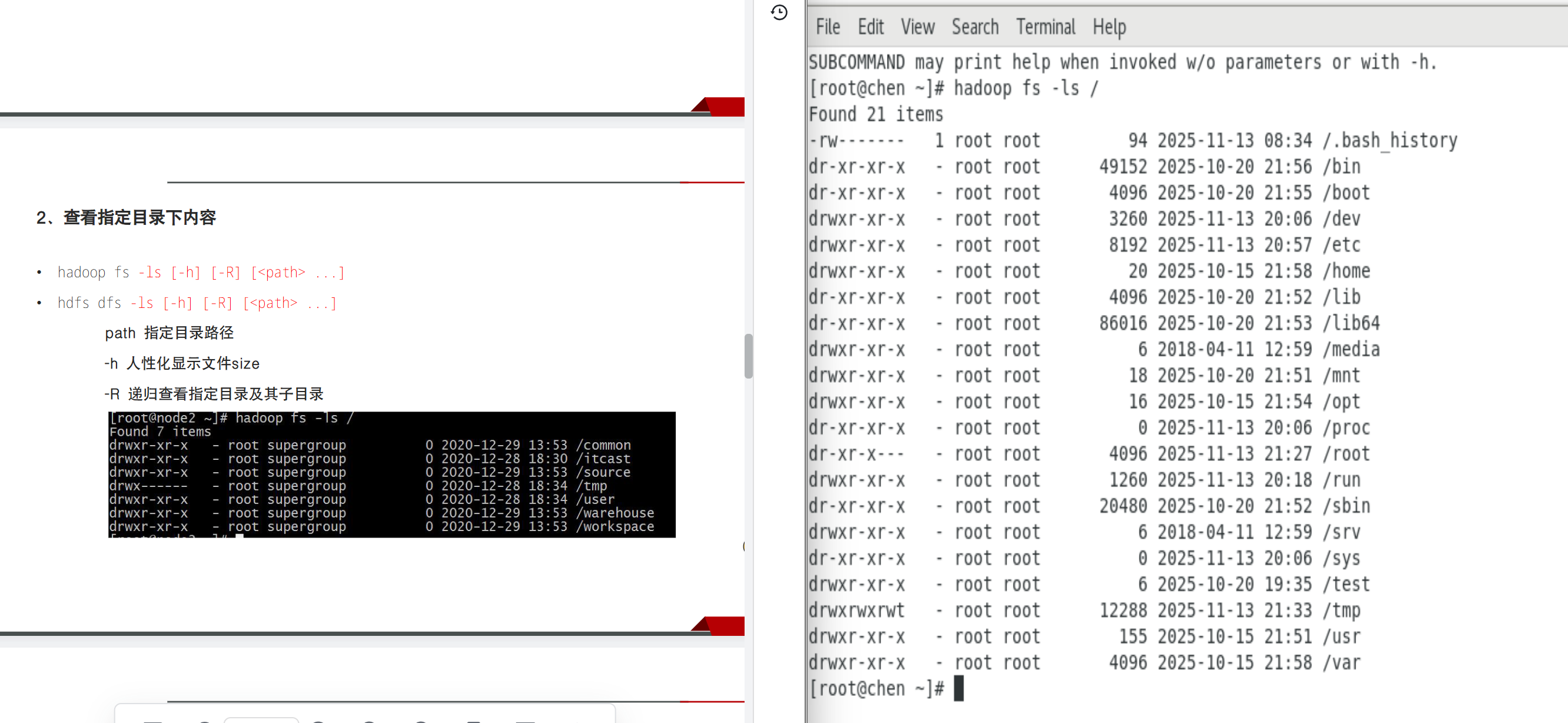

查看指定目录下内容

hadoop fs -ls [-h] [-R] [<path>...]

hdfs dfs -ls [-h] [-R] [<path>...]

path指定目录路径

-h人性化显示文件size

-R递归查看指定目录及其子目录

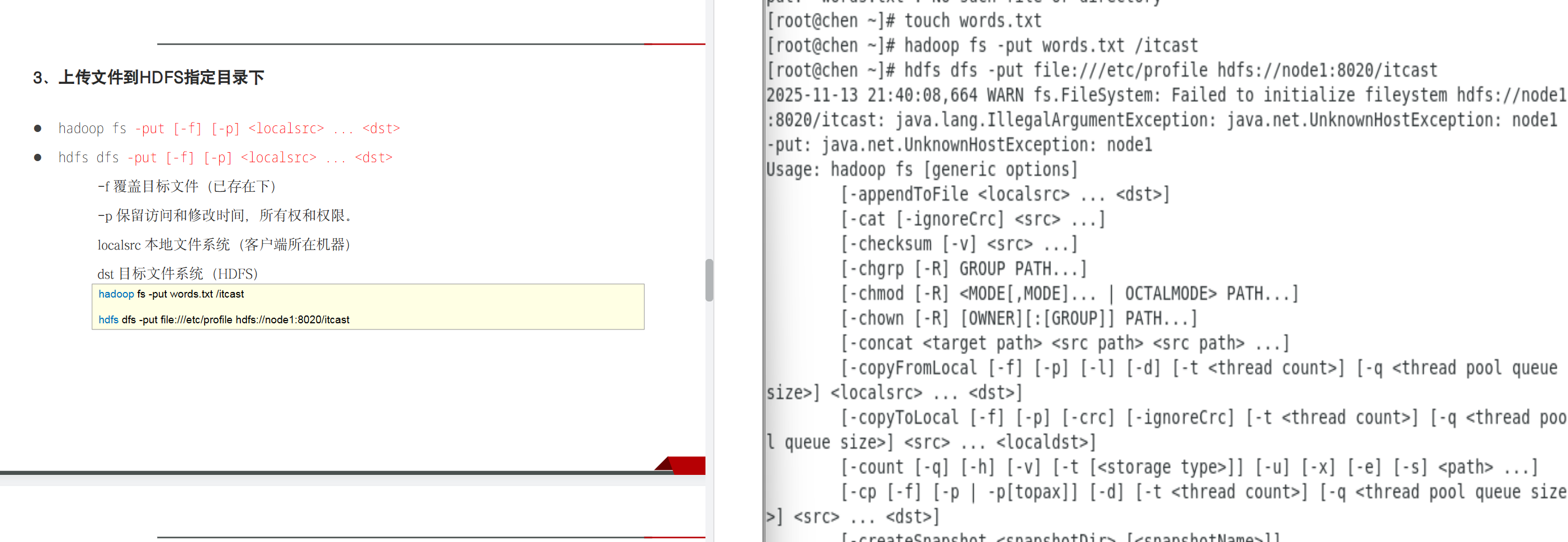

上传文件到HDFS指定目录下

hadoopfs-put[-f][-p]<localsrc>...<dst>

hdfsdfs-put[-f][-p]<localsrc>...<dst>

-f覆盖目标文件(已存在下)

-p保留访问和修改时间,所有权和权限。

localsrc本地文件系统(客户端所在机器)

dst目标文件系统(HDFS)

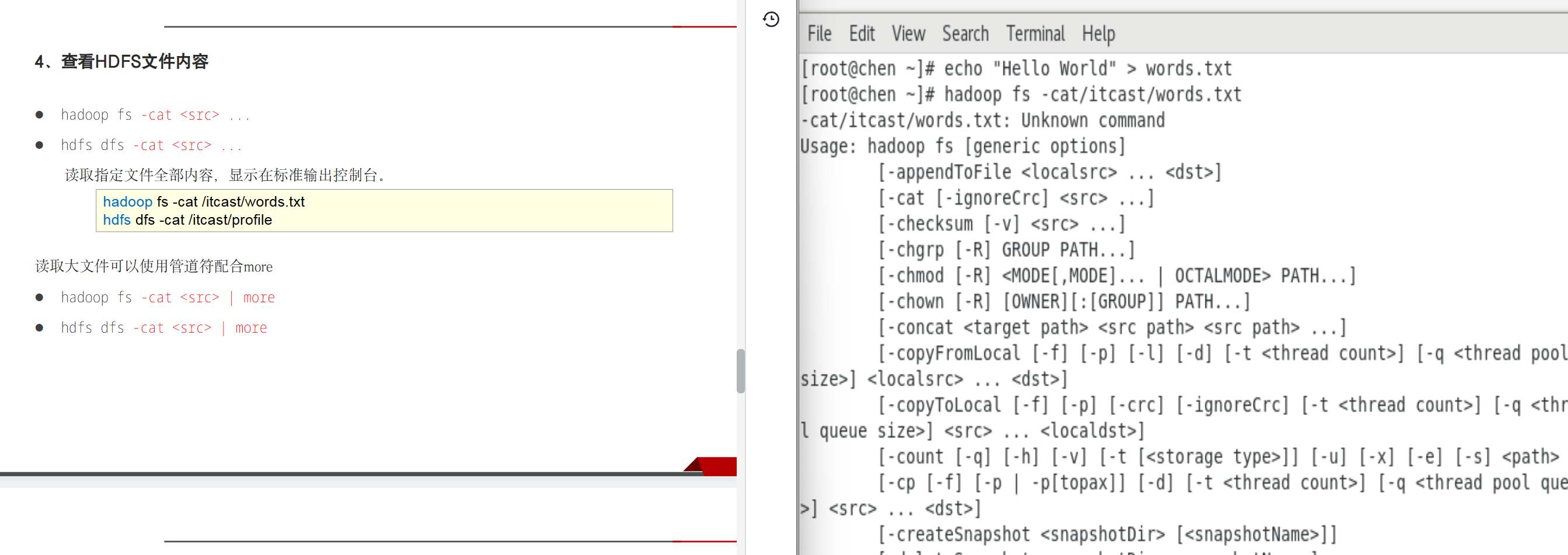

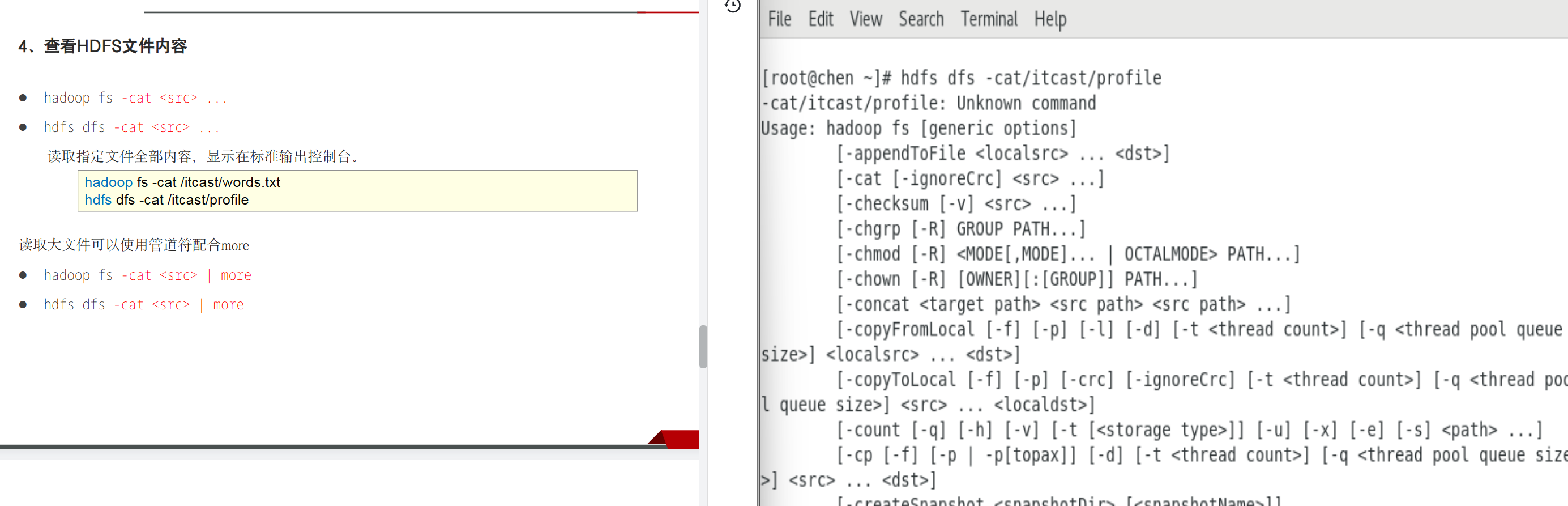

查看HDFS文件内容

hadoopfs-cat<src>...

hdfsdfs-cat<src>...

读取指定文件全部内容,显示在标准输出控制台。

读取大文件可以使用管道符配合more

hadoop fs -cat <src> | more

hdfs dfs -cat <src> | more

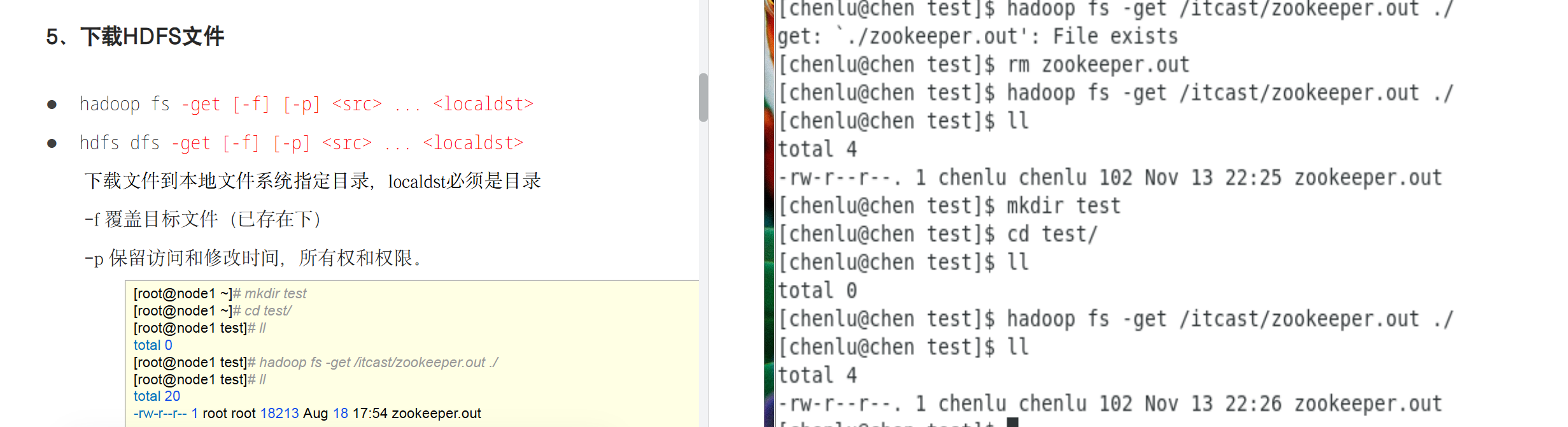

下载HDFS文件

hadoop fs -get [-f] [-p] <src> ... <localdst>

hdfs dfs -get [-f] [-p] <src> ... <localdst>

下载文件到本地文件系统指定目录,localdst必须是目录

-f覆盖目标文件(已存在下)

-p保留访问和修改时间,所有权和权限。

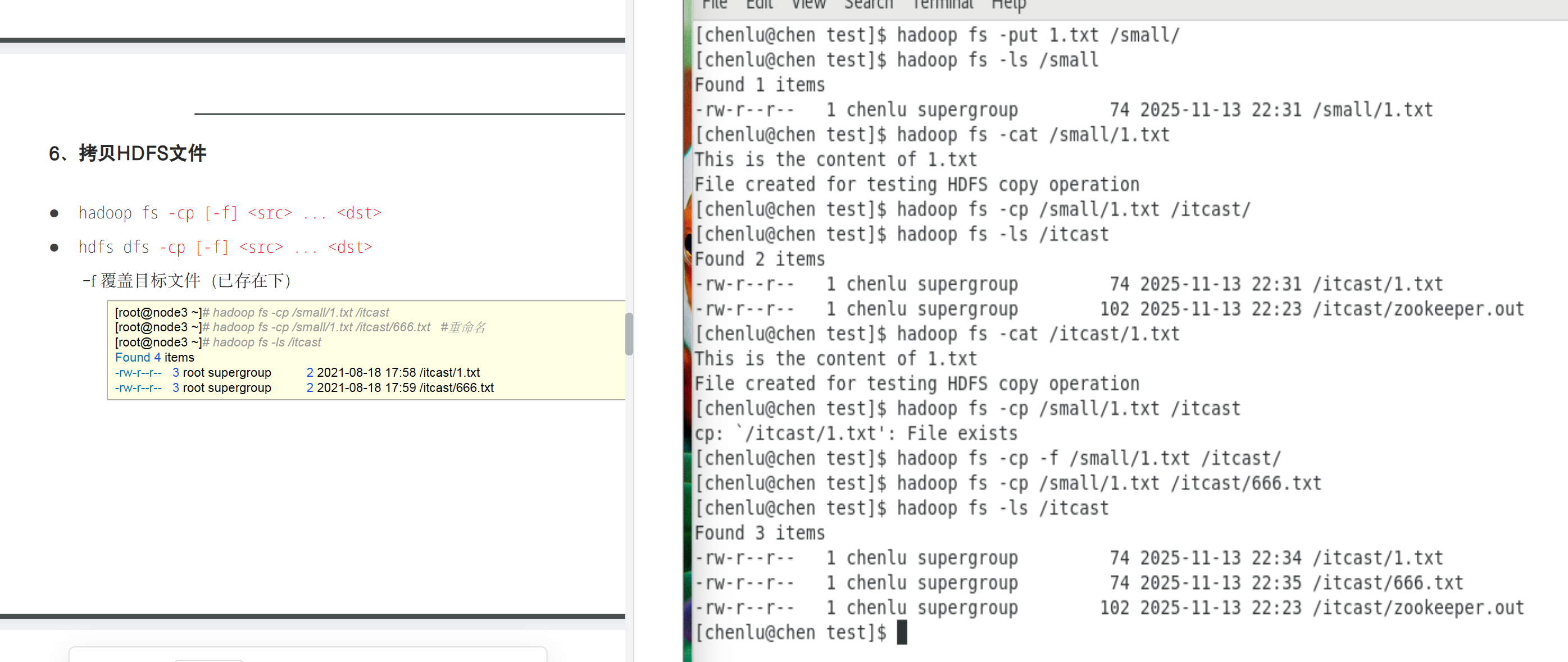

拷贝HDFS文件

hadoop fs -cp [-f] <src> ... <dst>

hdfs dfs -cp [-f] <src> ... <dst>

-f覆盖目标文件(已存在下)

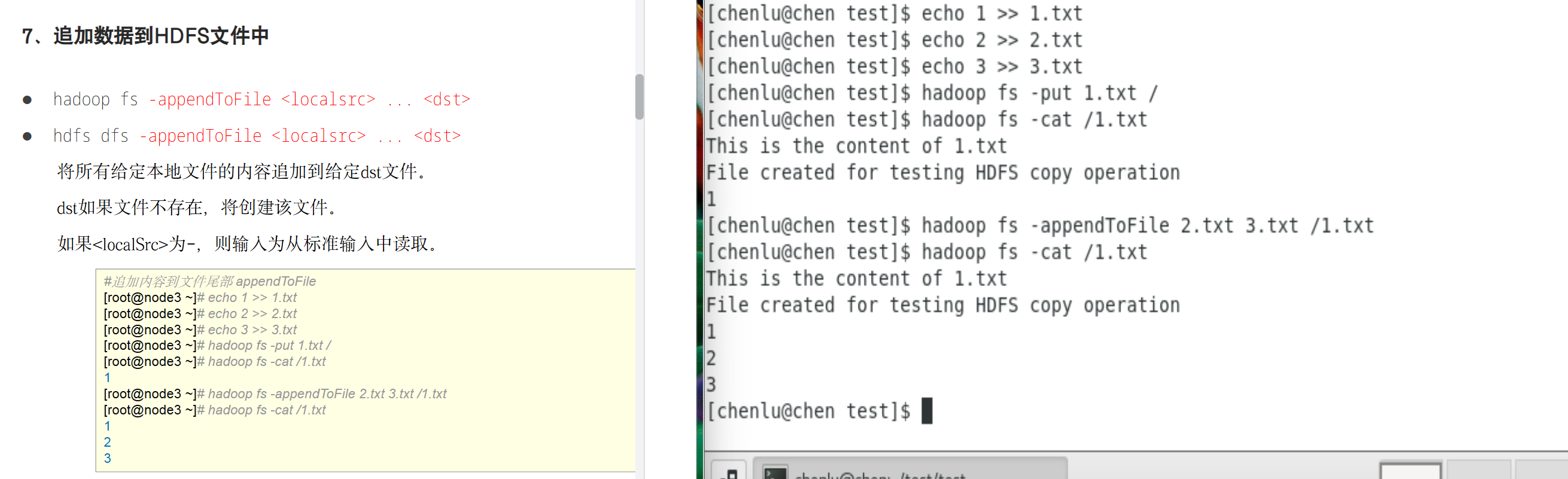

追加数据到HDFS文件中

hadoop fs -appendToFile <localsrc> ... <dst>

hdfs dfs -appendToFile <localsrc> ... <dst>

将所有给定本地文件的内容追加到给定dst文件。

dst如果文件不存在,将创建该文件。

如果<localSrc>为-,则输入为从标准输入中读取。

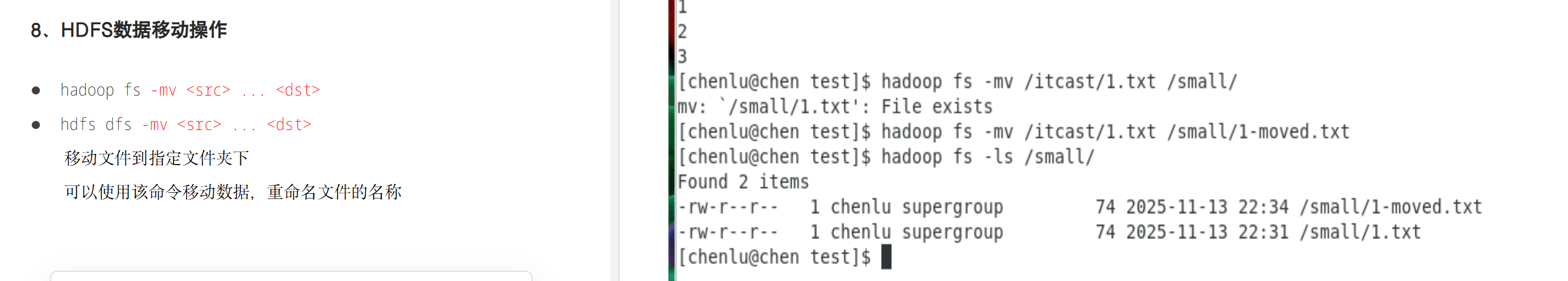

HDFS数据移动操作

hadoop fs -mv <src> ... <dst>

hdfs dfs -mv <src> ... <dst>

移动文件到指定文件夹下

可以使用该命令移动数据,重命名文件的名称

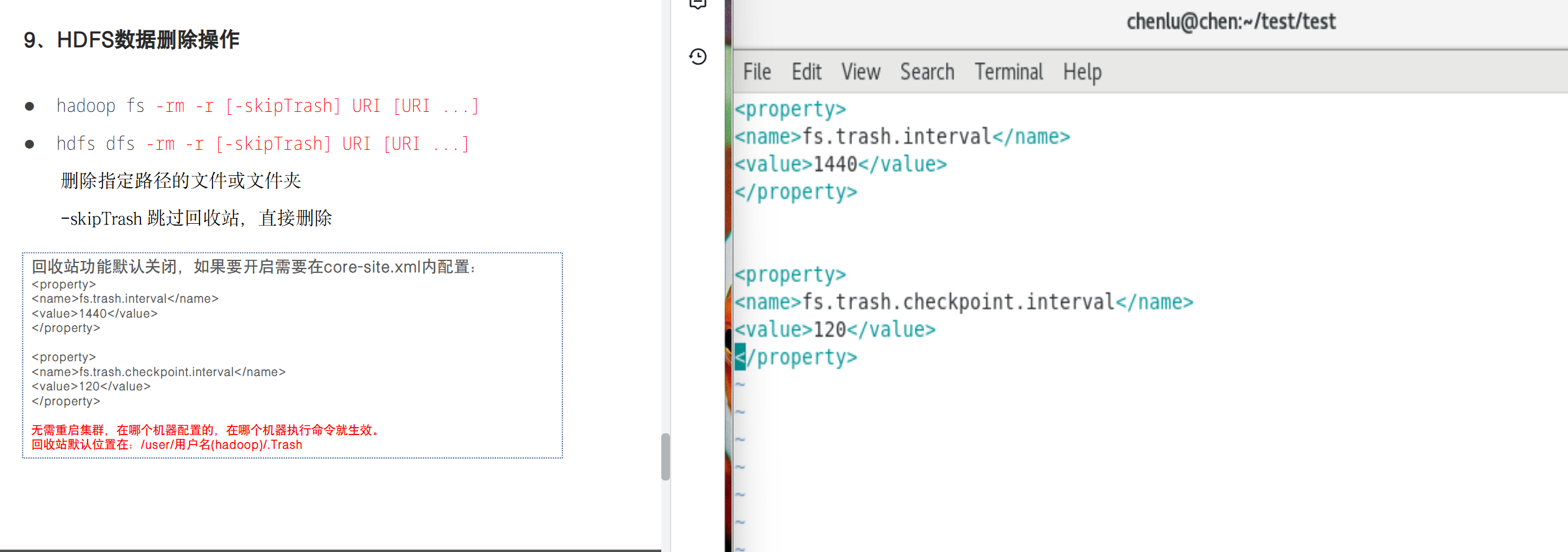

HDFS数据删除操作

hadoop fs -rm -r [-skipTrash] URI [URI ...]

hdfs dfs -rm -r [-skipTrash] URI [URI ...]

删除指定路径的文件或文件夹

-skipTrash跳过回收站,直接删除

(无需重启集群,在哪个机器配置的,在哪个机器执行命令就生效。回收站默认位置在:/user/用户名(hadoop)/.Trash)

7.HDFS shell其他命令

命令官方指导文档:https://hadoop.apache.org/docs/r3.3.4/hadoop-project-dist/hadoop-common/FileSystemShell.html

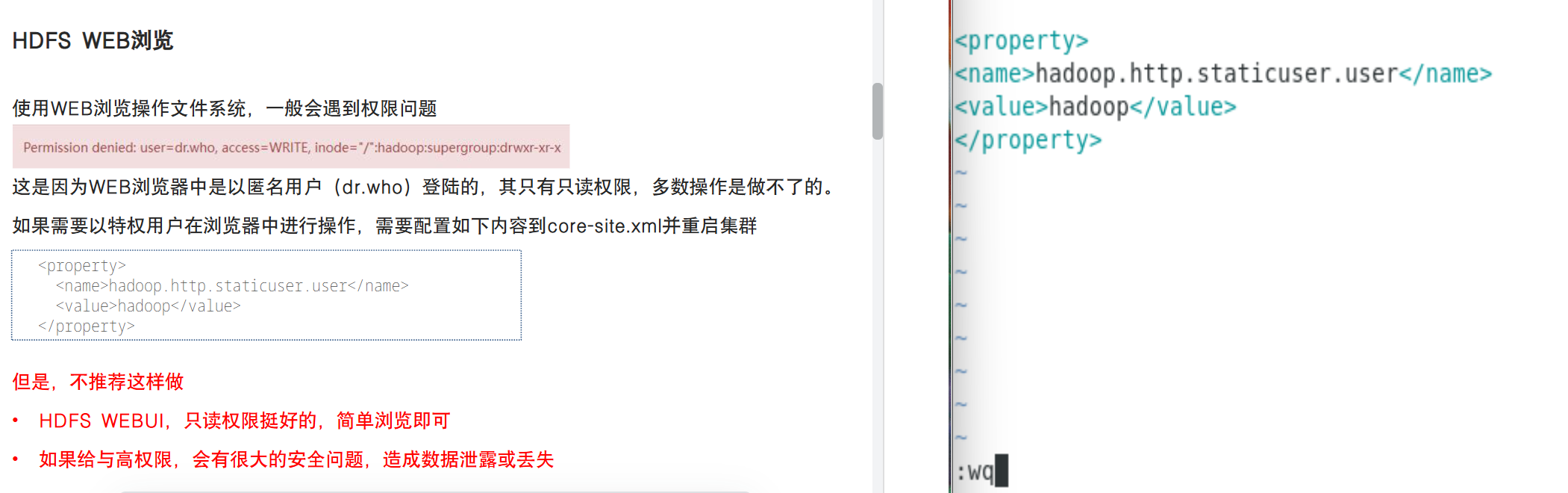

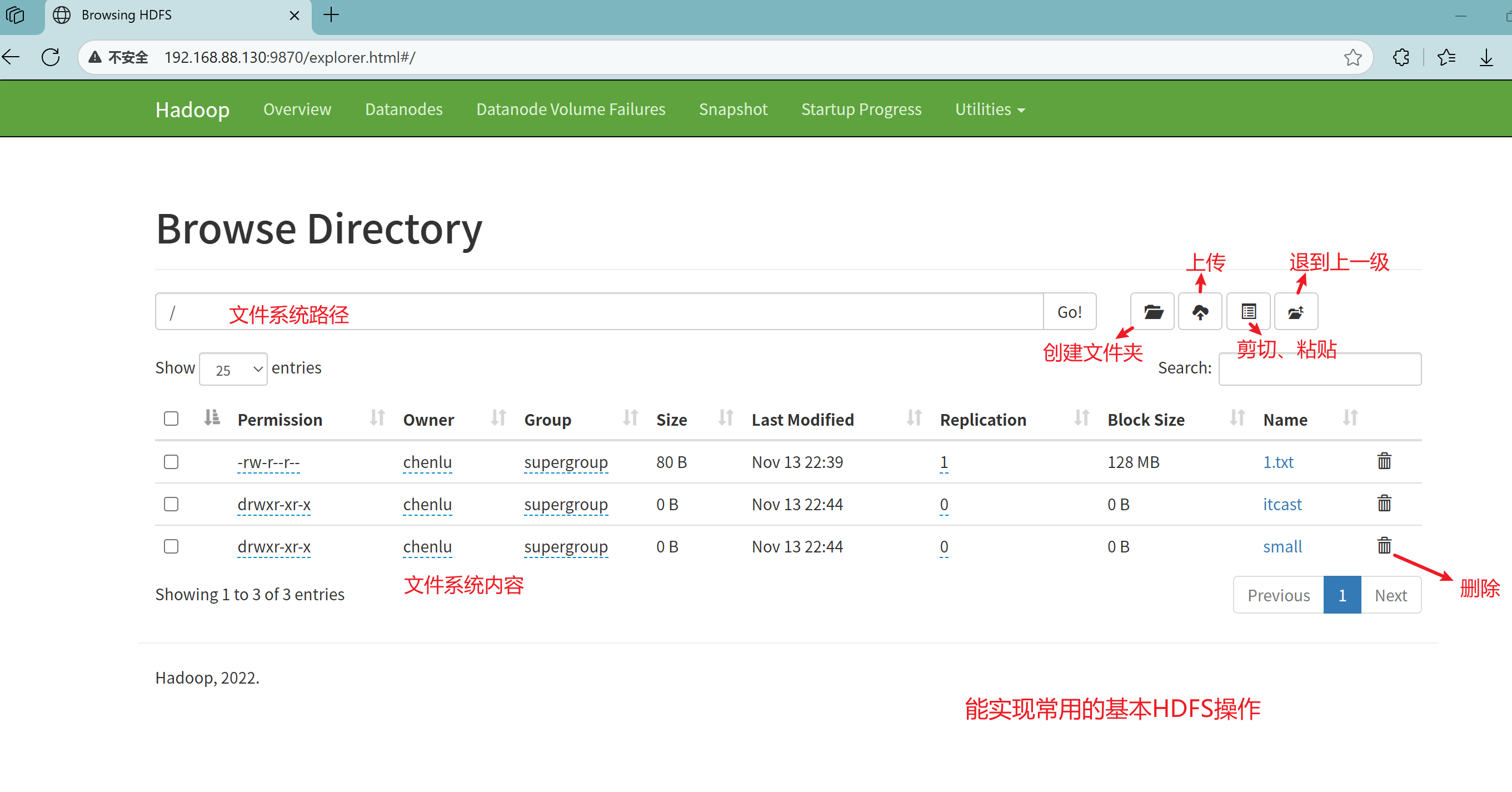

8.HDFS WEB浏览

先执行 ip addr show 查看虚拟机IP地址,尝试从浏览器访问

遇到防火墙拦截,阻止访问Hadoop Web UI,需要开放Hadoop的端口

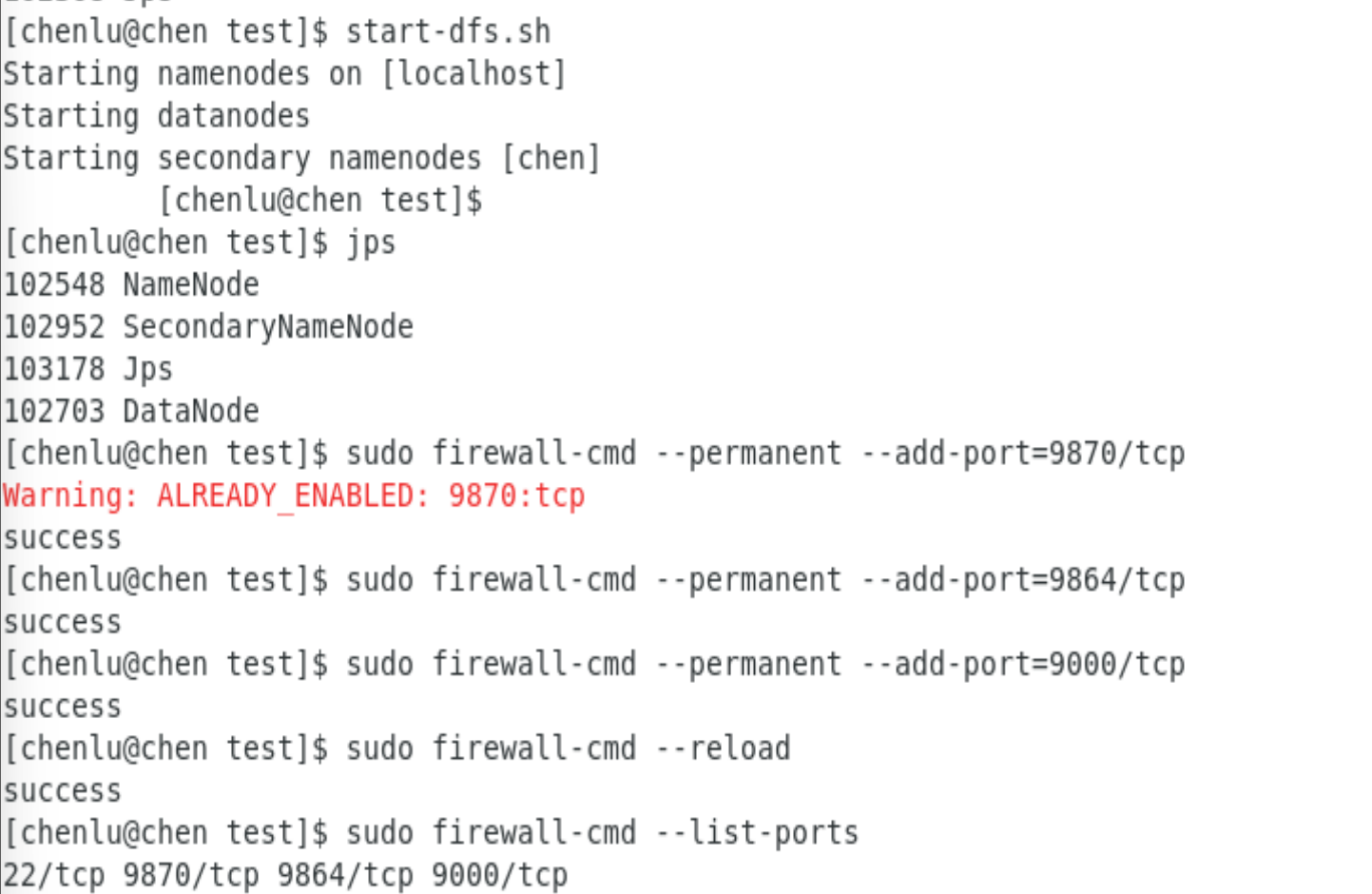

开放Hadoop Web UI端口

sudo firewall-cmd --permanent --add-port=9870/tcp # NameNode Web UI

sudo firewall-cmd --permanent --add-port=9864/tcp # DataNode Web UI

sudo firewall-cmd --permanent --add-port=9000/tcp # HDFS服务端口

重新加载防火墙配置

sudo firewall-cmd --reload

验证端口已开放 sudo firewall-cmd --list-ports

遇到权限问题时,到core-site.xml中配置

1644

1644

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?