大数据文摘专栏作品

作者:Christopher Dossman

编译:Jiaxu、fuma、云舟

呜啦啦啦啦啦啦啦大家好,拖更的AI Scholar Weekly栏目又和大家见面啦!

AI ScholarWeekly是AI领域的学术专栏,致力于为你带来最新潮、最全面、最深度的AI学术概览,一网打尽每周AI学术的前沿资讯。

本周关键词:虚假新闻识别、3D打印人体器官、Chatbot

本周最佳研究

本周最佳研究

BERT预训练更改,最终任务性能提高

BERT预训练更改,最终任务性能提高

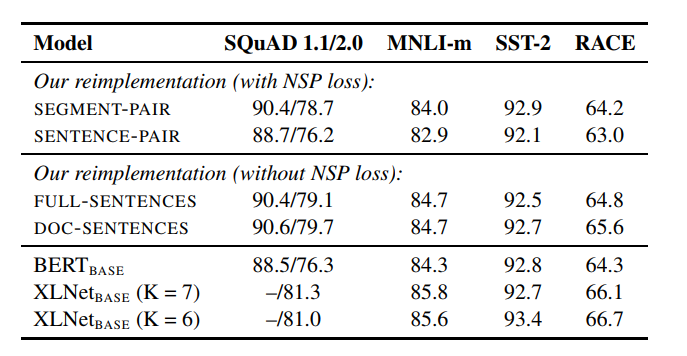

RoBERTa(稳健优化的BERT预训练方法)是Paul G. Allen计算机科学与工程学院的研究人员最近发表的一篇论文。他们展示了BERT预训练的复制研究,该研究仔细研究了许多关键超参数和训练数据大小的影响。

在发现BERT的不足之后,他们提出了一种改进BERT的方法。具体来说,RoBERTa采用动态屏蔽FULL-SENTENCES进行训练,没有NSP损失大型小批量和更大的字节级BPE。

他们做出了以下四点修改:

训练模型的时间更长,批量更大,数据更多

删除了预测下一个句子的目标

训练更长的序列

动态更改应用于训练数据的遮罩模式

RoBERTa可以匹配或超过所有后BERT方法的性能,并在GLUE,RACE

本周AI领域的热门话题包括虚假新闻识别技术、3D打印人体器官的进展以及一项新研究,该研究旨在为Chatbot注入同理心,使其能更好地理解和响应人类情感。

本周AI领域的热门话题包括虚假新闻识别技术、3D打印人体器官的进展以及一项新研究,该研究旨在为Chatbot注入同理心,使其能更好地理解和响应人类情感。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?