一.谁来执行Rebalance以及管理consumer的group呢?

kafka提供了一个角色,coordinator来执行对于consumer group的管理,当consumer group的第一个consumer启动的时候,它会去和kafka server确定谁是它们组的coordinator。之后该group内的所有成员都会和该coordinator进行协调通信

二.如何确定coordinator

consumer group如何确定自己的coordinator是谁呢, 消费者向kafka集群中的任意一个broker发送一个

GroupCoordinatorRequest请求,服务端会返回一个负载最小的broker节点的id,并将该broker设置为coordinator

三.JoinGroup的过程

在rebalance之前,需要保证coordinator是已经确定好了的,整个rebalance的过程分为两个步骤,Join和Sync.

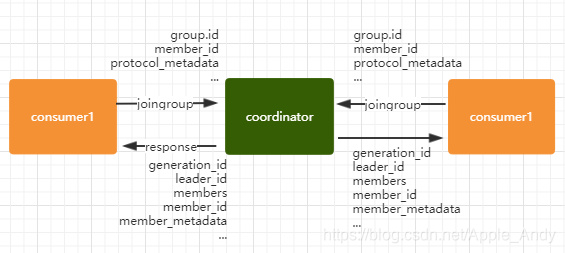

**join:**表示加入到consumer group中,在这一步中,所有的成员都会向coordinator发送joinGroup的请求。一旦所有成员都发送了joinGroup请求,那么coordinator会选择一个consumer担任leader角色,

并把组成员信息和订阅信息发送消费者,leader选举算法比较简单,如果消费组内没有leader,那么第一个加入消费组的消费者就是消费者leader,如果这个时候leader消费者退出了消费组,那么重新选举一个leader,这个选举很随意,类似于随机算法

Synchronizing Group Stat

Kafka通过coordinator管理consumer group,coordinator由负载最小的broker担任。rebalance过程包括Join和Sync两步,Join时consumer向coordinator发送joinGroup请求,coordinator选择leader并分配分区。Sync阶段,leader同步分区分配方案给所有成员,实现consumer group的分区消费。

Kafka通过coordinator管理consumer group,coordinator由负载最小的broker担任。rebalance过程包括Join和Sync两步,Join时consumer向coordinator发送joinGroup请求,coordinator选择leader并分配分区。Sync阶段,leader同步分区分配方案给所有成员,实现consumer group的分区消费。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

212

212