abstract

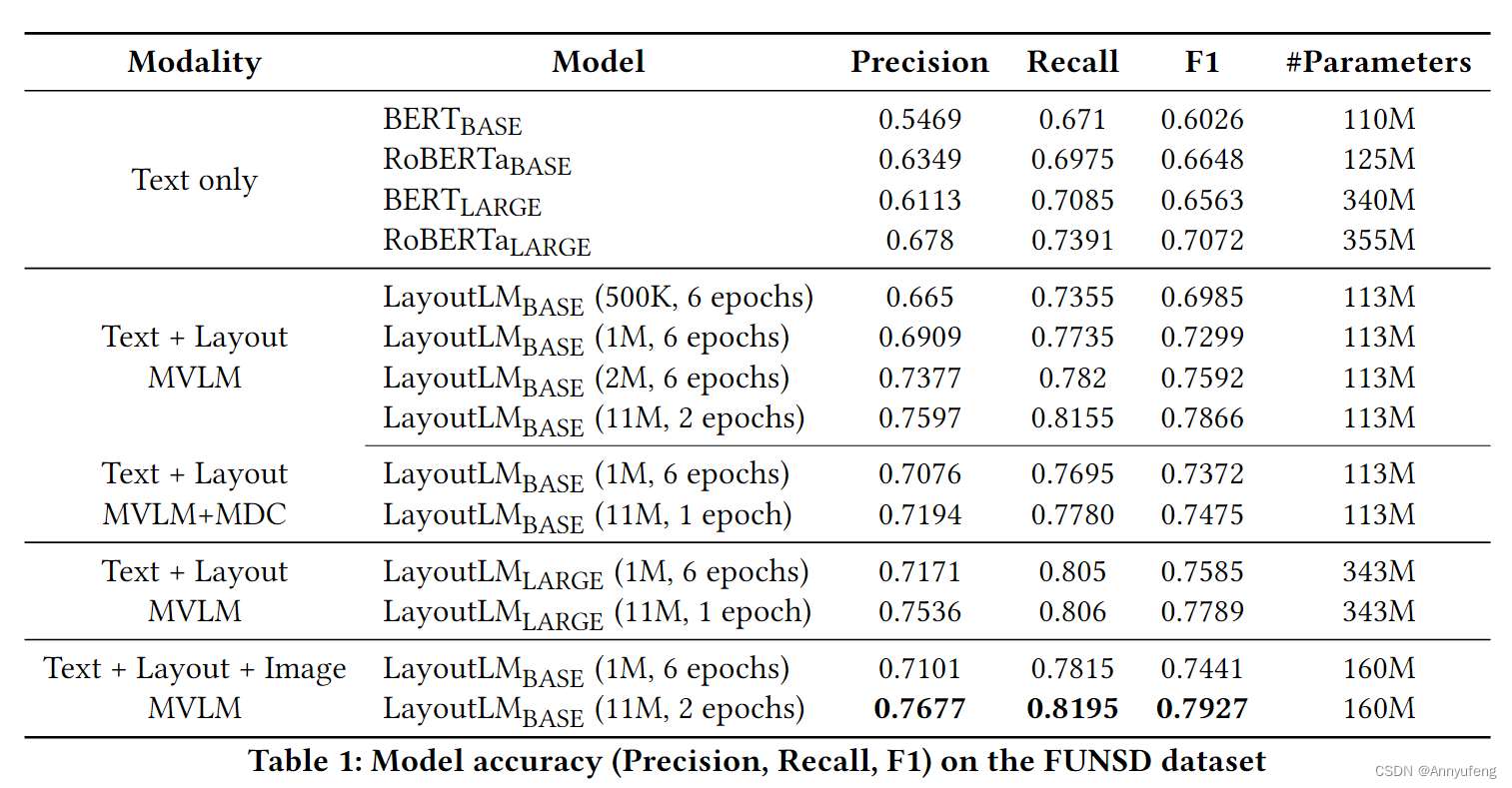

在layoutlm出现以前,已经有很多文本层面(NLP)的应用,但却忽视了布局和版式信息,微软提出的layoutlm首次结合了文本和布局信息,从而在文本理解 收据理解 图像文本分类上有较大的提升

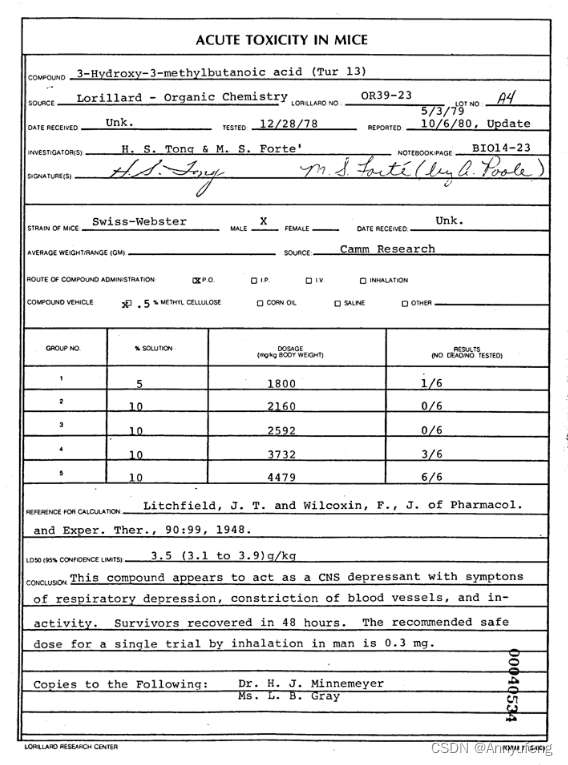

document

Model

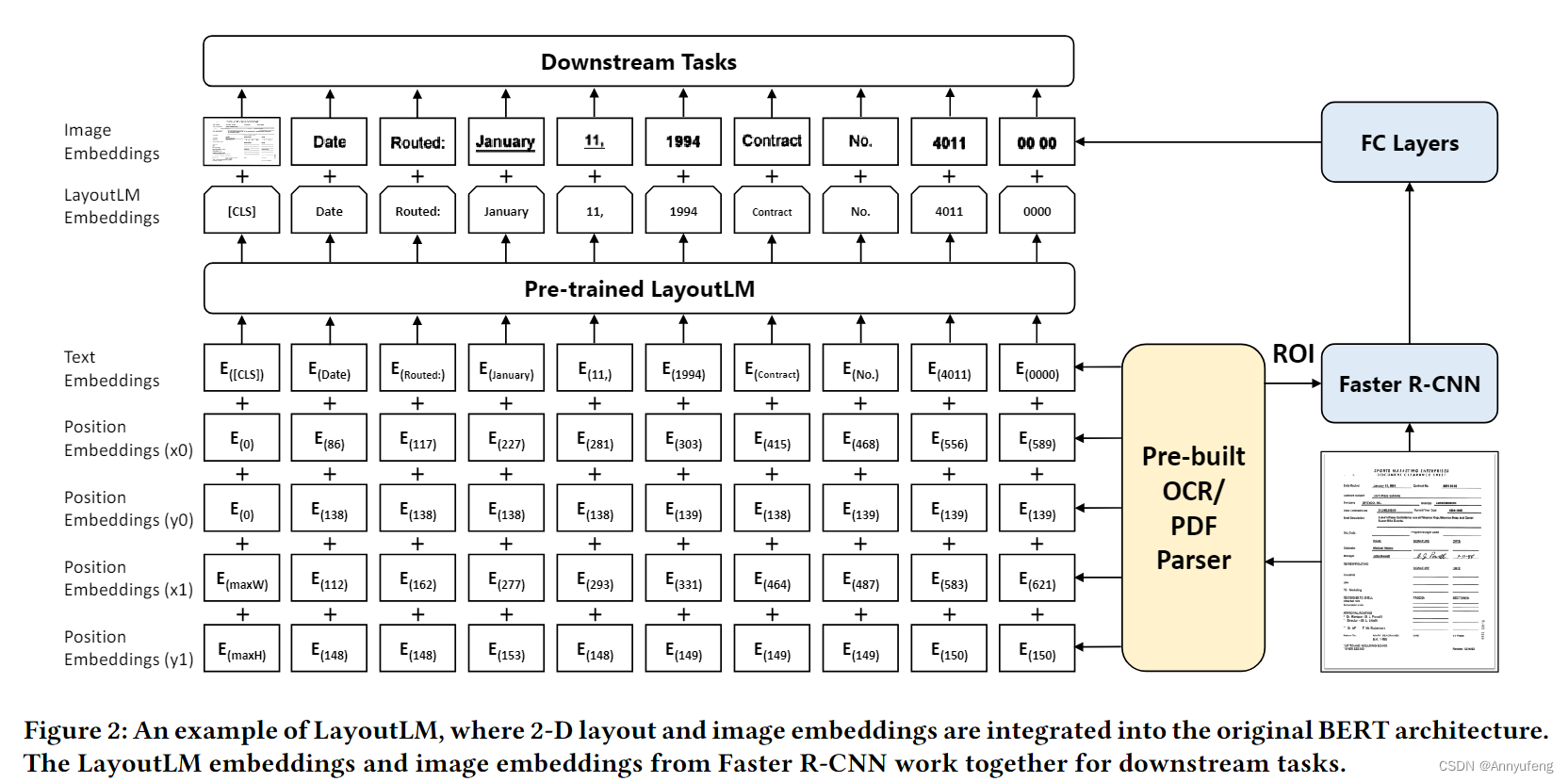

LayoutLM基于BERT模型

BERT--TRANSFORMER--ATTENTION--ENCODER(DECODER)

BERT实际上就是使用transformer和内部的attention机制 用来搞理解 QA任务。

在此基础上 layoutml加入了两个输入

-

2-D Position Embedding

x0 y0 x1 y1 左上 和 右下

-

Image Embedding

利用图像特征 并与文本要对齐

整个过程,先将position embedding和BERT中的text embedding相加 做预训练

微调部分 输出layoutlm embedding 再加上 image embedding

结果:

1180

1180

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?