前言

你有没有这样的困惑?看了大量关于 Transformer 和大语言模型(LLM)的资料,却依然感觉一头雾水?今天,让我们一起来聊一聊LLM 中的核心概念——Token。在学习 Transformer 的过程中,当真正理解了"Token" 和 "Tokenizer(分词器)"的工作原理时,才仿佛迷雾散去,迎来第一个顿悟时刻。

作为大模型的基石,Token 虽然看似简单基础,却是一切推理、训练和优化的起点。从 DeepSeek 到 Claude,这些先进的大语言模型之所以能够理解和生成文本,都离不开 Token 的作用。无论你是刚接触大模型的初学者,还是在实际开发中面临 Token 限制的工程师,本文都将帮助你构建清晰的认知框架,彻底掌握这一关键概念。

一、Token是什么?——文字的“积木块”

在大语言模型的世界里,Token 可以理解为文本处理的最小单元。想象你在阅读一本书,书中的文字在你的脑海里被拆解为一个个可以理解的词汇。在 LLM 中,Token 的形态丰富多样:它既可以是完整的词汇,如 “苹果”、“你好"这类语义完整的单元;也可能是词汇的组成部分,例如"unhappiness"可能被分割成"un"和"happiness"两个子单元;极端情况下,甚至会细化到字母级,将"apple"拆解为"a”、“p”、“p”、“l”、“e”。

这种灵活的拆解机制源于语言特性与任务需求的多样性。对于英语这类单词边界清晰的语言,以完整单词作为 Token 能够高效捕捉语义;而中文、日文等缺乏天然分隔符的语言,则需要更精细的切分策略,通过将词语拆解为字或子词单元,实现更精准的语义解析。这种差异化处理方式,确保了大模型在多语言场景下都能实现高效的文本处理与理解。

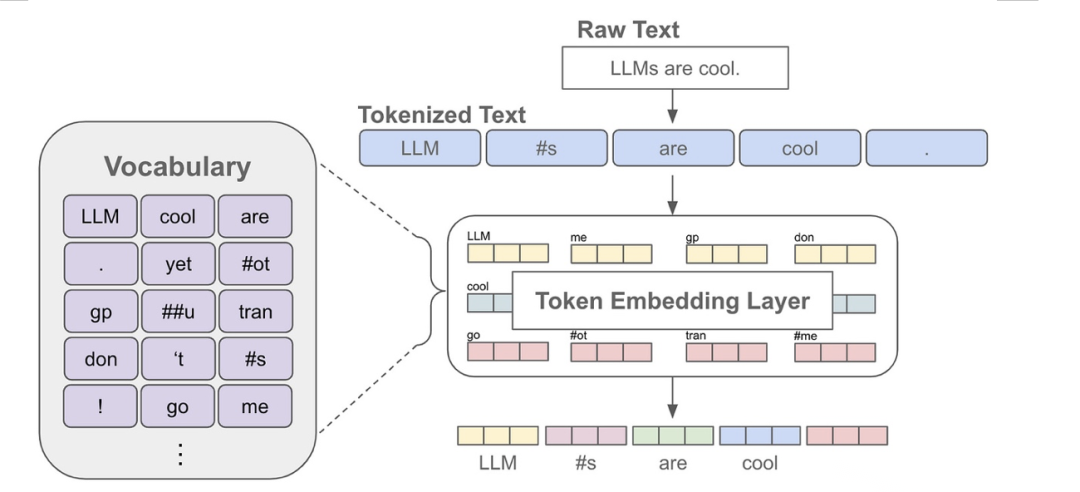

二、分词器——把文字“翻译”给AI的能手

那么,文本是如何转化为 Token 的呢?这一过程离不开分词器(Tokenizer)的运作。分词器就像一位专业翻译官,承担着将人类语言转化为机器可识别 Token 序列的重要使命。目前主流的分词方法各有特色:

字典分词:就像查字典,通过匹配预先构建的词表,将文本切分为标准词汇单元;

BPE(Byte-Pair Encoding):从基础字符开始,把常见的字符组合合并起来,慢慢拼成更大的词块;

SentencePiece:继承 BPE 的核心思想,在此基础上进行优化升级,具备更强的跨语言适应性;

WordPiece:BERT 模型常用的分词方式,它的原理有点像搭积木。先把每个单词拆成一个个小碎片,再根据这些碎片出现的频率和语义,把合适的碎片重新拼起来,组成能被模型更好理解的词块。

以 “Hello, I’m an AI assistant.” 这句话为例,使用 BPE 分词器处理后,会得到这样的 Token 序列:[‘Hello’, ‘,’, ‘I’, “'m”, ‘an’, ‘AI’, ‘assistant’, ‘.’]。每个 Token 都是 AI 理解文本的基础单元,正是通过对这些 Token 的分析与处理,模型才能构建出完整的语义理解。

三、中文的分词

在大语言模型领域,中文分词一直是个技术难点 —— 不同于英语用空格天然分隔单词,中文文本连绵不断,需要特殊处理。LLM 主要通过三种方式实现中文分词:

字符级分词:最基础的方法是将每个汉字作为一个 Token,比如 “你好” 会拆分为 [“你”, “好”]。这种方式虽然简单直接,但割裂了词语完整性,难以捕捉深层语义。

词级分词:借助词典或统计模型对文本进行切分,例如 “长沙欢迎你” 会处理成 [“长沙”, “欢迎”, “你”]。这种方法依赖高质量词库或训练良好的分词模型,新词识别能力较弱。

子词级分词:采用类似 BPE 的算法,将高频字符组合成 Token。比如 “我爱长沙” 可能拆分为 [“我”, “爱”, “长沙”] 或更大语义单元。这种方案在 LLM 中应用最广泛,既能处理未收录的新词,又兼顾计算效率与语义表达。

以 LLaMA 系列模型为例,就采用子词分词器处理中文。尽管这种方法在应对生词和提升效率上表现优异,但也存在局限性:有时会错误拆分或合并词汇,例如把 “的事” 误判为一个单元,而非正确识别为两个独立词语,这也是中文分词领域持续优化的方向。

四、特殊Token——文字里的“交通标志”

在大语言模型(LLM)中,除了承载语义的普通 Token,还有一类特殊 Token 发挥着关键作用。它们就像路上的交通标志,通过特定的标识告诉模型一些特别的信息,常见类型包括:

[CLS]:全称 Classification,表示一段文字的开头,帮助模型快速定位核心语义,常用于文本分类任务;

[SEP]:即 Separator,用于分隔不同的句子或段落,让模型清晰识别文本边界;

[PAD]:Padding 的缩写,当输入文本长度不足时,自动填充占位,确保数据格式统一;

[UNK]:Unknown 的简称,遇到词表外的未登录词时,以此作为替代标识;

[MASK]:主要应用于 BERT 等预训练模型,通过遮蔽部分词汇,引导模型预测缺失内容,强化语义理解能力。

这些特殊 Token 是模型理解文本结构与执行任务的重要辅助,它们就像给AI指路的小助手,以标准化的符号体系,帮助 AI 精准把握文本的逻辑脉络与关键信息。

五、Token计数——为什么数量这么重要?

在使用大语言模型时,很多人会疑惑:Token 数量的多少究竟有何影响?实际上,这个数字直接关乎计算效率与使用成本。以 GPT-3 采用的 BPE 分词算法为例,平均每个英文单词会被拆分为 1.3 个 Token。假设用户输入 100 个 Token,模型回复 50 个 Token,单次交互就产生了 150 个 Token 的处理量。而市面上多数 AI 服务都采用 Token 计价模式,这意味着 Token 数量越多,使用成本越高。

直观来说,简单的提问如 “今天天气怎么样?” 可能仅需 10 个 Token,但若提交一篇长篇文章,Token 数量瞬间飙升至数百甚至上千。因此,无论是个人用户还是开发者,掌握 Token 计数方法、合理控制输入长度,都是优化使用成本的关键。

以下是一个Token计数的示例:

| 文本 | Token数量 | 分词结果 |

|---|---|---|

| Hello, I’m an AI assistant. | 8 | [‘Hello’, ‘,’, ‘I’, “'m”, ‘an’, ‘AI’, ‘assistant’, ‘.’] |

| 今天天气很好 | 3 | [‘今天’, ‘天气’, ‘很好’] |

六、LLaMA系列模型的分词器演进

现在我们来看看具体的模型。LLaMA系列是Meta(前Facebook AI)开发的大型语言模型,目前已经发布了Llama 2和Llama 3。我们来看看它们的分词器是怎么演进的。

1、Llama 2的分词器:BPE和SentencePiece

Llama 2 采用 BPE 算法构建分词体系。BPE是一种无监督的分词算法,通过迭代地合并语料库中最频繁出现的字符对来构建词汇表。具体来说,Llama 2的分词器从字符级别开始,找出语料库中出现频率最高的字符对并合并,将合并后的字符对加入词汇表,然后重复这个过程,直到达到预设的词汇表大小(约32,000个Token)或无法继续合并为止 (Understanding the Llama2 Tokenizer).

除了BPE,Llama 2的分词器还使用了SentencePiece。SentencePiece是一个无监督的文本编码器,提供了统一的接口,支持BPE、WordPiece和Unigram等多种分词算法。SentencePiece的优势在于其灵活性和一致性。它直接在原始文本上操作,不依赖于预处理或语言特定的特征(如空格),因此可以轻松地适应不同的语言和领域。

2、Llama 3的分词器:更大的词汇量和Tiktoken

在Llama 3中,分词器进行了显著的升级。首先,词汇量从Llama 2的32,000个大幅增加到了128,256个,显著提升了文本编码的精细度,为复杂语义表达提供了更丰富的基础。

其次,Llama 3从SentencePiece转向了Tiktoken。Tiktoken是由OpenAI开发的现代分词和编码工具,旨在更高效、更灵活地处理各种语言和文本数据。Llama 3选择Tiktoken可能基于其在编码效率和多语言支持方面的优势,以及与GPT系列模型保持一致的考虑 (In-depth understanding of Llama Tokenizer).

3、Llama 4的分词器:尚未公布

截至目前,Meta尚未公开Llama 4的全部细节,但据行业推测,Llama 4的分词器可能在以下方向发力:

延续 Tiktoken 生态:进一步优化多语言处理性能,消除跨语种的分词障碍;

词汇表扩容:持续扩大 Token 覆盖范围,精准捕捉更多生僻词汇和新兴表达;

性能深度优化:聚焦分词效率、中文处理能力和噪声抑制,提升模型鲁棒性;

任务适配增强: 针对指令微调等复杂场景,设计更贴合需求的分词策略,强化模型的交互能力。

七、总结

Token和分词器是LLM的“幕后英雄”。Token是AI处理文字的基本单位,分词器则是把文字变成Token的魔法师。从早期的WordPiece、BPE,到SentencePiece与Tiktoken,我们可以看到:分词器并不是一件小事。它影响的不只是文本编码效率,更深刻地决定了模型理解语言的方式、训练成本以及推理表现。

希望这篇文章让你对Token和分词器有了清晰的认识!只有真正理解了 Token,我们才能更好地驾驭大模型,让它为我们的任务所用。

最后的最后

感谢你们的阅读和喜欢,作为一位在一线互联网行业奋斗多年的老兵,我深知在这个瞬息万变的技术领域中,持续学习和进步的重要性。

为了帮助更多热爱技术、渴望成长的朋友,我特别整理了一份涵盖大模型领域的宝贵资料集。

这些资料不仅是我多年积累的心血结晶,也是我在行业一线实战经验的总结。

这些学习资料不仅深入浅出,而且非常实用,让大家系统而高效地掌握AI大模型的各个知识点。如果你愿意花时间沉下心来学习,相信它们一定能为你提供实质性的帮助。

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

大模型知识脑图

为了成为更好的 AI大模型 开发者,这里为大家提供了总的路线图。它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

经典书籍阅读

阅读AI大模型经典书籍可以帮助读者提高技术水平,开拓视野,掌握核心技术,提高解决问题的能力,同时也可以借鉴他人的经验。对于想要深入学习AI大模型开发的读者来说,阅读经典书籍是非常有必要的。

实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

面试资料

我们学习AI大模型必然是想找到高薪的工作,下面这些面试题都是总结当前最新、最热、最高频的面试题,并且每道题都有详细的答案,面试前刷完这套面试题资料,小小offer,不在话下

640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

393

393

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?