HDFS云盘管理系统项目说明文档

1. 项目概述

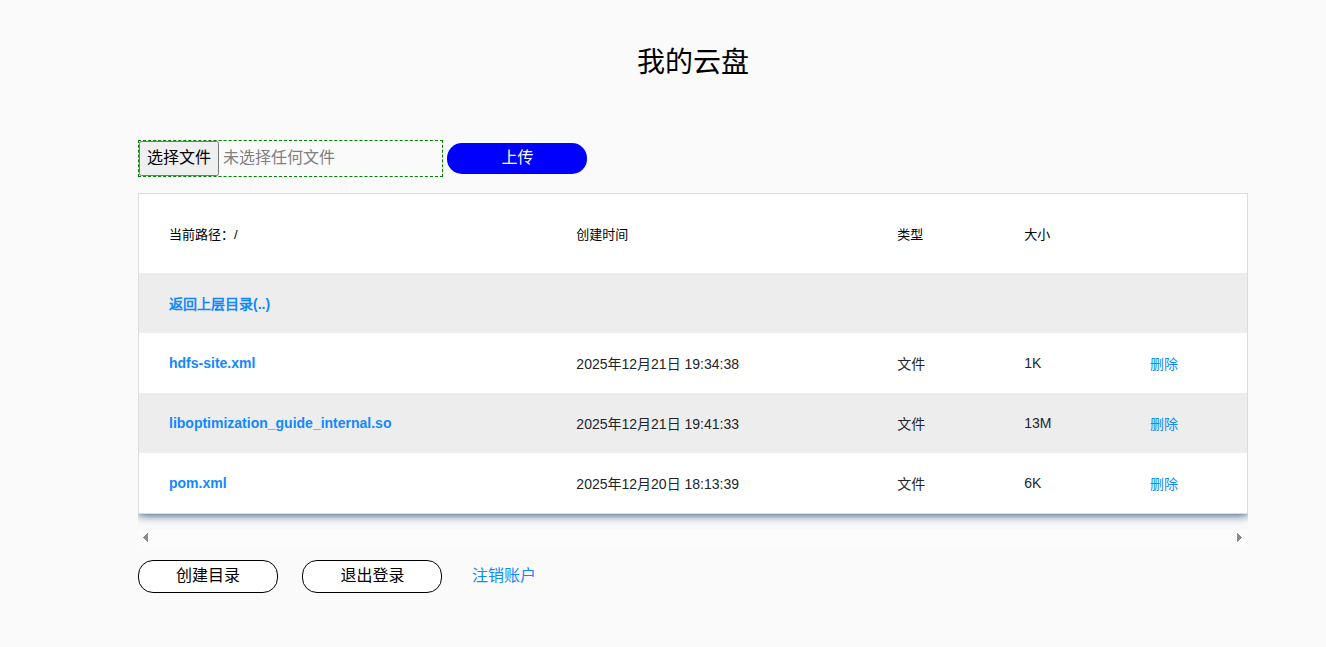

HDFS云盘管理系统是一个基于Hadoop分布式文件系统(HDFS)的Web应用程序,提供了类似云盘的文件管理功能。该系统允许用户通过友好的Web界面上传、下载、浏览、创建和删除文件及目录,实现了对HDFS的便捷操作和管理。

1.1 项目背景

随着大数据时代的到来,数据量呈爆炸式增长,传统的文件存储方式已经无法满足需求。Hadoop分布式文件系统(HDFS)作为大数据存储的核心组件,具有高容错性、高可靠性和高扩展性等特点,成为了处理大规模数据的首选存储解决方案。然而,HDFS的原生操作方式主要通过命令行界面进行,对普通用户来说不够友好。因此,开发一个基于Web的HDFS云盘管理系统,将极大地降低HDFS的使用门槛,提高用户体验和工作效率。

1.2 项目目标

- 提供友好的Web界面,实现对HDFS的可视化管理

- 支持用户注册、登录和身份验证

- 实现文件和目录的基本操作(上传、下载、浏览、创建、删除等)

- 支持多用户隔离,每个用户拥有独立的存储空间

- 提供安全的用户权限管理机制

2. 技术栈

2.1 后端技术

| 技术/框架 | 版本 | 用途 |

|---|---|---|

| Java | JDK 8+ | 核心开发语言 |

| Spring | 5.0.5.RELEASE | 依赖注入和面向切面编程框架 |

| SpringMVC | 5.0.5.RELEASE | Web应用开发框架 |

| MyBatis | 3.4.6 | ORM框架,用于数据库操作 |

| MyBatis-Spring | 1.3.1 | MyBatis与Spring的集成 |

| Hadoop Common | 3.3.5 | Hadoop基础库 |

| Hadoop HDFS | 3.3.5 | HDFS客户端库 |

| Hadoop Client | 3.3.5 | Hadoop客户端工具 |

| Druid | 1.1.10 | 数据库连接池 |

| MySQL Connector | 8.0.27 | MySQL数据库驱动 |

| JUnit | 4.12 | 单元测试框架 |

2.2 前端技术

| 技术/框架 | 版本 | 用途 |

|---|---|---|

| HTML5 | - | 页面结构 |

| CSS3 | - | 页面样式 |

| JavaScript | - | 页面交互 |

| JSP | - | Java服务器页面 |

| JSTL | 1.2 | JSP标准标签库 |

| Bootstrap | - | 前端UI框架 |

| Font Awesome | 4.7.0 | 图标库 |

2.3 开发工具

| 工具 | 用途 |

|---|---|

| IntelliJ IDEA | Java开发IDE |

| Maven | 项目构建和依赖管理 |

| Git | 版本控制 |

3. 系统架构

3.1 整体架构

HDFS云盘管理系统采用经典的MVC(Model-View-Controller)架构模式,结合Spring框架的分层设计理念,将系统分为以下几个层次:

- 表现层(View): 由JSP页面组成,负责用户界面的展示和用户交互。

- 控制层(Controller): 由SpringMVC的Controller组成,处理用户请求,调用业务逻辑层的方法,并将结果返回给视图层。

- 业务逻辑层(Service): 实现核心业务逻辑,调用数据访问层的方法,处理业务规则和事务。

- 数据访问层(Dao): 负责与数据库和HDFS的交互,实现数据的持久化和文件操作。

- 域模型层(Domain): 定义系统中的核心实体类,封装业务数据。

3.2 系统架构图

┌───────────────────────────────────────────────────────────────────────────┐

│ 表现层(View) │

│ (JSP页面 + JavaScript) │

└───────────────────────────────────────────────────────────────────────────┘

↑

│ HTTP请求/响应

↓

┌───────────────────────────────────────────────────────────────────────────┐

│ 控制层(Controller) │

│ (UserController, FileController) │

└───────────────────────────────────────────────────────────────────────────┘

↑

│ 调用业务方法

↓

┌───────────────────────────────────────────────────────────────────────────┐

│ 业务逻辑层(Service) │

│ (UserService, HdfsFileService) │

└───────────────────────────────────────────────────────────────────────────┘

↑

│ 调用数据访问方法

↓

┌───────────────────────────────────────────────────────────────────────────┐

│ 数据访问层(Dao) │

│ (UserMapper, HdfsDao) │

└───────────────────────────────────────────────────────────────────────────┘

↑

│ 数据交互

↓

┌─────────────────────────────────┬─────────────────────────────────────────┐

│ 数据库(MySQL) │ 文件系统(HDFS) │

└─────────────────────────────────┴─────────────────────────────────────────┘

4. 核心功能模块

4.1 用户管理模块

4.1.1 功能概述

用户管理模块负责用户的注册、登录、退出和注销等功能,实现了用户身份验证和权限控制。

4.1.2 核心功能点

-

用户注册

- 验证用户名和密码的有效性

- 检查用户名是否已存在

- 创建用户账户和对应的HDFS目录

- 保存用户信息到数据库

-

用户登录

- 验证用户凭据(用户名和密码)

- 创建用户会话

- 初始化用户当前路径

-

用户退出

- 销毁用户会话

- 清除登录状态

-

用户注销

- 删除用户账户

- 删除用户对应的HDFS目录

- 销毁用户会话

4.1.3 关键代码分析

UserController.java - 处理用户相关请求:

// 用户登录

@RequestMapping("/login")

public String login(User user, Model model, HttpSession session) throws IOException {

List<User> users = userService.selectUserList(user);

// 如果用户不存在

if (users.isEmpty()) {

model.addAttribute("status", "用户名或密码错误!");

return "index";

}

session.setAttribute("LOGIN_STATUS", users.get(0));

session.setAttribute("path", "/");

return "redirect:/file/fileList";

}

// 用户注册

@RequestMapping("/register")

public String register(User user, String userpasswd_confirm, Model model) throws IOException {

// 后端判断输入数据是否合规

if (user.getUsername() == null || user.getUsername().equals(" ")) {

model.addAttribute("status", "请输入用户名");

return "register";

}

// ... 其他验证逻辑 ...

// 数据库插入用户

userService.insertUser(user);

// 注册成功,为用户创建自己的目录

hdfsFileService.mkdir(user.getUsername(), pre);

model.addAttribute("status", "注册成功,请登录!");

return "index";

}

4.2 文件管理模块

4.2.1 功能概述

文件管理模块是系统的核心功能模块,实现了对HDFS文件和目录的各种操作,包括文件列表展示、目录创建、文件上传、文件下载、文件删除等。

4.2.2 核心功能点

-

文件列表展示

- 显示当前目录下的所有文件和子目录

- 展示文件/目录的名称、类型、大小、创建时间等信息

- 支持目录导航和路径显示

-

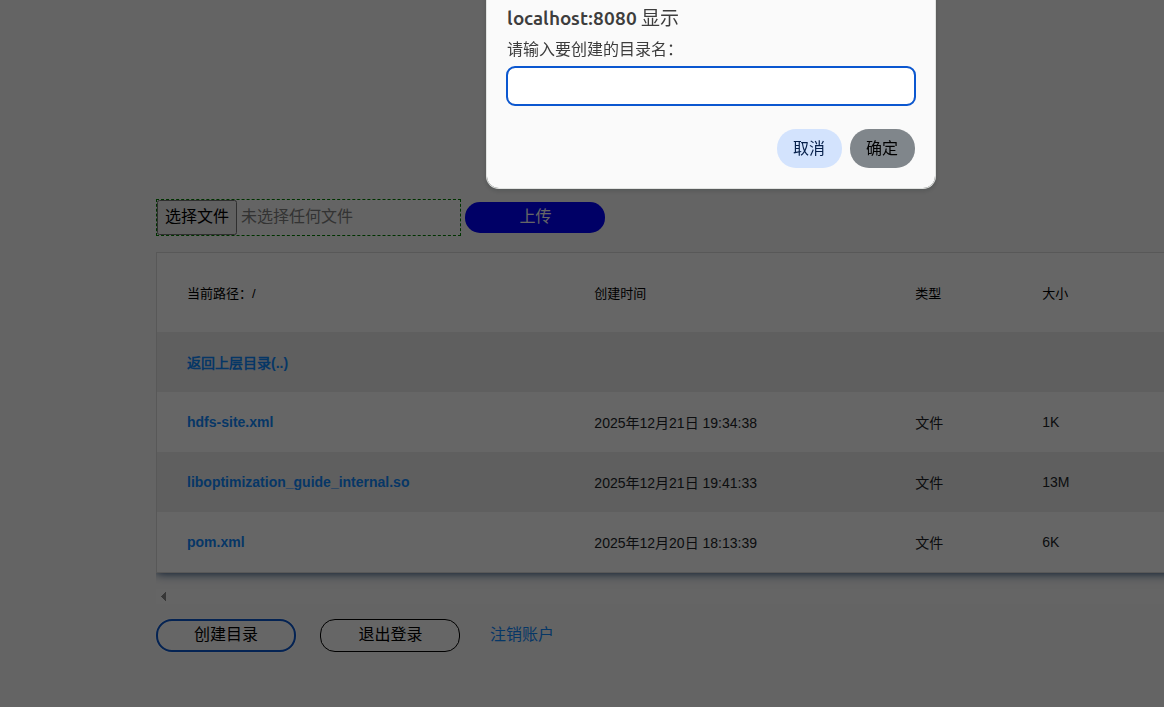

目录操作

- 创建新目录

- 浏览子目录

- 返回上一级目录

-

文件操作

- 上传本地文件到HDFS

- 从HDFS下载文件到本地

- 删除文件或目录

4.2.3 关键代码分析

FileController.java - 处理文件相关请求:

// 获取文件列表

@RequestMapping("/fileList")

public String FileList(Model model, HttpSession session) {

User user = (User) session.getAttribute("LOGIN_STATUS");

String currentPath = (String) session.getAttribute("path");

// 获取文件列表

List<HdfsFile> fileList = null;

try {

fileList = hdfsFileService.getFileList(pre + user.getUsername() + currentPath);

} catch (IOException e) {

e.printStackTrace();

}

model.addAttribute("currentpath", currentPath);

model.addAttribute("filelist", fileList);

return "myfiles";

}

// 创建目录

@RequestMapping("/makeDirectory")

public String makeDirectory(String dirname, HttpSession session, Model model) throws IOException {

User user = (User) session.getAttribute("LOGIN_STATUS");

String currentPath = (String) session.getAttribute("path");

String waring = null;

String path = pre + user.getUsername() + currentPath;

if(hdfsFileService.fileExist(path + dirname)) {

waring = "alert(\"该目录已存在,请重新输入目录名!\");";

session.setAttribute("waring", waring);

return "redirect:fileList";

}

else {

hdfsFileService.mkdir(dirname, path);

waring = "alert(\"创建成功!\");";

session.setAttribute("waring", waring);

session.setAttribute("path", currentPath + dirname + "/");

return "redirect:fileList";

}

}

// 文件下载和目录导航

@RequestMapping("/fileHandle")

public String fileHandle(HdfsFile hdfsFile, HttpServletResponse response, HttpServletRequest request, HttpSession session) throws Exception {

User user = (User) session.getAttribute("LOGIN_STATUS");

String currentPath = (String) session.getAttribute("path");

// 如果是目录,进入到下一层

if(!hdfsFile.getFile()) {

session.setAttribute("path", currentPath + hdfsFile.getFileName() + "/");

return "redirect:fileList";

}

// 如果是文件,下载文件

// 设置响应头

String filename = hdfsFile.getFileName();

ServletContext servletContext = request.getServletContext();

String mimeType = servletContext.getMimeType(filename);

response.setHeader("content-type", mimeType);

// 解决中文文件名问题

String agent = request.getHeader("user-agent");

filename = DownloadUtlis.getFileName(agent, filename);

response.setHeader("content-disposition", "attachment;filename = "+filename);

BufferedInputStream bufferedInputStream = new BufferedInputStream(hdfsFileService.downloadFile(hdfsFile.getFileName(), pre + user.getUsername() + currentPath));

BufferedOutputStream bufferedOutputStream = new BufferedOutputStream(response.getOutputStream());

byte[] buff = new byte[2048];

int bytesRead;

while((bytesRead = bufferedInputStream.read(buff, 0, buff.length)) != -1)

bufferedOutputStream.write(buff, 0, bytesRead);

bufferedInputStream.close();

bufferedOutputStream.close();

return null;

}

HdfsFileServiceImpl.java - 实现文件操作的核心业务逻辑:

// 获取文件列表

@Override

public List<HdfsFile> getFileList(String path) throws IOException {

Path root = new Path(path);

FileSystem fs = hdfsDao.getFileSystem();

FileStatus[] files = fs.listStatus(root);

fs.close();

List<HdfsFile> list = getFiles(files);

return list;

}

// 创建目录

@Override

public boolean mkdir(String newName, String currentPath) throws IOException {

Path filePath = new Path(currentPath + newName);

FileSystem fs = hdfsDao.getFileSystem();

boolean result = fs.mkdirs(filePath);

fs.close();

return result;

}

// 上传文件

@Override

public boolean uploadFile(BufferedInputStream in, String remotePath) throws IOException {

FileSystem fs = null;

try {

fs = hdfsDao.getFileSystem();

} catch (IOException e) {

e.printStackTrace();

return false;

}

// 获取输出对象

FSDataOutputStream out = null;

try {

out = fs.create(new Path(remotePath));

} catch (IOException e) {

fs.close();

e.printStackTrace();

return false;

}

// 最后一个参数的意思是使用完之后是否关闭流

try {

IOUtils.copyBytes(in, out, 2048, true);

} catch (IOException e) {

fs.close();

e.printStackTrace();

return false;

}

fs.close();

return true;

}

4.3 安全与权限管理模块

4.3.1 功能概述

安全与权限管理模块负责系统的安全控制,包括用户身份验证、会话管理、权限控制和异常处理等。

4.3.2 核心功能点

-

身份验证

- 用户登录时验证用户名和密码

- 使用Session机制维护用户登录状态

-

权限控制

- 实现登录拦截器,防止未授权用户访问受保护资源

- 限制用户只能访问自己的文件目录

-

异常处理

- 统一处理系统运行时异常

- 提供友好的错误提示信息

4.3.3 关键代码分析

LoginInterceptor.java - 登录拦截器,防止未授权访问:

public class LoginInterceptor implements HandlerInterceptor {

@Override

public boolean preHandle(HttpServletRequest request, HttpServletResponse response, Object handler) throws Exception {

HttpSession session = request.getSession();

if(session.getAttribute("LOGIN_STATUS") != null) {

return true;

}

response.sendRedirect(request.getContextPath() + "/index.jsp");

return false;

}

}

MyExceptionResolver.java - 统一异常处理器:

public class MyExceptionResolver implements HandlerExceptionResolver {

@Override

public ModelAndView resolveException(HttpServletRequest request, HttpServletResponse response, Object handler, Exception ex) {

ModelAndView modelAndView = new ModelAndView();

modelAndView.addObject("error", ex.getMessage());

modelAndView.setViewName("error");

return modelAndView;

}

}

5. 数据库设计

5.1 数据库概述

系统采用MySQL数据库存储用户信息,数据库名为hdfs_pan。

5.2 核心表结构

5.2.1 用户表(user)

| 字段名 | 数据类型 | 约束 | 描述 |

|---|---|---|---|

| id | BIGINT | PRIMARY KEY, AUTO_INCREMENT | 用户ID |

| username | VARCHAR(50) | NOT NULL, UNIQUE | 用户名 |

| password | VARCHAR(50) | NOT NULL | 密码 |

5.3 数据库访问

系统使用MyBatis作为ORM框架,实现了对数据库的高效访问。通过Mapper接口和XML映射文件的方式,将Java对象与数据库表进行映射,实现了数据的持久化操作。

UserMapper.xml - 用户数据访问映射文件:

<?xml version="1.0" encoding="UTF-8" ?>

<!DOCTYPE mapper PUBLIC "-//mybatis.org//DTD Mapper 3.0//EN" "http://mybatis.org/dtd/mybatis-3-mapper.dtd">

<mapper namespace="xyz.kjdtbs.mapper.UserMapper">

<!-- 查询用户列表 -->

<select id="selectUserList" parameterType="xyz.kjdtbs.domain.User" resultType="xyz.kjdtbs.domain.User">

select * from user

<where>

<if test="username != null and username != ''">

and username = #{username}

</if>

<if test="password != null and password != ''">

and password = #{password}

</if>

</where>

</select>

<!-- 插入用户 -->

<insert id="insertUser" parameterType="xyz.kjdtbs.domain.User">

insert into user(username, password) values(#{username}, #{password})

</insert>

<!-- 删除用户 -->

<delete id="deleteUserById" parameterType="long">

delete from user where id = #{id}

</delete>

</mapper>

6. HDFS配置与集成

6.1 HDFS配置文件

系统通过以下配置文件与HDFS进行交互:

- core-site.xml - HDFS核心配置文件:

<configuration>

<!-- 指定NameNode的地址 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

<!-- 指定hadoop数据的存储目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/hadoop/data</value>

</property>

<!-- 配置HDFS网页登录使用的静态用户为hadoop -->

<property>

<name>hadoop.http.staticuser.user</name>

<value>hadoop</value>

</property>

</configuration>

- hdfs-site.xml - HDFS站点配置文件:

<configuration>

<!-- NameNode web端访问地址 -->

<property>

<name>dfs.namenode.http-address</name>

<value>localhost:9870</value>

</property>

</configuration>

6.2 HDFS交互实现

系统通过HdfsDao接口及其实现类HdfsDaoImpl实现与HDFS的交互:

@Repository

public class HdfsDaoImpl implements HdfsDao {

private static Configuration conf;

static {

// 指定访问HDFS时的用户名

System.setProperty("HADOOP_USER_NAME", "hadoop");

// 读取resources中的配置文件

conf = new Configuration();

}

public FileSystem getFileSystem() throws IOException {

return FileSystem.get(conf);

}

}

该实现类负责创建和管理HDFS的FileSystem对象,为上层业务逻辑提供HDFS访问接口。

7. 系统配置

7.1 Spring配置

系统使用Spring框架进行依赖注入和事务管理,主要配置文件包括:

-

applicationContext.xml - Spring核心配置文件:

- 配置组件扫描

- 配置数据源

- 配置MyBatis会话工厂

- 配置事务管理

-

spring-mvc.xml - SpringMVC配置文件:

- 配置控制器组件扫描

- 配置视图解析器

- 配置文件上传解析器

- 配置拦截器

- 配置异常处理器

7.2 Web配置

web.xml - Web应用配置文件:

- 配置Spring监听器

- 配置SpringMVC前端控制器

- 配置字符编码过滤器

7.3 数据库连接配置

jdbc.properties - 数据库连接配置文件:

jdbc.driverClassName=com.mysql.cj.jdbc.Driver

jdbc.url=jdbc:mysql://localhost:3306/hdfs_pan?useUnicode=true&characterEncoding=UTF-8&serverTimezone=UTC

jdbc.username=root

jdbc.password=123456

8. 部署与运行

8.1 环境要求

- JDK 8或以上版本

- MySQL 5.7或以上版本

- Hadoop 3.x版本

- Tomcat 8或以上版本

- Maven 3.x版本

8.2 部署步骤

-

安装和配置Hadoop

- 下载并解压Hadoop安装包

- 配置HDFS相关参数(core-site.xml, hdfs-site.xml等)

- 启动HDFS服务

-

创建数据库

- 启动MySQL服务

- 创建名为

hdfs_pan的数据库 - 执行SQL脚本创建用户表

-

配置项目

- 修改数据库连接配置(jdbc.properties)

- 修改HDFS配置文件(core-site.xml, hdfs-site.xml)

-

构建项目

- 使用Maven构建项目:

mvn clean package - 生成WAR包:

HDFS-Pan-1.0-SNAPSHOT.war

- 使用Maven构建项目:

-

部署项目

- 将WAR包部署到Tomcat的webapps目录

- 启动Tomcat服务器

-

访问系统

- 在浏览器中访问:

http://localhost:8080/

- 在浏览器中访问:

8.3 运行流程

- 用户访问系统首页,选择登录或注册

- 登录成功后,进入文件管理主界面

- 用户可以进行文件和目录的各种操作:

- 浏览文件列表

- 创建新目录

- 上传本地文件

- 下载HDFS文件

- 删除文件或目录

- 操作完成后,用户可以选择退出登录或注销账户

9. 项目总结与展望

9.1 项目总结

HDFS云盘管理系统成功实现了基于Web的HDFS文件管理功能,提供了友好的用户界面和丰富的文件操作功能。系统采用了成熟的Java EE技术栈和MVC架构模式,具有良好的可扩展性和可维护性。通过该系统,用户可以方便地管理HDFS上的文件和目录,极大地提高了工作效率。

9.2 项目亮点

- 友好的用户界面:采用Bootstrap框架构建响应式页面,提供了良好的用户体验

- 完整的文件操作功能:支持文件上传、下载、浏览、创建、删除等各种操作

- 安全的用户管理:实现了用户注册、登录、身份验证和权限控制

- 高效的HDFS交互:通过Hadoop API实现了对HDFS的高效访问

- 可扩展的架构设计:采用分层架构和模块化设计,便于系统扩展和功能升级

9.3 未来展望

虽然系统已经实现了基本功能,但仍有许多可以改进和扩展的地方:

- 文件分享功能:支持用户之间分享文件和目录

- 文件搜索功能:实现基于文件名和内容的文件搜索

- 文件版本控制:支持文件的多版本管理和回滚

- 大文件分块上传:支持大文件的分块上传和断点续传

- 数据统计与分析:提供文件存储统计和使用情况分析

- 移动端支持:开发移动端应用,实现随时随地访问HDFS文件

- 集群监控:集成HDFS集群监控功能,实时显示集群状态

通过不断的改进和扩展,HDFS云盘管理系统将能够更好地满足用户的需求,成为一个功能完善、性能优良的分布式文件管理平台。

10. 附录

10.1 项目目录结构

├── src/

│ ├── main/

│ │ ├── java/

│ │ │ └── xyz/

│ │ │ └── kjdtbs/

│ │ │ ├── controller/ # 控制器层

│ │ │ ├── dao/ # 数据访问层

│ │ │ ├── domain/ # 域模型层

│ │ │ ├── interceptor/ # 拦截器

│ │ │ ├── mapper/ # MyBatis映射接口

│ │ │ ├── resolver/ # 异常解析器

│ │ │ ├── service/ # 业务逻辑层

│ │ │ └── utils/ # 工具类

│ │ ├── resources/ # 配置文件

│ │ │ ├── xyz/kjdtbs/mapper/ # MyBatis映射文件

│ │ │ ├── applicationContext.xml # Spring配置文件

│ │ │ ├── core-site.xml # HDFS核心配置

│ │ │ ├── hdfs-site.xml # HDFS站点配置

│ │ │ ├── jdbc.properties # 数据库连接配置

│ │ │ └── spring-mvc.xml # SpringMVC配置文件

│ │ └── webapp/ # Web资源

│ │ ├── file/ # 文件管理页面

│ │ ├── static/ # 静态资源

│ │ ├── WEB-INF/ # Web应用配置

│ │ ├── index.jsp # 登录页面

│ │ └── register.jsp # 注册页面

│ └── test/ # 测试代码

├── pom.xml # Maven配置文件

└── README.md # 项目说明文档

10.2 核心API列表

| 类名 | 主要功能 |

|---|---|

| UserController | 处理用户注册、登录、退出等请求 |

| FileController | 处理文件上传、下载、浏览等请求 |

| HdfsFileService | 提供文件操作的业务逻辑接口 |

| HdfsFileServiceImpl | 实现文件操作的业务逻辑 |

| HdfsDao | 提供HDFS访问接口 |

| HdfsDaoImpl | 实现HDFS访问功能 |

| LoginInterceptor | 实现登录拦截功能 |

| MyExceptionResolver | 实现统一异常处理 |

| User | 用户实体类 |

| HdfsFile | 文件实体类 |

10.3 常见问题与解决方案

-

HDFS连接失败

- 检查HDFS服务是否正常运行

- 检查HDFS配置文件是否正确

- 检查网络连接是否正常

-

文件上传失败

- 检查文件大小是否超过限制

- 检查HDFS存储空间是否充足

- 检查文件权限设置是否正确

-

用户登录失败

- 检查用户名和密码是否正确

- 检查数据库连接是否正常

- 检查用户是否已注册

-

页面显示异常

- 检查Tomcat服务是否正常运行

- 检查项目部署是否正确

- 检查浏览器缓存是否需要清除

通过以上的详细说明,相信读者已经对HDFS云盘管理系统有了全面的了解。该系统不仅实现了基本的文件管理功能,还提供了良好的用户体验和安全保障,是一个功能完善、性能优良的分布式文件管理平台。

1488

1488

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?