目录

一、Ubuntu的安装

1.创建虚拟机

在安装之前先在VirtualBox创建一个虚拟机,我们为其取名为Ubuntu,如下图所示:

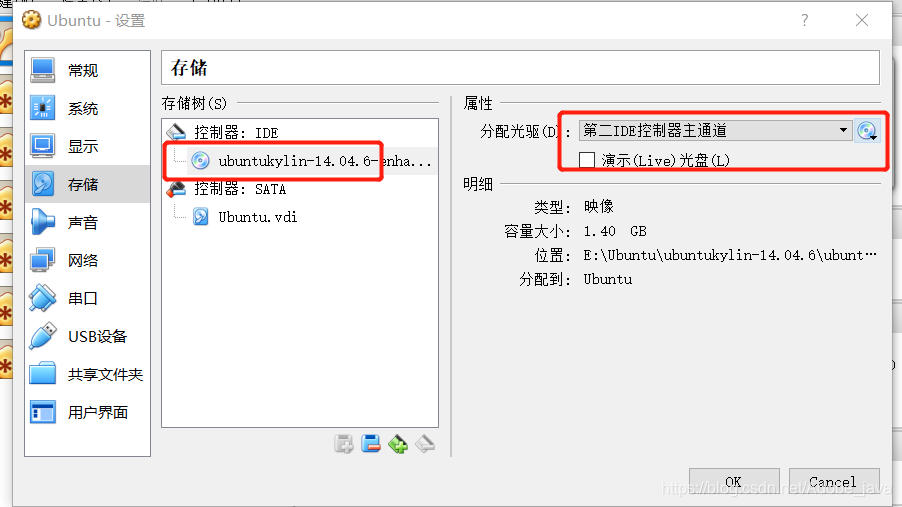

2.添加Ubuntu ISO映像文件

进入存储设置界面后,点击没有盘片,再点击光盘按钮,选择一个虚拟光驱,添加您下载的Ubuntu ISO映像文件,如下图所示:

3.开启虚拟机

开启刚刚创建的虚拟机,启动看到Ubuntu 的安装欢迎界面后,选择你想用的语言。下一步的时候直接点击“继续”按钮,然后选择”其他选项”,在点击继续。

4.创建分区

添加交换空间和根目录,一般选择512MB到1G大小作为交换空间,剩下空间全部用来作为根目录

(1)交换空间:

-

点击“+”按钮后,我们进行如下设置:

-

大小:我们设置512MB

新分区的类型:选择“主分区”选项

新分区的位置:选择“空间起始位置”选项

用于:在下拉列表中选择“交换空间”选项

(2)根目录:

-

点击“+”按钮后,我们进行如下设置:

-

大小:不用改动,系统自动设为剩余的空间

新分区的类型:选择“逻辑分区”选项

新分区的位置:选择“空间起始位置”选项

用于:在下拉列表中选择“EXT4日志文件系统”选项

挂载点:在下拉列表中选择“/”选项

5.开始安装

点击“现在安装”按钮后,会弹出如下界面,询问“ 将改动写入磁盘吗?”,点击“继续”按钮

6.重启

安装完成后重启虚拟机

二、创建hadoop用户

1.创建用户

打开终端窗口,输入如下命令创建新用户 :

sudo useradd -m hadoop -s /bin/bash

使用如下命令设置密码,可简单设置为 hadoop,按提示输入两次密码:

sudo passwd hadoop

为 hadoop 用户增加管理员权限,方便部署,命令如下:

sudo adduser hadoop sudo

最后注销当前用户,返回登陆界面。在登陆界面中选择刚创建的 hadoop 用户进行登陆。

2.更新apt

打开终端窗口,执行如下命令进行更新:

sudo apt-get update

后续需要更改一些配置文件,vim是vi增强版,基本用法相同,建议安装一下vim:

sudo apt-get install vim

3.安装SSH、配置SSH无密码登陆

Ubuntu 默认已安装了 SSH client,此外还需要安装 SSH server:

sudo apt-get install openssh-server

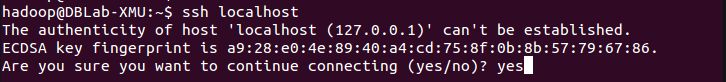

安装后,可以使用如下命令登陆本机:

ssh localhost

SSH首次登陆提示,输入 yes 。然后按提示输入密码 hadoop,这样就登陆到本机了

退出刚才的 ssh,回到了我们原先的终端窗口,然后利用 ssh-keygen 生成密钥,并将密钥加入到授权中:

exit # 退出刚才的 ssh localhost

cd ~/.ssh/ # 若没有该目录,请先执行一次ssh localhost

ssh-keygen -t rsa # 会有提示,都按回车就可以

cat ./id_rsa.pub >> ./authorized_keys # 加入授权

三、安装Java环境

1.安装JDK

在Linux命令行界面中,执行如下Shell命令:

cd /usr/lib

sudo mkdir jvm #创建/usr/lib/jvm目录用来存放JDK文件

cd ~ #进入hadoop用户的主目录

cd Downloads #注意区分大小写字母,刚才已经通过FTP软件把JDK安装包jdk-8u162-linux-x64.tar.gz上传到该目录下

sudo tar -zxvf ./jdk-8u162-linux-x64.tar.gz -C /usr/lib/jvm #把JDK文件解压到/usr/lib/jvm目录下

2.设置环境变量

下面继续执行如下命令,设置环境变量:

cd ~

vim ~/.bashrc

使用上述命令进入环境变量配置文件,在文件头部添加如下内容:

export JAVA_HOME=/usr/lib/jvm/jdk1.8.0_162

export JRE_HOME=${

JAVA_HOME}/jre

export CLASSPATH=.:${

JAVA_HOME}/lib:${

JRE_HOME}/lib

export PATH=${

JAVA_HOME}/bin:$PATH

保存配置后,继续执行如下命令让.bashrc文件的配置立即生效:

source ~/.bashrc

四、安装hadoop

下载好hadoop安装文件后,可使用ftp从主机传到虚拟机内,或者插入u盘后右击右下角的U盘标志,勾选你的U盘(注意别选到鼠标,不过选到了有惊喜!!),如下图所示:

选择将 Hadoop 安装至 /usr/local/ 中:

sudo tar -zxf ~/下载/hadoop-2.6.0.tar.gz -C /usr/local # 解压到/usr/local中

cd /usr/local/

sudo mv ./hadoop-2.6.0/ ./hadoop # 将文件夹名改为hadoop

sudo chown -R hadoop ./hadoop # 修改文件权限

本文详细介绍了如何在Ubuntu虚拟机上安装Hadoop,创建hadoop用户,安装Java环境,配置Hadoop伪分布式,使用Eclipse编译运行MapReduce程序,通过实例演示了如何对文件中的单词进行统计并下载结果。

本文详细介绍了如何在Ubuntu虚拟机上安装Hadoop,创建hadoop用户,安装Java环境,配置Hadoop伪分布式,使用Eclipse编译运行MapReduce程序,通过实例演示了如何对文件中的单词进行统计并下载结果。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2057

2057

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?