超参数设置

超参数的设置直接影响机器学习的速度以及效率

属性

epoch:训练轮数

batch_size:批大小

learning_tate:学习率

#超参数设置

num_epochs=10

batch_size=64

learning_rate=0.001

优化器

涉及到优化算法的那块的对象

adam_optimizer=tf.keras.optimizers.Adam(learning_rate)

编译模型

参数

optimizer:优化器

loss:损失函数

metrics:评价

mode.compile(optimizer=adam_optimizer,

loss=tf.keras.losses.sparse_categorical_crossentropy,

metrics=['accuracy'])

训练模型

参数

x:训练数据

y:训练数据标签

batch_size:批大小

epochs:训练遍数(轮数)

mode.fit(x=x_train,y=y_train,

batch_size=batch_size,epochs=num_epochs)

保存模型

保存模型很简单,直接一个save函数就可以了

mode.save("model.h5")

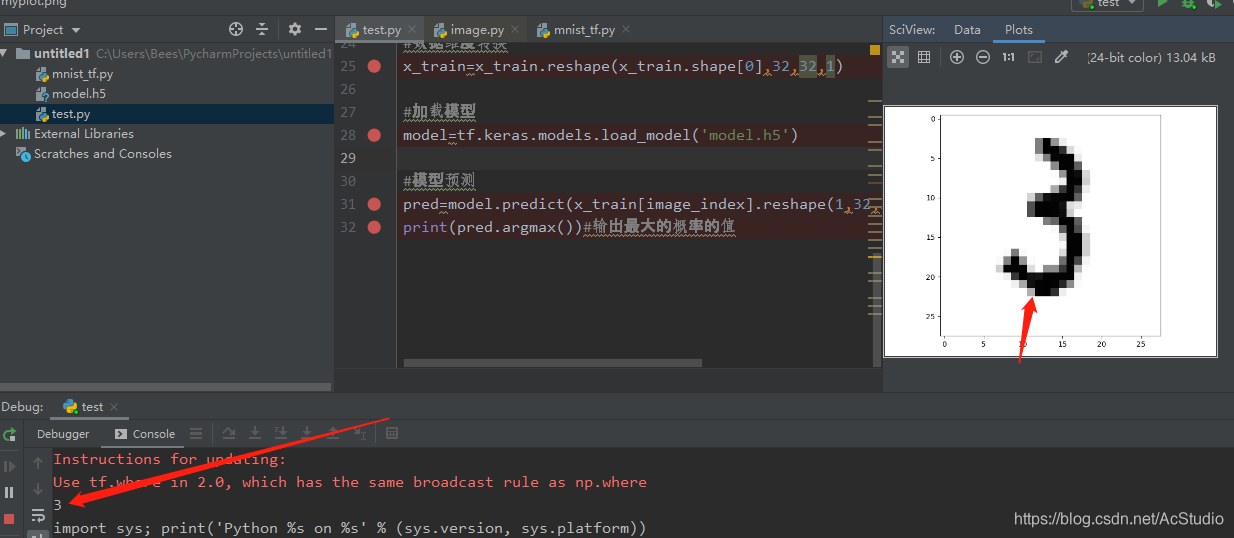

加载模型

加载模型也很简单直接调用函数就好

#加载模型

model=tf.keras.models.load_model('model.h5')

模型预测

参数

x:输入数据

#模型预测

pred=mode.predict(x_test[image_index].reshape(1,32,32,1))

print(pred.argmax())#输出最大的概率的值

我们看一下预测的图片

图像为3输出为3

本文详细介绍了机器学习中关键的超参数设置,包括epoch、batch_size和learning_rate的作用及影响。通过实例展示了如何使用Adam优化器进行模型编译,并进行模型训练、保存与加载,最后对模型进行预测。

本文详细介绍了机器学习中关键的超参数设置,包括epoch、batch_size和learning_rate的作用及影响。通过实例展示了如何使用Adam优化器进行模型编译,并进行模型训练、保存与加载,最后对模型进行预测。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?