目录

前言

📅大四是整个大学期间最忙碌的时光,一边要忙着备考或实习为毕业后面临的就业升学做准备,一边要为毕业设计耗费大量精力。近几年各个学校要求的毕设项目越来越难,有不少课题是研究生级别难度的,对本科同学来说是充满挑战。为帮助大家顺利通过和节省时间与精力投入到更重要的就业和考试中去,学长分享优质的选题经验和毕设项目与技术思路。

🚀对毕设有任何疑问都可以问学长哦!

大家好,这里是海浪学长计算机毕设专题,本次分享的课题是

🎯基于深度卷积网络的手势识别技术

项目背景

手势识别在人机交互中扮演着重要角色,然而传统方法存在鲁棒性低、部署困难等问题。随着科技的发展,人机交互越来越广泛应用于日常生活,为了满足用户需求,快速、准确地识别手势成为备受关注的研究话题。本篇博文介绍了一项基于深度学习的手势识别研究,利用深度学习技术提高手势识别的准确性和鲁棒性。通过构建一个深度学习模型,我们能够快速、准确地识别手势,并将其应用于人机交互系统。

设计思路

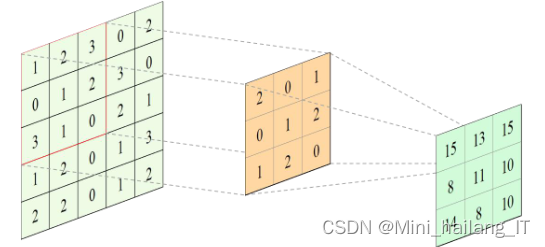

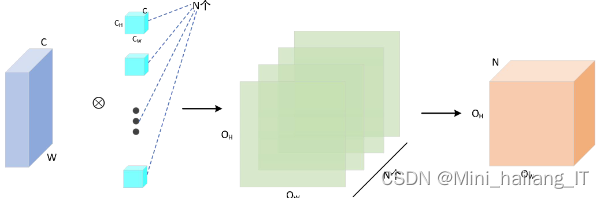

传统的神经网络与卷积神经网络在连接方式上有所不同,卷积神经网络采用局部连接和权值共享的方式,具有稀疏的连通性和加速网络训练的优势。卷积层是卷积神经网络的重要组成部分,负责对输入图片进行特征提取。池化层在卷积层之后进行处理,通过减少特征图的冗余信息、降低计算量和抑制过拟合等方式提升网络性能。深度学习的卷积神经网络模型在图像识别、自动驾驶、农业和医疗等领域得到了广泛应用。

在卷积神经网络中,输入特征图的通道数决定了卷积核的通道数。当使用单个卷积核时,输出特征图的通道数为一。如果需要多个特征图通道,需要使用相应数量的卷积核。输出特征图的高宽与输入特征图的通道数无关,计算关系仍然符合相应的公式。通过卷积运算,每个卷积核会生成一个单通道的特征图,最终合并形成具有所需通道数的新特征图。

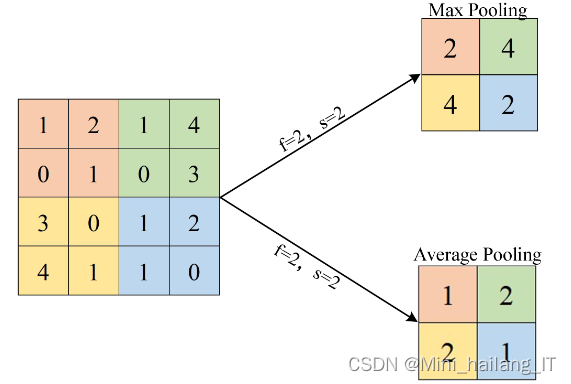

池化层在卷积层之后,对目标区域的数据进行处理,不进行卷积运算。池化操作不改变特征图的通道数,而是改变特征图的高度和宽度。它可以减少特征图中冗余的信息,降低计算量,加快模型训练速度,并抑制过拟合现象,提升网络的鲁棒性。最大池化和平均池化是常见的池化方式,最大池化取池化窗口内的最大值,平均池化取池化窗口内的平均值。在图像识别领域,最大池化被广泛使用。

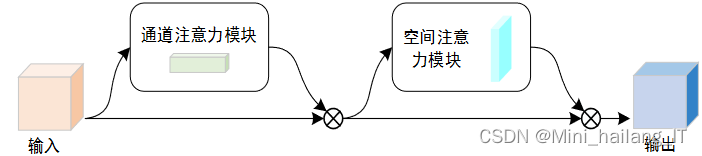

CBAM(通道注意力机制模块)和SENet(Squeeze-and-Excitation网络)在通道注意力机制的结构上存在细微差别。SENet在挤压阶段仅使用全局平均池化,可能会导致部分必要的特征信息丢失。CBAM在通道注意力机制中增加了最大池化,以验证最大池化和平均池化结合的必要性。,CBAM和SENet的注意力机制进行串联时,先后顺序对模型的精度产生影响。在ResNet50上的实验总结出最佳组合策略是先应用通道注意力机制,然后再应用空间注意力机制。

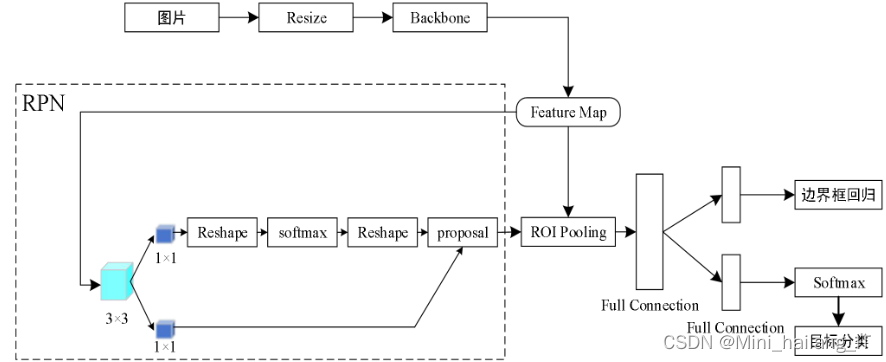

Faster R-CNN是一种目标检测算法,也被称为two-stage算法,因为它在检测过程中需要生成候选区域。相比于RCNN和Fast R-CNN,Faster R-CNN结构更加完善,检测效果更好。它由两部分组成:区域建议网络(RPN)和Fast R-CNN。Fast R-CNN的主干特征提取网络可以是ResNet、VGG等,原论文中使用的是VGG作为骨干特征提取网络。输入图片后,进行大小调整(Resize)以适应骨干特征提取网络的输入,然后进行特征提取,输出共享特征图(Feature Map)。共享特征图会进入两个不同的分支:左边分支是RPN网络,进行一系列卷积操作用于分类和回归,生成建议框;右边分支是ROI Pooling层,对不同大小的特征图进行分区域的池化,最终输出相同大小的特征图,用于物体的分类和回归预测。

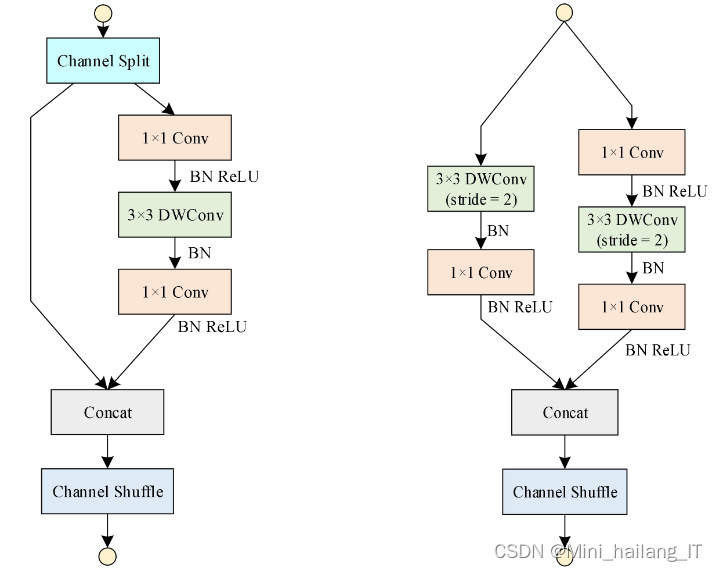

ShuffleNet V2是一种轻量级网络模型,是在ShuffleNet V1的基础上进一步优化的网络结构。根据网络Stage单元输出的通道数不同,ShuffleNet V2被划分为ShuffleNet V2-0.5×/1×/1.5×/2×。为确保ShuffleNet V2在使用过程中的高效性,网络设计原则包括:a) 输入特征图通道数等于输出特征图通道数;b) 分组卷积的分组数适当;c) 尽可能减少碎片化操作(网络的串行支路或并行支路);d) 减少Element wise(指激活函数、偏置等)操作。

数据集

由于网络上没有现有的合适的手势识别数据集,我决定自己进行数据收集,制作一个全新的数据集。这个数据集包含了各种手势的照片,其中包括不同角度、不同光照条件下的手势示例。通过自己拍摄照片,我能够捕捉到真实的手势动作和多样的环境背景,这将为我的手势识别研究提供更准确、可靠的数据。我相信这个自制的数据集将为手势识别领域的研究和发展提供有力的支持,并为手势识别技术的应用做出积极贡献。

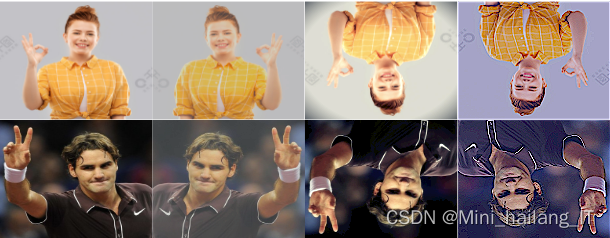

数据扩充是一种常用的技术,可通过对现有数据进行变换和增强来增加训练集的大小和多样性。对手势识别数据集的数据扩充可采用图像翻转、旋转缩放、平移裁剪、亮度对比度调整、噪声添加、颜色变换和数据组合等方法。这些方法可以单独或组合使用,根据任务和数据集特点选择适合的扩充方式。数据扩充能有效提高模型的泛化能力、鲁棒性和性能,通过增加训练样本数量和多样性,提升手势识别模型的表现。

手势数据集使用LabelImg图像标注软件进行人工标注,并生成对应的XML文件。在标注过程中,从物体的左下方往上画矩形框,确保物体完全包含在矩形框内。生成的XML文件包含物体的类别名称和标定的矩形框信息。

import os

import xml.etree.ElementTree as ET

def generate_xml(filename, width, height, objects):

root = ET.Element("annotation")

size = ET.SubElement(root, "size")

ET.SubElement(size, "width").text = str(width)

ET.SubElement(size, "height").text = str(height)

ET.SubElement(size, "depth").text = str(3) # Assuming RGB images

for obj in objects:

obj_elem = ET.SubElement(root, "object")

ET.SubElement(obj_elem, "name").text = obj["name"]

bbox = ET.SubElement(obj_elem, "bndbox")

ET.SubElement(bbox, "xmin").text = str(obj["xmin"])

ET.SubElement(bbox, "ymin").text = str(obj["ymin"])

ET.SubElement(bbox, "xmax").text = str(obj["xmax"])

ET.SubElement(bbox, "ymax").text = str(obj["ymax"])

tree = ET.ElementTree(root)

tree.write(filename)

# Example usage

width = 640

height = 480

objects = [

{"name": "gesture1", "xmin": 100, "ymin": 200, "xmax": 300, "ymax": 400},

{"name": "gesture2", "xmin": 400, "ymin": 100, "xmax": 550, "ymax": 250}

]

filename = "example.jpg"

xml_filename = os.path.splitext(filename)[0] + ".xml"

generate_xml(xml_filename, width, height, objects)模型训练

该配置为Windows 11操作系统,搭载I7处理器和NVIDIA GeForce RTX 3070 LHR显卡。内存条使用DDR5技术,容量为16GB。深度学习环境基于PyTorch 1.7.1框架,GPU加速环境使用Cuda 11.0和cudnn 8.0.5.39。编程语言为Python 3.7。

改进后的模型选择了大小为416×416的图片作为输入,以平衡检测精度和计算量的关系。学习率的范围是根据深度学习模型的结构、数据集规模和其他超参数等经验总结得出的,最高学习率为0.01,最低学习率为0.0001。训练分为冻结阶段和解冻阶段,前50个epoch为冻结阶段,使用batch size为16,后130个epoch为解冻阶段,使用batch size为8。优化器选择了随机梯度下降(SGD),并使用余弦退火算法来调整学习率。这些设置旨在平衡训练时间和模型性能,以达到较好的训练效果。

import torch

import torch.optim as optim

import torch.optim.lr_scheduler as lr_scheduler

import torchvision.transforms as transforms

from torch.utils.data import DataLoader

# Set image size

image_size = (416, 416)

# Set learning rate range

lr_max = 0.01

lr_min = 0.0001

# Set training epochs and batch sizes for freeze and unfreeze stages

freeze_epochs = 50

unfreeze_epochs = 130

freeze_batch_size = 16

unfreeze_batch_size = 8

# Create optimizer with stochastic gradient descent (SGD)

optimizer = optim.SGD(model.parameters(), lr=lr_max)

# Create learning rate scheduler using cosine annealing

scheduler = lr_scheduler.CosineAnnealingLR(optimizer, T_max=unfreeze_epochs)

# Define transformations for image resizing and normalization

transform = transforms.Compose([

transforms.Resize(image_size),

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225])

])

# Create data loader for training data

train_dataset = YourDataset(...) # Replace with your dataset

train_dataloader = DataLoader(train_dataset, batch_size=freeze_batch_size, shuffle=True)

# Train freeze stage

for epoch in range(freeze_epochs):

for images, labels in train_dataloader:

# Perform forward and backward pass

...

# Update model parameters

optimizer.step()

# Adjust learning rate

scheduler.step()

# Clear gradients

optimizer.zero_grad()

# Update batch size and data loader for unfreeze stage

train_dataloader = DataLoader(train_dataset, batch_size=unfreeze_batch_size, shuffle=True)

# Train unfreeze stage

for epoch in range(unfreeze_epochs):

for images, labels in train_dataloader:

# Perform forward and backward pass

...

# Update model parameters

optimizer.step()

# Adjust learning rate

scheduler.step()

# Clear gradients

optimizer.zero_grad() 深度学习在手势识别中的应用:模型训练策略与技术解析

深度学习在手势识别中的应用:模型训练策略与技术解析

本文介绍了基于深度卷积网络的手势识别项目,涉及项目背景、设计思路(包括卷积神经网络、注意力机制、目标检测算法如FasterR-CNN和轻量级网络ShuffleNetV2),以及数据集的创建、数据扩充和模型训练的详细步骤,使用了PyTorch框架和优化策略。

本文介绍了基于深度卷积网络的手势识别项目,涉及项目背景、设计思路(包括卷积神经网络、注意力机制、目标检测算法如FasterR-CNN和轻量级网络ShuffleNetV2),以及数据集的创建、数据扩充和模型训练的详细步骤,使用了PyTorch框架和优化策略。

7583

7583

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?