10月29日凌晨,英伟达GTC大会首次在华盛顿召开。黄仁勋直接亮出下一代GPU核弹——Vera Rubin,相较于九年前,他亲手交付给OpenAI的首个超算DGX-1,性能足足提升了100倍。并且预计10月可以投产!

目前,Blackwell已全面量产。

2026年底两大GPU王牌预计爆赚5000亿美金!

AI的世界,远不止ChatGPT

在近两小时演讲中,老黄不仅再次上演了一波AI“美队”,而且还给出了AI时代独一份的洞察——AI不是工具,而是会用工具的「工人」。

他就给大众认知来了一个降维打击,AI并不等于聊天机器人。他将其比作一个数据密集型的「编程」,在CPU时代的旧世界,人们手工编码,软件在CPU上运行,Windows主导了一切。而在当下,机器学习训练,模型直接跑在GPU之上。能源-GPU-超算-模型-应用,全栈的能力构成了完整的AI。

过去的软件产业,本质上是在「造工具」,Excel、Word、浏览器皆是工具。但AI不是工具,是「工人」。

这回是历史上头一次,技术自己会「干活」了!

老黄举例道,英伟达每一位工程师都在用Cursor,生产力得以大幅提升。而Cursor使用的工具是VS Code。AI本身也正在成为一个「全新的产业」,当人们把各种形式的信息编程token之后,就需要一个「AI工厂」。

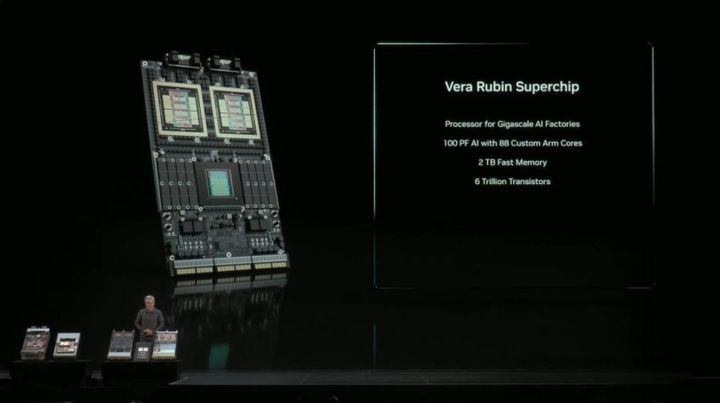

Vera Rubin首秀,性能狂飙百倍

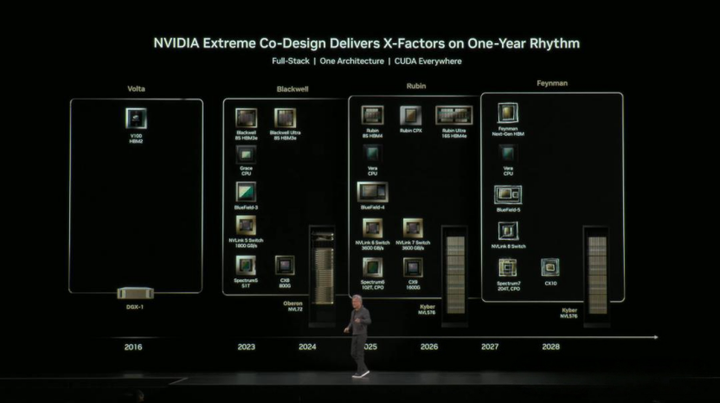

现场,老黄再次搬出了未来三年英伟达GPU路线图,从Blackwell,到Rubin,再到Feynman。

下一代Vera Rubin的首次亮相。这是英伟达第三代NVLink 72机架级超级计算机,彻底实现了无线缆连接。目前,已在实验室完成测试。

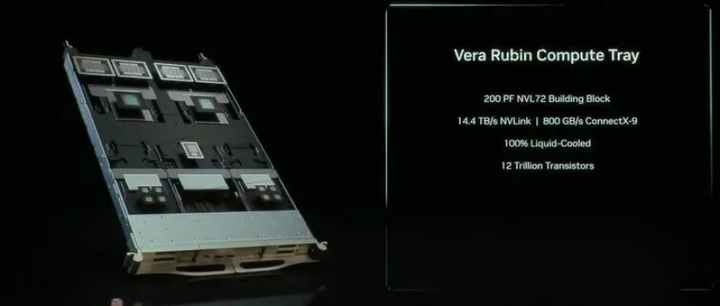

这块超级芯片计算能力达到100 Petaflops,是DGX-1性能的100倍。换句话说,以前需要25个机架,现在一个Vera Rubin就能完成。如下,便是Rubin计算托盘,推理性能可达440PF。

🔵其底部配备了8个Rubin CPX GPU、BlueField-4数据处理器,还有两颗Vera CPU,以及4个Rubin封装——总共8个GPU,全部实现了无缆、全液冷。同时,英伟达还引入了一种全新「上下文处理器」(Context Processor),支持超100万token上下文。此外,BlueField-4革命性处理器,可以加速AI模型加载时间。还有NVLink交换机,可以让所有GPU步传输数据;以太网交换机Spectrum-X可以确保处理器同时通信而不拥堵。再加上Quantum交换机,三者结合,系统全部兼容InfiniBand、Quantum 和 Spectrum Ethernet。

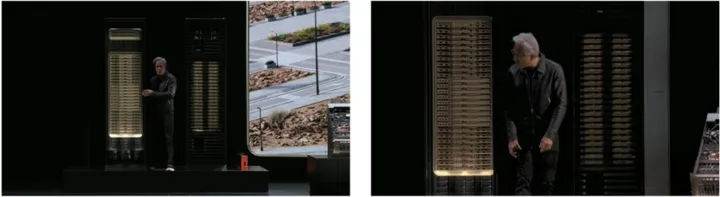

所有这些组合起来,一个完整的机架塞满150万个零件,重量足足有两吨!它的主干网络,一秒内就能传输相当于整个互联网的流量,刷新全球最快的token生成速度。老黄表示,

老黄表示,「一个1GW规模的数据中心,大概需要8000-9000台这样的机架。这就是未来的AI工厂」!

预测,在2026年底前,仅凭「Blackwell+Rubin」就足以冲击5000亿美元的营收。而且,这一数字还未将中国市场计算在内。

10x的性能,1/10的成本

「AI工厂」不同于过去的数据中心,是因为它基本上只做一件事——运行AI。

一来,生产尽可能有价值、更智能的token;

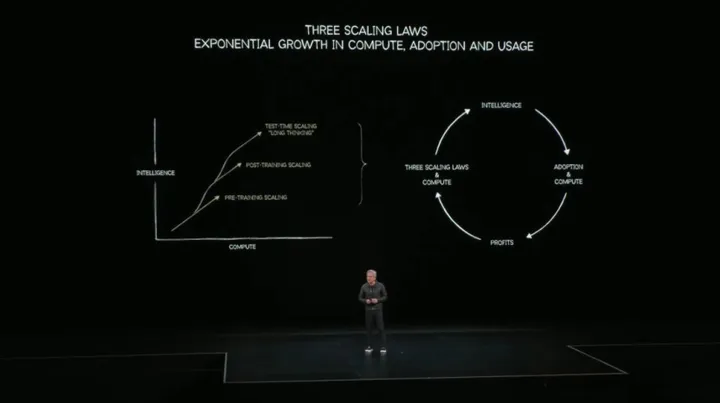

其次,要用极高的速度将其生产出来。过去两年,业界让AI学会了变得更加聪明的方法,预训练是第一阶段。下一步就是后训练,再之后就是测试时,让AI不断思考(Long Thinking)。

这也是老黄一直以来,反复强调的三大Scaling Law。模型越聪明,使用的人越多;用的人越多,需要的算力越多。

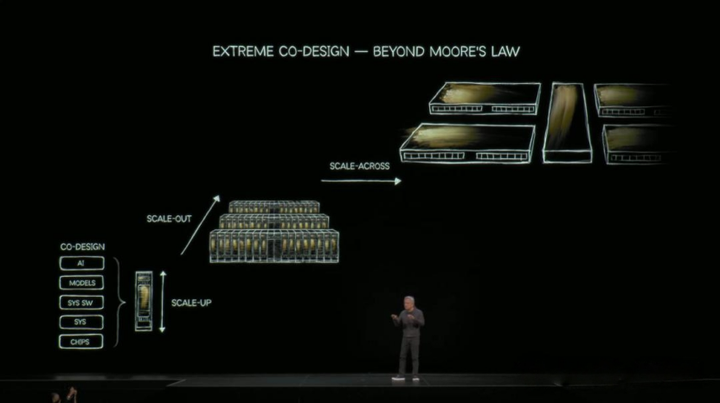

英伟达是当今世界上,唯一一家真正从一张白纸开始,同时思考芯片、系统、软件、模型、应用的公司。他们的协同设计,将AI算力实现了从Scale up到Scale out,再到Scale across的扩展。

Grace Blackwell NVL72,一台思考机器,就是英伟达「协同设计」的典型代表。

🔵为了驾驭万亿级参数模型,它采用了MoE架构。传统系统受限于GPU间互联带宽,一块GPU要扛32位专家的计算。在NVLink 72架构下,每块GPU可以放4位专家。SemiAnalysis最新基准测试显示,Grace Blackwell每块GPU的性能,是H200的十倍。只多了一倍晶体管,速度却快了十倍,秘诀就在于——极致协同设计。GB200,这台世界上最昂贵的计算机,却能生成成本最低的token。

它的极致性能,均摊了每一次计算的总拥有成本(TCO),也就是说——10倍性能,十分之一成本。

而此刻,这一突破正逢其时。全球六大云巨头的资本支出曲线(CapEx),正以史无前例的速度飙升。英伟达也官宣未来要联手能源部,建七大全新AI超算。

接下来的一系列震撼合作,将英伟达的AI帝国展示在了所有人面前:

1.AI原生6G:推出「AI on RAN」技术,将AI与6G网络深度融合,让基站成为边缘的AI计算中心。

2.超算基建:与美国能源部合作,建造7座全新的AI超算。

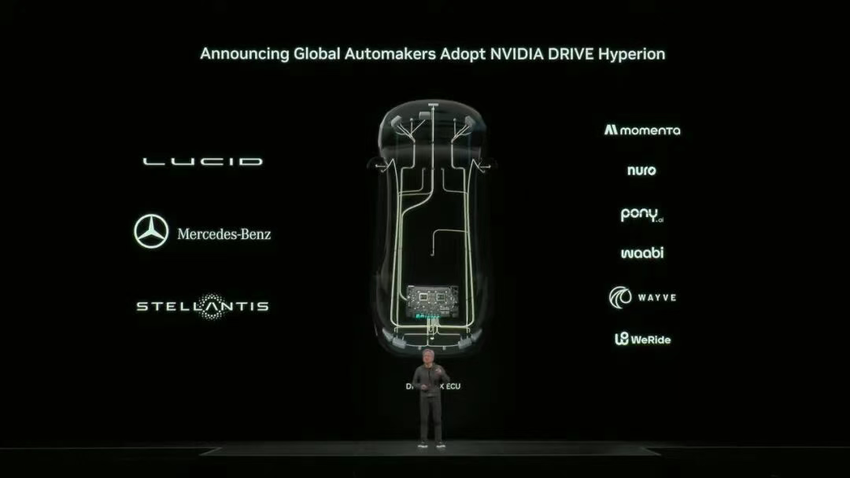

3.自动驾驶:发布「开箱即用」的DRIVE Hyperion平台,快速部署L4级自动驾驶系统。

4.量子计算:发布NVQLink技术,首次将AI超算与量子处理器无缝连接,加速量子计算的实用化进程。

5.物理AI:通过Omniverse中的数字孪生技术,训练「物理AI」,加速机器人在现实世界中的部署,目标直指美国「再工业化」。

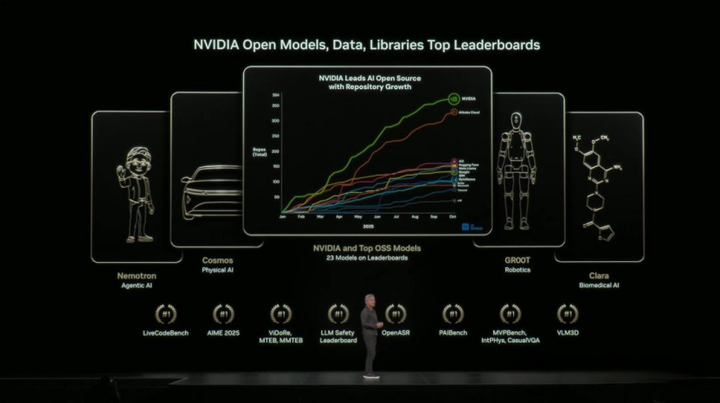

开源扛把子,没有弱项

英伟达不仅是算力之王,更是AI生态的绝对核心。「过去几年,开源AI在推理、多模态、蒸馏效率三大维度上,实现巨大飞跃」。

全世界,都离不开开源。目前英伟达在全球开源贡献榜上,23个模型上榜,覆盖了语言、物理AI、语音、推理等全领域。下载量也非常惊人。

⭐未来的竞争将是“AI生产力”的竞争,而英伟达正在为世界提供这套最核心的生产资料。其构筑的生态壁垒已难以逾越。面对未来,真正的“安全毯”不是一份稳定的工作,而是持续进化的能力……

你有什么感想,欢迎评论区交流!

黄仁勋发布百倍性能GPU

黄仁勋发布百倍性能GPU

739

739

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?