系列文章目录

第一章 AlexNet网络详解

第二章 VGG网络详解

第三章 GoogLeNet网络详解

第四章 ResNet网络详解

第五章 ResNeXt网络详解

第六章 MobileNetv1网络详解

第七章 MobileNetv2网络详解

第八章 MobileNetv3网络详解

第九章 ShuffleNetv1网络详解

第十章 ShuffleNetv2网络详解

第十一章 EfficientNetv1网络详解

第十二章 EfficientNetv2网络详解

第十三章 Transformer注意力机制

第十四章 Vision Transformer网络详解

第十五章 Swin-Transformer网络详解

第十六章 ConvNeXt网络详解

第十七章 RepVGG网络详解

第十八章 MobileViT网络详解

0、前言

1.这篇论文讨论了通过深度卷积神经网络对大规模图像数据进行分类问题。

2.该论文的研究背景是有关图像分类问题,先前的方法存在问题,因此需要诞生新的研究方法。

3.该论文的主要观点是建立了一个大型深度卷积神经网络,能够将图像分类任务的错误率显著提高。

4.先前的研究方法主要是浅层的神经网络模型,以及传统方法如手工设计特征等,这些方法缺乏对于大尺寸数据的适应性和准确性不高的问题。

5.该论文提出了一个深度卷积神经网络模型进行图像分类任务,采用非饱和神经元、子采样和dropout等技巧以提高模型的性能和训练效率。

6.研究的发现表明,该深度卷积神经网络模型能够有效地提高图像分类任务的准确性,但研究的局限性在于其不适用于其他领域的数据集。

1、摘要

我们训练了一个大规模、深度的卷积神经网络,将ImageNet LSVRC-2010竞赛中的120万张高分辨率图像分类为1000个不同类别。在测试数据上,我们取得了37.5%的top-1误差率和17.0%的top-5误差率,这比之前的最先进技术要好得多。该神经网络有6000万参数和65万个神经元,由五个卷积层和一些最大池层以及三个完全连接层和一个最终的1000路softmax组成。为了加速训练,我们采用了非饱和神经元和非常高效的GPU实现卷积操作。为了减少完全连接层的过拟合,我们采用了一个最近开发的正则化方法,称为“dropout”,证明非常有效。我们还参加了ILSVRC-2012比赛,并取得了15.3%的获胜top-5测试误差率,相比第二名的26.2%要好得多。

2、AlexNet网络结构

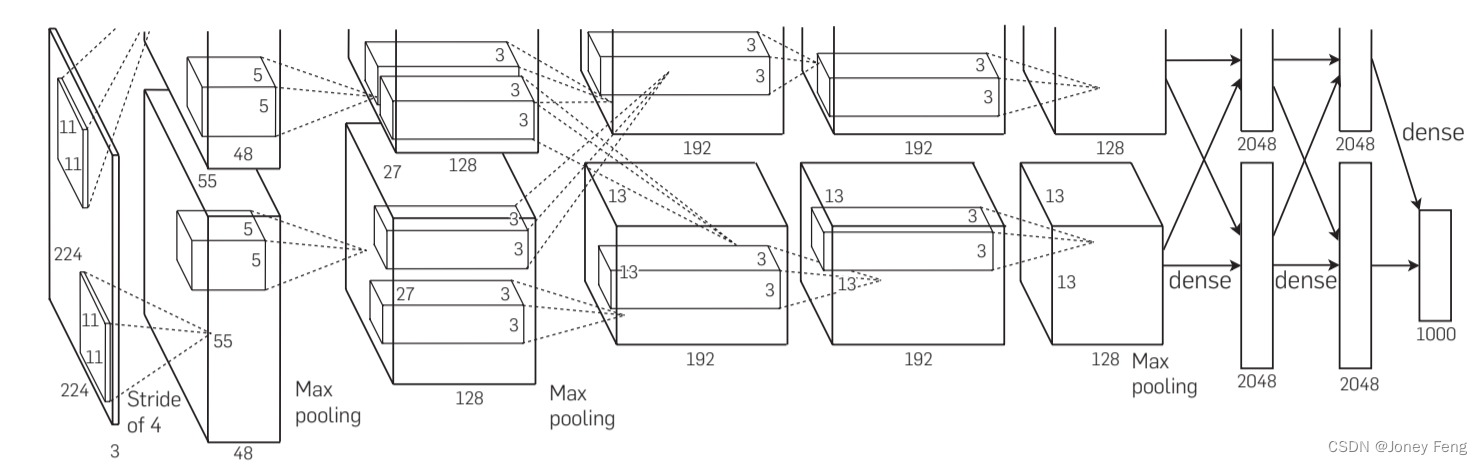

AlexNet是在ImageNet Large Scale Visual Recognition Challenge(ILSVRC)比赛中取得大胜的深度卷积神经网络,于2012年由Alex Krizhevsky等人提出。AlexNet是一个8层的卷积神经网络,它的结构如下所示: 输入图像尺寸为224×224,第一层是一个卷积层,使用96个大小为11×11的滤波器提取特征。在此之后,使用ReLU激活函数进行非线性变换,并使用局部响应归一化(LRN)方法进行特征增强。接下来,使用步长为2的2×2最大池化进行下采样。第二层和第三层都是卷积层,分别使用256和384个滤波器,滤波器的大小为5×5。使用ReLU激活函数进行非线性变换。第四层是一个具有256个滤波器的卷积层,大小为3×3。之后再次使用ReLU激活函数进行非线性变换。第五层是一个具有256个滤波器的卷积层,大小为3×3。和前面一样,再次使用ReLU激活函数进行非线性变换。最后使用2×2最大池化进行下采样。 在卷积层和池化层之后,网络连接了三个全连接层。这三个全连接层分别包含4096,4096和1000个神经元。最后一层包含1000个神经元,代表1000个ImageNet类别的预测概率。网络最后使用softmax函数输出预测值。

该网络的创新点在于:

(1)首次利用GPU进行网络加速训练。

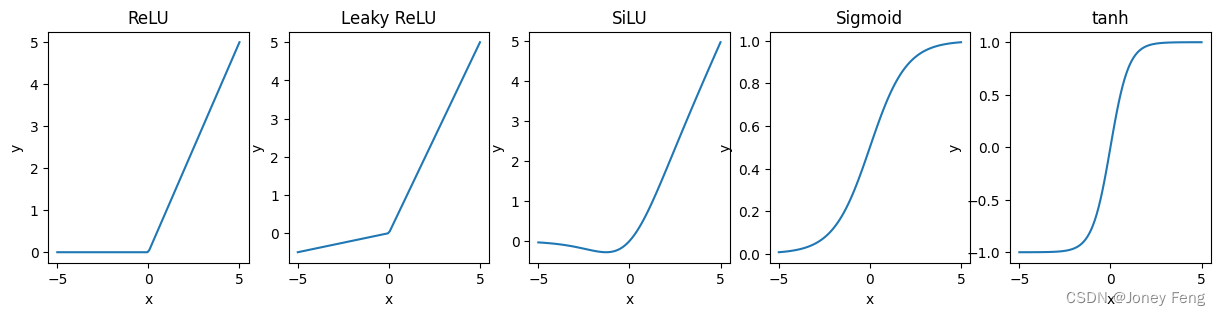

(2)使用了ReLU激活函数代替传统的Sigmoid以及Tanh激活函数。

(3)使用LRN(Local Response Normalization)局部响应归一化。

LRN局部相应归一化的全称是Local Response Normalization,意为局部响应归一化。它是一种常用的神经网络正则化技术,用于减少过拟合,提高模型的泛化能力。具体来说,LRN会对每个神经元的输出进行归一化,使得神经元的输出值受到相邻神经元的影响程度降低,从而增强了模型的鲁棒性和泛化能力。 在具体实现中,LRN会对每个神经元的输出进行归一化。

(4) 在全连接层的前两层使用了Dropout随机失活神经元操作以减少过拟合。

过拟合:根本原因是特征维度过多,模型假设过于复杂,参数过多,训练数据过少,噪声过多,导致拟合的参数完美的预测训练集,但对新数据的测试集预测结果差,过度的拟合了训练数据,而没有考虑到泛化能力。

本文详细介绍了AlexNet网络的结构、工作原理及其在ImageNet大规模图像分类挑战中的突破。AlexNet是首个成功应用深度学习的CNN模型,通过非饱和神经元(ReLU)、局部响应归一化和Dropout等技术,减少了过拟合,显著提高了准确性。此外,文章还讨论了数据增强和GPU并行计算在训练大型模型中的重要性。

本文详细介绍了AlexNet网络的结构、工作原理及其在ImageNet大规模图像分类挑战中的突破。AlexNet是首个成功应用深度学习的CNN模型,通过非饱和神经元(ReLU)、局部响应归一化和Dropout等技术,减少了过拟合,显著提高了准确性。此外,文章还讨论了数据增强和GPU并行计算在训练大型模型中的重要性。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?