介绍

Dectask 是一款基于人工智能的新一代高性能项目管理工具,专为现代团队打造。它兼具企业级功能与轻量级体验,在保持系统简洁易用的同时,提供强大的项目管理能力。 Dectask 完美平衡了功能丰富性与操作简便性,能够替代 Jira、飞书项目、Notion 和 Trello 等传统工具,让项目管理更智能、更高效。

安装方式

Dectask 提供了多种安装方式,你可以根据自己的需求选择合适的方式进行安装,安装方式有:

普通安装

一键安装

docker安装

docker-compose安装

系统要求

- 操作系统:Windows 7或更高版本,macOS 10.15 或更高版本,或 Ubuntu 18.04 或 Centos 7.0 或更高版本

- 内存:建议 4GB 或更多

- 硬盘空间:建议 10GB 或更多

- 浏览器:最新版本的 Chrome、Firefox 或 Safari

安装步骤

Dectask依赖Mysql数据库,所以需要先安装Mysql数据库。Redis数据库是可选的,建议安装和启用,以提高性能。

1.下载和安装Mysql8数据库

Dectask 依赖于 Mysql8 数据库,你需要先安装 Mysql8 数据库。根据你的操作系统,选择合适的版本进行下载:

安装Mysql后,使用Mysql客户端如Navicat或Mysql Workbench,创建数据库dectask,字符集为utf8mb4,并创建用户dectask和密码。 同时解除Mysql严格模式。

-- 解除严格模式

SET GLOBAL sql_mode='NO_ENGINE_SUBSTITUTION';

-- 创建数据库dectask

CREATE DATABASE IF NOT EXISTS dectask CHARACTER SET utf8mb4 COLLATE utf8mb4_unicode_ci;

-- 创建用户dectask,密码

CREATE USER 'dectask_user'@'%' IDENTIFIED BY 'dectask_password';

-- 授权用户dectask_user

GRANT ALL PRIVILEGES ON dectask.* TO 'dectask_user'@'%';

-- 刷新权限

FLUSH PRIVILEGES;2.下载 Dectask

根据你的操作系统,选择合适的版本进行下载:

将下载好的文件解压到一个目录中,例如:/data/dectask,并赋予该目录读写权限

3.安装和启动 Dectask

将下载好的Dectask解压到一个目录中,例如:/opt/dectask 在解压后的目录中,编辑 config.yaml 文件,将数据库连接信息填写正确。

#其他内容暂不配置

mysql:

path: 'localhost:3306'

config: 'charset=utf8mb4&parseTime=True&loc=Local'

dbname: 'dectask'

username: 'dectask'

password: '修改为自己的密码'安装过程需要打开命令行窗口,切换到Dectask目录,执行以下命令安装Dectask。

./dectask install zh_cn

# 安装成功后会输出管理员账号和密码,请牢记

# 装成功后会输出管理员账号和密码,请牢记安装成功后,执行以下命令启动Dectask。

./dectask守护进程方式运行

./dectask -d停止和重启命令

./dectask stop

./dectask restart之后就可以在浏览器 http://localhost:8888/login 上访问 Dectask 了.如需要修改端口,可以在config.yaml中修改.

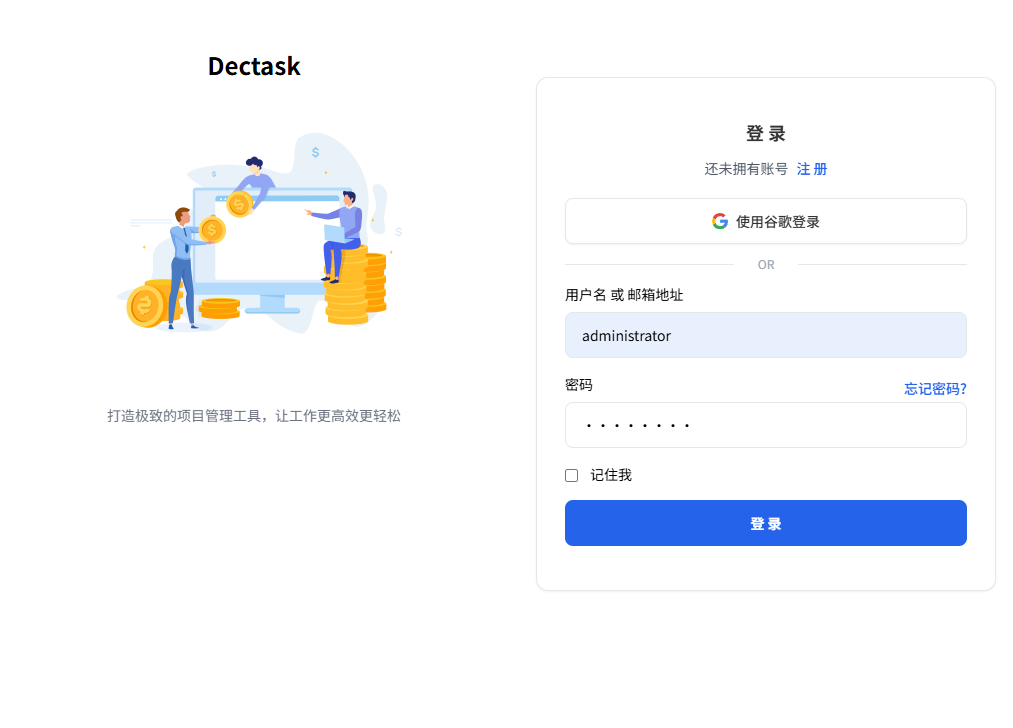

登录界面如下

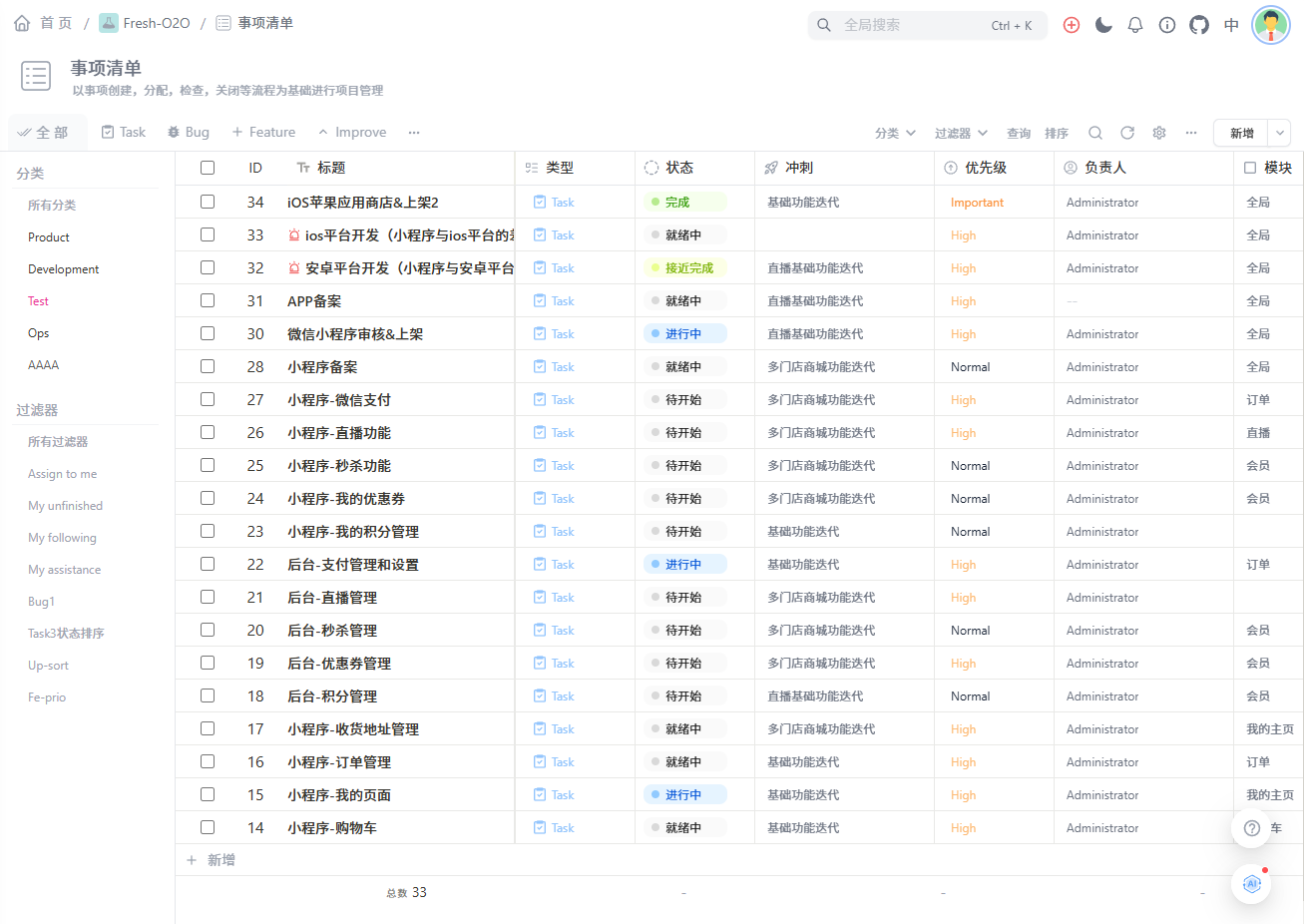

事项管理界面

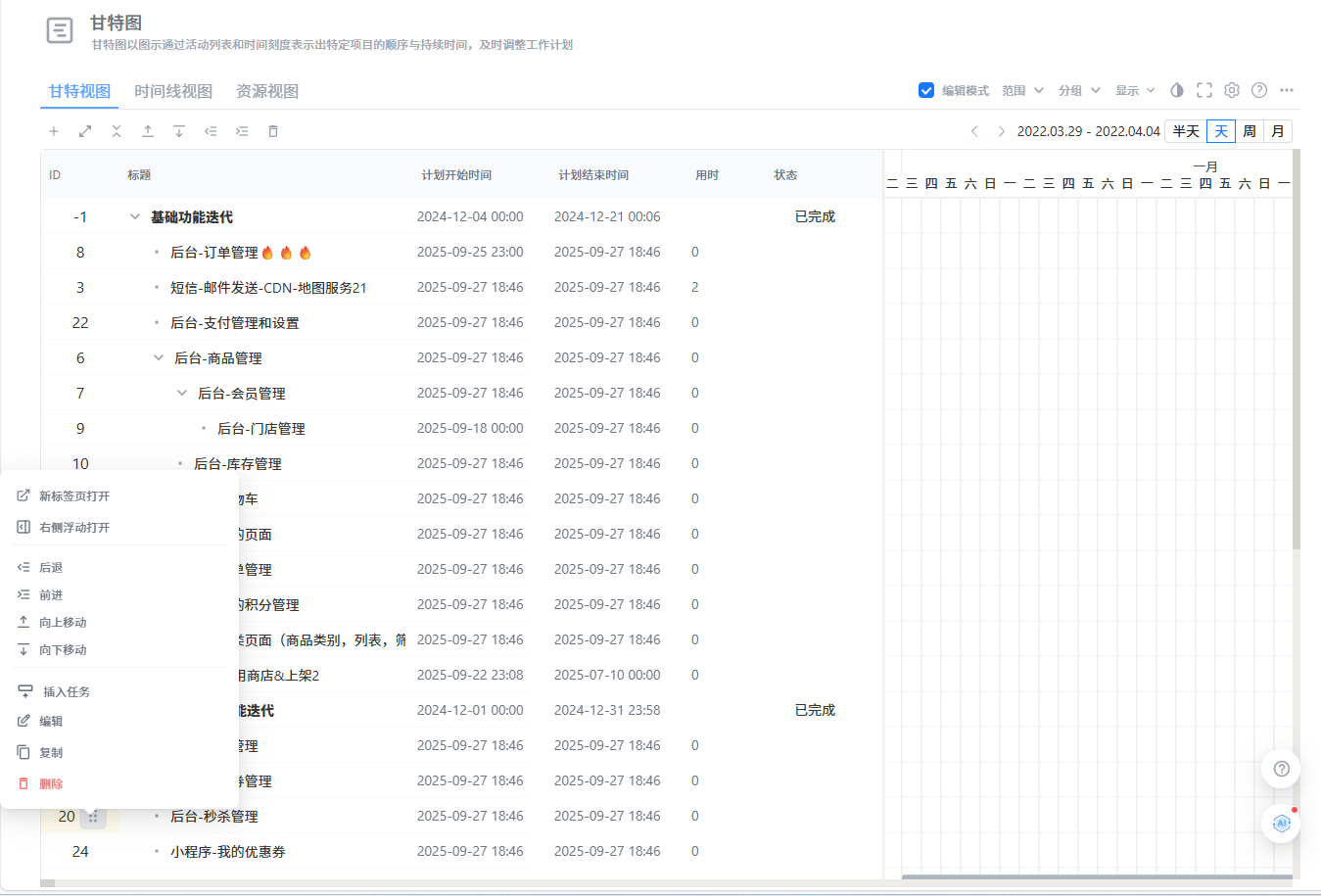

甘特图界面

4.安装和启用Redis(可选)

Dectask 建议安装和启用 Redis 数据库,以提高性能。根据你的操作系统,选择合适的版本进行下载:

- Redis下载:下载链接

安装 Redis 后,编辑 config.yaml 文件,将 Redis 连接信息填写正确。

#redis配置,根据实际情况修改

redis:

db: 0

addr: '127.0.0.1:6379'

password: ''重启命令

./dectask restart

2048

2048

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?