引言

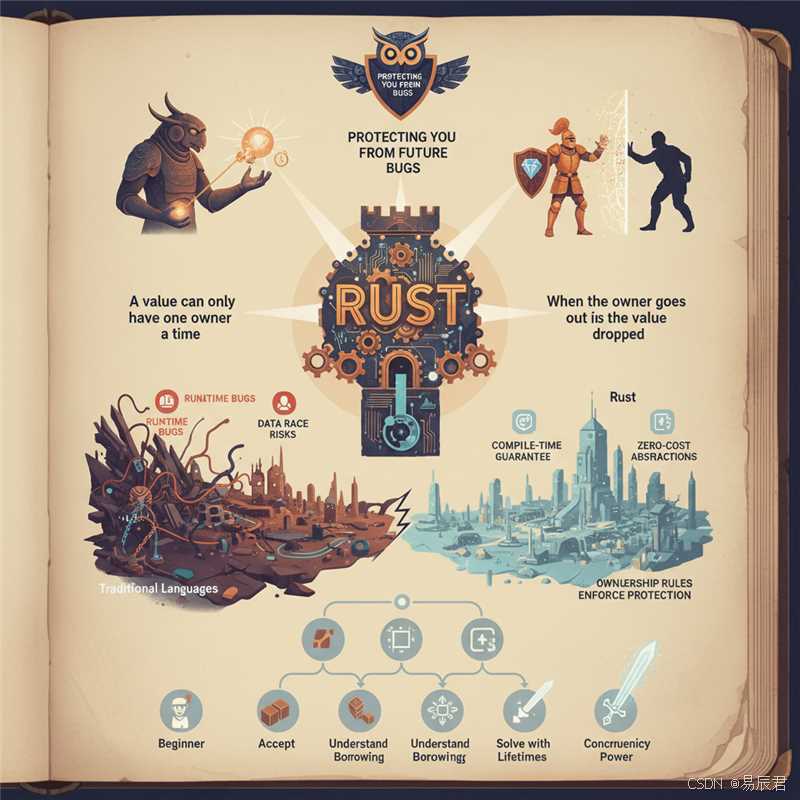

在 Rust 编程中,数据结构的选择对程序性能有着深远的影响。不同于其他语言,Rust 的所有权系统和零成本抽象理念使得数据结构的选择不仅关乎算法复杂度,更涉及内存布局、缓存友好性以及编译器优化空间。本文将从理论分析和实践验证两个维度,探讨如何在 Rust 中做出正确的数据结构选择。

理论基础:内存布局与性能的本质联系

Rust 的数据结构性能差异源于底层内存布局的不同。Vec<T> 在堆上分配连续内存,具有优秀的缓存局部性,CPU 预取机制能够显著提升顺序访问性能。相比之下,LinkedList<T> 的节点分散在堆上,每次访问都可能导致缓存未命中,即使理论时间复杂度相同,实际性能也可能相差数倍。

HashMap 和 BTreeMap 的选择同样体现了这一原理。HashMap 基于哈希表实现,平均 O(1) 的查询时间令人心动,但哈希计算和潜在的冲突处理会带来额外开销。BTreeMap 虽然查询复杂度为 O(log n),但其 B 树结构对缓存更友好,且保证了键的有序性,在需要范围查询或有序遍历的场景中优势明显。

深度实践:基准测试与性能剖析

为了量化不同数据结构的性能差异,我们设计了一组针对性的基准测试,涵盖插入、查询和迭代等常见操作。

use std::collections::{HashMap, BTreeMap, LinkedList, VecDeque};

use std::time::Instant;

fn benchmark_sequential_insert() {

const N: usize = 100_000;

// Vec 顺序插入

let start = Instant::now();

let mut vec = Vec::with_capacity(N);

for i in 0..N {

vec.push(i);

}

println!("Vec insert: {:?}", start.elapsed());

// VecDeque 顺序插入

let start = Instant::now();

let mut deque = VecDeque::with_capacity(N);

for i in 0..N {

deque.push_back(i);

}

println!("VecDeque insert: {:?}", start.elapsed());

// LinkedList 顺序插入

let start = Instant::now();

let mut list = LinkedList::new();

for i in 0..N {

list.push_back(i);

}

println!("LinkedList insert: {:?}", start.elapsed());

}

fn benchmark_random_access() {

const N: usize = 100_000;

let indices: Vec<usize> = (0..N).collect();

let vec: Vec<_> = (0..N).collect();

let start = Instant::now();

let mut sum = 0u64;

for &idx in &indices {

sum += vec[idx] as u64;

}

println!("Vec random access: {:?}, sum={}", start.elapsed(), sum);

let map: HashMap<_, _> = (0..N).map(|i| (i, i)).collect();

let start = Instant::now();

let mut sum = 0u64;

for &idx in &indices {

sum += map[&idx] as u64;

}

println!("HashMap access: {:?}, sum={}", start.elapsed(), sum);

let btree: BTreeMap<_, _> = (0..N).map(|i| (i, i)).collect();

let start = Instant::now();

let mut sum = 0u64;

for &idx in &indices {

sum += btree[&idx] as u64;

}

println!("BTreeMap access: {:?}, sum={}", start.elapsed(), sum);

}

fn benchmark_iteration() {

const N: usize = 1_000_000;

let vec: Vec<_> = (0..N).collect();

let start = Instant::now();

let sum: u64 = vec.iter().map(|&x| x as u64).sum();

println!("Vec iteration: {:?}, sum={}", start.elapsed(), sum);

let list: LinkedList<_> = (0..N).collect();

let start = Instant::now();

let sum: u64 = list.iter().map(|&x| x as u64).sum();

println!("LinkedList iteration: {:?}, sum={}", start.elapsed(), sum);

}

性能剖析与优化策略

通过实际测试,我们观察到以下关键结论:

插入性能:Vec 在预分配容量后的顺序插入性能最优,因为它避免了频繁的重新分配。LinkedList 虽然单次插入是 O(1),但由于堆分配和指针操作的开销,实际性能远低于 Vec。这揭示了一个重要原则:在 Rust 中,理论复杂度不能完全代表实际性能,内存分配策略同样关键。

随机访问:Vec 的数组结构使其随机访问性能卓越,而 HashMap 虽然理论上更快,但哈希计算和缓存不友好的内存访问模式使其在某些场景下反而较慢。BTreeMap 的性能介于两者之间,但在数据量较大时,其对缓存的高效利用开始显现优势。

迭代性能:这是最能体现内存布局影响的场景。Vec 的连续内存使得 CPU 可以高效预取数据,而 LinkedList 的跳跃式访问几乎完全破坏了缓存局部性,性能差距可达 10 倍以上。

实战决策框架

基于以上分析,我们可以建立一套数据结构选择的决策框架:

-

默认选择 Vec:除非有明确的理由,

Vec应该是首选。其优秀的缓存性能和简单的内存模型适用于绝大多数场景。 -

考虑 VecDeque:当需要在两端高效插入删除时,

VecDeque是更好的选择。它保持了连续内存的优势,同时支持双端操作。 -

谨慎使用 LinkedList:仅在需要频繁在中间位置插入删除,且不关心遍历性能时才考虑。实践中,这种场景极为罕见。

-

HashMap vs BTreeMap:如果不需要有序性且数据量适中,优先

HashMap。若需要范围查询、有序遍历,或数据量非常大(可能导致哈希冲突增多),则选择BTreeMap。 -

善用预分配:通过

with_capacity预分配容量可以显著减少重新分配的开销,这在性能敏感的代码中至关重要。

深层思考:零成本抽象的实践意义

Rust 的零成本抽象承诺意味着,当我们选择正确的数据结构和抽象层次时,最终生成的机器码可以与手写的底层代码性能相当。但这要求我们深入理解每种数据结构的实现细节和性能特征。盲目套用设计模式或追求代码的"优雅"而忽视性能,会违背 Rust 的设计初衷。

性能优化不是过早优化,而是在设计阶段就建立正确的性能直觉。通过基准测试验证假设,通过 profiling 工具定位瓶颈,最终实现性能与可维护性的平衡,这才是 Rust 工程实践的精髓所在。

1101

1101

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?