使用FileBeat采集Kafka日志到Elasticsearch

一、需求分析

在资料中有一个kafka_server.log.tar.gz压缩包,里面包含了很多的Kafka服务器日志,现在我们为了通过在Elasticsearch中快速查询这些日志,定位问题。我们需要用FileBeats将日志数据上传到Elasticsearch中。

问题:

- 首先,我们要指定FileBeat采集哪些Kafka日志,因为FileBeats中必须知道采集存放在哪儿的日志,才能进行采集。

- 其次,采集到这些数据后,还需要指定FileBeats将采集到的日志输出到Elasticsearch,那么Elasticsearch的地址也必须指定。

二、配置FileBeats

FileBeats配置文件主要分为两个部分。

- inputs

- output

从名字就能看出来,一个是用来输入数据的,一个是用来输出数据的。

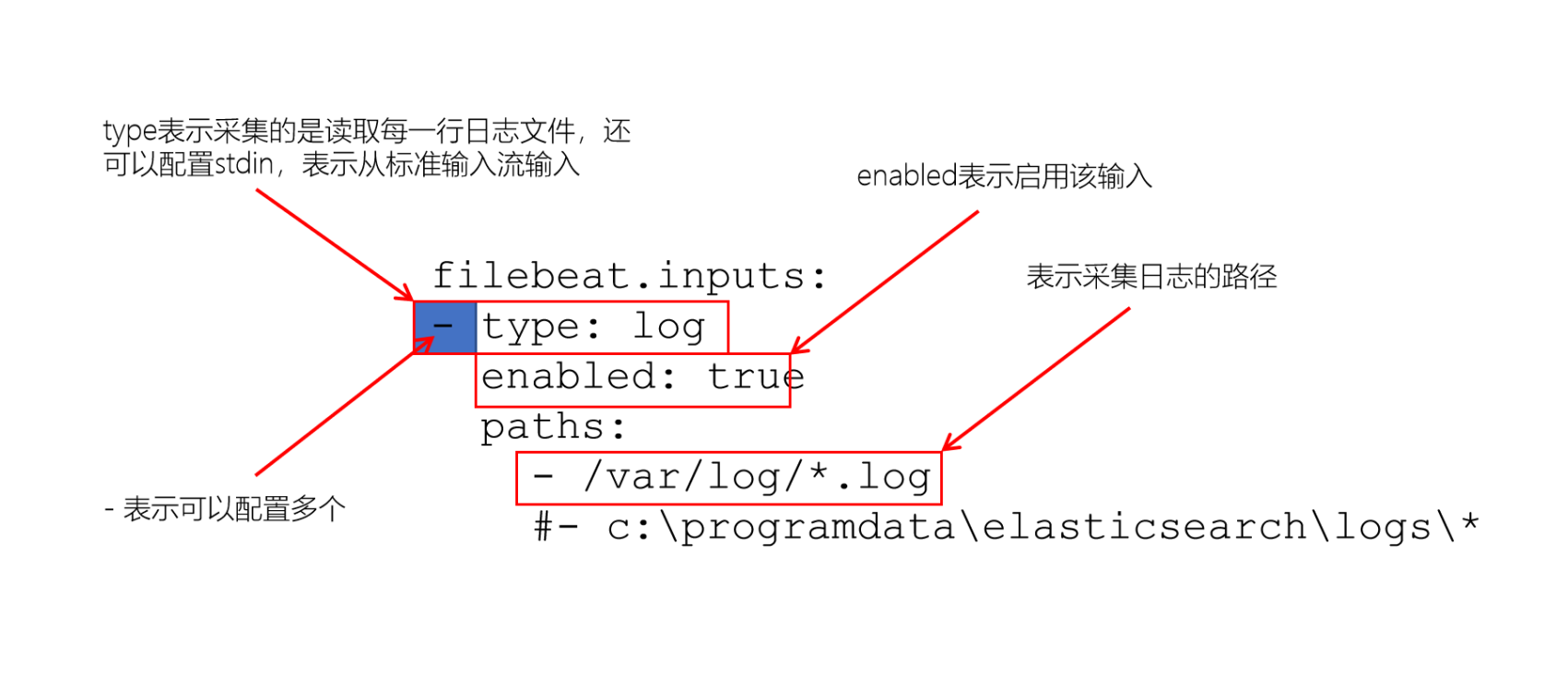

1、input配置

filebeat.inputs:

- type: log

enabled: true

paths:

- /var/log/*.log

#- c:\programdata\elasticsearch\logs\*

在FileBeats中,可以读取一个或多个数据源。

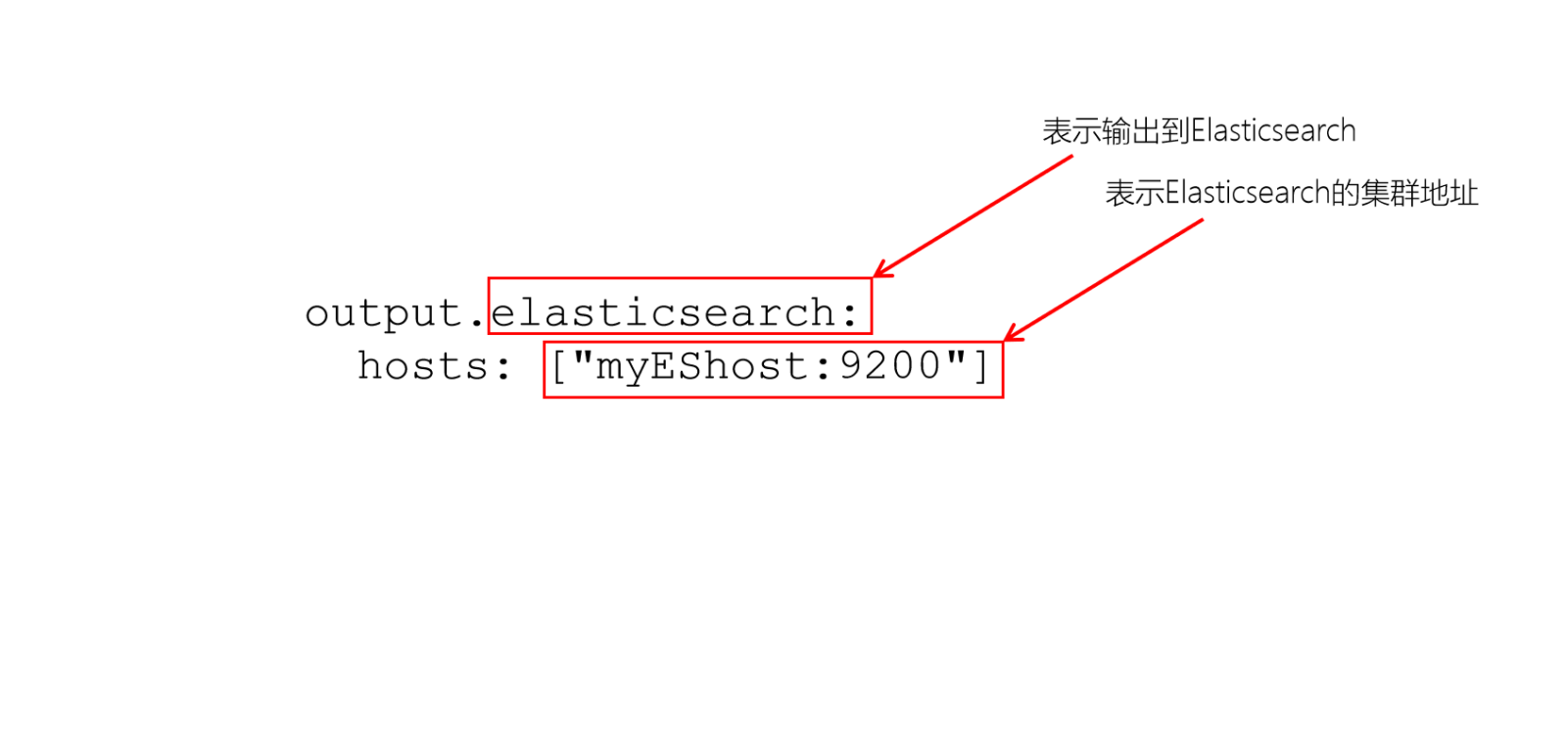

2、output配置

默认FileBeat会将日志数据放入到名称为:filebeat-%filebeat版本号%-yyyy.MM.dd 的索引中。

PS:

FileBeats中的filebeat.reference.yml包含了FileBeats所有支持的配置选项。

三、配置文件

1、创建配置文件

cd /export/server/es/filebeat-7.6.1-linux-x86_64

vim filebeat_kafka_log.yml

2、复制一下到配置文件中

filebeat.inputs:

- type: log

enabled: true

paths:

- /export/server/es/data/kafka/server.log.*

output.elasticsearch:

hosts: ["node1:9200", "node2:9200", "node3:9200"]

四、运行FileBeat

1、运行FileBeat

./filebeat -c filebeat_kafka_log.yml -e

2、将日志数据上传到/var/kafka/log,并解压

mkdir -p /export/server/es/data/kafka/

tar -xvzf kafka_server.log.tar.gz

注意: 文件

本文介绍了如何使用FileBeat将Kafka服务器日志上传到Elasticsearch,包括需求分析、配置FileBeat的input和output、创建配置文件、运行FileBeat、查询数据以及解决日志多行问题。在处理日志多行问题时,讨论了如何避免将跨多行的异常信息分开处理。

本文介绍了如何使用FileBeat将Kafka服务器日志上传到Elasticsearch,包括需求分析、配置FileBeat的input和output、创建配置文件、运行FileBeat、查询数据以及解决日志多行问题。在处理日志多行问题时,讨论了如何避免将跨多行的异常信息分开处理。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

5300

5300

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?